BrowseComp: OpenAI startet neuen Benchmark zur Bewertung der Informationsbeschaffungsfähigkeiten von KI-Netzwerken

Kürzlich veröffentlichte OpenAI ein Projekt namens DurchsuchenComp ein neuer Benchmark-Test, mit dem die Fähigkeit von KI-Agenten, im Internet zu navigieren, bewertet werden soll. Der Benchmark besteht aus 1.266 Fragen, die ein breites Spektrum von Bereichen abdecken, von wissenschaftlichen Entdeckungen bis hin zur Popkultur, und verlangt vom Agenten, dass er ständig in einer offenen Webumgebung auf der Suche nach Antworten navigiert, die schwer zu finden und mit Informationen verwoben sind.

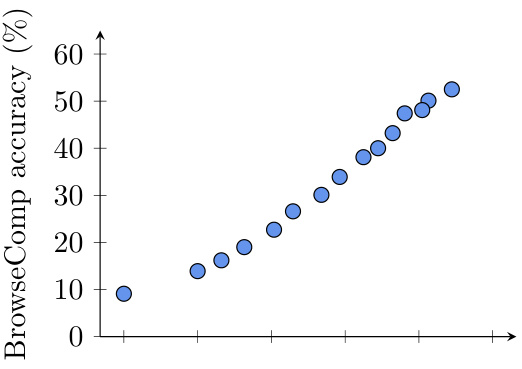

Abbildung 1: BrowseComp-Leistung einer früheren Version von OpenAI Deep Research bei unterschiedlichem Browsing-Aufwand. Die Genauigkeit verbessert sich gleichmäßig, wenn der Rechenaufwand zum Zeitpunkt des Tests zunimmt.

Bestehende Benchmarks sind "gesättigt" und BrowseComp wurde zu diesem Zweck entwickelt.

Derzeit konzentrieren sich einige beliebte Benchmarks, wie SimpleQA, auf die Fähigkeit eines Modells, isolierte, einfache Fakten abzurufen. Für fortgeschrittene Modelle wie GPT-4o, das mit Browsing-Tools ausgestattet ist, sind solche Aufgaben zu einfach geworden und nähern sich der Leistungssättigung. Das bedeutet, dass Benchmarks wie SimpleQA nicht mehr geeignet sind, um die wahren Fähigkeiten von Modellen zu erkennen, wenn es um komplexere Informationen geht, für deren Auffinden eine tiefgreifende Netzwerkexploration erforderlich ist.

Um diese Lücke zu schließen, hat OpenAI BrowseComp (was "Browse Competition" bedeutet) entwickelt. Der Benchmark besteht aus 1.266 herausfordernden Fragen und soll die Fähigkeit von KI-Agenten bewerten, Fragen zu finden, die schwer zu finden sind, verflochtene Informationspunkte haben und möglicherweise den Besuch von Dutzenden oder sogar Hunderten von Websites erfordern, um sie zu beantworten. Das Team hat den Benchmark auf OpenAI's simple evals GitHub-Repositoryund bietet detaillierteForschungsarbeiten.

BrowseComps Design-Konzept

BrowseComp wurde ursprünglich entwickelt, um eine Lücke in bestehenden Benchmark-Tests zu schließen. Zwar gab es in der Vergangenheit bereits eine Reihe von Benchmarks zur Bewertung von Information Retrieval-Fähigkeiten, doch die meisten von ihnen basierten auf relativ einfachen Fragen, die von bestehenden Sprachmodellen leicht gelöst werden können. BrowseComp hingegen konzentriert sich auf komplexe Fragen, die eine eingehende Suche und kreatives Denken erfordern, um die Antworten zu finden.

Hier sind einige Beispiele für Ausgaben in BrowseComp:

- Beispielfrage 1Welche Fußballmannschaften haben zwischen 1990 und 1994 Spiele mit brasilianischen Schiedsrichtern bestritten, in denen es vier gelbe Karten gab (zwei für jede Mannschaft), von denen drei in der zweiten Halbzeit gezeigt wurden, und vier Auswechslungen während des Spiels, von denen eine auf eine Verletzung in den ersten 25 Minuten des Spiels zurückzuführen war?

- ReferenzantwortIrland gegen Rumänien

- Beispiele für Fragen 2:: Nennen Sie bitte eine fiktive Figur, die gelegentlich die vierte Wand durchbricht, um mit dem Publikum zu interagieren, und die für ihren Humor bekannt ist. Die Fernsehsendung wurde zwischen den 1960er und 1980er Jahren ausgestrahlt und hatte weniger als 50 Folgen.

- Referenzantwort: Plastikmann

- Beispiele für Fragen 3Bitte geben Sie den Titel einer wissenschaftlichen Arbeit an, die zwischen 2018 und 2023 auf einer EMNLP-Konferenz vorgestellt wurde und bei der der erste Autor einen Bachelor-Abschluss am Dartmouth College und der vierte Autor einen Bachelor-Abschluss an der University of Pennsylvania hatte.

- Referenzantwort:: Grundlagen des Brotbackens: Die Wissenschaft des Brotes

Einzigartige Merkmale von BrowseComp

- herausforderndBrowseComp-Aufgaben sind sorgfältig entworfen, um sicherzustellen, dass bestehende Modelle nicht in kurzer Zeit gelöst werden können. Menschliche Trainer führen bei der Erstellung der Aufgaben mehrere Validierungsrunden durch, um sicherzustellen, dass sie schwierig sind. Im Folgenden finden Sie einige der Kriterien, die zur Bewertung der Schwierigkeit der Aufgaben verwendet werden:

- Nicht durch bestehende Modelle gelöstGPT-4o (mit und ohne Browsing), OpenAI o1 und frühere Versionen des Deep-Research-Modells haben diese Probleme nicht gelöst: Die Ausbilder wurden gebeten, zu überprüfen, ob sie diese Probleme lösen können.

- Nicht in den Suchergebnissen verfügbar:: Die Ausbilder wurden gebeten, fünf einfache Google-Suchen durchzuführen und zu überprüfen, ob die Antworten nicht auf den ersten Seiten der Suchergebnisse zu finden waren.

- Der Mensch kann das nicht in zehn Minuten lösen.:: Die Ausbilder wurden gebeten, Aufgaben zu stellen, die so schwierig waren, dass eine andere Person sie nicht in zehn Minuten lösen konnte. Bei einigen Aufgaben versucht ein zweiter Trainer, die Lösung zu finden. Ausbilder, die Aufgaben erstellt haben, für deren Lösung mehr als 40% benötigt wurden, wurden gebeten, ihre Aufgaben zu überarbeiten.

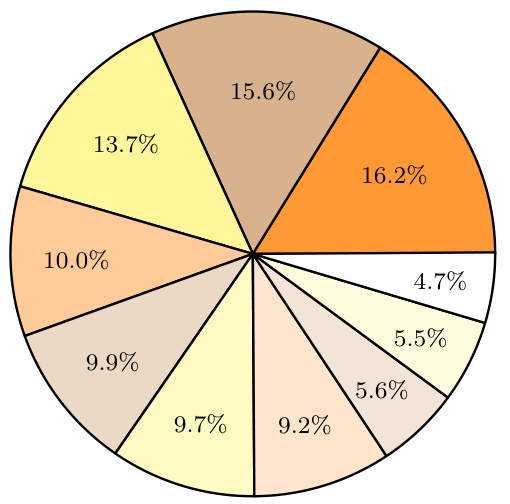

Abbildung 2: Verteilung der Themen in BrowseComp. Die Verteilung der Themen in BrowseComp wird durch die Hinweise des ChatGPT Das Modell kategorisierte die Themen der einzelnen Fragen ex post. - Leicht nachprüfbar:: Trotz des Schwierigkeitsgrades der Fragen sind die Antworten in der Regel kurz und klar und durch Referenzantworten leicht überprüfbar. Dieses Design macht das Benchmarking anspruchsvoll, ohne unfair zu sein.

- Buntheit:: BrowseComp-Fragen decken ein breites Spektrum an Bereichen ab, darunter Fernsehen und Film, Wissenschaft und Technik, Kunst, Geschichte, Sport, Musik, Videospiele, Geografie und Politik. Diese Vielfalt gewährleistet, dass die Tests umfassend sind.

Bewertung der Modellleistung

Tests auf der BrowseComp haben gezeigt, dass die Leistung der bestehenden Modelle uneinheitlich ist:

- GPT-4o im Gesang antworten GPT-4.5 Ohne die Browsing-Funktion liegt die Genauigkeit nahe bei Null. Selbst mit aktivierter Browsing-Funktion verbessert sich die Genauigkeit von GPT-4o nur von 0,6% auf 1,9%, was darauf hinweist, dass die Browsing-Funktion allein nicht ausreicht, um komplexe Probleme zu lösen.

- OpenAI o1 Das Modell hat keine Browsing-Funktion, erreicht aber eine Genauigkeit von 9,91 TP3T aufgrund seiner starken Argumentationsfähigkeit, was darauf hindeutet, dass einige Antworten durch internes Wissens-Reasoning gewonnen werden können.

- OpenAI Deep Research Das Modell war mit einer Genauigkeit von 51,51 TP3T am erfolgreichsten. Das Modell durchsucht das Netz selbstständig, indem es Informationen aus verschiedenen Quellen auswertet und synthetisiert und seine Suchstrategie so anpasst, dass es Probleme lösen kann, die sonst nicht zu lösen wären.

tiefgreifende Analyse

1. die Kalibrierungsfehler

Obwohl das Deep-Research-Modell in Bezug auf die Genauigkeit gut abschneidet, weist es einen hohen Kalibrierungsfehler auf. Das bedeutet, dass das Modell seine eigene Unsicherheit nicht genau einschätzen kann, wenn es selbstbewusst falsche Antworten gibt. Dieses Phänomen ist besonders deutlich bei Modellen mit Browsing-Funktionen, was darauf hindeutet, dass der Zugang zu Web-Tools das Vertrauen des Modells in falsche Antworten erhöhen kann.

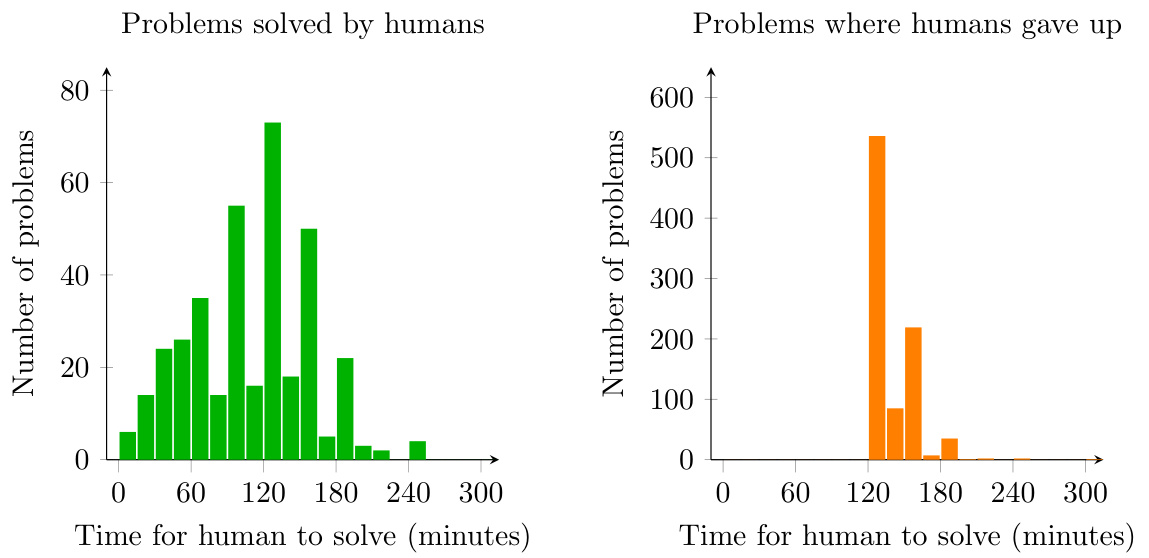

Abbildung 3: Histogramm, das zeigt, wie lange ein Mensch braucht, um ein BrowseComp-Problem zu lösen oder aufzugeben. Die TrainerInnen durften erst aufgeben, nachdem sie mindestens zwei Stunden lang versucht hatten, das Problem zu lösen.

2. die Auswirkungen der Computerressourcen

Die Testergebnisse zeigen, dass sich die Leistung des Modells allmählich verbessert, wenn die Rechenressourcen zum Zeitpunkt der Tests erhöht werden. Dies deutet darauf hin, dass die BrowseComp-Probleme einen erheblichen Such- und Denkaufwand erfordern und dass mehr Rechenressourcen die Leistung des Modells erheblich verbessern können.

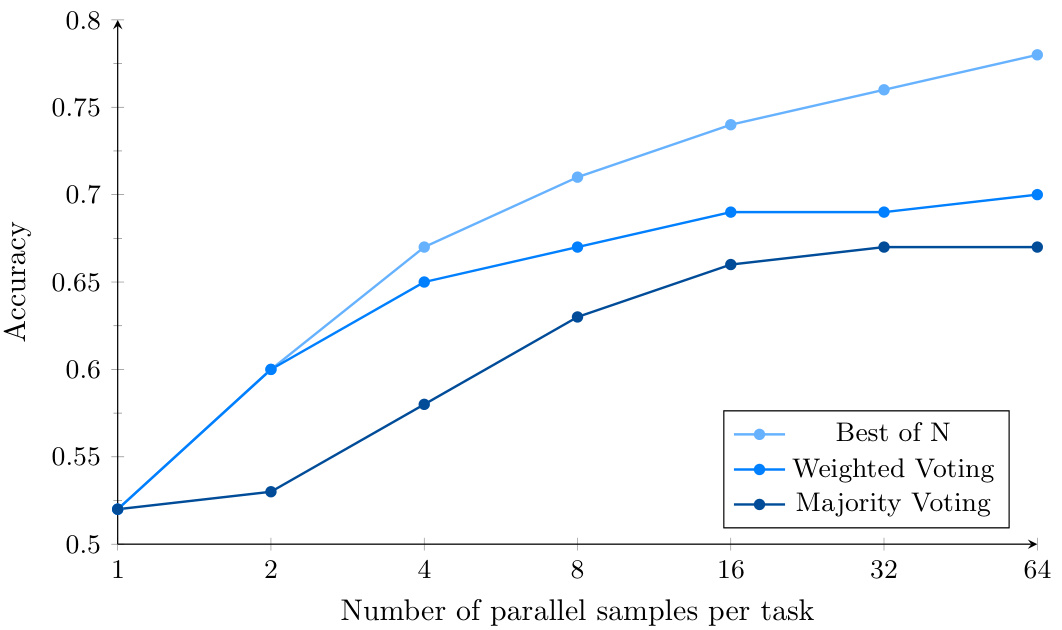

Abbildung 4: BrowseComp-Leistung für Deep Research bei Verwendung von parallelem Sampling und vertrauensbasierter Abstimmung. Der zusätzliche Rechenaufwand verbessert die Modellleistung mit Best-of-N weiter.

3. die Aggregationsstrategien

Die Leistung des Modells kann durch mehrere Versuche und die Verwendung verschiedener Aggregationsstrategien (z. B. Mehrheitsabstimmung, gewichtete Abstimmung und Best-Choice) 15% bis 25% weiter verbessert werden, wobei die Best-Choice-Strategie am besten abschneidet, was darauf hindeutet, dass das Deep-Research-Modell ein hohes Maß an Genauigkeit bei der Ermittlung der richtigen Antwort aufweist.

zu einem Urteil gelangen

Die Veröffentlichung von BrowseComp bietet eine neue Dimension bei der Bewertung von KI-Agenten. Er testet nicht nur die Fähigkeit eines Modells, Informationen zu finden, sondern untersucht auch seine Ausdauer und Kreativität bei komplexen Problemen. Obwohl die Leistung bestehender Modelle bei BrowseComp noch verbessert werden muss, wird die Veröffentlichung dieses Benchmark-Tests die Forschung auf dem Gebiet der KI zweifellos voranbringen.

In Zukunft, wenn mehr Modelle eingesetzt werden und die Technologie sich weiterentwickelt, können wir davon ausgehen, dass sich die Leistung der KI-Agenten auf BrowseComp weiter verbessern wird, was letztendlich zu zuverlässigeren und vertrauenswürdigeren KI-Agenten führen wird.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...