AssemblyAI: Hochpräzise Sprache-zu-Text- und Audio Intelligence-Analyseplattform

Allgemeine Einführung

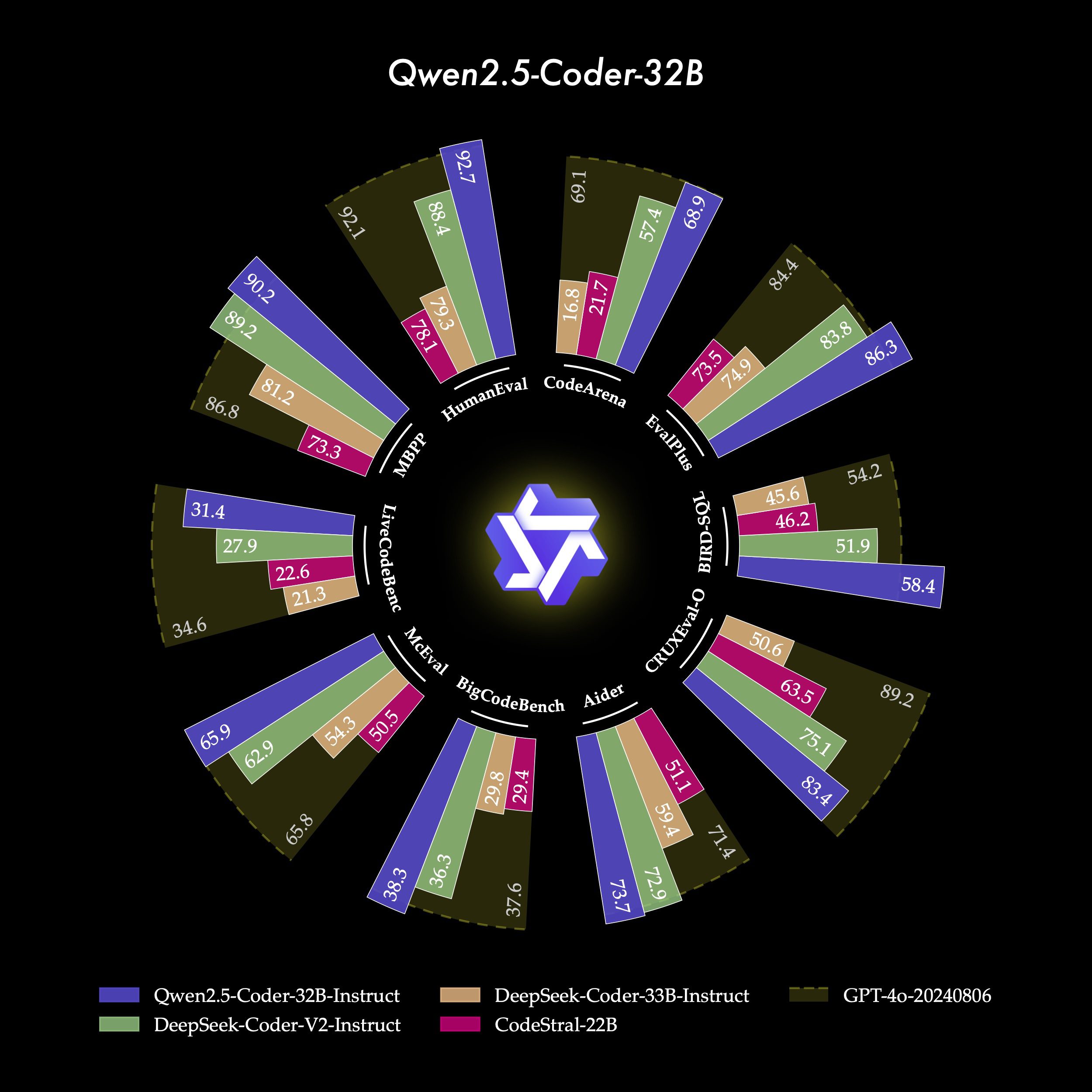

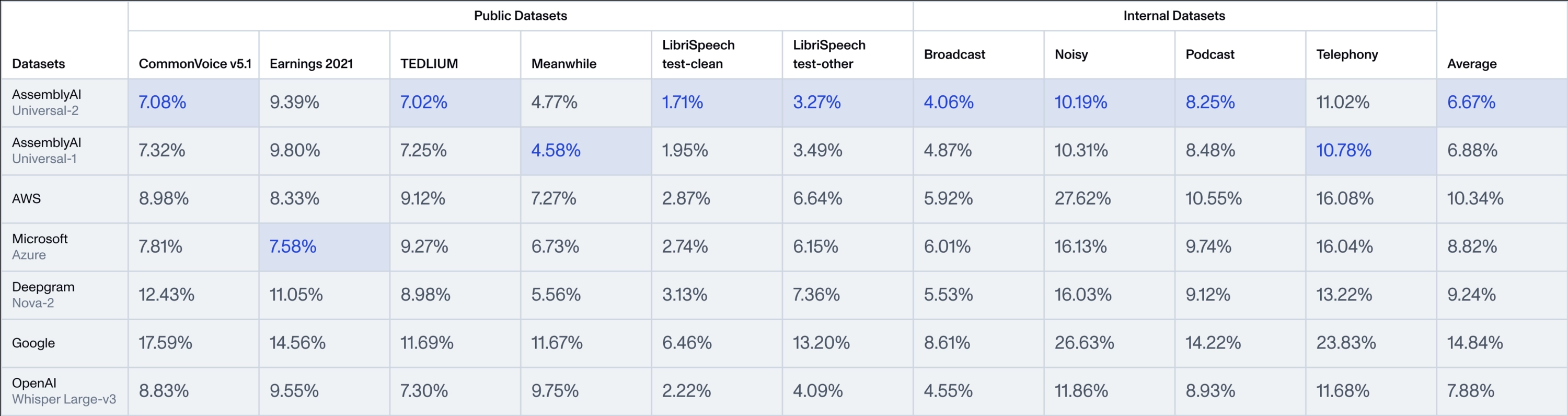

AssemblyAI ist eine Plattform, die sich auf Sprach-KI-Technologie konzentriert und Entwicklern und Unternehmen effiziente Sprache-zu-Text- und Audio-Analyse-Tools zur Verfügung stellt. Das zentrale Highlight ist die Universal-Serie von Modellen, vor allem die neu veröffentlichte Universal-2, die AssemblyAIs fortschrittlichste Sprache-zu-Text-Modell bis heute ist. universal-2 baut auf der Grundlage von Universal-1, mit mehr als 12,5 Millionen Stunden mehrsprachige Audio-Trainingsdaten, und ist in der Lage, genau zu erfassen die Komplexität der realen Gespräche und liefern hochpräzise Audio-Daten. Universal-2 baut auf Universal-1 mit mehr als 12,5 Millionen Stunden mehrsprachiger Audio-Trainingsdaten auf und ist in der Lage, die Komplexität realer Dialoge genau zu erfassen und hochpräzise Audiodaten zu liefern. Im Vergleich zu Universal-1 verbessert Universal-2 die Erkennung von Eigennamen (z.B. Namen, Marken) um 241 TP3T, die Erkennung von gemischt numerisch-alphabetischen Inhalten (z.B. Telefonnummern, Mailboxen) um 211 TP3T und die Textformatierung (z.B. Interpunktion, Großschreibung) um 151 TP3T, wodurch die "letzte Meile" der Genauigkeit des traditionellen Modells deutlich reduziert wird. "AssemblyAI macht diese Spitzentechnologien über einfach zu verwendende APIs für globale Nutzer zugänglich und wurde von Spotify, Fireflies und anderen Unternehmen genutzt, um intelligente Sprachprodukte für Bereiche wie die Aufzeichnung von Meetings und die Analyse von Inhalten zu entwickeln.

Funktionsliste

- Sprache-zu-TextKonvertieren Sie Audiodateien oder Live-Audiostreams in hochpräzisen Text und unterstützen Sie dabei mehrere Sprachen und mehrere Audioformate.

- Lautsprecher-ErkennungAutomatisches Erkennen verschiedener Sprecher im Audio für Mehrpersonen-Dialogszenarien.

- Sentiment-AnalyseAnalyse emotionaler Tendenzen in der Sprache, wie z.B. positiv, negativ oder neutral, um das Benutzererlebnis zu verbessern.

- Echtzeit-TranskriptionBietet eine Echtzeit-Sprache-zu-Text-Funktionalität mit niedriger Latenz, die sich für Voice Agents oder Live-Untertitel eignet.

- Audio Intelligence ModellierungUmfasst erweiterte Funktionen wie Inhaltsüberprüfung, Themenerkennung, Stichwortsuche und mehr.

- LeMUR-RahmenVerarbeitung von transkribiertem Text mithilfe eines umfangreichen Sprachmodells, mit Unterstützung für die Erstellung von Zusammenfassungen, Fragen und Antworten und mehr.

- Untertitel GenerationUnterstützt den Export von Untertiteldateien im SRT- oder VTT-Format zur einfachen Erstellung von Videoinhalten.

- PII-DatenschutzAutomatisches Erkennen und Blockieren von sensiblen Informationen in Audiodateien, wie z. B. Namen oder Telefonnummern.

Hilfe verwenden

AssemblyAI ist ein Cloud-basierter API-Dienst, der keine lokale Installation erfordert, um auf seine leistungsstarken Funktionen zuzugreifen. Hier finden Sie einen detaillierten Leitfaden, der Ihnen den Einstieg erleichtert und Sie tiefer in die Möglichkeiten des Dienstes einführt.

Registrieren und Abrufen von API-Schlüsseln

- Besuchen Sie die offizielle Website: Öffnen Sie Ihren Browser und geben Sie

https://www.assemblyai.com/Gehen Sie zur Startseite. - Registrieren Sie sich für ein KontoKlicken Sie auf "Anmelden" in der oberen rechten Ecke und geben Sie Ihre E-Mail-Adresse und Ihr Passwort ein, um den Registrierungsprozess abzuschließen. Nach der Registrierung werden Sie automatisch in das Dashboard aufgenommen.

- Holen Sie sich den SchlüsselSuchen Sie den Bereich "API-Schlüssel" im Dashboard und klicken Sie auf "Kopieren", um den Schlüssel zu kopieren. Dies ist die einzige Zugangsberechtigung für den Aufruf der API und sollte sicher aufbewahrt werden.

- Kostenlose Testversion: Kostenloses Guthaben für neue Nutzer, keine Notwendigkeit, sofort eine Zahlungsmethode zu binden.

Kernfunktion Betrieb

Das Herzstück von AssemblyAI ist die API-Integration. Im Folgenden wird ein Beispiel für die Verwendung der Universal-Modellfamilie in Python gegeben. Sie können auch andere Sprachen (z.B. Java, Node.js) verwenden, indem Sie sich auf die Dokumentation auf der Website beziehen.

Sprache zu Text (Universal-2)

- vorläufigVergewissern Sie sich, dass eine Audiodatei vorhanden ist (z. B.

sample.mp3) oder URL-Link. - Installieren des SDKLäuft im Terminal:

pip install assemblyai

- Code-Beispiel::

import assemblyai as aai

aai.settings.api_key = "你的API密钥" # 替换为你的密钥

transcriber = aai.Transcriber()

transcript = transcriber.transcribe("sample.mp3")

print(transcript.text) # 输出文本,如“今天天气很好。”

- Universal-2 StärkenStandardmäßig wird das Universal-2-Modell verwendet, das Eigennamen (z. B. "Zhang Wei") und formatierte Zahlen (z. B. "6. März 2025") genauer erkennt als Universal-1, oft in Sekundenschnelle. Die Verarbeitungszeit beträgt in der Regel nur wenige Sekunden.

Echtzeit-Transkription

- Anwendbare SzenarienLive-Streaming, Telekonferenzen und andere Echtzeitanforderungen.

- Code-Beispiel::

from assemblyai import RealtimeTranscriber import asyncio async def on_data(data): print(data.text) # 实时输出文本 transcriber = RealtimeTranscriber( api_key="你的API密钥", sample_rate=16000, on_data=on_data ) async def start(): await transcriber.connect() await transcriber.stream() # 开始接收音频流 asyncio.run(start()) - ArbeitsablaufSprechen Sie nach dem Lauf in das Mikrofon und der Text wird in Echtzeit angezeigt. Die geringe Latenzzeit der Universal-2 sorgt für schnelle und genaue Ergebnisse.

Lautsprecher-Erkennung

- Methode zur Freigabe::

config = aai.TranscriptionConfig(speaker_labels=True) transcript = transcriber.transcribe("sample.mp3", config=config) for utterance in transcript.utterances: print(f"说话人 {utterance.speaker}: {utterance.text}") - Beispiele für Ergebnisse::

说话人 A: 你好,今天会议几点? 说话人 B: 下午两点。 - auf etw. aufmerksam machenUniversal-2 bietet eine konsistentere Leistung in Gesprächen mit mehreren Personen und reduziert Verwirrung.

Sentiment-Analyse

- Methode zur Freigabe::

config = aai.TranscriptionConfig(sentiment_analysis=True) transcript = transcriber.transcribe("sample.mp3", config=config) for result in transcript.sentiment_analysis: print(f"文本: {result.text}, 情感: {result.sentiment}") - Beispiele für Ergebnisse::

文本: 我很喜欢这个产品, 情感: POSITIVE 文本: 服务有点慢, 情感: NEGATIVE

Untertitel Generation

- Betriebscode::

transcript = transcriber.transcribe("sample.mp3") with open("captions.srt", "w") as f: f.write(transcript.export_subtitles_srt()) - am Ende: Erzeugen

.srtDatei, die direkt in eine Videobearbeitungssoftware importiert werden kann.

Merkmale: LeMUR Framework

- Funktion EinführungLeMUR kombiniert groß angelegte Sprachmodellierung mit der Verarbeitung von Transkriptionsergebnissen, z.B. zur Erstellung von Abstracts.

- Verfahren::

- Besorgen Sie sich eine ID für die Abschrift:

transcript = transcriber.transcribe("sample.mp3") transcript_id = transcript.id - Erstellen Sie eine Zusammenfassung:

from assemblyai import Lemur lemur = Lemur(api_key="你的API密钥") summary = lemur.summarize(transcript_id) print(summary.response) - Beispiel Output: "Der Fortschritt des Projekts wurde auf der Sitzung besprochen und soll nächste Woche abgeschlossen werden."

- Besorgen Sie sich eine ID für die Abschrift:

caveat

- Unterstützte FormateKompatibel mit 33 Audio-/Videoformaten wie MP3, WAV, etc.

- Spracheinstellungen99+ Sprachen werden unterstützt und können über

language_code="zh"Geben Sie Chinesisch an. - AbrechnungAbrechnung pro Audiostunde, Preise siehe offizielle Website.

Wenn Sie diese Schritte befolgen, können Sie die leistungsstarken Funktionen der Universal-2 voll ausschöpfen, um effiziente Sprachanwendungen zu erstellen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...