AgenticSeek: ein KI-Assistent für die Automatisierung von Aufgaben, der vollständig lokal läuft

Allgemeine Einführung

AgenticSeek ist ein quelloffener KI-Assistent, der vollständig nativ läuft und auf der Deepseek R1-Modellentwicklung. Es benötigt keine Cloud-API und verursacht keine monatlichen Gebühren in Höhe von Hunderten von Dollar. Sein Ziel ist es, ein intelligenter Assistent ähnlich dem Film "Jarvis" zu werden, der in der Lage ist, Aufgaben wie das Schreiben von Code, die Dateiverwaltung, das Surfen im Internet usw. auf dem Computer des Nutzers auszuführen und dabei den Datenschutz zu gewährleisten. Entwickler Martin. Legrand positioniert es als Manus Eine lokale Alternative zu AI, mit dem Schwerpunkt auf 100%, das lokal läuft. Mit Stand vom März 2025 gibt es 181 Sterne und 16 Forks auf GitHub, und die Community ist weiterhin aktiv und begrüßt Mitwirkende.

Funktionsliste

- Vollständig lokaler BetriebEs ist keine Internetverbindung erforderlich, alle Berechnungen werden auf dem Gerät des Nutzers durchgeführt, und es gibt keine Datenverluste.

- SprachinteraktionUnterstützt Spracheingabebefehle und Sprachantworten, um den Bedienkomfort zu erhöhen.

- DateisystembetriebDurchsuchen und Arbeiten mit lokalen Dateien über die Bash.

- Schreiben von Code und DebuggingCodegenerierung und Fehlerbehebung für Python, C, Golang und andere Sprachen.

- autonome FehlerkorrekturWenn ein Befehl fehlschlägt oder ein Code-Fehler auftritt, wiederholt die KI automatisch den Versuch und behebt ihn.

- Intelligente AufgabenverteilungAutomatisches Auswählen des passenden Funktionsmoduls je nach Art der Aufgabe.

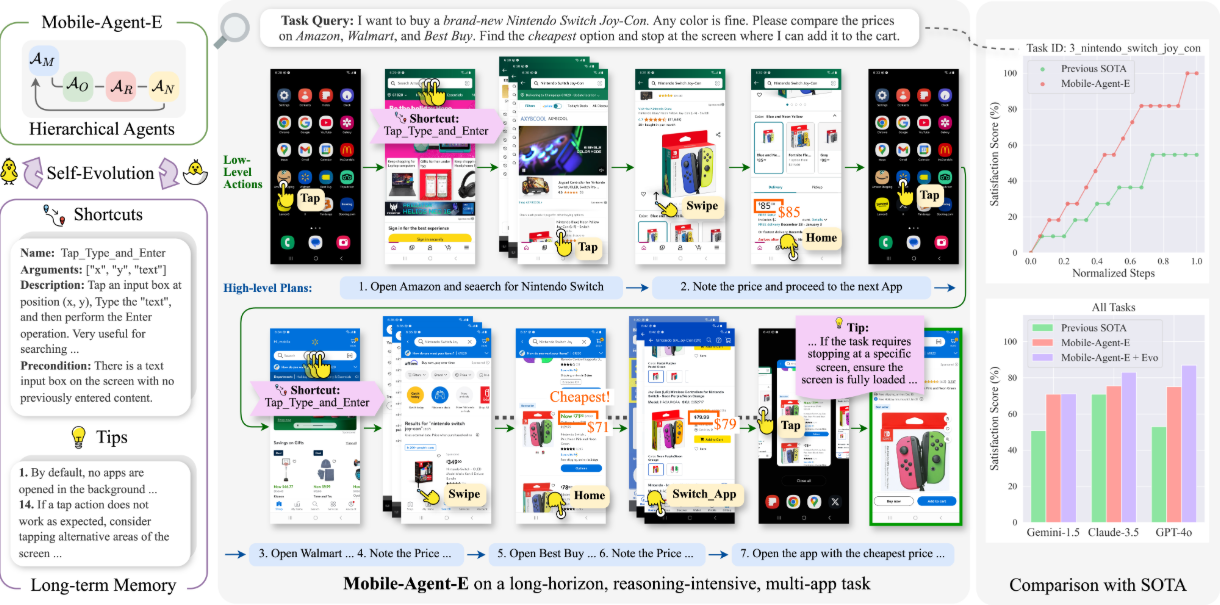

- Zusammenarbeit zwischen mehreren AgentenKomplexe Aufgaben können aufgeteilt, geplant und von mehreren Agenten ausgeführt werden.

- Werkzeug-UnterstützungIntegrierte Suche, Dateisuche und andere Dienstprogramme.

- SpeicherfunktionDialoghistorie und Benutzerpräferenzen aufbewahren und lange kontextbezogene Austauschvorgänge unterstützen.

- WebbrowserKann auf Webseiten navigieren und selbstständig Informationen extrahieren.

Hilfe verwenden

Die Installation und Nutzung von AgenticSeek erfordert ein gewisses technisches Grundwissen, aber die Schritte sind klar. Im Folgenden finden Sie eine detaillierte Anleitung, damit Sie schnell loslegen können.

Einbauverfahren

- Vorbereitung der Umwelt

- Vergewissern Sie sich, dass Ihr Computer Python 3 unterstützt, dass mindestens 8 GB RAM empfohlen werden und dass Ihr Grafikprozessor mehr als 8 GB Videospeicher benötigt (12 GB werden für 14B-Modelle empfohlen).

- Installieren Sie Git zum Herunterladen von Code.

- Laden Sie Ollama (Tool zur Ausführung lokaler Modelle) herunter und installieren Sie es, da es eine Kernabhängigkeit darstellt. Besuchen Sie Ollama Offizielle Website Holen Sie es sich.

- AgenticSeek herunterladen

- Öffnen Sie ein Terminal (CMD oder PowerShell für Windows, Terminal für Mac/Linux).

- Geben Sie den Befehl clone project ein:

git clone https://github.com/Fosowl/agenticSeek.git - Rufen Sie den Projektkatalog auf:

cd agenticSeek

- Erstellen einer virtuellen Umgebung

- Geben Sie den Befehl ein, um eine eigenständige Umgebung zu erstellen:

python3 -m venv agentic_seek_env - Aktivieren Sie die Umwelt:

- Fenster:

agentic_seek_env\Scripts\activate - Mac/Linux:

source agentic_seek_env/bin/activate

- Fenster:

- Geben Sie den Befehl ein, um eine eigenständige Umgebung zu erstellen:

- Installation von Abhängigkeiten

- Nachdem Sie die Umgebung aktiviert haben, führen Sie sie aus:

pip install -r requirements.txt - Oder verwenden Sie ein automatisches Installationsskript (Mac/Linux):

./install.sh

- Nachdem Sie die Umgebung aktiviert haben, führen Sie sie aus:

- Modelle konfigurieren und herunterladen

- Stellen Sie sicher, dass Ollama installiert ist und starten Sie den Dienst:

ollama serve - Herunterladen von Tiefensuche R1 Modell (14B empfohlen, 7B für Geräte mit niedriger Konfiguration):

ollama pull deepseek-r1:14b - Compiler

config.ini, die lokal ausgeführt werden soll:[MAIN] is_local = True provider_name = ollama provider_model = deepseek-r1:14b

- Stellen Sie sicher, dass Ollama installiert ist und starten Sie den Dienst:

- AgenticSeek starten

- Eingabe:

python main.py - Wenn eine Eingabeaufforderung angezeigt wird, bedeutet dies, dass der Vorgang erfolgreich durchgeführt wurde.

- Eingabe:

Funktion Betriebsablauf

Sprachinteraktion

- Methode der Öffnung: in

config.iniaufstellenspeak = Trueim Gesang antwortenlisten = True. - ausnutzenSagen Sie beim Starten "Sprachmodus starten" und stellen Sie dann Fragen mit Ihrer Stimme, z. B. "Schreiben Sie einen Code für mich".

- PunktDie KI antwortet per Stimme und stellt sicher, dass das Mikrofon und die Lautsprecher funktionieren.

- zur Kenntnis nehmenEs kann sein, dass die Lautstärke zum ersten Mal eingestellt werden muss, und dass es bei Geräten mit geringerer Leistung zu einer Verzögerung kommen kann.

Dateisystembetrieb

- Einrichten des Katalogs: in

config.iniangegeben inwork_dirz.B../Users/你的用户名/文档. - ausnutzenGeben Sie "Alle Textdateien auflisten" ein, und AI wird die Ergebnisse zurückgeben.

- Erweiterte FunktionenEs heißt "Analysieren Sie den Inhalt dieser Datei" und extrahiert die Schlüsselinformationen.

- FinesseBash-Befehle wie z. B. "Neuen Ordner erstellen" werden unterstützt.

Schreiben von Code und Debugging

- ArbeitsweiseTippen Sie "Schreiben Sie einen Python-Sortieralgorithmus" und die KI generiert Code.

- Komponenten während der Prüfung anpassenWenn es einen Fehler im Code gibt, sagen Sie "beheben Sie diesen Fehler" und die KI wird ihn analysieren und ändern.

- Unterstützte SprachenDerzeit umfasst es Python, C, Golang, wird später erweitert.

Webbrowser

- ausnutzenTippen Sie "Finde die neuesten KI-Nachrichten" ein, und die KI wird die Seite durchsuchen und die Informationen zusammenstellen.

- EinschränkungDerzeit wird nur Text extrahiert, Bild- oder Videoparsing wird nicht unterstützt.

- FinesseSie können Schlüsselwörter angeben, z. B. "Suche nach Deepseek R1-Updates".

autonome Fehlerkorrektur

- ArbeitsweiseEs sind keine besonderen Einstellungen erforderlich. Wenn der Befehl fehlschlägt, versucht die KI automatisch, ihn zu reparieren.

- typisches BeispielWenn Sie den falschen Befehl "Datei X öffnen" eingeben, zeigt AI an, dass die Datei nicht existiert und schlägt eine Alternative vor.

Fernsteuerung (optional)

- Nehmen SieWenn die Leistung der lokalen Geräte nicht ausreicht, kann ein Server für die Ausführung des Modells verwendet werden.

- umziehen::

- Starten Sie Ollama auf dem Server und ermitteln Sie die IP (z.B.

192.168.1.100). - Führen Sie das Serverskript aus:

python server_ollama.py - lokale Änderung

config.ini::[MAIN] is_local = False provider_name = server provider_model = deepseek-r1:14b provider_server_address = 192.168.1.100:5000 - Lokal laufen:

python main.py

- Starten Sie Ollama auf dem Server und ermitteln Sie die IP (z.B.

caveat

- Hardware-Voraussetzung7B-Modelle erfordern 8 GB Videospeicher, 14B erfordert 12 GB (z. B. RTX 3060) und 32B erfordert 24 GB+.

- Komponenten während der Prüfung anpassenWenn der Start fehlschlägt, überprüfen Sie, ob Ollama läuft, oder sehen Sie im Terminal-Fehlerprotokoll nach.

- Update: Regelmäßiger Betrieb

git pullHolen Sie sich die neuesten Funktionen. - LizenzDas Projekt ist quelloffen und frei unter der GPL-3.0.

Anwendungsszenario

- Programmierhilfen

Wenn Sie beim Schreiben von Code nicht weiterkommen, z. B. bei der Fehlersuche in komplexer Logik, generiert AgenticSeek Code, behebt Fehler und erklärt Code-Details. - Verwaltung von Dokumenten

Computerdateien sind unübersichtlich. Nach dem Einrichten eines Verzeichnisses kann AI Dateien auflisten, Inhalte extrahieren und sogar Stapelverarbeitungsvorgänge durchführen. - Unterstützung beim Lernen

Die Schüler können damit Dokumente analysieren, nach Informationen suchen und durch Sprachinteraktion Notizen machen, um die Effizienz zu steigern. - Mandat zum Schutz der Privatsphäre

AgenticSeek läuft lokal ohne Internetverbindung, um die Informationssicherheit beim Umgang mit sensiblen Daten zu gewährleisten.

QA

- Ist es wirklich 100%, das lokal läuft?

Ja, wenn Sie Ollama oder den Server-Modus verwenden, ist die gesamte Verarbeitung lokal, und nicht-lokale Optionen (wie OpenAI) sind nur optional. - Was ist, wenn ich nicht genügend Hardware habe?

Verwenden Sie das Modell 7B, oder lassen Sie ein höheres Modell über einen Remote-Server laufen. - Was ist, wenn etwas schief geht?

Stellen Sie sicher, dass Ollama läuft, überprüfen Sieconfig.iniKonfiguration. Wenn es immer noch nicht klappt, können Sie einen Fehler auf GitHub melden. - Was ist besser als Manus AI?

Es konzentriert sich auf den lokalen Betrieb und den Schutz der Privatsphäre für diejenigen, die keine Cloud-Dienste nutzen möchten.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...