6 Wochen Lernpfad zum Cue Engineering Experten (trans.)

(jemandem eine Stelle etc.) anbieten

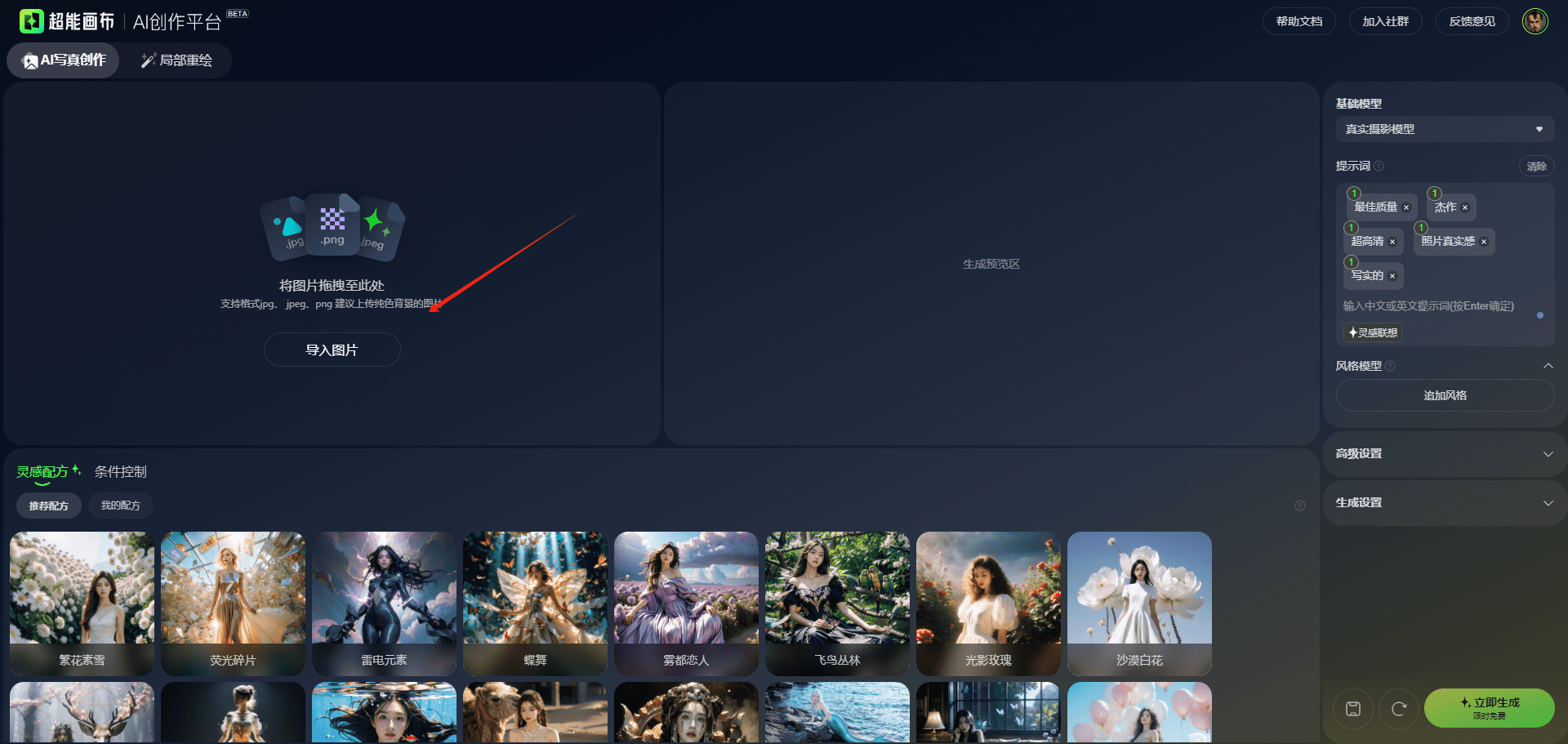

Da der Bereich der künstlichen Intelligenz (KI) weiter wächst, ist Cue Engineering zu einer vielversprechenden Karriere geworden. Heute streben viele Menschen danach, sich die Fähigkeiten anzueignen, um effektiv mit großen Sprachmodellen (Large Language Models, LLMs) zu interagieren. Teilen Sie den gleichen Wunsch? Denken Sie darüber nach, wo Sie anfangen und wie Sie vorgehen sollen? Wir bieten Ihnen diesen Lernpfad an, um Sie dabei zu unterstützen, ein Prompt-Engineering-Experte zu werden. Dieser umfassende Leitfaden soll Ihnen helfen, Prompt-Engineering Schritt für Schritt zu meistern, von den Grundlagen bis zu fortgeschrittenen Techniken. Egal, ob Sie Anfänger oder Fortgeschrittener sind, dieser strukturierte Lernpfad wird Ihnen das Wissen und die praktischen Fähigkeiten vermitteln, die Sie benötigen, um LLM zu meistern.

skizziert.

- Verstehen Sie, was ein Cue-Projekt ist.

- Lernen Sie in 6 Wochen, wie Sie Prompt Engineering beherrschen.

- Finden Sie heraus, was Sie jede Woche lernen müssen und wie Sie üben können.

Verzeichnis (auf der Festplatte des Computers)

- Woche 1: Einführung in die Cue-Technik

- Woche 2: Einrichten von LLMs für Prompts

- Woche 3: Effektive Prompts schreiben

- Woche 4: Verstehen von Prompting-Mustern

- Woche 5: Tipps zum Prompting für Fortgeschrittene

- Woche 6: Fortgeschrittene Prompting-Strategien

- allgemeine Probleme

Woche 1: Einführung in die Cue-Technik

Konzentrieren Sie sich in der ersten Woche der Prompt Engineering Journey auf die folgenden Themen

Was ist das Tip-Projekt?

- Das Konzept des Cue Engineering im NLP und seine Bedeutung verstehen.

- Verstehen, wie man effektive Prompts schreibt und wie sie sich auf die Sprachmodellierung auswirken.

- Erfahren Sie mehr über den historischen Hintergrund und die Entwicklung der Queue-Technik und wie sie sich im Laufe der Zeit weiterentwickelt hat.

Wie funktioniert das LLM?

- Lernen Sie die Grundlagen des LLM kennen und verstehen Sie, wie es in einfacher, nicht technischer Sprache funktioniert.

- Lernen Sie, wie LLM ausgebildet wird und funktioniert, und verstehen Sie es mit einfachen Analogien und Beispielen.

- Lernen Sie verschiedene LLMs wie GPT-4o, Llama und Mistral und ihre einzigartigen Eigenschaften und Anwendungsszenarien kennen.

Stichwort: Rolle der Technik

- Verstehen Sie die Stellenbeschreibungen und die spezifischen Fähigkeiten, die für Positionen wie Tip Engineer, Data Scientist und andere erforderlich sind.

- Lernen Sie die praktische Anwendung von Cue Engineering anhand von realen Projekten und Beispielaufgaben kennen.

Praktische Anwendungen der Queue-Technik

- In der Forschung werden Fallstudien über erfolgreiche Anwendungen von Cue Engineering in verschiedenen Branchen vorgestellt.

Beispiel:LLMs am Arbeitsplatz: eine Fallstudie über den Einsatz von Cue-Engineering für die Job-Kategorisierung. - Diskutieren Sie die Auswirkungen von Cue-Engineering auf die Leistung von KI-Modellen und verstehen Sie, wie es die Effektivität dieser Modelle verbessern kann.

verwirklichen

- Erkunden Sie die LLM-ChartsLernen Sie verschiedene Benchmarks wie MMLU-Pro, HuamnEval, Chatbot Arena und mehr kennen. Erforschen Sie verschiedene LLM-Diagramme und lernen Sie die aktuell führenden Modelle in verschiedenen Benchmarks kennen.

Beispiel:Hugging Face Space für open-llm-leaderboardundLLM-Ranking | Künstliche Analyse - Identifizierung von Schlüsselkompetenzen und Analyse von Tipps Technische FallstudienBeginnend mit der Identifizierung der allgemeinen Fähigkeiten und Qualifikationen, die von Souffleuren benötigt werden, indem man sich Stellenbeschreibungen und Berufsprofile ansieht. Recherchieren Sie die praktischen Anwendungen der Souffleurtechnik in verschiedenen Branchen und fassen Sie diese zusammen, wobei Sie sich darauf konzentrieren, wie Souffleure gestaltet sind und welche Ergebnisse sie erzielen.

Beispiel:Fallstudie - Tipp-ProjektundDie Auswirkungen von generativen KI-Anwendungen in 13 realen Anwendungsfällen.

Woche 2: Aufbau eines großen Sprachmodells für Prompts

In dieser Woche werden wir lernen, wie man das Large Language Model (LLM) für das Prompting auf verschiedene Arten einrichtet. Die Benutzer können jede der genannten Methoden verwenden.

Direkt auf der LLM-Website zugänglich

- Erfahren Sie, wie Sie diese Modelle direkt über die LLM-Webplattform nutzen können.

- Erfahren Sie, wie Sie ein Konto erstellen und wie Sie sich auf der beliebten Big Language Modelling-Plattform zurechtfinden.

Lokale Ausführung des quelloffenen LLM

- den Prozess der Einrichtung eines quelloffenen LLM (z.B. Llama3, Mistral, Phi3, etc.) zur Ausführung auf einem lokalen Rechner mit Hugging Face oder Ollama und msty.app oder Open WebUI.

- Verstehen der Hardware- und Softwareanforderungen verschiedener Open-Source-LLMs.

Programmatischer Zugang über API

- Erfahren Sie, wie Sie sich für den API-Zugang anmelden können. Zum Beispiel die Bereitstellung von API-Zugang zu LLMs über die Plattform, wie GPT-4o, Claude, Gemini usw., sowie die Nutzung der Hugging Face Inference API für den Zugang zu Modellen wie Llama, Phi, Gemma und anderen.

- Erfahren Sie, wie Sie API-Schlüssel konfigurieren und in verschiedene Anwendungen zur Erstellung von Eingabeaufforderungen integrieren können.

API-Schlüssel in AI Content Labs einrichten

verwirklichen

- Zugang zum LLM über die WebsiteErstellen Sie ein Konto und versuchen Sie, direkt auf der LLM-Website Prompts zu erstellen.

- Open Source LLM lokal einrichtenFolgen Sie der Anleitung, um einen lokalen Open-Source-LLM herunterzuladen, zu installieren und zu konfigurieren und ihn mit Hilfe verschiedener Eingabeaufforderungen zu testen.

- API-Schlüssel registrierenVervollständigen Sie den Prozess der Beschaffung eines API-Schlüssels von einem Anbieter wie OpenAI und schreiben Sie ein einfaches Skript, um einen Prompt mit diesem Schlüssel zu erzeugen.

Woche 3: Effektive Prompts schreiben

In dieser Woche werden wir lernen, wie man eine Vielzahl von Hinweisarten erstellt, um Sprachmodelle effektiv zu booten, wobei wir uns auf klare Befehle, Beispiele, Iterationen, Begrenzer, strukturierte Formate und Temperaturparameter konzentrieren.

Schreiben Sie klare und spezifische Anweisungen

- Lernen Sie, wie Sie klare und spezifische Anweisungen schreiben, um das Modell bei der Erzeugung der gewünschten Ergebnisse anzuleiten.

- Verstehen, wie wichtig Klarheit und Spezifität sind, um Mehrdeutigkeiten zu vermeiden und die Genauigkeit der Antworten zu verbessern.

Spezifische Beispiele für die Verwendung

- Lernen Sie Techniken für die Verwendung spezifischer Beispiele in Prompts, um Kontext zu liefern und die Relevanz der Modellergebnisse zu verbessern.

- Erfahren Sie, wie Sie das erwartete Format oder den Antworttyp anhand von Beispielen demonstrieren können.

Den Hinweis transformieren und iterieren

- Erkunden Sie die Vorteile der Umwandlung von Stichworten und der Iteration zur Verbesserung der Ausgabequalität.

- Erfahren Sie, wie kleine Änderungen in den Eingabeaufforderungen zu erheblichen Verbesserungen der Ergebnisse führen können.

Verwendung von Begrenzungszeichen

- Lernen Sie, wie Sie Trennzeichen in Eingabeaufforderungen effektiv einsetzen können, um verschiedene Abschnitte oder Eingabearten zu trennen.

- Erfahren Sie, wie Sie die Struktur und Lesbarkeit Ihrer Aufforderungen verbessern können, indem Sie Beispiele für die Verwendung von Trennzeichen geben.

Festlegen eines strukturierten Ausgabeformats

- verstehen, wie wichtig es ist, in der Aufforderung ein strukturiertes Ausgabeformat anzugeben, um die Konsistenz und Organisation der Antworten zu gewährleisten.

- Lernen Sie Techniken, um das erwartete Ausgabeformat klar zu definieren.

Parameter für die Betriebstemperatur

- Lernen Sie das Konzept der Temperaturparameter in der Sprachmodellierung kennen und erfahren Sie, wie sie die Kreativität und die Zufälligkeit der Ausgabe beeinflussen.

- Lernen Sie, wie Sie die Temperaturparameter anpassen können, um ein Gleichgewicht zwischen Vielfalt und Kohärenz zu finden und die Reaktion des Modells zu steuern.

verwirklichen

- Schreiben Sie klare und spezifische AnweisungenErstellen Sie Prompts mit klaren und spezifischen Anweisungen und beobachten Sie, wie sich die Klarheit auf die Modellausgabe auswirkt.

- Spezifische Beispiele für die VerwendungEinfügen eines konkreten Beispiels in die Aufforderung, um den Unterschied in der Relevanz der Ausgabe mit und ohne Beispiel zu vergleichen.

- Den Hinweis transformieren und iterierenVersuchen Sie, die Aufforderungen zu variieren, um zu sehen, wie kleine Änderungen die Ergebnisse verbessern.

- Verwendung von BegrenzungszeichenVerwenden Sie Trennzeichen, um verschiedene Abschnitte in der Aufforderung zu trennen, und analysieren Sie die Auswirkungen auf die Struktur und Lesbarkeit der Antwort.

Woche 4: Verstehen von Prompting-Mustern

In dieser Woche lernen wir Hint-Patterns kennen, eine High-Level-Technik, die einen wiederverwendbaren und strukturierten Ansatz zur Lösung häufiger Probleme bei der Ausgabe von Large Language Models (LLM) bietet.

Überblick über den Cue-Modus

- Das Konzept der Cueing Patterns und ihre Rolle bei der Erstellung effektiver Cues für LLMs verstehen (z.B.).

- Lernen Sie die Ähnlichkeiten zwischen Hinweismustern und Entwurfsmustern in der Softwareentwicklung kennen, wobei Hinweismuster wiederverwendbare Lösungen für spezifische und wiederkehrende Probleme bieten.

- Ziel der Erforschung des Prompting-Modells ist es, die Entwicklung von Prompts zu erleichtern, indem ein Rahmen für die Erstellung von Prompts geschaffen wird, der wiederverwendet und an verschiedene Szenarien angepasst werden kann.

Eingabesemantik

- Lernen Sie die semantischen Kategorien der Eingaben kennen und erfahren Sie, wie LLM die bereitgestellten Eingaben versteht und verarbeitet.

- Lernen Sie das Eingabeaufforderungsmuster "Meta Language Creation" kennen, das die Definition einer benutzerdefinierten Sprache oder eines Symbols beinhaltet, das mit dem LLM interagiert.

Anpassung der Ausgabe

- Verstehen Sie die Kategorie Output-Anpassung, die sich auf die Anpassung des LLM-Outputs an spezifische Bedürfnisse oder Formate konzentriert.

- Erforschen Sie den "Template"-Eingabemodus, um sicherzustellen, dass die LLM-Ausgabe genau der Vorlage oder dem Format entspricht.

- Erfahren Sie mehr über das "Rollen"-Cueing-Modell, bei dem das LLM eine bestimmte Rolle oder Perspektive einnimmt, wenn es Output erzeugt.

falsche Identifizierung

- Erlernen von Fehlererkennungskategorien mit dem Schwerpunkt auf der Erkennung und Behebung potenzieller Fehler in der LLM-Ausgabe.

- Erfahren Sie mehr über den Abfragemodus "Faktencheckliste", der eine Liste von Fakten in der Ausgabe zur Überprüfung erzeugt.

- Erkunden Sie das Modell der "reflektierenden" Eingabeaufforderung, das den LLM dazu auffordert, über seinen Output nachzudenken und mögliche Fehler oder verbesserungswürdige Bereiche zu identifizieren.

Queue-Optimierung

- Erfahren Sie mehr über die Kategorie Prompt-Optimierung, deren Schwerpunkt auf der Optimierung der Prompts liegt, die an LLMs gesendet werden, um die Qualität der Prompts zu gewährleisten.

- Erfahren Sie mehr über das Modell der "Fragenoptimierung", das LLMs dabei unterstützt, die Fragen der Benutzer zu optimieren, um genauere Antworten zu erhalten.

- Erforschen Sie das Modell der alternativen Herangehensweise, um sicherzustellen, dass das LLM mehrere Möglichkeiten bietet, eine Aufgabe zu erledigen oder ein Problem zu lösen.

Interaktion und Kontextsteuerung

- Das Verständnis der Interaktionskategorien verbessert die Dynamik der Interaktion zwischen dem Nutzer und dem LLM und macht den Dialog ansprechender und effektiver.

- Lernen Sie das Souffleurmodell "Umgekehrte Interaktion", bei dem der LLM den Dialog führt, indem er Fragen stellt.

- Lernen Sie die Kategorie der kontextuellen Steuerung kennen, wobei der Schwerpunkt auf der Pflege und Verwaltung kontextueller Informationen im Dialog liegt.

- Erforschung des Souffleurmodells "Context Manager", um Kohärenz und Relevanz im laufenden Dialog zu gewährleisten.

Übung

- Erkundung verschiedener Cue-MusterUntersuchung verschiedener Cueing-Muster, um zu verstehen, wie sie spezifische, wiederkehrende Probleme bei der LLM-Ausgabe angehen.

- Beispiel für die Analyse von HinweismusternUntersuchung von Beispielen aus der Praxis, um zu verstehen, wie mit Hilfe von Cue Patterns bestimmte Ziele und Ergebnisse erreicht werden können.

- Identifizieren und Klassifizieren von Cueing-MusternÜben Sie sich darin, in einem gegebenen Beispiel verschiedene Cue-Muster zu erkennen und sie in die entsprechende Kategorie einzuordnen.

- Kombinieren Sie mehrere Cueing-ModiErkunden Sie, wie mehrere Cueing-Modi kombiniert werden können, um komplexere Cueing-Probleme zu lösen und die Gesamtleistung zu verbessern.

Woche 5: Fortgeschrittene Prompting-Techniken

In dieser Woche werden wir uns mit fortgeschrittenen Prompting-Techniken beschäftigen, um die Effektivität und Raffinesse von Prompts weiter zu verbessern. Hier sind ein paar Beispiele.

N-Schuss Tipp

- Lernen Sie den N-Shot-Tipp, bei dem es darum geht, null, ein oder mehrere Beispiele (N-Shots) zu liefern, um die Reaktion des Modells zu steuern.

- Erfahren Sie, wie N-Shot-Tipps die Genauigkeit und Relevanz von Modellergebnissen verbessern können, indem sie Kontext und Beispiele liefern.

Gedankenkette

- Erkunden Sie die Techniken der Gedankenkette (Chain of Thought, COT), um ein Problem anhand eines geführten Modells Schritt für Schritt zu erörtern.

- Erfahren Sie, wie die Methode zu einem kohärenteren und logisch konsistenten Output beitragen kann.

Selbstkonsistenz

- Zum Verständnis selbstkonsistenter Methoden gehört es, das Modell zu veranlassen, mehrere Lösungen zu erzeugen und dann die konsistenteste auszuwählen.

- Erfahren Sie, wie diese Technik die Zuverlässigkeit und Genauigkeit der generierten Antworten verbessert.

Gedankenbaum

- Lernen Sie die Thinking-Tree-Technik kennen, die Modelle dazu anregt, mehrere Wege und mögliche Ergebnisse für ein bestimmtes Problem zu berücksichtigen.

- Lernen Sie, wie Sie Hinweise konstruieren können, um diesen verzweigten Denkprozess zu erleichtern und die Entscheidungsfähigkeit zu verbessern.

Mindmap

- Erforschen Sie den Mind-Mapping-Ansatz, bei dem Modelle Netzwerke aus miteinander verbundenen Ideen und Konzepten bilden.

- Erfahren Sie, wie Sie diese Technologie nutzen können, um eine umfassendere und vielschichtigere Antwort zu erhalten.

Übung

- Umsetzung des N-Shot-TippsGeben Sie einige Beispiele (N-shots) für das Modell an und beobachten Sie, wie es die Relevanz und Genauigkeit der Antwort verbessert.

- Versuchen Sie die GedankenketteErstellen Sie Prompts, die das Modell Schritt für Schritt durch das Problem führen, und analysieren Sie die Kohärenz der Ergebnisse.

- Anwendung der SelbstkonsistenzDas Modell wird veranlasst, mehrere Lösungen für das Problem zu generieren und die konsistenteste auszuwählen, um die Zuverlässigkeit zu verbessern.

- Verwendung eines DenkbaumsEntwicklung von Aufforderungen, um die Modelle zu ermutigen, mehrere Wege und Ergebnisse in Betracht zu ziehen und ihre Entscheidungsprozesse zu bewerten.

Woche 6: Fortgeschrittene Cue-Design-Strategien

In dieser Woche erforschen wir fortschrittliche Strategien für die Gestaltung von Stichwörtern, um die Leistung und Präzision der Interaktion mit Sprachmodellen weiter zu verbessern.

Reagieren Sie

- tun Reagieren Sie Techniken, um neue Aufgaben zu erlernen und Entscheidungen zu treffen, indem man dem Modell erlaubt, zu "handeln" und zu "argumentieren".

- Erfahren Sie, wie Sie mit diesem Ansatz interaktivere und ansprechendere Ergebnisse erzielen können.

Umformulierung und Antwortvorgaben

- Das Verständnis der "Restate and respond"-Technik beinhaltet, dass das Modell aufgefordert wird, eine gegebene Eingabe zu wiederholen und dann zu antworten.

- Erfahren Sie, wie dieser Ansatz die Klarheit verbessert und mehrere Ansichten desselben Inputs ermöglicht.

Selbst-Optimierung

- Erforschung von "selbstoptimierenden" Methoden, die die Modelle auffordern, ihre eigenen Antworten zu überprüfen und zu verbessern, um die Genauigkeit und Konsistenz zu erhöhen.

- Untersuchen Sie, wie diese Technik die Qualität des Outputs verbessern kann, indem sie zur Selbsteinschätzung anregt.

Iterations-Tipps

- Erlernen Sie den Ansatz des "iterativen Cueing", um den Output des Modells durch iteratives Cueing und Feedback kontinuierlich zu optimieren.

- Erfahren Sie, wie die Qualität und Relevanz von Antworten mit dieser Technik im Laufe der Zeit verbessert werden kann.

Kettentechnologie

- PrüfketteDie Verwendung von Validierungsfragen und deren Antworten, um das Phänomen der Halluzinationen zu reduzieren.

- WissensketteErstellen Sie Aufforderungen, die auf dynamischem Wissen aufbauen, um umfassende Antworten zu geben.

- emotionale Kette: Fügen Sie am Ende der Aufforderung emotionale Reize hinzu, um die Leistung des Modells zu verbessern.

- DichteketteGenerieren Sie mehrere Zusammenfassungen, die immer detaillierter werden, aber nicht an Länge zunehmen.

- symbolische Kette: Darstellung komplexer Umgebungen durch Verwendung kondensierter symbolischer räumlicher Darstellungen in verketteten Zwischeninferenzschritten.

verwirklichen

- Einführung der React-TechnologieErstellen Sie Prompts, die das Modell auffordern, auf bestimmte Stimuli zu reagieren oder zu antworten, und bewerten Sie die Interaktivität der Ausgabe.

- Wiederholungen und Antwortvorgaben verwendenVersuchen Sie, das Modell aufzufordern, den Input neu zu formulieren und dann zu antworten, und analysieren Sie den Output auf Klarheit und Vielfalt.

- Selbstoptimierung der AnwendungEntwickeln Sie Tipps, um die Modelle zu ermutigen, ihre Antworten zu überprüfen und zu verbessern, um die Genauigkeit und Konsistenz zu erhöhen.

- Kettentechnologie erforschenErstellen Sie eine Reihe von Hinweisen unter Verwendung verschiedener Verkettungstechniken (z. B. natürlichsprachliche Argumentationsketten, Wissensketten) und bewerten Sie die Kohärenz und Tiefe der Antworten.

zu einem Urteil gelangen

Durch diesen Lernpfad kann jeder ein Experte für Cue Engineering werden. Dadurch erhalten Sie ein tiefgreifendes Verständnis dafür, wie man effektive Hinweise entwirft und fortgeschrittene Techniken einsetzt, um die Leistung großer Sprachmodelle zu optimieren. Dieses Wissen wird Sie in die Lage versetzen, komplexe Aufgaben zu bewältigen, die Modellleistung zu verbessern und einen Beitrag zum wachsenden Bereich der KI und des maschinellen Lernens zu leisten. Kontinuierliches Üben und die Erforschung neuer Ansätze werden dafür sorgen, dass Sie in diesem dynamischen und spannenden Bereich an der Spitze stehen.

Cue-Engineering ist ein zentraler Bestandteil der Erstellung und des Trainings generativer KI-Modelle. Beherrschen Sie Cue Engineering und alle anderen Aspekte der generativen KI mit unserem umfassenden und vollständigen Generative AI Capstone Programm. Dieser Kurs deckt KI-Grundlagen bis hin zu fortgeschrittenen Techniken ab, um Ihnen bei der Feinabstimmung Ihrer generativen KI-Modelle für eine Vielzahl von Anforderungen zu helfen. Sehen Sie sich den Kurs jetzt an!

allgemeine Probleme

F1: Was ist Prompt-Engineering? Warum ist sie wichtig?

A. Cue-Engineering bezieht sich auf die Gestaltung von Eingaben, die das makrosprachliche Modell bei der Erzeugung der gewünschten Ausgabe anleiten. Dies ist wichtig, um die Genauigkeit und Relevanz der von der KI generierten Antworten zu verbessern.

F2: Welche gängigen Tools und Plattformen gibt es für die Verwendung des Big Language Model?

A. Zu den häufig verwendeten Tools und Plattformen gehören die GPT-Modelle von OpenAI, Hugging Face, Ollama und Llama und Mistral und andere Open-Source-Modelle für große Sprachen.

F3: Wie lernen Anfänger etwas über Cue Engineering?

A. Anfänger können damit beginnen, die Grundlagen von Natural Language Processing (NLP) und Big Language Modelling zu verstehen, mit einfachen Eingabeaufforderungen zu experimentieren und nach und nach die in diesem Lernpfad erwähnten fortgeschritteneren Techniken zu erkunden.

F4: Welche Schlüsselqualifikationen sind für die Arbeit in der Prompttechnik erforderlich?

A. Zu den Schlüsselqualifikationen gehören NLP-Kenntnisse, Verständnis für große Sprachmodelle, die Fähigkeit, effektive Prompts zu entwerfen, und Vertrautheit mit Programmierung und API-Integration.

F5: Wie wirkt sich das Cue-Engineering auf reale Anwendungen aus?

A. Ein effektives Cue-Engineering kann die Leistung von KI-Modellen in verschiedenen Branchen erheblich verbessern, vom Kundenservice über die Erstellung von Inhalten bis hin zur Datenanalyse und Entscheidungsunterstützung.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...