Zonos: ferramentas de síntese de fala e clonagem de fala de alta qualidade

Introdução geral

O Zonos é uma ferramenta de síntese e clonagem de fala de código aberto desenvolvida pela Zyphra. A versão Zonos-v0.1 usa Transformador O recurso de clonagem de fala da Zonos gera uma saída de fala de alta qualidade após apenas alguns segundos de áudio de referência. A ferramenta é compatível com vários idiomas, incluindo inglês, japonês, chinês, francês e alemão, e oferece controle refinado sobre a qualidade e a emoção do áudio, e o recurso Speech Clone da Zonos gera uma fala de aparência altamente natural após fornecer apenas alguns segundos de áudio de referência. Os usuários podem obter os pesos do modelo e o código de amostra via GitHub e experimentá-lo no Huggingface.

Lista de funções

- Clonagem de fala TTS de amostra zeroTexto de entrada e uma amostra de alto-falante de 10 a 30 segundos para gerar uma saída de fala de alta qualidade.

- Entrada de prefixo de áudioAdicionar prefixos de texto e áudio para uma correspondência de alto-falante mais rica.

- Suporte a vários idiomasInglês, japonês, chinês, francês e alemão são suportados.

- Qualidade de áudio e controle de emoçõesControle de voz: fornece controle refinado sobre muitos aspectos do áudio gerado, incluindo velocidade de fala, variação de tom, qualidade de áudio e emoção (por exemplo, felicidade, medo, tristeza e raiva).

- Geração de fala em tempo realSuporte à geração em tempo real de fala de alta fidelidade.

Usando a Ajuda

Processo de instalação

- projeto de clonagemExecute o seguinte comando em um terminal para clonar o projeto Zonos:

bash

git clone https://github.com/Zyphra/Zonos.git

cd Zonos - Instalação de dependênciasUse o seguinte comando para instalar as dependências necessárias do Python:

bash

pip install -r requirements.txt - Download dos pesos do modeloFaça o download dos pesos de modelo necessários do Huggingface e coloque-os no diretório do projeto.

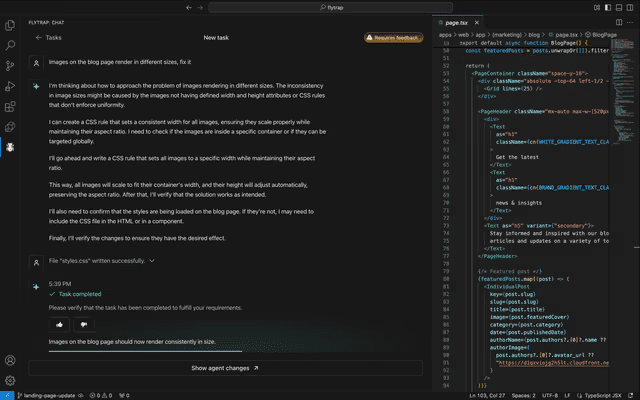

Uso

- Modelos de carregamentoCarregamento do modelo Zonos no ambiente Python:

import torch import torchaudio from zonos.model import Zonos from zonos.conditioning import make_cond_dict model = Zonos.from_pretrained("Zyphra/Zonos-v0.1-transformer", device="cuda") - Gerar discursoForneça amostras de texto e de alto-falante para gerar saída de fala:

python

wav, sampling_rate = torchaudio.load("assets/exampleaudio.mp3")

speaker = model.make_speaker_embedding(wav, sampling_rate)

cond_dict = make_cond_dict(text="Hello, world!", speaker=speaker, language="en-us")

conditioning = model.prepare_conditioning(cond_dict)

codes = model.generate(conditioning)

wavs = model.autoencoder.decode(codes).cpu()

torchaudio.save("sample.wav", wavs[0], model.autoencoder.sampling_rate) - Usando a interface do GradioA interface Gradio é recomendada para a geração de fala:

bashIsso gera um

uv run gradio_interface.py

# 或者

python gradio_interface.pysample.wavsalvo no diretório raiz do projeto.

Fluxo de operação detalhado da função

- Clonagem de fala TTS de amostra zero::

- Ao inserir o texto desejado e uma amostra de 10 a 30 segundos do locutor, o modelo gerará uma saída de fala de alta qualidade.

- Entrada de prefixo de áudio::

- Adicione prefixos de texto e áudio para uma correspondência de alto-falante mais rica. Por exemplo, os prefixos de áudio de sussurro podem ser usados para gerar efeitos de sussurro.

- Suporte a vários idiomas::

- Selecione o idioma desejado (por exemplo, inglês, japonês, chinês, francês ou alemão) e o modelo gerará a saída de fala no idioma correspondente.

- Qualidade de áudio e controle de emoções::

- Use o recurso Conditional Settings (Configurações condicionais) do modelo para controlar meticulosamente todos os aspectos do áudio gerado, inclusive a velocidade da fala, a variação do tom, a qualidade do áudio e a emoção (por exemplo, felicidade, medo, tristeza e raiva).

- Geração de fala em tempo real::

- Use a interface Gradio ou outros métodos de geração em tempo real para gerar rapidamente um discurso de alta fidelidade.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...