O Wisdom Spectrum suporta 128K de contexto/4K de comprimento de saída modelo grande GLM-4-Flash de volume total aberto!

Desde 27 de agosto, o Wisdom Spectrum disponibilizou a API do GLM-4-Flash para o público gratuitamente. Executando um teste de tradução de três dias do inglês para o chinês, o GLM-4-Flash compara o GLM-4-9b fornecido pela Silicon Flow e o GLM-4-9b fornecido pela Wisdom Spectrum. OpenRouter: interface unificada para integração de vários LLMs, interface gratuita de modelo grande Ela não é menos eficaz ou mais rápida do que as muitas APIs de modelo gratuitas oferecidas pelo RIP.

O GLM-4-9b lançou anteriormente uma API gratuita no SILICONFLOW (Silicon Flow): acelerando a AGI para a humanidade, integrando uma interface de modelo grande e gratuito O GLM-4-Flash e o GLM-4-9b têm algumas diferenças no tamanho do modelo, no número de parâmetros, nos cenários de aplicação etc. Ambos são APIs gratuitas e oferecem serviços gratuitos.

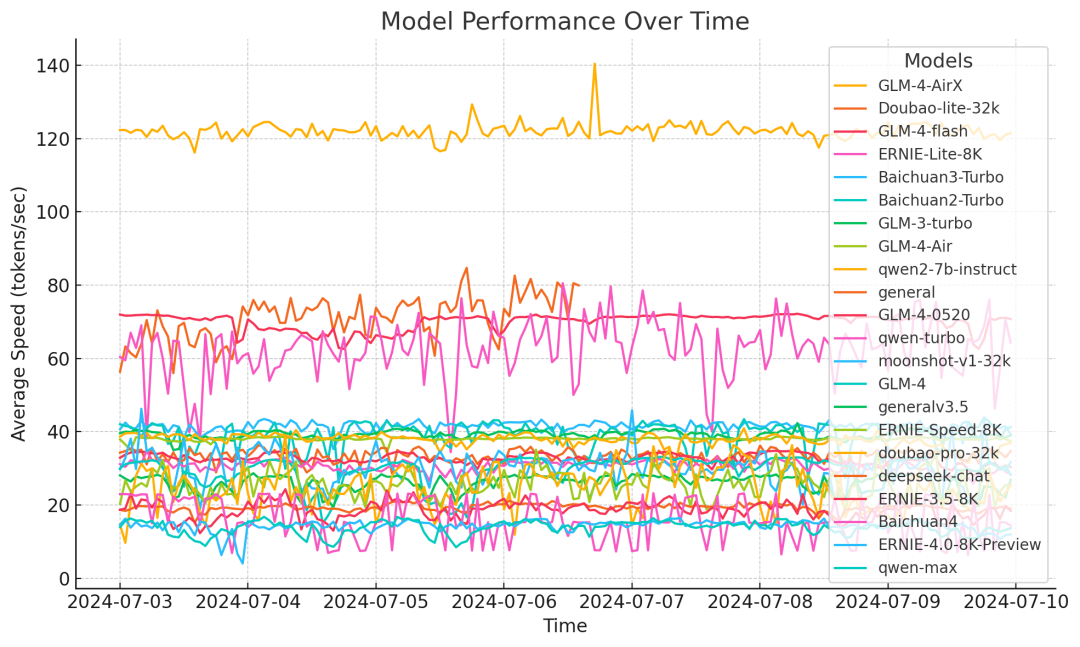

Pode-se dizer que o modelo GLM-4-Flash tem uma grande vantagem tanto em termos de "velocidade" quanto de "desempenho".

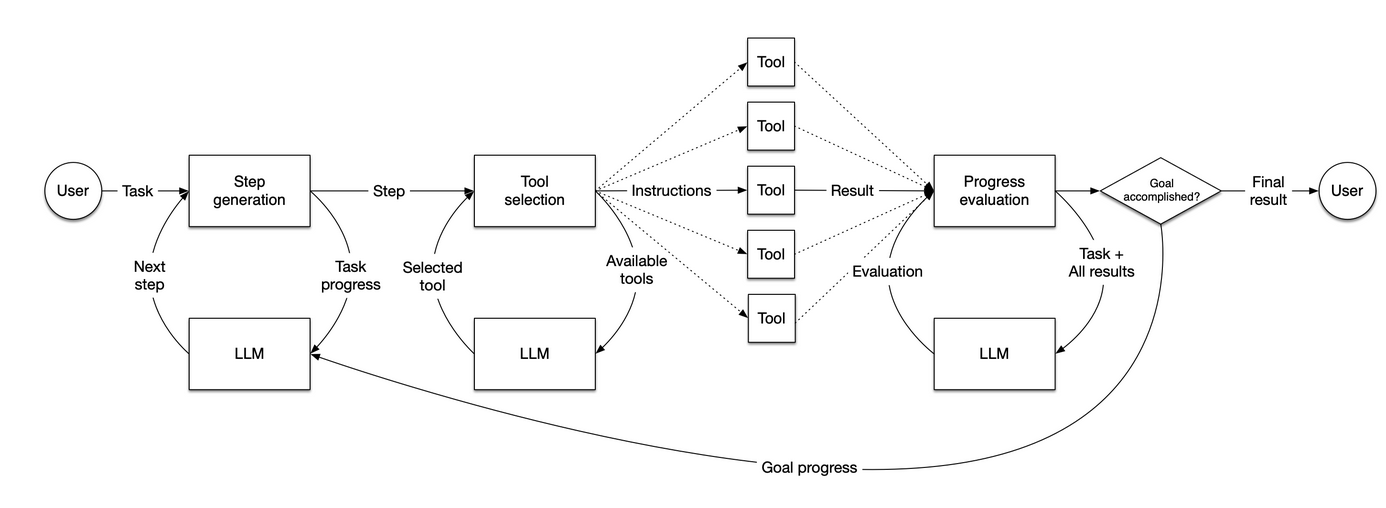

Para melhorar a velocidade de inferência do modelo, o GLM-4-Flash adota várias medidas de otimização, como quantificação de peso adaptável, várias técnicas de processamento paralelo, estratégia de processamento em lote e amostragem especulativa. De acordo com os resultados do teste de velocidade do modelo de terceiros, a velocidade de inferência do GLM-4-Flash é estável em torno de 72,14 tokens/s em um ciclo de teste de uma semana, o que é significativamente melhor do que outros modelos.

Em termos de desempenho, o GLM-4-Flash usa até 10T de dados multilíngues de alta qualidade na fase de pré-treinamento do modelo, o que permite que o modelo raciocine sobre diálogos de várias rodadas, pesquisas na Web, invocações de ferramentas e textos longos (com suporte para comprimentos de contexto de até 128K).Comprimento de saída 4K), etc. Ele suporta 26 idiomas, incluindo chinês, inglês, japonês, coreano e alemão.

Com base na API GLM-4-Flash totalmente gratuita e aberta, a fim de ajudar os usuários a aplicar melhor o modelo a cenários de aplicação específicos, fornecemos simultaneamente funções de ajuste fino do modelo para atender às necessidades de diferentes usuários. Bem-vindo ao uso!

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...