Demonstra-se que: a RL supera a SFT no aprendizado de conhecimentos generalizáveis, especialmente em tarefas multimodais, mostrando habilidades mais fortes de raciocínio e reconhecimento visual

breve

No campo da inteligência artificial.modelo básico(por exemplo, modelos de linguagem em larga escala e modelos de linguagem visual) se tornaram uma força central que impulsiona o progresso tecnológico. No entanto, como aprimorar efetivamente a capacidade desses modelos?capacidade de generalizaçãoO desafio de se adaptar à complexidade e à variabilidade dos cenários da vida real continua sendo um dos principais. Atualmente.Ajuste fino supervisionado (SFT) e aprendizado por reforço (RL)são dois métodos pós-treinamento amplamente adotados, mas suas funções e efeitos específicos no aprimoramento da capacidade de generalização dos modelos ainda não estão claros.

Essa tese é apoiada por umEstudo comparativo aprofundadoEm nosso estudo, exploramos sistematicamente o impacto da SFT e da RL sobre os recursos de generalização do modelo subjacente. Nosso foco está nos dois aspectos principais a seguir:

- Generalização baseada em regras textuais: Projetamos um sistema chamado Pontos gerais de um jogo de cartas de raciocínio aritmético que avalia o desempenho do modelo sob diferentes variantes de regras.

- Generalização visual: Usamos o V-IRL um ambiente de navegação baseado em entrada visual do mundo real, para testar a capacidade do modelo de se adaptar às mudanças na entrada visual.

Por meio de uma série deExperimentação e análise rigorosasChegamos às seguintes conclusões importantes:

- A RL supera a SFT na generalização visual e de regras: A RL é capaz de aprender e aplicar novas regras de forma eficiente, mantendo um bom desempenho na presença de variações de entrada visual. Em contrapartida, a SFT tende a memorizar os dados de treinamento e tem dificuldade de se adaptar a variantes não vistas.

- A RL aprimora o reconhecimento visual: Na modelagem de linguagem visual (VLM), a RL não apenas melhora o raciocínio, mas também aprimora o reconhecimento visual, enquanto a SFT reduz o reconhecimento visual.

- O SFT é fundamental para o treinamento de RL: O SFT é um fator essencial para o sucesso do treinamento de RL quando o modelo de backbone não tem boa capacidade de seguir instruções. Ele estabiliza o formato de saída do modelo para que a RL possa aproveitar ao máximo seu desempenho.

- A expansão do número de iterações de verificação melhora a generalização da RL: No treinamento de RL, o aumento do número de iterações de validação pode melhorar ainda mais a generalização do modelo.

Essas descobertasFornece percepções valiosas para futuras pesquisas e aplicações de IANeste estudo, foi demonstrado que a RL tem mais potencial em tarefas multimodais complexas. Nosso estudo não apenas revela as diferentes funções da SFT e da RL, mas também fornece novas ideias sobre como combinar essas duas abordagens de forma mais eficaz para criar modelos subjacentes mais avançados e confiáveis.

Se você é um pesquisador de IA, um engenheiro ou um leitor interessado no futuro da IA, este documento fornecerá insights e orientações práticas. Vamos nos aprofundar nos mistérios da SFT e da RL para revelar o caminho crítico para a generalização do modelo subjacente.

Texto original:https://tianzhechu.com/SFTvsRL/assets/sftvsrl_paper.pdf

leitura rápida

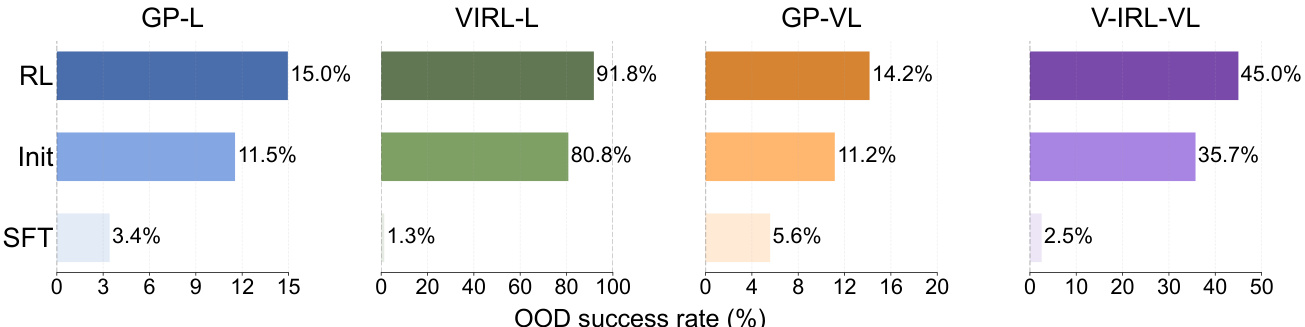

1. A RL supera a SFT na generalização de regras

Conclusão:

A RL é capaz de aprender e generalizar regras baseadas em texto com eficiência, enquanto a SFT tende a memorizar dados de treinamento e tem dificuldade de se adaptar a variantes de regras não vistas.

Exemplo:

A RL supera a SFT no desempenho fora de distribuição (OOD) nas tarefas GeneralPoints e V-IRL.

- GeneralPoints (GP-L):

- RL. A taxa de sucesso foi de 15,01 TP3T, o que representa um aumento em relação aos 11,51 TP3T no ponto de controle inicial. +3.5%.

- SFT. A taxa de sucesso foi de 3,41 TP3T, uma redução em relação aos 11,51 TP3T no ponto de controle inicial. -8.1%.

- V-IRL (V-IRL-L):

- RL. A precisão por etapa foi de 91,8%, uma melhoria em relação aos 80,8% no ponto de verificação inicial +11.0%.

- SFT. A precisão por etapa foi de 1,31 TP3T, abaixo dos 80,81 TP3T no ponto de controle inicial -79.5%.

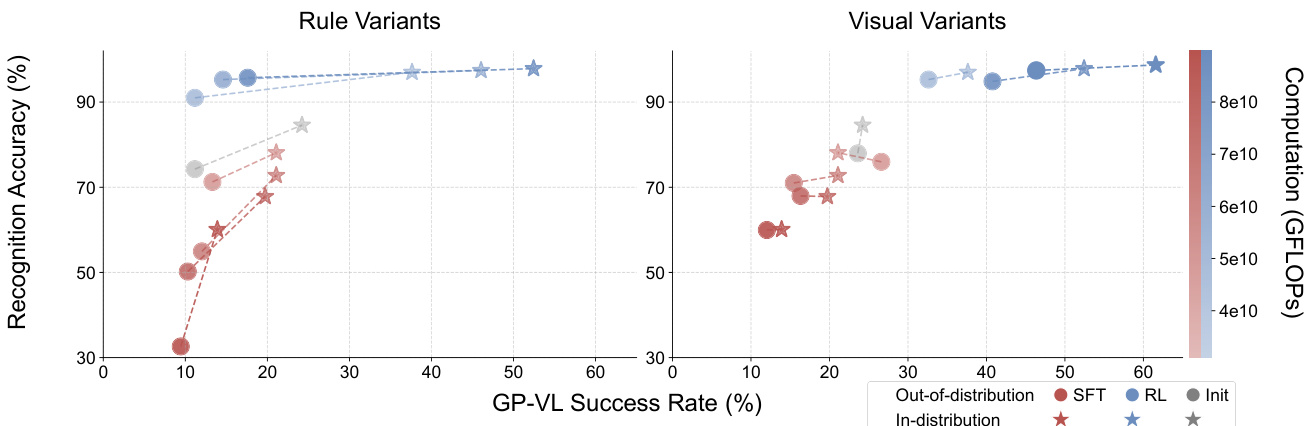

Figura 6: Para cada subgráfico, a RL e a SFT são treinadas usando a mesma quantidade de computação, e seu ponto de verificação inicial compartilhado (rotulado como Init) é definido como linha de base. Consulte o Apêndice C.3 para ver as configurações detalhadas.

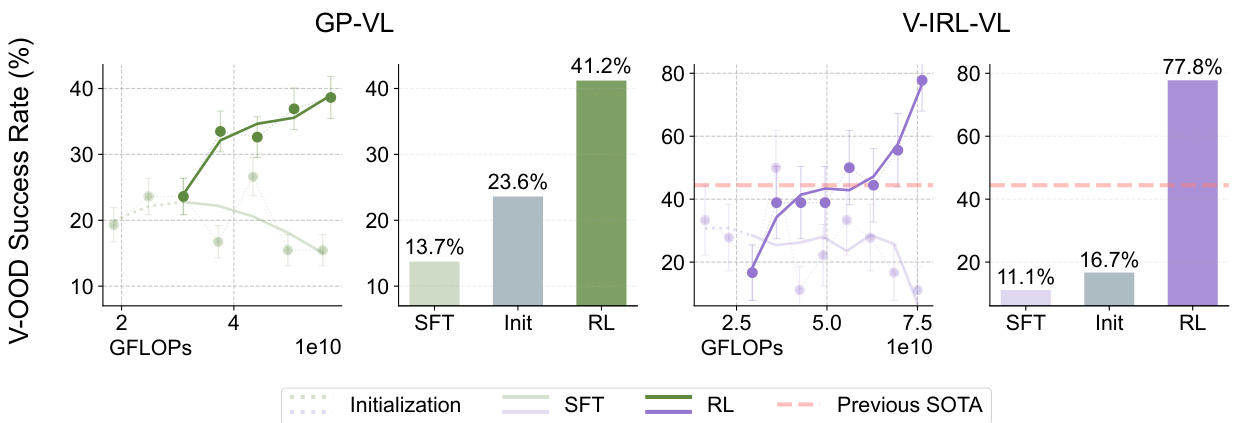

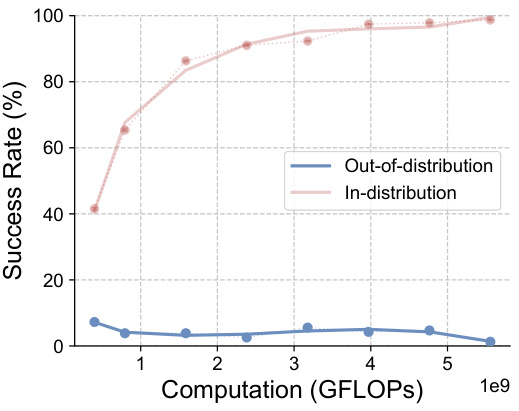

2. A RL também é generalizada em tarefas de OOD visual, enquanto a SFT tem um desempenho ruim

Conclusão:

Mesmo em tarefas que contêm modalidades visuais, a RL ainda é capaz de generalizar para variantes visuais não vistas, enquanto a SFT sofre degradação do desempenho.

Exemplo:

Nas tarefas GeneralPoints-VI e V-IRL-VL:

- GeneralPoints-VI (GP-VI):

- RL. A taxa de sucesso foi de 41,21 TP3T, um aumento em relação aos 23,61 TP3T no ponto de controle inicial +17.6%.

- SFT. A taxa de sucesso foi de 13,71 TP3T, abaixo dos 23,61 TP3T no ponto de controle inicial. -9.9%.

- V-IRL-VL (V-IRL-VL):

- RL. A precisão por etapa foi de 77,81 TP3T, uma melhoria em relação aos 16,71 TP3T no ponto de verificação inicial +61.1%.

- SFT. A precisão por etapa foi de 11,11 TP3T, abaixo dos 16,71 TP3T no ponto de controle inicial -5.6%.

Figura 7: Semelhante às Figuras 5 e 6, mostramos a dinâmica de desempenho (mostrada como linhas) e o desempenho final (mostrado como barras) avaliados fora da distribuição visual. O estado da arte anterior no teste de referência pequeno V- IRL VLN (Yang et al., 2024a) está marcado em laranja. Consulte o Apêndice C.3 para obter a configuração detalhada da avaliação (e suavização de curva).

3. A RL aprimora o reconhecimento visual de VLMs

Conclusão:

A RL não apenas melhora a inferência do modelo, mas também aprimora seu reconhecimento visual, enquanto a SFT reduz o reconhecimento visual.

Exemplo:

Na tarefa GeneralPoints-VI:

- RL. À medida que a quantidade de computação de treinamento aumenta, tanto a precisão do reconhecimento visual quanto a taxa de sucesso geral melhoram.

- SFT. À medida que a quantidade de computação de treinamento aumenta, tanto a precisão do reconhecimento visual quanto a taxa de sucesso geral diminuem.

Figura 8: Comparação da taxa de reconhecimento e da taxa de sucesso do Reinforcement Learning (RL) e do Supervised Fine Tuning (SFT) em diferentes variantes do GP-VL. Os gráficos mostram o desempenho da taxa de reconhecimento (eixo y) e a taxa de sucesso em tela única (eixo x), correspondente aos dados dentro da distribuição (vermelho) e fora da distribuição (azul), respectivamente. A transparência dos pontos de dados (barras coloridas) representa a quantidade de cálculos de treinamento. Os pares de dados conectados por linhas (⋆-◦ ) são avaliados usando os mesmos pontos de controle. Os resultados mostram que o aprendizado por reforço (RL) melhora a taxa de reconhecimento e a precisão geral à medida que a quantidade de computação pós-treinamento aumenta, enquanto o ajuste fino supervisionado (SFT) mostra a tendência oposta.

Figura 8: Comparação da taxa de reconhecimento e da taxa de sucesso do Reinforcement Learning (RL) e do Supervised Fine Tuning (SFT) em diferentes variantes do GP-VL. Os gráficos mostram o desempenho da taxa de reconhecimento (eixo y) e a taxa de sucesso em tela única (eixo x), correspondente aos dados dentro da distribuição (vermelho) e fora da distribuição (azul), respectivamente. A transparência dos pontos de dados (barras coloridas) representa a quantidade de cálculos de treinamento. Os pares de dados conectados por linhas (⋆-◦ ) são avaliados usando os mesmos pontos de controle. Os resultados mostram que o aprendizado por reforço (RL) melhora a taxa de reconhecimento e a precisão geral à medida que a quantidade de computação pós-treinamento aumenta, enquanto o ajuste fino supervisionado (SFT) mostra a tendência oposta.

4. O SFT é necessário para o treinamento de RL

Conclusão:

O SFT é necessário para o treinamento de RL quando o modelo de backbone não tem um bom acompanhamento de comando.

Exemplo:

Todos os experimentos em que a RL de ponta a ponta foi aplicada diretamente ao Llama-3.2 pós-treinamento sem a inicialização do SFT terminaram em fracasso.

- Estudos de casos de falhas:

- O modelo gera respostas longas, digressivas e não estruturadas que não conseguem recuperar informações e recompensas associadas ao treinamento de RL.

- Por exemplo, o modelo tenta resolver o jogo de 24 pontos escrevendo código, mas não consegue concluir a geração do código, o que resulta em uma falha de validação.

![]()

Figura 20: Registramos as respostas do modelo usando dicas semelhantes às mostradas na Figura 11. Os resultados mostram que a Llama-3.2-Vision-11B não consegue seguir as instruções corretamente. Omitimos respostas longas que tentavam resolver o quebra-cabeça por meio de código, mas que não foram concluídas dentro da duração limitada do contexto.

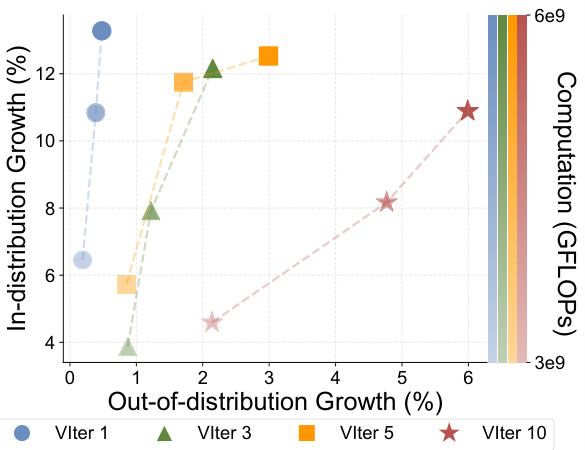

5. A expansão do número de iterações de validação melhora a capacidade de generalização da RL

Conclusão:

No treinamento de RL, o aumento do número de iterações de validação melhora a generalização do modelo.

Exemplo:

Na tarefa de linguagem de pontos gerais (GP-L):

- 1 iteração de validação. O desempenho do OOD é aprimorado apenas por +0.48%.

- 3 iterações de validação. O desempenho do OOD é aprimorado +2.15%.

- 5 iterações de validação. O desempenho do OOD é aprimorado +2.99%.

- 10 iterações de validação. O desempenho do OOD é aprimorado +5.99%.

Figura 10: Registramos experimentos de RL com números variados de iterações de validação (VIter) como uma forma de aumentar a quantidade de cálculos de treinamento (transparência de cores).

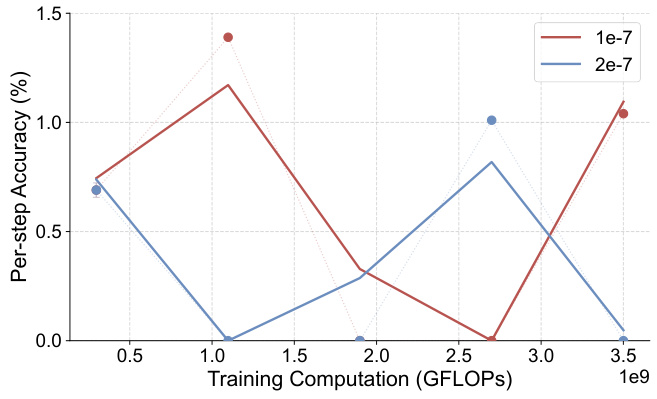

6. SFT com ajuste excessivo aos marcadores de inferência e ignorando os marcadores de reconhecimento

Conclusão:

A SFT tende a se ajustar excessivamente aos marcadores inferidos e a se concentrar menos nos marcadores identificados, possivelmente devido à alta frequência dos marcadores inferidos.

Exemplo:

Na tarefa GeneralPoints-VI, a SFT não conseguiu obter um desempenho de intra-distribuição comparável ao da RL, mesmo depois de ajustar os hiperparâmetros.

- Estudo de ablação de SFT.

- Após o ajuste da taxa de aprendizado e de outros componentes ajustáveis, nenhuma das taxas de sucesso do SFT excedeu 30% e não apresentou tendência de aumento.

Figura 16: Estudo de ablação do GeneralPoints-VL SFT. Realizamos experimentos de ablação na taxa de aprendizado e relatamos a taxa de sucesso de tela única dentro da distribuição (%) para todos os experimentos. Nenhum dos experimentos teve taxas de sucesso acima de 30% e não apresentaram tendência de aumento.

7. A RL não pode recuperar o desempenho do OOD de pontos de verificação com ajuste excessivo

Conclusão:

Quando inicializada a partir de um ponto de verificação com ajuste excessivo, a RL não conseguiu recuperar o desempenho de OOD do modelo.

Exemplo:

Na tarefa V-IRL-VL:

- Inicialização de RL a partir de pontos de verificação superajustados: o

- A precisão inicial por etapa é menor que a do 1% e a RL não pode melhorar o desempenho do OOD.

Figura 19: Precisão de etapa única fora da distribuição (%) - GFLOPs: modelo V-IRL-VL sob variantes regulares (usando pontos de verificação iniciais superajustados). Consulte o Apêndice C.3 para obter detalhes sobre as métricas de avaliação.

resumos

Por meio de uma série de experimentos e análises, esta tese demonstra as vantagens da RL no aprendizado de conhecimentos generalizáveis e a tendência do SFT de favorecer a memorização dos dados de treinamento. A tese também destaca a importância do SFT para o treinamento de RL e o impacto positivo da expansão do número de iterações de validação sobre a capacidade de generalização da RL. Essas descobertas fornecem percepções valiosas para a criação de modelos de base mais robustos e confiáveis no futuro.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...