XTuner V1 - Mecanismo de treinamento de modelo grande de código aberto do Shanghai AI Lab

O que é o XTuner V1?

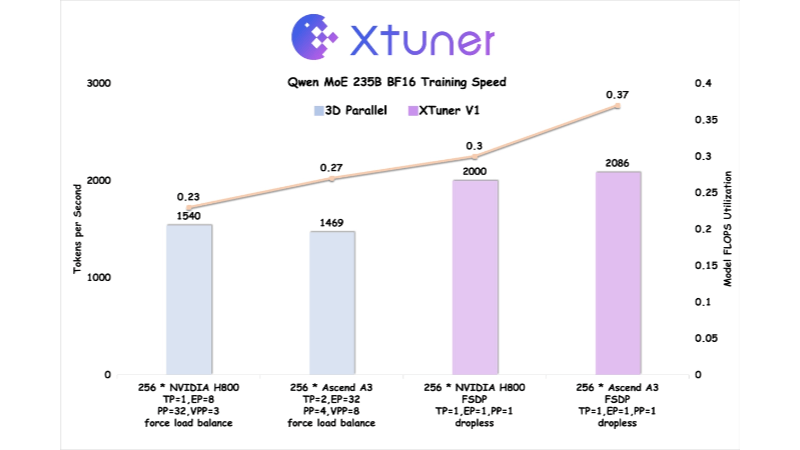

O XTuner V1 é uma nova geração de mecanismo de treinamento de modelos de grande porte com código aberto do Shanghai Artificial Intelligence Laboratory, projetado para treinamento de modelos de especialistas mistos (MoE) esparsos em escala ultragrande. Desenvolvido com base no PyTorch FSDP, o XTuner V1 alcança o treinamento de alto desempenho por meio da otimização multidimensional de memória, comunicação e carga, etc. O XTuner V1 oferece suporte ao treinamento de modelos MoE com até 1 trilhão de parâmetros e, pela primeira vez, supera a solução paralela 3D tradicional em termos de rendimento de treinamento em modelos de mais de 200 bilhões de escalas. Ele suporta o treinamento de sequências longas de 64k sem a tecnologia de paralelismo de sequências, o que reduz significativamente a dependência do paralelismo especializado e melhora a eficiência do treinamento de sequências longas.

Recursos do XTuner V1

- treinamento não destrutivoModelos MoE em escala de 200 bilhões podem ser treinados sem paralelismo especializado, e modelos de 600 bilhões requerem apenas paralelismo especializado no nó.

- Suporte a sequências longasTreinamento de comprimento de sequência de 64k de 200 bilhões de modelos MoE sem paralelismo de sequência: suporta treinamento de comprimento de sequência de 64k de 200 bilhões de modelos MoE sem paralelismo de sequência.

- alta eficiênciaSuporte ao treinamento de modelos MoE com 1 trilhão de parâmetros e taxa de transferência de treinamento de modelos de mais de 200 bilhões em relação ao paralelismo 3D tradicional.

- Otimização da memória de vídeoReduz os picos de memória gráfica por meio do mecanismo automático Chunk Loss e da tecnologia Async Checkpointing Swap.

- cobertura de comunicaçõesO consumo de tempo de comunicação é mascarado por meio da otimização da memória e da tecnologia Intra-Node Domino-EP.

- Balanceamento de carga DPMitigando o problema da bolha nula computacional causada pela atenção de comprimento variável e mantendo o balanceamento de carga na dimensão paralela dos dados.

- Co-otimização de hardwareOtimizado no supernó NPU do Ascend A3 em colaboração com a Huawei Rise, a eficiência do treinamento excede a do NVIDIA H800.

- Suporte a código aberto e cadeia de ferramentasXTuner V1, DeepTrace e ClusterX de código aberto para suporte total.

Principais benefícios do XTuner V1

- Treinamento eficienteSuporte ao treinamento de modelos MoE para até 1 trilhão de parâmetros, com rendimento de treinamento que supera as soluções paralelas 3D tradicionais para modelos em escala de mais de 200 bilhões.

- Processamento de sequências longasTreinamento de comprimento de sequência de 64k de 200 bilhões de modelos MoE sem paralelismo de sequência, adequado para cenários de processamento de texto longo, como aprendizado por reforço.

- baixa necessidade de recursosO modelo paramétrico de 200 bilhões não requer paralelismo especializado e o modelo de 600 bilhões requer apenas paralelismo especializado no nó, reduzindo os requisitos de recursos de hardware.

- Otimização da memória de vídeoA mais recente adição ao sistema é uma nova tecnologia que reduz significativamente os picos de memória por meio da perda automática de pedaços e da troca de pontos de verificação assíncronos para dar suporte ao treinamento de modelos maiores.

- otimização das comunicaçõesRedução do impacto da sobrecarga de comunicação na eficiência do treinamento, mascarando o consumo do tempo de comunicação por meio da otimização da memória e de técnicas de Domino-EP intra-nó.

- balanceamento de cargaMitigando o problema da bolha nula computacional causada pela atenção de comprimento variável, garantindo o balanceamento de carga na dimensão paralela dos dados e melhorando a eficiência do treinamento.

Qual é o site oficial do XTuner V1?

- Site do projeto:: https://xtuner.readthedocs.io/zh-cn/latest/

- Repositório do GitHub:: https://github.com/InternLM/xtuner

Pessoas a quem o XTuner V1 se destina

- Pesquisadores de modelos grandesXTuner V1: Para os pesquisadores que precisam treinar modelos de especialização mista (MoE) esparsos em escala ultragrande, o XTuner V1 oferece um mecanismo de treinamento de alto desempenho que suporta o treinamento de modelos com até 1 trilhão de parâmetros.

- Engenheiro de aprendizado profundoPara engenheiros envolvidos em treinamento distribuído em larga escala, o XTuner V1 oferece recursos otimizados de comunicação e gerenciamento de memória para melhorar significativamente a eficiência do treinamento.

- Desenvolvedores de infraestrutura de IAPara os desenvolvedores que se concentram na co-otimização de hardware e na computação de alto desempenho, o XTuner V1 trabalha com a equipe de tecnologia Rise da Huawei para fornecer otimizações detalhadas específicas de hardware.

- Colaboradores da comunidade de código abertoO código-fonte aberto do XTuner V1 oferece uma grande variedade de oportunidades de desenvolvimento e otimização para desenvolvedores interessados em projetos de código-fonte aberto e que desejam contribuir.

- Equipe de IA empresarialO XTuner V1 oferece suporte de cadeia de ferramentas fácil de usar e de alto desempenho para equipes empresariais que precisam de uma solução eficiente e de baixo limiar para treinar modelos grandes.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...