Implementação privada sem GPUs locais DeepSeek-R1 32B

com relação a DeepSeek-R1 Para uso diário no escritório, diretamente no site oficial é a melhor opção, se você tiver outras preocupações ou necessidades especiais... Ele deve ser usado no Implementação local do DeepSeek-R1 (com instalador de um clique)Os tutoriais em branco aqui são perfeitos para você.

Se você tiver um computador mal configurado, mas ainda quiser implantar usando o DeepSeek-R1 privado ... Então, considere o uso de GPUs gratuitas, como todos aprenderam há muito tempo Implementando o modelo de código aberto DeepSeek-R1 on-line com potência de GPU gratuitaNo entanto, há uma desvantagem fatal, ou seja, a GPU gratuita só pode instalar 14B, a instalação de 32B será muito difícil, mas, após o teste, só é possível instalar o DeepSeek-R1 com 32B ou mais de qualidade de saída para atender às necessidades do trabalho diário.

Então... O que vamos fazer é instalar GPUs gratuitas na execução eficiente de Versão quantitativa do DeepSeek-R1 32B. Ele está chegando!

Na GPU gratuita, isso pode ser feito na saída de 2 a 6 palavras por segundo (de acordo com a complexidade do problema, a velocidade de saída varia); a desvantagem desse método é que você precisa ativar o serviço de tempos em tempos.

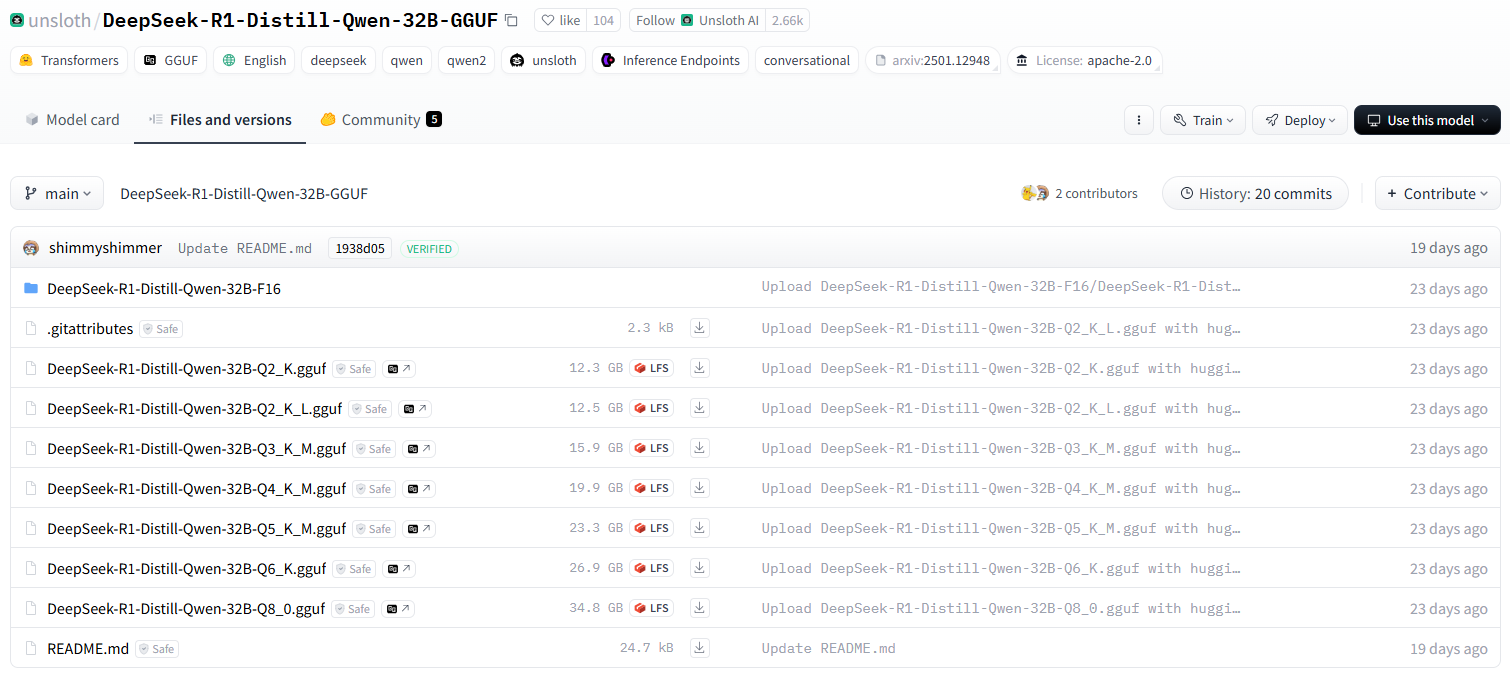

equipe unsloth versão quantificada DeepSeek-R1

sem preguiça A versão fornecida do Qwen-32B-Q4_K_M é compactada até 20 GB, o que já é capaz de ser executado em uma única placa de nível de consumidor..

Um breve resumo dos requisitos de desempenho do computador para a versão quantificada

DeepSeek-R1-Distill-Qwen-32B-GGUFDescrição das diferentes versões quantitativas do modelo

O sufixo de cada arquivo (por exemplo, Q2_K_L, Q4_K_M, etc.) representa uma quantificação diferente. Veja a seguir suas principais diferenças:

q2_k_l, q3_k_m, q4_k_m, q5_k_m, q6_k, q8_0

Q2eQ3eQ4eQ5eQ6eQ8denota o número de bits a serem calculados (por exemploQ4(indica um cálculo de 4 bits).Kalém deMPode ser uma estratégia quantitativa ou um nível de precisão diferente.Q8_0Normalmente, a quantificação de 8 bits, próxima à precisão do FP16, com as maiores demandas computacionais, mas com melhor qualidade de inferência.

DeepSeek-R1-Distill-Qwen-32B-F16

F16indicarPonto flutuante de 16 bits (FP16)é o modelo não calculado, que tem a maior precisão, mas usa a maior parte da memória de vídeo.

Saiba mais sobre o conceito de quantificação aqui:O que é quantificação de modelo: explicação dos tipos de dados FP32, FP16, INT8 e INT4

Como faço para escolher a versão correta?

- Dispositivos com pouca memória de vídeo (por exemplo, GPUs de consumo) →SelectQuantificação de Q4, Q5Por exemplo

Q4_K_MtalvezQ5_K_MO equilíbrio entre desempenho e precisão. - Dispositivos de memória extremamente baixos (por exemplo, operação da CPU) →SelectQuantificação Q2 ou Q3Por exemplo

Q2_K_LtalvezQ3_K_Mreduzindo o espaço ocupado pela memória. - Servidores de GPU de alto desempenho→SelectQuantificação de Q6 ou Q8Por exemplo

Q6_KtalvezQ8_0obtendo uma melhor qualidade de raciocínio. - mais eficaz→Select

F16mas requer uma quantidade significativa de armazenamento significativo (cerca de 60 GB ou mais).

Versão de instalação recomendada da GPU gratuita

Q2_K_L

Iniciar a instalação do DeepSeek-R1 32B

De como obter uma GPU gratuita até sua instalação Ollama Processo de leitura rápida ou leitura:Implementando o modelo de código aberto DeepSeek-R1 on-line com potência de GPU gratuitaA única diferença em relação ao tutorial anterior é uma pequena alteração no comando de instalação.

Vá direto ao processo de instalação de uma versão específica do Quantised no Ollama. Felizmente, o Ollama simplificou ao máximo todo o processo de instalação, exigindo apenas um comando de instalação para aprender.

1. instalando o formato de comando base do modelo de controle de versão quantitativo huggingface

Lembre-se do seguinte formato de comando de instalação

ollama run hf.co/{username}:{reponame}

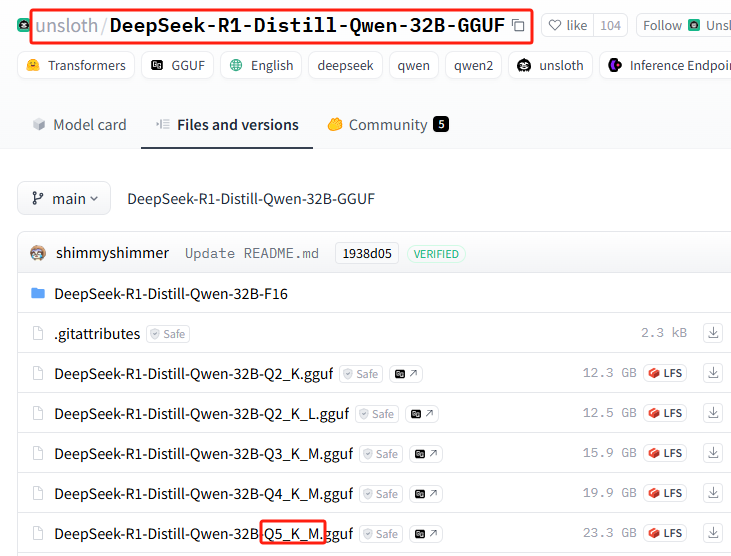

2. seleção da versão quantitativa

Lista de todas as versões quantitativas: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

Esta instalação usa: Q5_K_M (apenas para fins de demonstração, oNovamente, instale a versão gratuita recomendada pela GPU!(O Q5 requer 23 G de espaço no disco rígido para a instalação real)

3. comando de instalação de emenda

{username}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

Splice para obter o comando de instalação completo:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

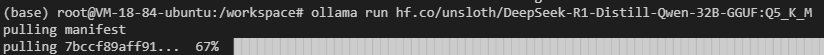

4 - Realize a instalação no Ollama

Execute o comando de instalação

Você pode enfrentar falhas de rede (boa sorte com isso), repita o comando de instalação mais algumas vezes...

Ainda não está funcionando? Execute o seguinte comando para tentar (alterne para o endereço de espelho doméstico):ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

Por que você não usa apenas o endereço do espelho para fazer o download, em vez de usar primeiro o endereço oficial e depois o espelho?

Isso ocorre porque a instalação integrada é mais rápida!

É claro que talvez você não precise dessa versão quantificada. Aqui está uma versão popular mais recente e sem censura: ollama run huihui_ai/deepseek-r1-abliterated:14b

5. tornar Ollama acessível aos párias

Confirme a porta Ollama digitando o comando no terminal

ollama serve

11414 ou 6399

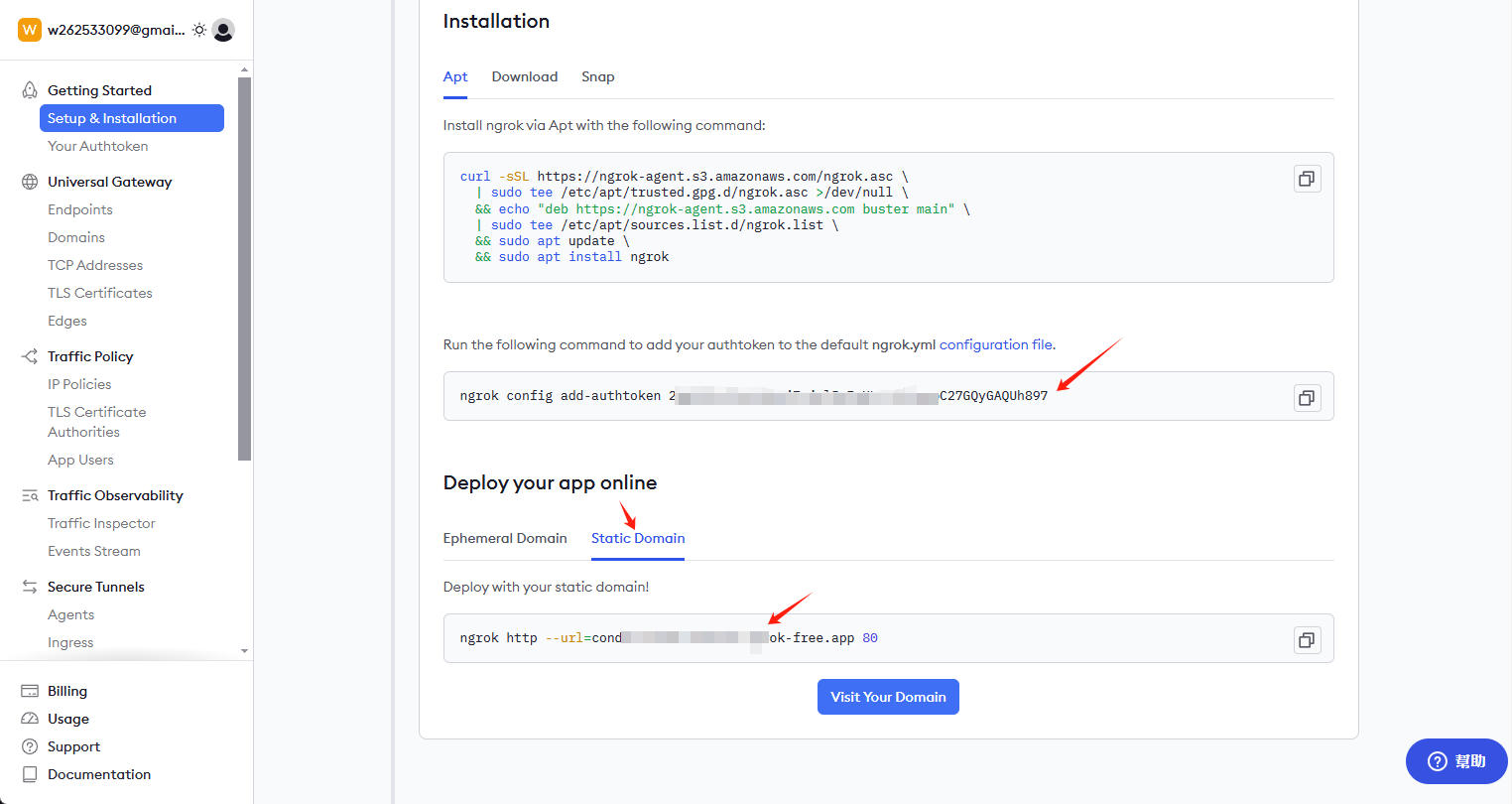

Instalação do ngrok

curl -sSL https://ngrok-agent.s3.amazonaws.com/ngrok.asc \ | tee /etc/apt/trusted.gpg.d/ngrok.asc >/dev/null \ && echo "deb https://ngrok-agent.s3.amazonaws.com buster main" \ | tee /etc/apt/sources.list.d/ngrok.list \ && apt update \ && apt install ngrok

Obter chave e link permanente

Visite ngrok.com para se registrar em uma conta e vá para a página inicial para obter a chave e o link permanente

Instale a chave e ative o endereço de acesso externo

Digite o seguinte comando no cliente:

ngrok config add-authtoken 这里是你自己的密钥

Continue a inserir os seguintes comandos para abrir o acesso externo: 6399 essa porta pode ser diferente de todas, verifique e modifique a sua própria

ngrok http --url=condor-known-ferret.ngrok-free.app 6399

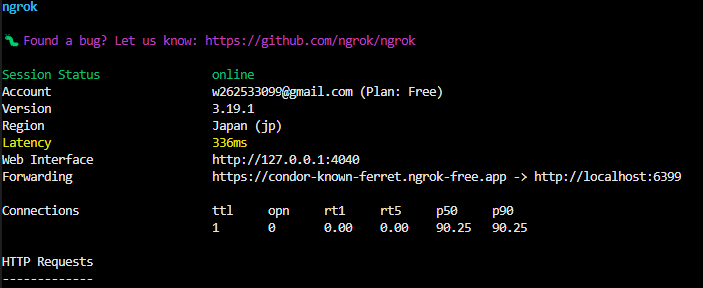

Após o sucesso, você verá no terminal

https://condor-known-ferret.ngrok-free.app é o endereço de acesso da interface do modelo, abra-o e você verá o seguinte conteúdo

fazer uso de

Obtido em https://condor-known-ferret.ngrok-free.app如何使用?

A maneira mais fácil de fazer isso é instalar o Assistência à página Usada em conjunto, a ferramenta é um plug-in de navegador que se instala sozinho.

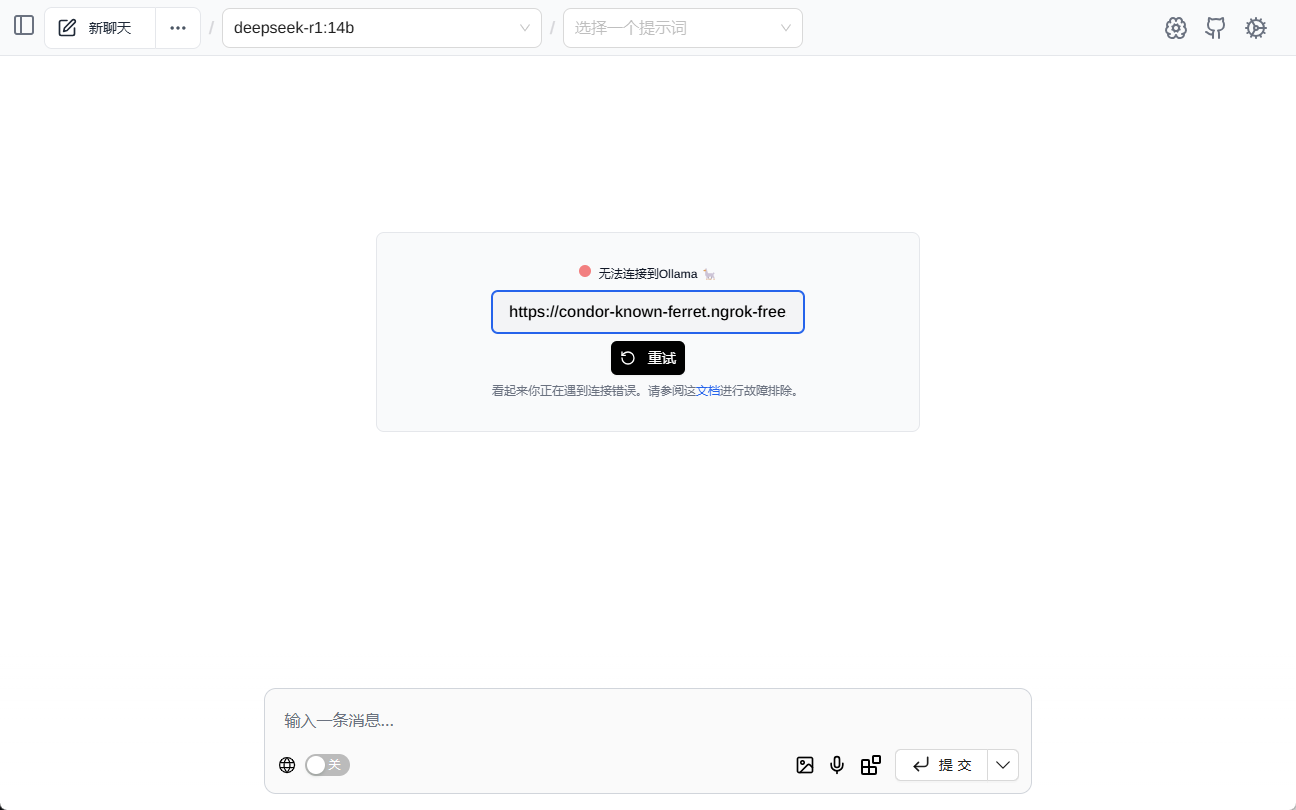

configurar

show (um ingresso) Assistência à página Depois disso, você verá a seguinte interface, preencha o endereço da interface

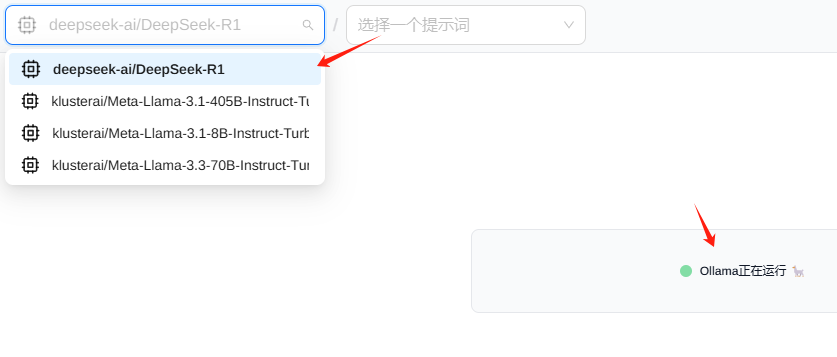

Normalmente, você verá o modelo carregado automaticamente

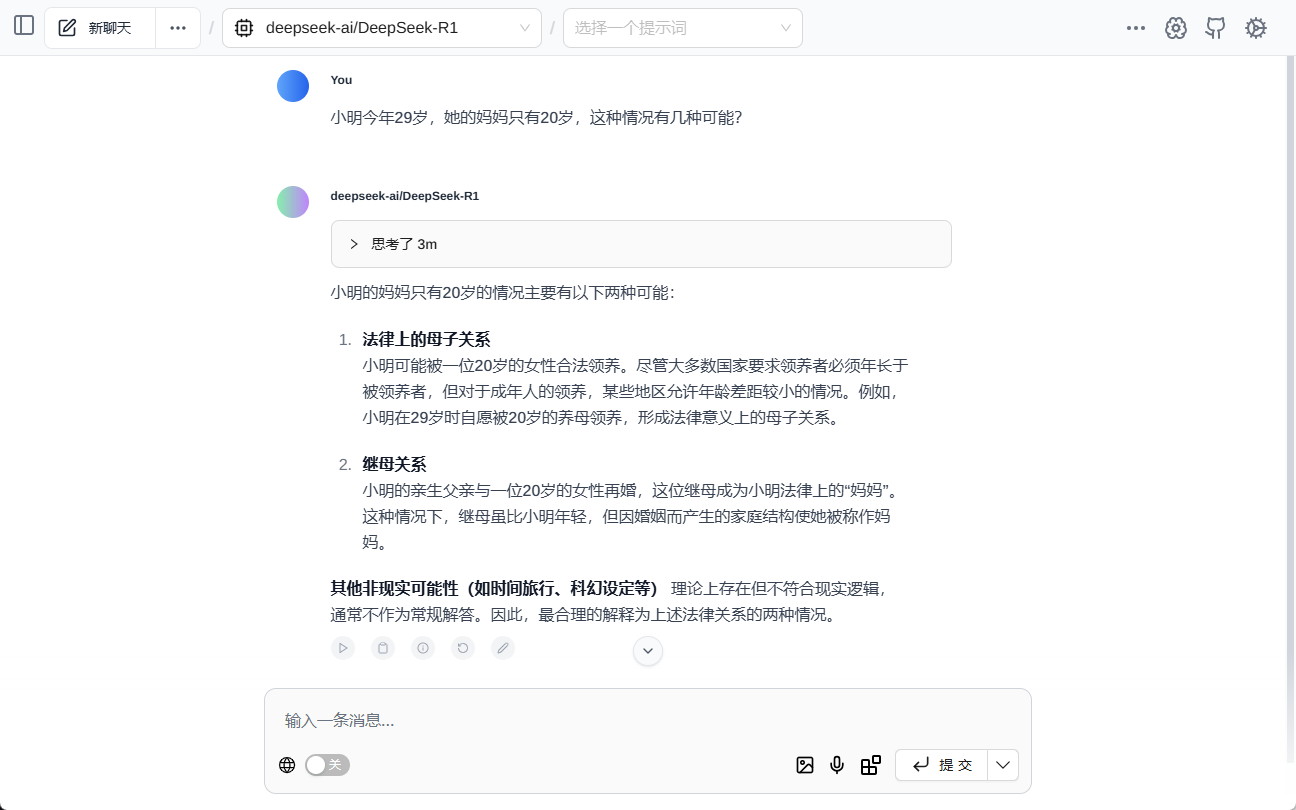

teste (maquinário etc.)

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...