VITA: Modelos de linguagem multimodal de grande porte de código aberto para interação visual e de fala em tempo real

Introdução geral

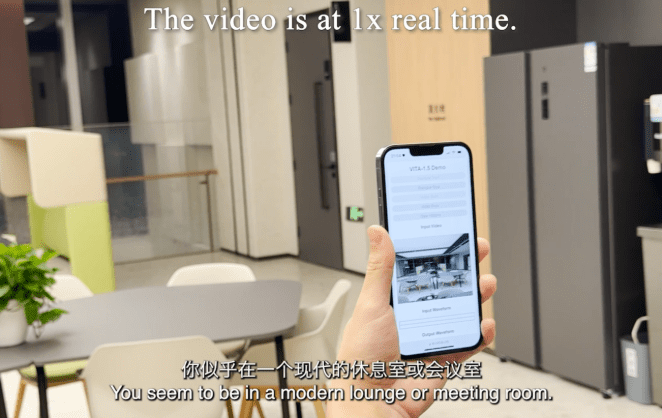

O VITA é um projeto líder de modelagem de linguagem grande multimodal interativa de código aberto, pioneiro na capacidade de obter uma verdadeira interação multimodal completa. O projeto lançou o VITA-1.0 em agosto de 2024, sendo pioneiro no primeiro modelo de linguagem grande multimodal interativo de código aberto e, em dezembro de 2024, o projeto lançou uma versão de atualização importante, o VITA-1.5, que melhora significativamente a experiência e o desempenho da interação. O modelo VITA é compatível com entradas e saídas multimodais, como imagem, vídeo e áudio, e é equipado com recursos de interação em tempo real, reduzindo significativamente a latência da interação de voz de ponta a ponta de 4 segundos para 1,5 segundos. O modelo VITA oferece suporte a entradas e saídas multimodais, como imagem, vídeo e áudio, e é equipado com recursos de interação em tempo real, o que reduz significativamente a latência da interação por voz de ponta a ponta de 4 segundos para 1,5 segundo, aprimorando muito a experiência do usuário. Como um projeto de código-fonte totalmente aberto, o VITA oferece uma plataforma ideal para pesquisadores e desenvolvedores explorarem a IA multimodal.

Lista de funções

- Processamento de entrada multimodal: suporta imagem, vídeo, áudio e outras formas de entrada

- Interação de voz em tempo real: latência de interação de voz de ponta a ponta de apenas 1,5 segundo

- Recursos de análise visual: recursos avançados de compreensão e análise de imagens e vídeos

- Processamento de áudio: suporta reconhecimento e síntese de fala

- Compreensão multimodal: rumo à correlação inteligente entre texto, imagem e áudio

- Suporte de código aberto: o código completo de treinamento e inferência é aberto

- Modelos pré-treinados: várias versões de modelos pré-treinados estão disponíveis

- Opções flexíveis de implementação: suporta implementações de várias plataformas de hardware

Visão geral do VITA-1.5

Em 12 de agosto de 2024, lançamos o VITA-1.0Isso é O primeiro modelo de macrolinguagem multimodal interativo e completo de código aberto. E agora (20 de dezembro de 2024), trazemos a você o Nova versão VITA-1.5!

O que há de novo no VITA-1.5?

Temos o prazer de apresentar VITA-1.5que introduziu uma série de avanços:

- Reduzir significativamente a latência da interação.. A latência da interação de voz de ponta a ponta aumentou de Aprox. 4 segundos Redução para 1,5 segundospermitindo uma interação quase instantânea e melhorando muito a experiência do usuário.

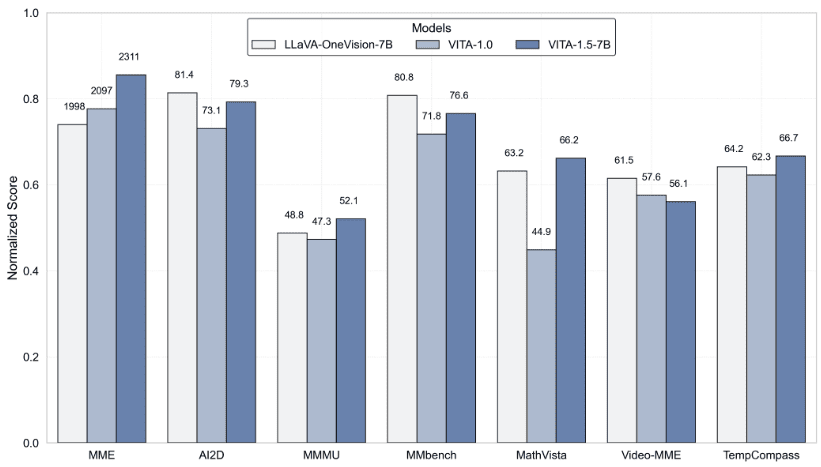

- Desempenho multimodal aprimorado. Em MMEeMMBench responder cantando MathVista O desempenho médio em benchmarks multimodais, como o 59.8 aumentá-lo para 70.8.

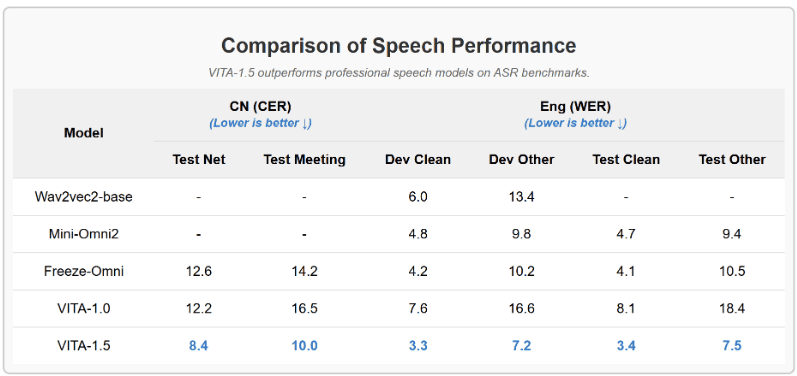

- Aprimoramento do recurso de processamento de fala.. Um novo nível de poder de processamento de fala foi alcançado, com a ASR WER (Word Error Rate, Test Other) aumentando de 18.4 Diminuir para 7.5. Além disso, usamos Módulo TTS de ponta a ponta Substitui o módulo TTS autônomo do VITA-1.0, que aceita como entrada a incorporação de grandes modelos de linguagem.

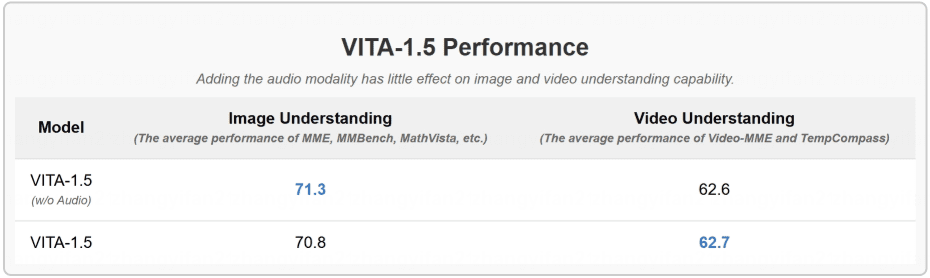

- Estratégias de treinamento progressivo. Dessa forma, a inclusão do módulo de fala tem pouco efeito sobre o outro desempenho multimodal (visual-verbal). O desempenho médio da compreensão de imagens só diminuiu de 71,3 para 70,8.

Resultados

- Avaliação de testes de benchmark de compreensão de imagens e vídeos

- O VITA-1.5 supera os modelos profissionais de fala em benchmarks de ASR

- A inclusão da modalidade de áudio tem pouco efeito sobre a compreensão de imagens e vídeos

Usando a Ajuda

1. configuração e instalação do ambiente

1.1 Requisitos da fundação:

- Ambiente Python

- Estrutura PyTorch

- Suporte a CUDA (recomenda-se a aceleração de GPU)

1.2 Etapas de instalação:

# 克隆项目仓库

git clone https://github.com/VITA-MLLM/VITA.git

cd VITA

# 安装依赖

pip install -r requirements.txt

2. uso de modelos

2.1 Carregamento do modelo pré-treinado:

from vita.model.builder import load_pretrained_model

from vita.conversation import conv_templates

from vita.util.mm_utils import get_model_name_from_path

# 加载模型

model_path = 'VITA/vita'

model_name = get_model_name_from_path(model_path)

tokenizer, model, image_processor, _ = load_pretrained_model(

model_path,

None,

model_name,

model_type='mixtral-8x7b',

device_map='auto'

)

2.2 Configuração do processamento de áudio:

# 初始化音频编码器

audio_encoder = model.get_audio_encoder()

audio_encoder.to(dtype=torch.float16)

audio_processor = audio_encoder.audio_processor

3. funções interativas em tempo real

- Suporta entrada e resposta de voz em tempo real

- Reconhecimento e análise integrados de imagens

- Oferece suporte a interações de diálogo em várias rodadas

- Fornecer um sistema completo de modelos de diálogo

4. uso de funções avançadas

4.1 Processamento de entrada multimodal:

- Suporta processamento de imagens em lote

- Análise em tempo real de fluxos de vídeo

- Processamento e síntese de fluxo de áudio

4.2 Treinamento e ajuste fino do modelo:

- Fornece scripts de treinamento completos

- Suporte para recursos de aprendizado contínuo

- Suporte ao treinamento de conjuntos de dados personalizados

5. avaliação e teste

- Suporta as principais referências de avaliação multimodal

- Ferramenta de avaliação VLMEvalKit integrada

- Fornece métricas detalhadas de testes de desempenho

6. cuidados

- As GPUs são recomendadas para inferência de modelos

- Preste atenção ao gerenciamento de memória, especialmente ao lidar com grandes entradas multimodais

- Verifique regularmente as atualizações do projeto para obter os recursos e as otimizações mais recentes

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...