Video Analyzer: analisa o conteúdo do vídeo e gera descrições detalhadas

Introdução geral

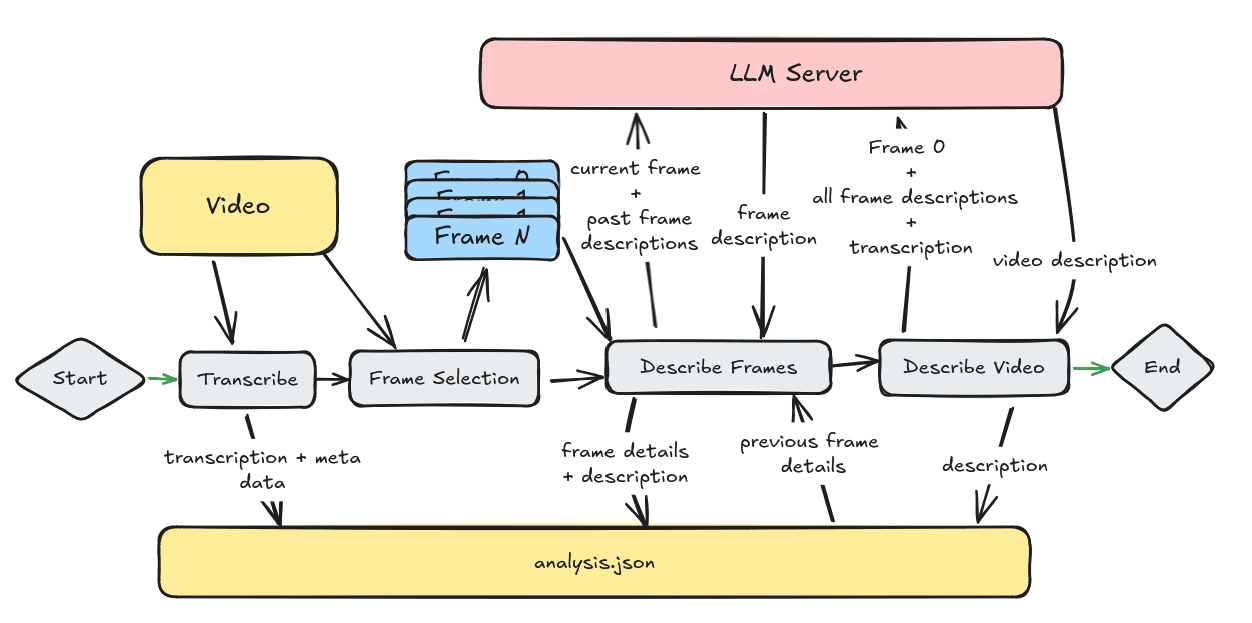

O Video Analyzer é uma ferramenta abrangente de análise de vídeo que combina visão computacional, transcrição de áudio e técnicas de processamento de linguagem natural para gerar descrições detalhadas do conteúdo do vídeo. A ferramenta ajuda os usuários a entender e analisar melhor o conteúdo de vídeo, extraindo quadros-chave do vídeo, transcrevendo o conteúdo de áudio e gerando descrições em linguagem natural. A ferramenta de análise de vídeo pode ser executada totalmente localmente, sem a necessidade de serviços de nuvem ou chaves de API, ou pode aproveitar qualquer serviço compatível com a API da OpenAI para obter velocidade e escala.

Lista de funções

- Extração de quadros de vídeoReconhece e extrai automaticamente os principais quadros dos vídeos.

- transcrição de áudioTranscrição de conteúdo de áudio usando o modelo Whisper.

- descrição de linguagem naturalConversão de quadros extraídos e conteúdo de áudio transcrito em descrições de linguagem natural.

- Suporte a vários modelosSuporte para análises usando diferentes modelos de linguagem em larga escala (por exemplo, o modelo Ollama Vision).

- resultado de saídaGerar um arquivo JSON contendo os resultados da análise para uso ou revisão posterior.

Usando a Ajuda

Processo de instalação

Para usar a ferramenta de análise de vídeo, primeiro você precisa instalar alguns softwares e bibliotecas necessários:

- armazém de clones::

- Use o Git para clonar um repositório de projeto no GitHub:

git clone https://github.com/byjlw/video-analyzer.git cd video-analyzer

- Use o Git para clonar um repositório de projeto no GitHub:

- Criação de um ambiente virtual::

- Para evitar conflitos de ambiente, é recomendável criar um novo ambiente virtual:

python3 -m venv .venv source .venv/bin/activate # 在Windows上使用 .venv\Scripts\activate

- Para evitar conflitos de ambiente, é recomendável criar um novo ambiente virtual:

- Instalação de dependências::

- Instale todos os pacotes Python necessários para o projeto:

pip install . - Ou, se desejar instalá-lo no modo de desenvolvimento, você pode usar:

pip install -e .

- Instale todos os pacotes Python necessários para o projeto:

- Configuração do FFmpeg::

- Certifique-se de ter o FFmpeg instalado em seu sistema para processamento de vídeo e áudio.

Uso de ferramentas de análise de vídeo

- Análise operacional::

- A maneira mais básica de usá-lo é especificar o arquivo de vídeo diretamente:

video-analyzer path/to/video.mp4 - Você pode passar mais parâmetros para personalizar o processo de análise:

video-analyzer video.mp4 --config custom_config.json --output ./custom_output --frames-per-minute 15 --duration 60 - Descrição do parâmetro:

--configEspecifica o caminho do arquivo de configuração.--outputCaminho de saída: Defina o caminho de saída.--frames-per-minuteNúmero de quadros extraídos por minuto: Defina o número de quadros extraídos por minuto.--durationLimite a duração do vídeo analisado em segundos.

- A maneira mais básica de usá-lo é especificar o arquivo de vídeo diretamente:

- resultado::

- Após a conclusão da análise, a ferramenta gera um

analysis.jsonque contém os resultados da análise de cada quadro-chave e uma descrição textual da transcrição do áudio.

- Após a conclusão da análise, a ferramenta gera um

- Configuração avançada::

- Você pode usar perfis personalizados para definir parâmetros mais detalhados, como escolher um tamanho específico de modelo do Whisper (minúsculo, básico, pequeno, médio, grande), definir o limite para detecção de idioma ou decidir se deseja manter as imagens de quadro extraídas ou não.

Função Fluxo de operação

- análise de estrutura::

- A ferramenta extrai os principais quadros do vídeo em uma taxa definida e, em seguida, executa uma análise de visão computacional de cada quadro, registrando seu registro de data e hora e os resultados da análise.

- processamento de áudio::

- O áudio é separado do vídeo e transcrito por meio do modelo Whisper. A transcrição é combinada com as informações dos quadros de vídeo para gerar uma descrição mais completa do vídeo.

- Gerar uma descrição::

- A ferramenta combina todos os dados analisados em uma descrição coerente do vídeo, usando quadros extraídos anteriormente e transcrições de áudio. Essa parte da funcionalidade utiliza técnicas de processamento de linguagem natural para tornar a descrição mais legível.

O uso dessa ferramenta ajuda os usuários a entender rapidamente o conteúdo do vídeo, especialmente em cenários em que um grande número de vídeos está sendo processado ou em que um resumo do vídeo precisa ser gerado automaticamente, o que aumenta muito a eficiência.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...