Rompendo os silos de informações: a Dify adiciona a pesquisa conectada ao assistente de IA DeepSeek localizado

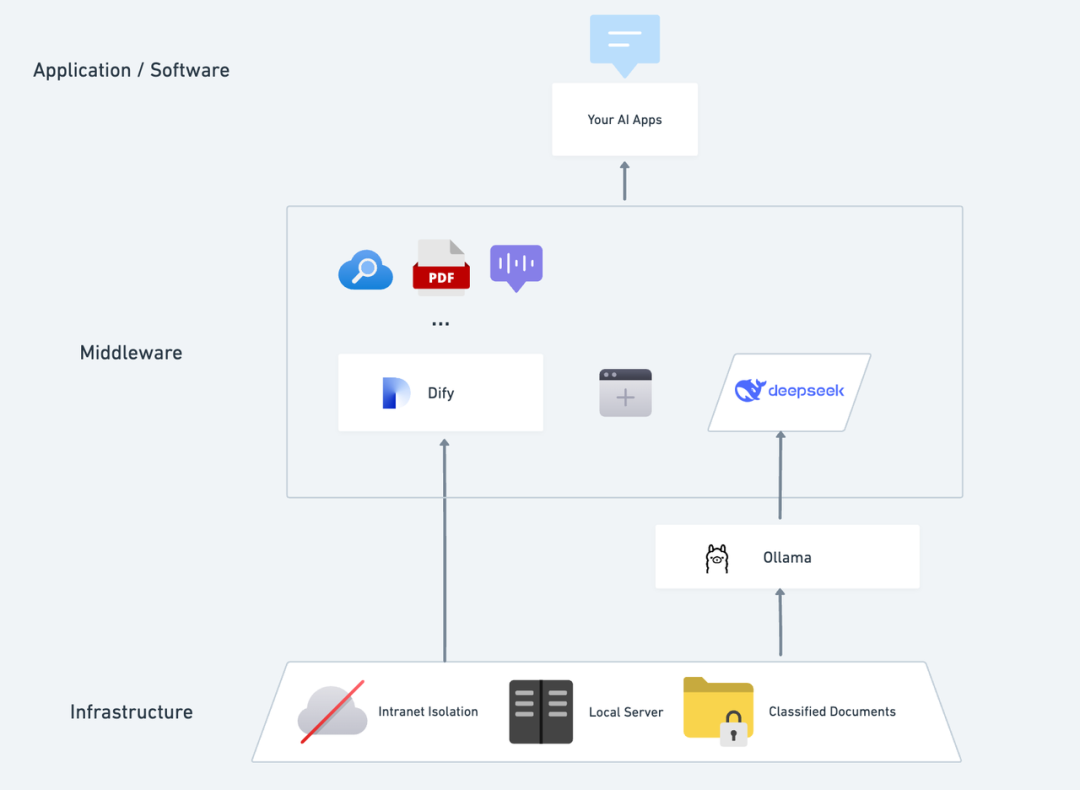

Imagine como seria ter um aplicativo privado de IA que fosse autônomo, confidencial e capaz de analisar textos locais, fornecer conversas precisas a qualquer momento e ter a capacidade de pesquisar na Internet. Neste artigo, vamos orientá-lo passo a passo no processo de criação de um aplicativo. DeepSeek + Ollama + Dify O AI Assistant é um assistente de IA privatizado e com todos os recursos que pode ser implementado rapidamente.

DeepSeek É um modelo inovador de linguagem grande de código aberto, sua arquitetura algorítmica avançada e a capacidade de "cadeia reflexiva", de modo que a interação de diálogo de IA se torna mais inteligente e natural. Com a implementação privada, você pode controlar totalmente a segurança dos seus dados e ajustar com flexibilidade o plano de implementação de acordo com suas necessidades, criando seu próprio "Sistema operacional de IA" .

Dify Como a mesma plataforma de desenvolvimento de aplicativos de IA de código aberto, ela também oferece uma solução completa de implementação privada e suporte avançado a ferramentas de terceiros. Inclui pesquisa de rede, funções de análise de documentos, etc. A Dify oferece suporte a mais de 1.000 modelos de código aberto ou fechado de todo o mundo). Ao mesmo tempo, a Dify oferece suporte a mais de 1.000 modelos de código aberto ou fechado em todo o mundo, de modo que você pode chamar qualquer modelo para capacitar seus aplicativos de IA.

A integração perfeita do DeepSeek à plataforma Dify não apenas garante a privacidade dos dados, mas também facilita para os desenvolvedores começarem a criar aplicativos avançados de IA em servidores locais, permitindo que empresas ou equipes realmente percebam o poder do DeepSeek. "Autonomia de dados" e "personalização flexível" . Se você tiver implementado entreImplementação privada do DeepSeek + Dify: criação de um sistema de assistente de IA local seguro e controlável você pode ir diretamente para a seção de pesquisa de rede.

Dify X DeepSeek Vantagens da implantação privada:

- Ligue para mais de 1.000 recursos de modelo: A Dify é uma plataforma neutra em relação a modelos que faz uso total do poder de raciocínio de diferentes modelos grandes (PS: pode ser chamada usando várias plataformas terceiras de MaaS compatíveis com a Dify) DeepSeek R1 para resolver o problema de chamadas de API oficiais instáveis, consulte o final do método de configuração detalhado)

- Excelente desempenho: Uma experiência de diálogo comparável a um modelo de negócios que lida facilmente com uma variedade de cenários complexos.

- Isolamento ambiental: Funciona totalmente off-line, eliminando qualquer risco de vazamento de dados.

- Os dados podem ser controlados: O que você quiser, você tem controle total dos dados e ele atende aos requisitos de conformidade do setor.

pré-posicionamentoAdquira um servidor (VPS ou VDS) que atenda às seguintes condições:Ambiente de hardware:

pré-posicionamentoAdquira um servidor (VPS ou VDS) que atenda às seguintes condições:Ambiente de hardware:

- CPU >= 2 núcleos

- Memória de vídeo/RAM ≥ 16 GiB (recomendado)

Ambiente de software:

- Docker

- Docker Compose

- Ollama

- Dify Community Edition

Iniciando a implantação 1. instalar o Ollama

Assim como os telefones celulares geralmente têm uma loja de aplicativos para ajudá-lo a encontrar e baixar aplicativos rapidamente, os modelos de IA têm sua própria "loja de aplicativos" dedicada.

O Ollama é um cliente de gerenciamento de modelos grandes de código aberto e multiplataforma (macOS, Windows, Linux) projetado para implantar perfeitamente modelos de linguagem grandes (LLMs), como DeepSeek, Llama, Mistral e outros.

Modelos grandes podem ser instalados e implementados com um único comando, e todos os dados de uso do LLM são armazenados localmente na máquina, proporcionando total privacidade e segurança dos dados para atender aos requisitos de conformidade.

Visite o site do Ollama (https://ollama.com/) e siga as instruções da página da Web para fazer o download e instalar o cliente Ollama. Após a conclusão da instalação, execute ollama -v no terminal para obter o número da versão.

~ ollama -v

ollama version is 0.5.5

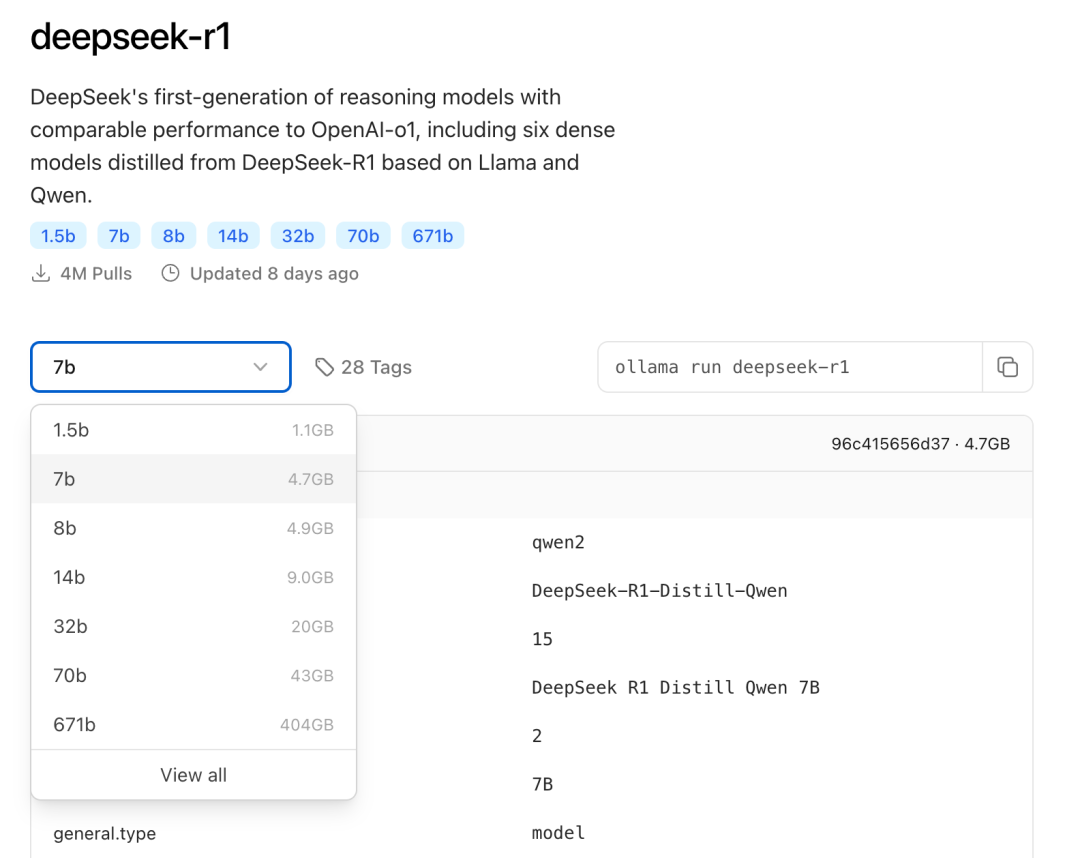

Selecione o modelo de tamanho apropriado do DeepSeek para a implementação com base na configuração real do ambiente. O modelo de tamanho 7B é recomendado para a instalação inicial.

O sufixo B indica os parâmetros de treinamento do modelo. Teoricamente, quanto mais alto for o parâmetro, melhor será o desempenho do modelo e maior será a memória gráfica necessária.

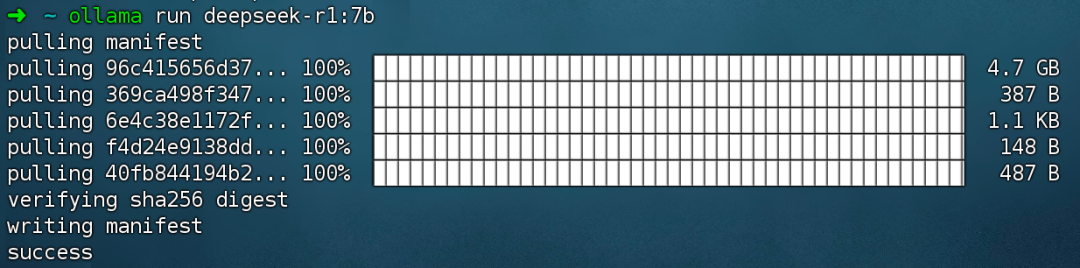

Executar comando ollama run deepseek-r1:7b Instale o modelo DeepSeek R1.

2 Instale a Dify Community Edition

Assim como uma casa precisa de encanamento e eletricidade, ela também precisa de uma cozinha em pleno funcionamento para que o chef possa produzir alimentos deliciosos, e é aí que entra a Dify. Como um projeto popular de código aberto do GitHub, a Dify tem uma cadeia de ferramentas integrada que abrange tudo o que é necessário para criar um aplicativo de IA. Com os poderosos recursos de modelagem do DeepSeek, qualquer pessoa pode criar rapidamente seu aplicativo de IA ideal sem a necessidade de conhecimento complexo de código.

Visite o endereço do projeto Dify no GitHub e execute os seguintes comandos para concluir o repositório de código de extração e o processo de instalação.

git clone https://github.com/langgenius/dify.git

cd dify/docker

cp .env.example .env

docker compose up -d # 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

Depois de executar o comando, o terminal exibirá automaticamente o status e o mapeamento de portas de todos os contêineres. Se houver interrupções ou erros, certifique-se de que o Docker e o Docker Compose estejam instalados. Para obter mais detalhes, consulte o seguinte.

Implante o Dify Community Edition:

https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

O Dify Community Edition usa a porta 80 por padrão, e sua plataforma Dify privatizada pode ser acessada por meio de um link para http://your_server_ip.

Para alternar as portas de acesso, consulte este documento: https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/faq#id-5.-ru-he-xiu-gai-ye-mian-duan-kou

3. conectando o DeepSeek à Dify

Depois de implantar o modelo DeepSeek com a Dify Community Edition, clique no link http://your_server_ip para entrar na plataforma Dify e, em seguida, clique no canto superior direito Avatar → Configurações → Fornecedor de modelos Selecione Ollama e toque em Add Model (Adicionar modelo).

Selecione o tipo de modelo LLM.

- Nome do modelo, preencha o nome do modelo implantado. O modelo implantado acima é o deepseek-r1 7b, portanto, preencha: deepseek-r1:7b.

- Base URL, preencha o endereço em que o cliente Ollama está sendo executado, geralmente http://your_server_ip:11434. Em caso de problemas de conexão, leia as perguntas frequentes no final deste artigo.

- Todas as outras opções são deixadas em seus valores padrão. De acordo com a descrição do modelo DeepSeek, o comprimento máximo gerado é de 32.768 tokens.

Comece a criar aplicativos de IA

As seções a seguir mostram como criar diferentes tipos de aplicativos de IA:

- Aplicativo de diálogo simples

- Aplicativos de diálogo simples com recursos de análise de documentos

- Aplicativos programáveis com pesquisa em rede

DeepSeek AI Chatbot (aplicativo simples)

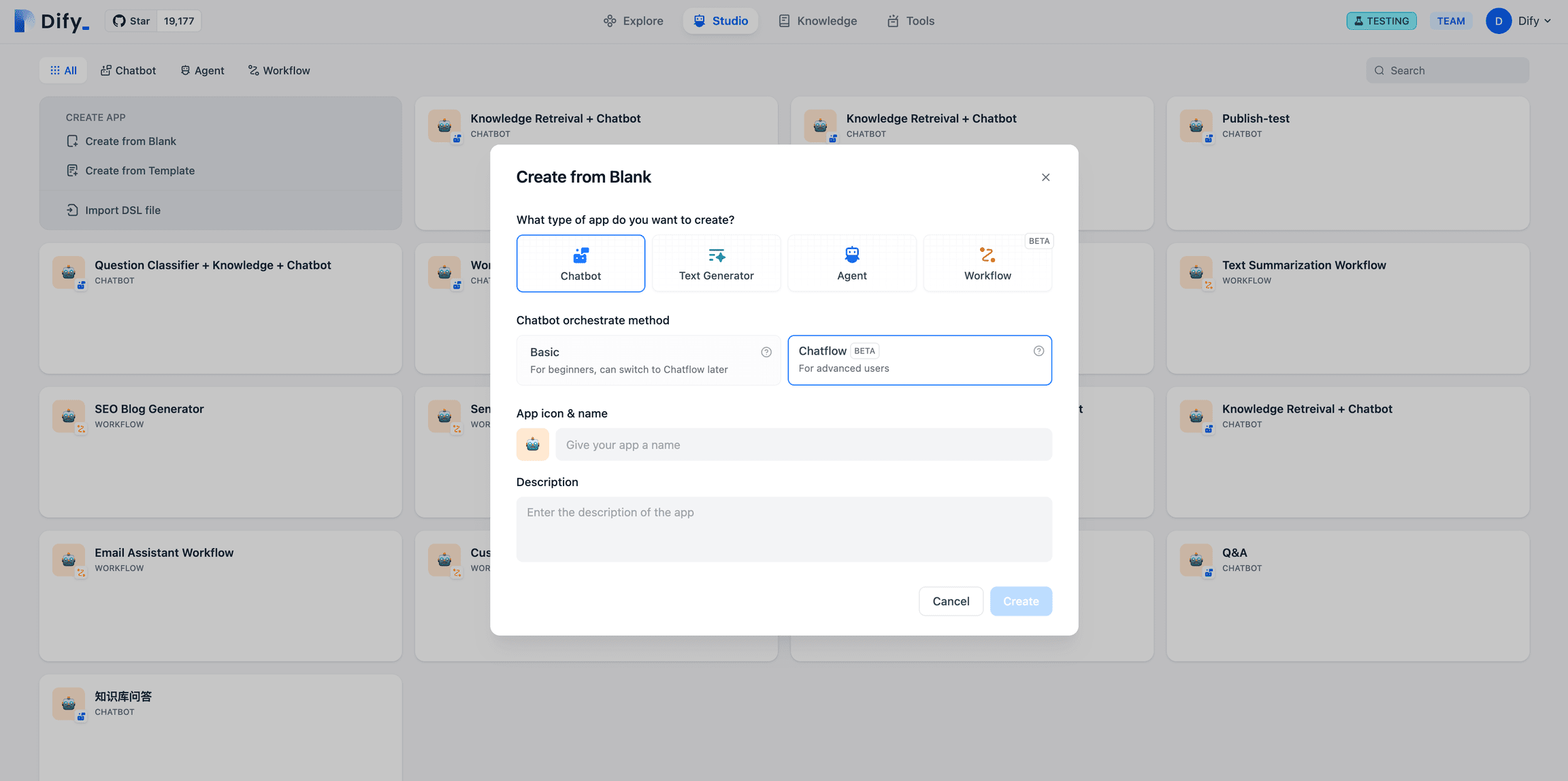

- Toque em "Create a Blank App" (Criar um aplicativo em branco) no lado esquerdo da página inicial da plataforma Dify, selecione o tipo de aplicativo "Chat Assistant" (Assistente de bate-papo) e dê um nome simples a ele.

- No canto superior direito, em Application Type (Tipo de aplicativo), selecione a estrutura Ollama na lista

deepseek-r1:7bModelos.

- Verifique se o aplicativo de IA funciona inserindo conteúdo na caixa de diálogo de visualização. A geração de uma resposta significa que a compilação do aplicativo de IA está concluída.

- Toque no botão Publicar no canto superior direito do aplicativo para obter um link para o aplicativo de IA e compartilhá-lo com outras pessoas ou incorporá-lo em outro site.

DeepSeek AI Chatbot + Base de conhecimento

Um desafio importante para a modelagem de linguagem em larga escala (LLM) é que os dados de treinamento não são atualizados em tempo real e a quantidade de dados pode ser insuficiente, o que pode fazer com que o modelo gere respostas "fantasmas".

Para resolver esse problema, surgiu a tecnologia Retrieval Augmented Generation (RAG). Ao recuperar o conhecimento relevante e fornecer ao modelo as informações contextuais necessárias, essas informações são incorporadas ao processo de geração de conteúdo, aumentando assim a precisão e o profissionalismo da resposta.

Na prática, quando você carrega documentos internos ou informações profissionais, a função de base de conhecimento da Dify pode assumir o papel de RAG para ajudar o LLM a fornecer respostas mais direcionadas com base em informações especializadas, compensando efetivamente a falta de dados de treinamento do modelo.

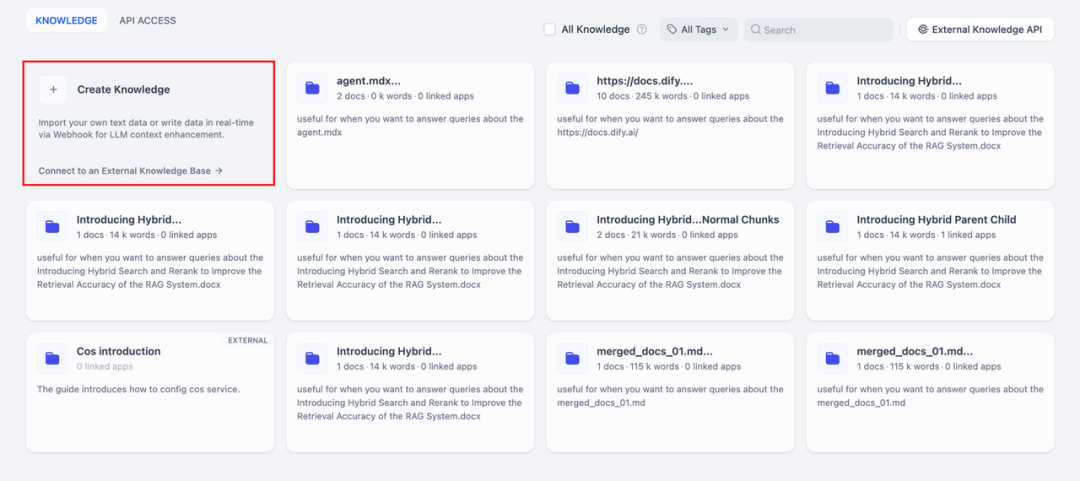

1. criação de uma base de conhecimento

Faça upload de documentos para a Base de Conhecimento que precisam ser analisados pela IA. Para garantir que o modelo DeepSeek compreenda com precisão o conteúdo do documento, recomenda-se que o texto seja processado usando um modelo de "segmentação pai-filho" - esse modelo preserva melhor a estrutura hierárquica e o contexto do documento.

Para obter etapas detalhadas de configuração, consulte este documento:

https://docs.dify.ai/zh-hans/guides/knowledge-base/create-knowledge-and-upload-documents

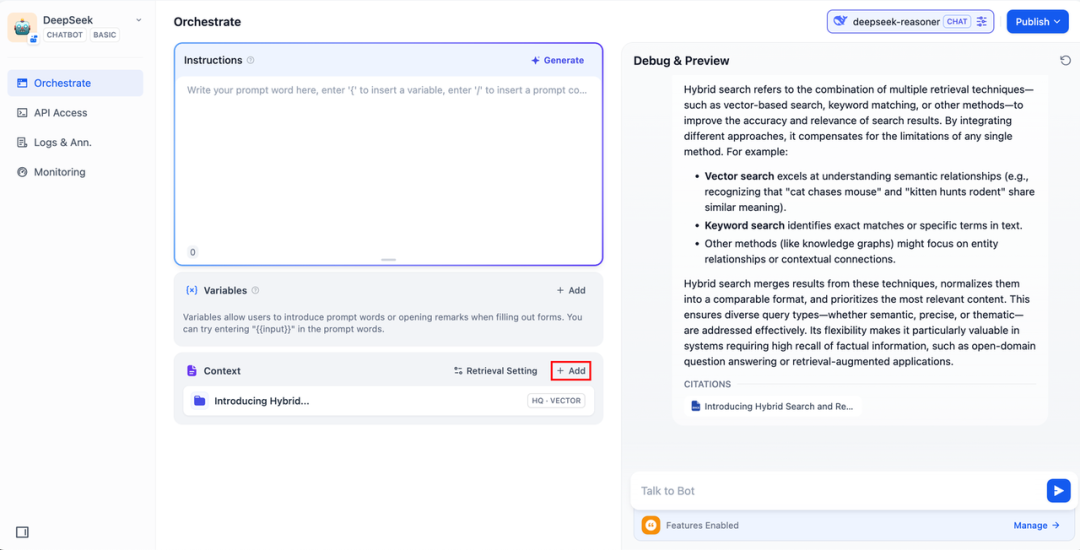

2. integração da base de conhecimento em aplicativos de IA

Adicione uma base de conhecimento ao "contexto" do aplicativo de IA e insira a pergunta relevante na caixa de diálogo. O lLM primeiro extrairá da base de conhecimento o contexto relevante para a pergunta e, em seguida, o resumirá e fornecerá uma resposta de melhor qualidade.

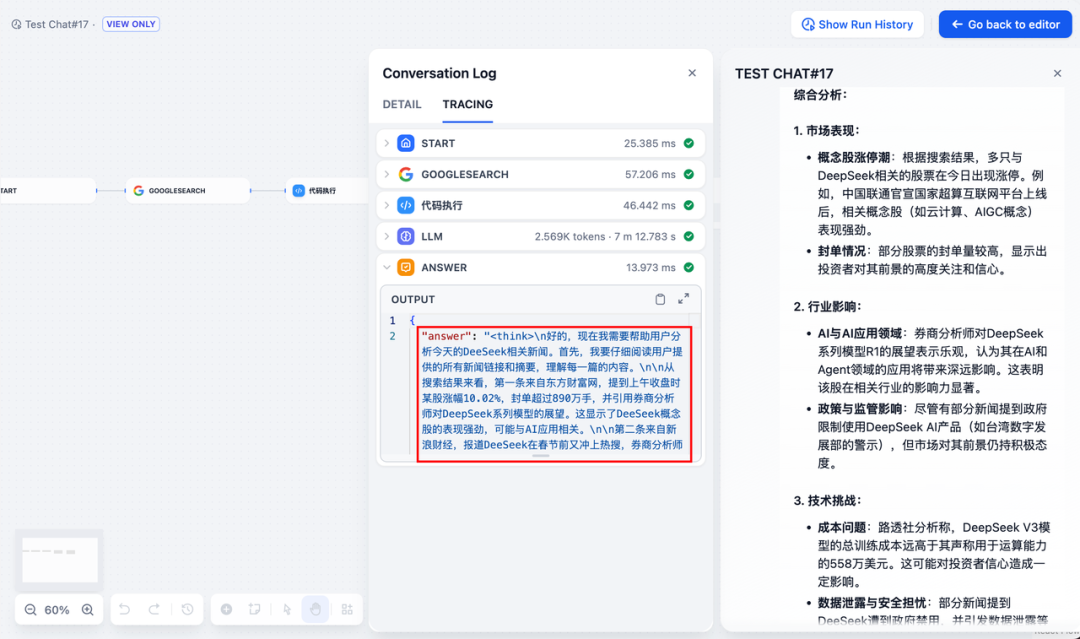

DeepSeek AI Chatflow / Workflow (pesquisa em rede)

Chatflow / Fluxo de trabalho Os aplicativos podem ajudá-lo a orquestrar e criar aplicativos de IA com funcionalidades mais complexas, como dar ao DeepSeek a capacidade de realizar pesquisa em rede, reconhecimento de arquivos, reconhecimento de fala e muito mais. Por questões de espaço, as seções a seguir mostram como dar ao DeepSeek Habilitar recursos de pesquisa em rede .

Para usar o aplicativo diretamente, você pode fazer o download do arquivo DSL clicando no link abaixo e importá-lo para a plataforma Dify.

Endereço de download do arquivo DSL do aplicativo:

https://assets-docs.dify.ai/2025/02/41a3564694dd3f2803ad06a29f5b3fef.yml

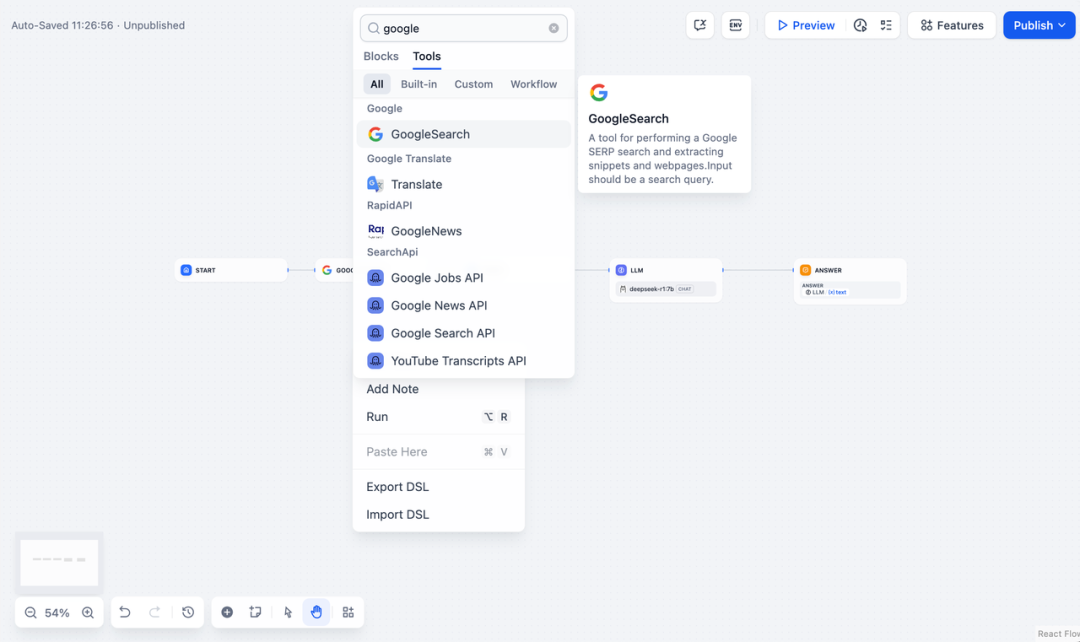

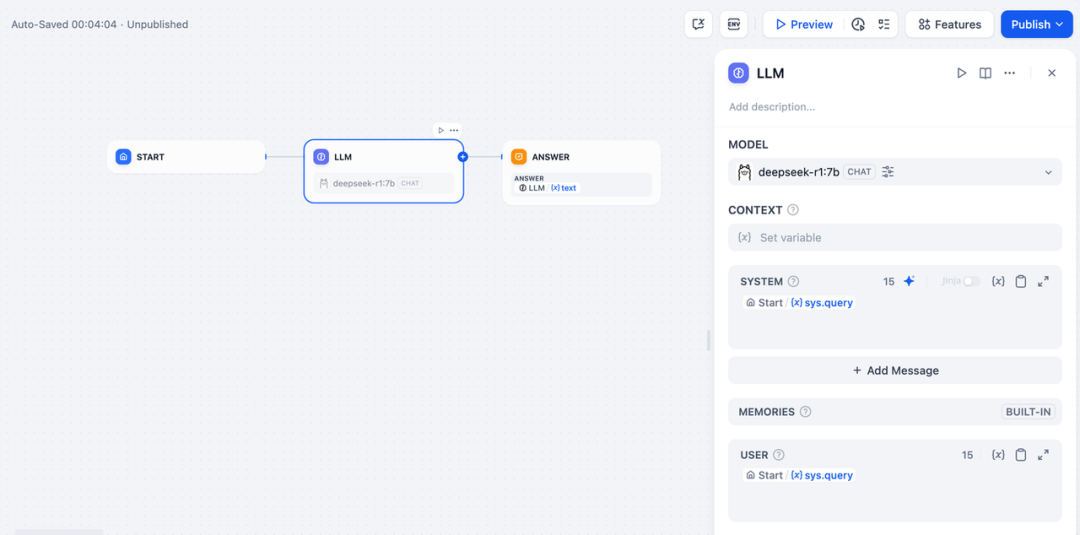

- Toque em "Create a Blank App" (Criar um aplicativo em branco) no lado esquerdo da página inicial da plataforma Dify, selecione um aplicativo do tipo "Chatflow" ou "Workflow" e simplesmente dê um nome a ele.

2. adicionarPesquisa na Internetpreencha a chave de API para ativar a funcionalidade do nó. Preencha o campo Query (Consulta) com a chave de API fornecida pelo nó inicial. {{#sys.query#}} Variáveis.

Visite o site a seguir para obter uma chave de API:

https://serpapi.com/users/sign_in

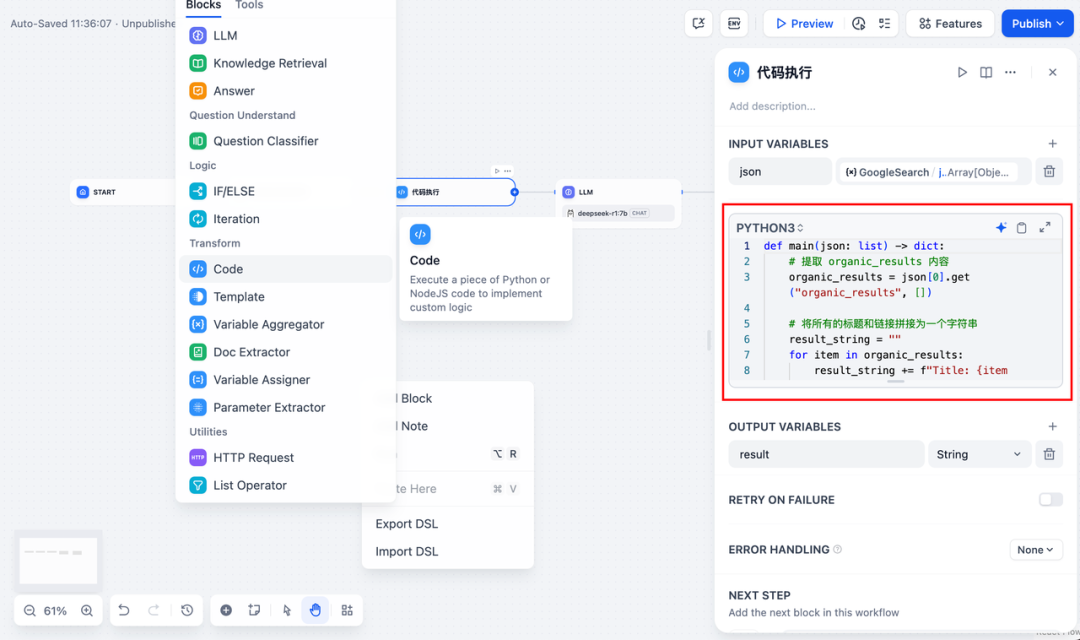

3. adicionarexecução de códigonó. Como a saída da ferramenta de pesquisa é uma parte do código JSON, você precisa adicionar um nó de execução de código para extrair o conteúdo necessário. Preencha a variável de entrada com a variável de saída JSON da ferramenta de pesquisa e preencha o nó de execução de código com o seguinte código:

def main(json: list) -> dict:

# 提取 organic_results 内容

organic_results = json[0].get("organic_results", [])

# 将所有的标题和链接拼接为一个字符串

result_string = ""

for item in organic_results:

result_string += (

f"Title: {item['title']}\n"

f"Link: {item['link']}\n"

f"Snippet: {item['snippet']}\n\n"

)

# 返回拼接后的字符串作为 result

return {

"result": result_string,

}

- Para adicionar um nó LLM, selecione a estrutura Ollama na seção

deepseek-r1:7be adicione a palavra de prompt do sistema no modelo{{#sys.query#}}para processar comandos do nó inicial que são inseridos pelo usuário.

No caso de anomalias de API, elas podem ser tratadas de forma flexível pela função de balanceamento de carga ou pelo nó de tratamento de exceções.

balanceamento de cargaAs solicitações de API podem ser distribuídas entre vários endpoints de API, conforme descrito em detalhes em https://docs.dify.ai/zh-hans/guides/model-configuration/load-balancing

Mecanismo de tratamento de exceçõesCapacidade de lançar mensagens de falha em caso de erros de nó sem interromper o processo principal. Para obter uma descrição detalhada, consulte: https://docs.dify.ai/zh-hans/guides/workflow/error-handling

- Adicione o nó final, faça referência às variáveis de saída do nó LLM e conclua a configuração. Você pode inserir conteúdo na caixa de visualização para teste. A geração de uma resposta significa que a criação do aplicativo de IA está concluída e você pode visualizar o processo de raciocínio do LLM no registro.

problemas comuns

1. erros de conexão durante a implantação do Docker

Os seguintes erros podem ser encontrados ao implantar o Dify e o Ollama com o Docker:

HTTPConnectionPool(host=127.0.0.1, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

HTTPConnectionPool(host=localhost, port=11434): Max retries exceeded with URL: /cpi/chat

(Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

Failed to establish a new connection: [Errno 111] Connection refused'))

Causa do erro: Esse erro ocorre porque o serviço Ollama não está acessível no contêiner do Docker. localhost geralmente aponta para o próprio contêiner, não para o host ou outro contêiner. Para resolver esse problema, você precisa expor o serviço Ollama à rede.

Método de configuração do ambiente do macOS:

Se o Ollama estiver sendo executado como um aplicativo do macOS, você precisará definir as variáveis de ambiente usando o launchctl:

- Defina as variáveis de ambiente chamando launchctl setenv:

launchctl setenv OLLAMA_HOST "0.0.0.0" - Reinicie o aplicativo Ollama.

- Se as etapas acima não funcionarem, você pode usar o seguinte método: o problema é que, dentro da janela de encaixe, você deve se conectar ao host.docker.internal para acessar o host da janela de encaixe, portanto, substituir o localhost pelo serviço host.docker.internal funcionará: http://host. docker.internal:11434

Método de configuração do ambiente Linux: Se o Ollama estiver sendo executado como um serviço systemd, você deverá usar o comando s ystemctl Configuração de variáveis de ambiente:

- Isso é feito chamando o

systemctl edit ollama.serviceEdite o serviço systemd. Isso abrirá um editor. - Para cada variável de ambiente, a variável

[Service]Adicione uma linha abaixo da seçãoEnvironment::[Service] Environment="OLLAMA_HOST=0.0.0.0" - Salvar e sair.

- Recarregue o systemd e reinicie o Ollama:

systemctl daemon-reload systemctl restart ollama

Método de configuração do ambiente do Windows:

No Windows, o Ollama herda as variáveis de ambiente do usuário e do sistema.

- Em primeiro lugar, clique em Ollama na barra de tarefas para sair do programa.

- Edite as variáveis de ambiente do sistema no painel de controle

- Edite ou crie novas variáveis para sua conta de usuário, como

OLLAMA_HOSTeOLLAMA_MODELSetc. - Clique em OK / Aplicar Salvar

- Executar em uma nova janela de terminal

ollama

2) Como posso alterar o endereço do serviço Ollama e o número da porta?

Encadernação padrão Ollama 127.0.0.1 porta 11434, que pode ser acessada por meio do OLLAMA_HOST As variáveis de ambiente alteram o endereço de vinculação.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...