Curso gratuito sobre como funcionam os Transformer LLMs, ministrado por Enda Wu

Como funcionam os LLMs de transformadores?

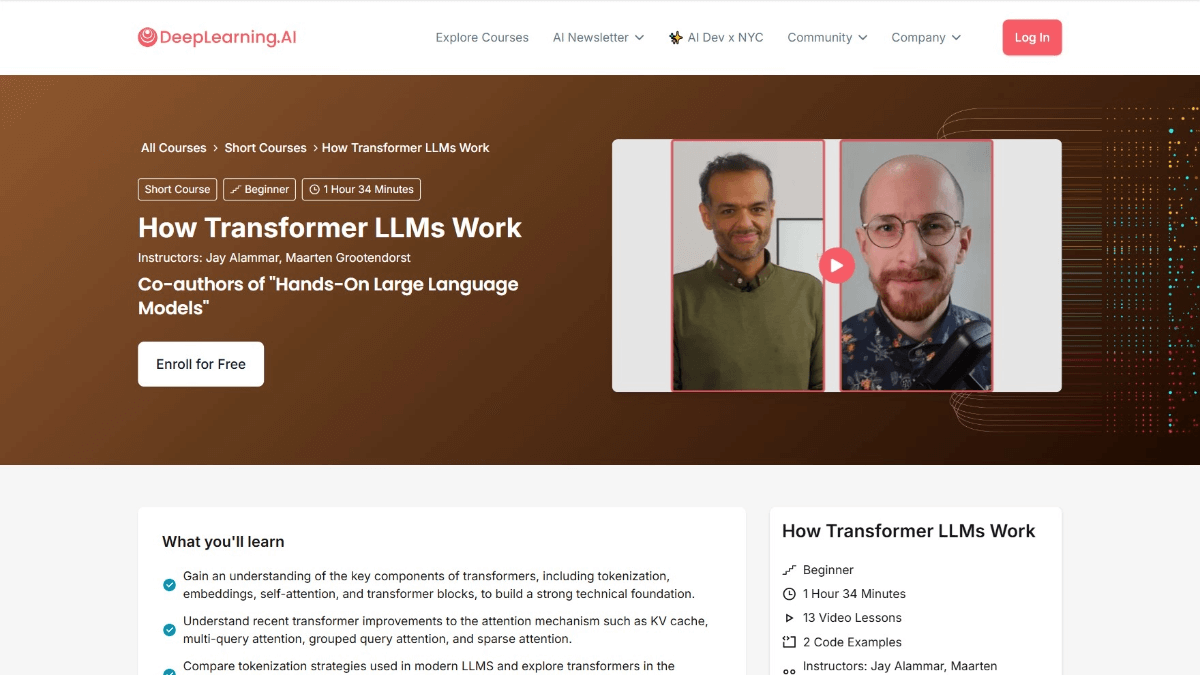

Transformador How LLMs Work é um curso da DeepLearning.AI em colaboração com Jay Alammar e Maarten Grootendorst, autores de Hands-On Large Language Models. O curso oferece uma visão aprofundada da arquitetura do Transformer que oferece suporte a modelos de linguagem grande (LLMs). O curso começa com a evolução da representação numérica das linguagens e aborda tópicos como desambiguação, o mecanismo de atenção e a camada de alimentação dos blocos do Transformer e como melhorar o desempenho armazenando em cache os cálculos. Depois de concluir o curso, os usuários terão uma compreensão aprofundada de como os LLMs processam as linguagens, poderão ler e entender documentos relevantes e melhorar sua capacidade de criar aplicativos LLM.

Objetivos do curso Como funcionam os LLMs de transformadores

- Entendendo a evolução da representação numérica da linguagemEntenda como a linguagem é representada digitalmente, desde modelos simples de saco de palavras até arquiteturas complexas de transformadores.

- Dominar o processamento de particípiosAprendizagem: aprender a decompor o texto de entrada em "tokens" e entender como os tokens são inseridos no modelo de linguagem.

- Mergulhando na arquitetura do transformadorAs três fases principais da arquitetura do Transformer são exploradas em detalhes: desambiguação e incorporação, empilhamento de blocos do Transformer e cabeçalhos do modelo de linguagem.

- Compreensão dos detalhes do bloco TransformerMecanismos de atenção e camadas de alimentação: inclui mecanismos de atenção e camadas de alimentação e como elas trabalham juntas para processar e gerar texto.

- Otimização do desempenho do aprendizadoSaiba como melhorar o desempenho do Transformer por meio de técnicas como a computação em cache.

- Exploração de aplicativos práticosHugging Face Transformer: explorando implementações recentes de modelos para aplicações práticas aprimoradas por meio da biblioteca Hugging Face Transformer.

Esboço do curso sobre como funcionam os LLMs de transformadores

- Visão geral dos LLMs de transformadoresIntrodução aos objetivos do curso, à estrutura e à importância da arquitetura do Transformer no contexto dos LLMs (Large Language Models) modernos.

- Evolução da representação linguísticaAnálise da evolução da modelagem de linguagem, do Bag-of-Words ao Word2Vec e à arquitetura Transformer.

- particípio e incorporaçãoAprenda como o texto de entrada é decomposto em tokens e como converter tokens em vetores de incorporação, incluindo a aplicação de codificação posicional.

- Bloco do transformadorEstrutura do bloco Transformer: Entenda a estrutura do bloco Transformer, incluindo o mecanismo de autoatenção e a função das redes de feed-forward.

- Atenção prolongadaDescrição: Explore como os mecanismos de atenção com várias cabeças podem melhorar o desempenho do modelo, capturando diferentes aspectos da entrada por meio de várias "cabeças".

- Empilhamento de blocos de transformadoresAprenda a criar modelos profundos empilhando vários blocos do Transformer e a função da vinculação residual e da normalização de camadas.

- Cabeçalho do modelo de idiomaEntenda como o Transformer implementa a geração de texto gerando a distribuição de probabilidade do próximo token a partir do cabeçalho do modelo de linguagem.

- mecanismo de cacheAprenda a melhorar a velocidade de inferência dos modelos do Transformer por meio de mecanismos de armazenamento em cache e aplicações práticas de armazenamento em cache.

- Últimas inovações arquitetônicasIntrodução: Apresenta as mais recentes inovações em Mixture-of-Experts (MoE) e outras arquiteturas de Transformer.

- Implementação do transformador com Hugging FaceAprenda a carregar e ajustar modelos de transformadores pré-treinados com a biblioteca Hugging Face Transformers.

- Codificação prática do TransformerAprenda a implementar os principais componentes do Transformer e a criar modelos simples do Transformer por meio de exercícios práticos de codificação.

- Trabalho de pesquisa sobre leitura e compreensãoAprenda a ler e entender artigos de pesquisa relacionados a transformadores, analisando artigos recentes e suas contribuições para a área.

- Criação de aplicativos LLMExplore como desenvolver aplicativos baseados em LLM e discuta as direções futuras e os possíveis aplicativos da arquitetura Transformer.

Endereço do curso para saber como funcionam os LLMs de transformadores

- Endereço do curso::DeepLearning.AI

Para quem trabalham os Transformer LLMs

- pesquisador de processamento de linguagem natural (NLP)Estudo aprofundado da arquitetura do Transformer, explorando aplicativos de ponta nas áreas de compreensão, geração e tradução de idiomas e promovendo o desenvolvimento da tecnologia de processamento de linguagem natural.

- Engenheiro de aprendizado de máquinaAprenda o funcionamento do Transformer para poder otimizar o desempenho do modelo, melhorar a precisão e a eficiência do modelo e desenvolver aplicativos de modelos de linguagem mais avançados.

- cientista de dadosProcessamento e análise de dados de texto em grande escala com a arquitetura Transformer, extraindo padrões e informações dos dados para apoiar a tomada de decisões.

- desenvolvedor de softwareIntegração de Transformer LLMs em vários aplicativos de software, como chatbots, sistemas de recomendação de conteúdo, etc., para aprimorar a inteligência do produto.

- Entusiastas da Inteligência ArtificialInteressado na arquitetura do Transformer e quer aprender como ela funciona, obter uma compreensão mais profunda da tecnologia de IA e expandir seus horizontes técnicos.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...