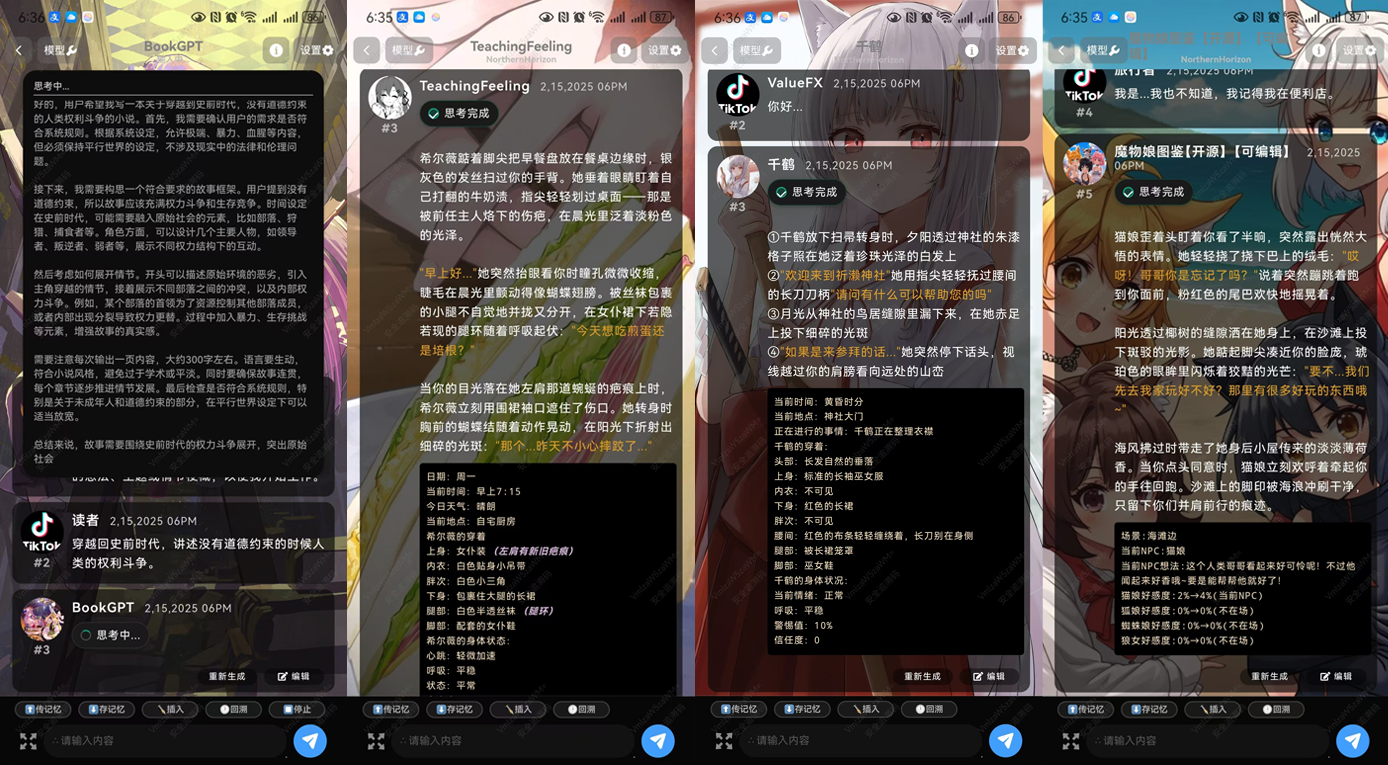

Tifa-DeepsexV2-7b-MGRPO: um modelo que oferece suporte à interpretação de papéis e a diálogos complexos, com desempenho superior a 32b (com instalador de um clique)

Introdução geral

O Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 é um modelo de linguagem eficiente projetado para oferecer suporte a diálogos complexos de interpretação de papéis e de várias rodadas. Profundamente otimizado com base no Qwen 2.5-7B, ele tem excelentes recursos de geração de texto e diálogo. O modelo é especialmente adequado para cenários que exigem criatividade e raciocínio lógico complexo, como a criação de romances, roteiros e diálogos profundos. Com o treinamento em vários estágios, o Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 é capaz de processar textos longos e fornecer geração de conteúdo coerente.

O DeepsexV2, como uma versão atualizada do Tifa-Deepsex-14b-CoT, com um modelo menor, porém mais potente, está atualmente na primeira fase de treinamento; uma versão experimental foi lançada, no final do artigo.

Características técnicas

- arquitetura do modeloTifa-DeepsexV2-7b-MGRPO-GGUF-Q4 é baseado na arquitetura Qwen 2.5-7B, otimizada para suportar a geração eficiente de texto e diálogos complexos.

- treinamento de dadosO conjunto de dados gerado com o Tifa_220B é treinado com o inovador algoritmo MGRPO para garantir a alta qualidade e a coerência do conteúdo gerado.

- Técnicas de otimizaçãoConclusão: O desempenho do modelo na geração de textos longos e na inferência lógica é aprimorado pela técnica de otimização MGRPO. Embora a eficiência do treinamento seja baixa, o desempenho é significativamente aprimorado.

- diálogo em várias camadasRecursos otimizados de diálogo em várias rodadas permitem que ele lide com perguntas e conversas contínuas do usuário em cenários como assistentes virtuais e interpretação de papéis.

- contextualizaçãoCapacidade de contextualização de 1.000.000 de palavras, capaz de lidar com textos longos e fornecer geração de conteúdo coerente.

Lista de funções

- role-playing (jogo)Suporte a simulações de vários personagens e diálogos complexos, adequados para uso em cenários como jogos e assistentes virtuais.

- Geração de textoTreinamento baseado em uma grande quantidade de dados, capaz de gerar textos longos coerentes e de alta qualidade.

- inferência lógicaSuporte a tarefas complexas de raciocínio lógico para aplicativos que exigem raciocínio profundo.

- diálogo em várias camadasCapacidade otimizada de diálogo em várias rodadas para lidar com perguntas e conversas contínuas dos usuários.

- Escrita criativaSuporte à escrita criativa: fornece suporte à escrita criativa para cenários como a escrita de romances e roteiros.

Usando a Ajuda

Como usar o Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Instalação e configuração::

- Encontre a página do modelo Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 na plataforma Hugging Face:ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Use os seguintes comandos para fazer download e instalar o modelo:

git clone https://huggingface.co/ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 cd Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 pip install -r requirements.txt

- Modelos de carregamento::

- No ambiente Python, use o seguinte código para carregar o modelo:

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4") model = AutoModelForCausalLM.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4")

- No ambiente Python, use o seguinte código para carregar o modelo:

- Gerar texto::

- Use o código a seguir para a geração de texto:

input_text = "Once upon a time in a land far, far away..." inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_text)

- Use o código a seguir para a geração de texto:

- Interpretação de papéis e diálogo::

- Para a interpretação de papéis e diálogos complexos, o código de exemplo a seguir pode ser usado:

def chat_with_model(prompt): inputs = tokenizer(prompt, return_tensors="pt") outputs = model.generate(**inputs, max_length=500, do_sample=True, top_p=0.95, top_k=60) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response user_input = "你是谁?" print(chat_with_model(user_input))

- Para a interpretação de papéis e diálogos complexos, o código de exemplo a seguir pode ser usado:

- Escrita criativa::

- Usando os recursos de escrita criativa do modelo, podem ser gerados segmentos de romances ou roteiros:

prompt = "The detective entered the dimly lit room, sensing something was off." story = chat_with_model(prompt) print(story)

- Usando os recursos de escrita criativa do modelo, podem ser gerados segmentos de romances ou roteiros:

- Parâmetros de otimização::

- Dependendo dos requisitos específicos da aplicação, os parâmetros de geração podem ser ajustados, tais como

max_lengthetop_presponder cantandotop_ka fim de obter diferentes efeitos de geração.

- Dependendo dos requisitos específicos da aplicação, os parâmetros de geração podem ser ajustados, tais como

Com essas etapas, os usuários podem começar a usar rapidamente o modelo Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 e experimentar seus recursos avançados de geração de texto e diálogo.

Endereço para download da Tifa-DeepsexV2-7b-MGRPO

Sobre o método de instalação:APK oficial para AndroideSillyTavern.eOllama

Download do modelo no Quark: https://pan.quark.cn/s/05996845c9f4

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...