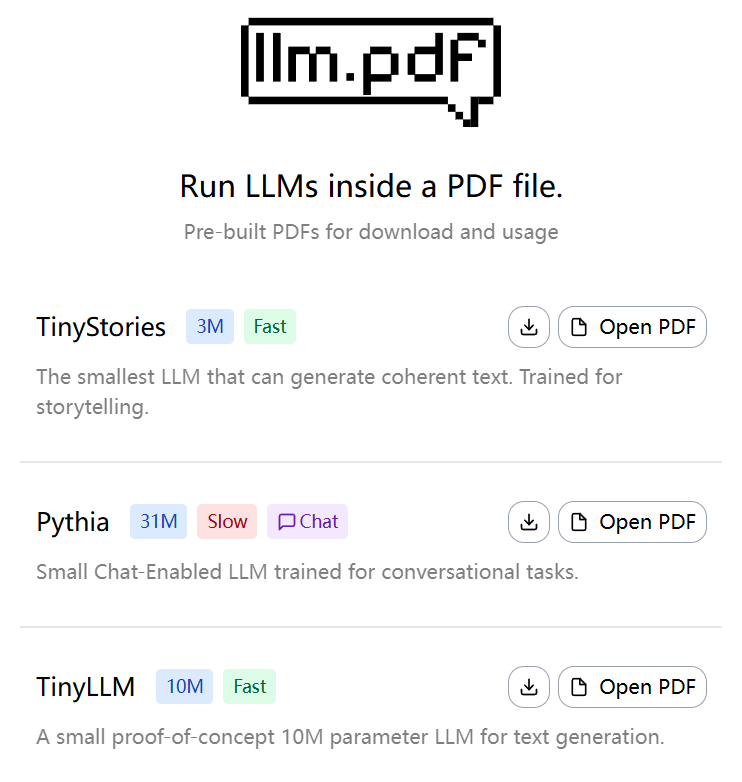

llm.pdf: projeto experimental para executar um modelo de linguagem em grande escala em um arquivo PDF

Introdução geral O llm.pdf é um projeto de código aberto que permite aos usuários executar modelos de linguagem grandes (LLMs) diretamente em arquivos PDF. Desenvolvido por EvanZhouDev e hospedado no GitHub, esse projeto demonstra uma abordagem inovadora: por meio do Em...