StreamingT2V: geração dinâmica e dimensionável de texto para vídeo longo

Introdução geral

O StreamingT2V é um projeto público desenvolvido pela equipe de pesquisa de IA da Picsart, focado na geração de vídeos longos coerentes, dinâmicos e dimensionáveis com base em descrições textuais. Essa tecnologia usa uma abordagem autorregressiva avançada que garante um vídeo temporalmente consistente que corresponde de perto ao texto da descrição e mantém uma imagem de alta qualidade de quadro. Ela é capaz de gerar vídeos de até 1.200 fps e até dois minutos de duração, com a possibilidade de ser dimensionada para períodos de tempo mais longos. A eficácia da técnica não é limitada por um modelo Text2Video específico, ou seja, os aprimoramentos no modelo melhorarão ainda mais a qualidade do vídeo.

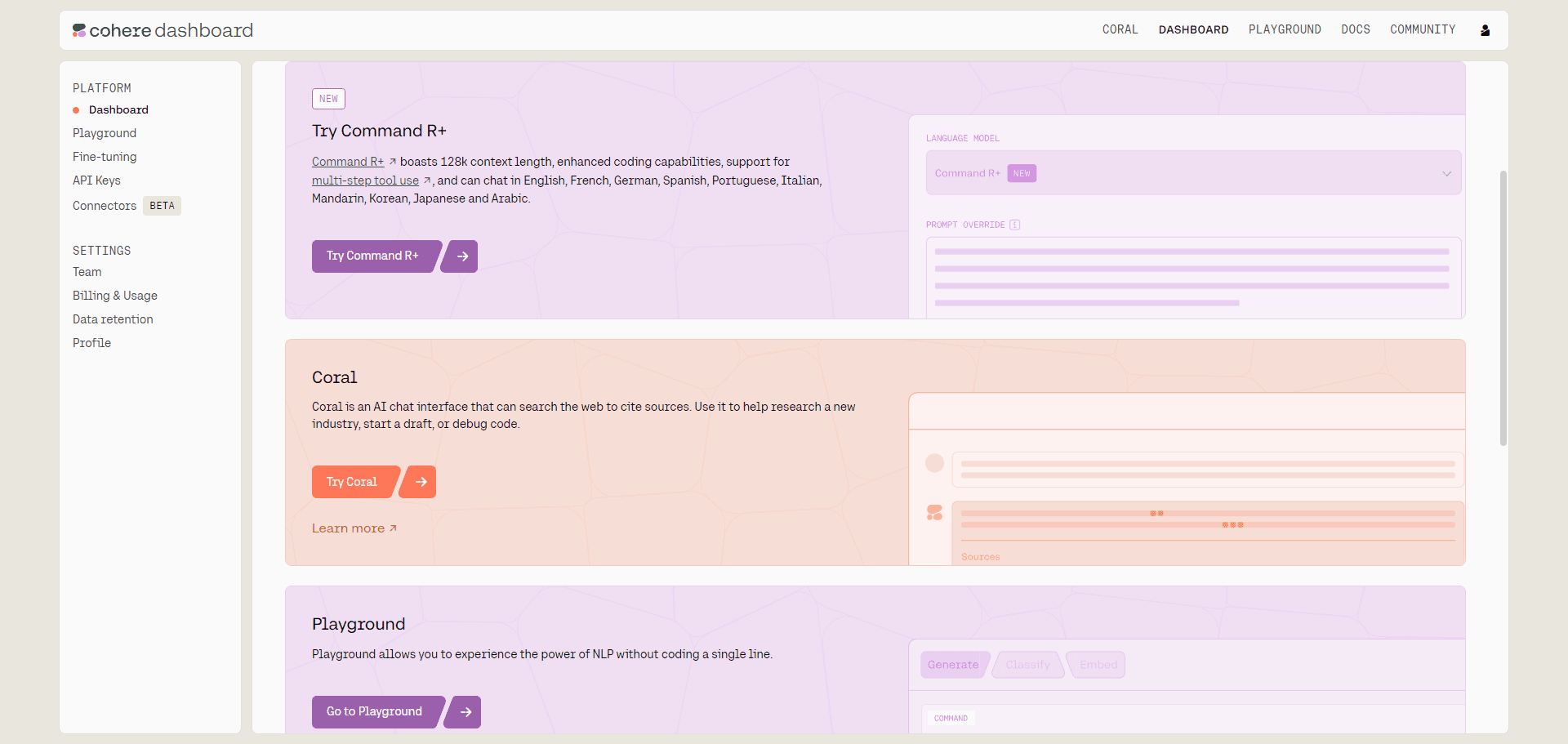

Experiência on-line do StreamingT2V

Lista de funções

Suporta a geração de vídeos de até 1.200 fps e até dois minutos de duração.

Mantém a consistência temporal do vídeo e das imagens com alta qualidade de quadros

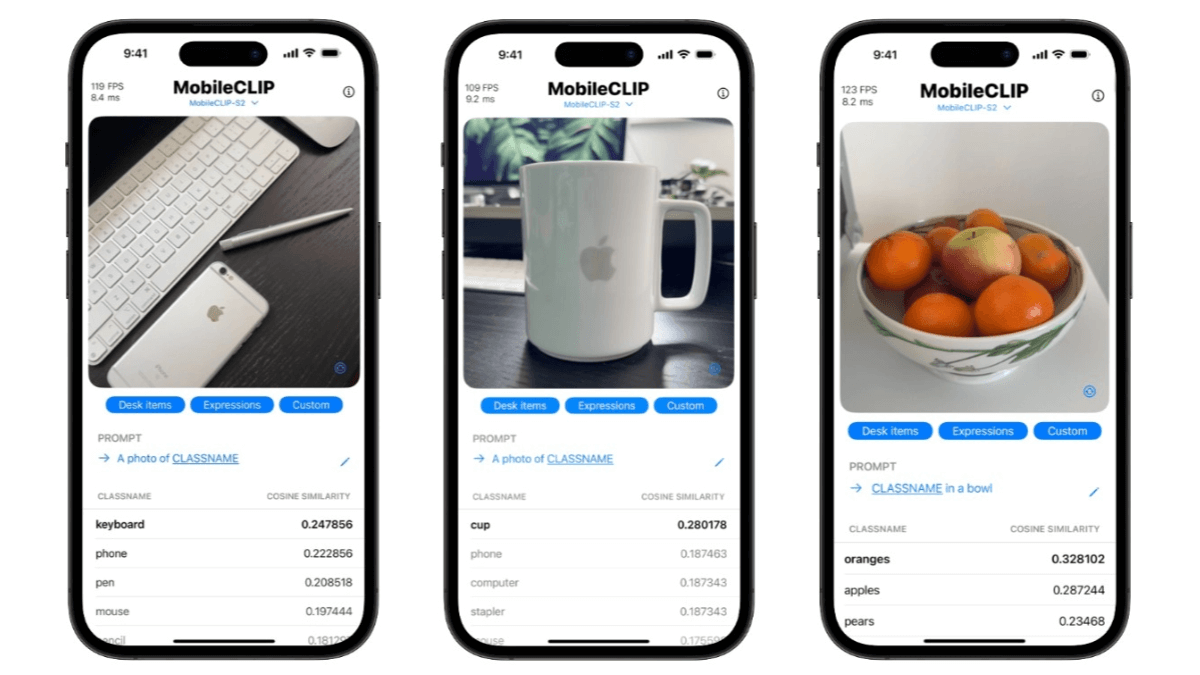

Geração de vídeo dinâmico que corresponde à descrição do texto

Suporte a vários aplicativos de modelo de base para aprimorar a qualidade dos vídeos gerados

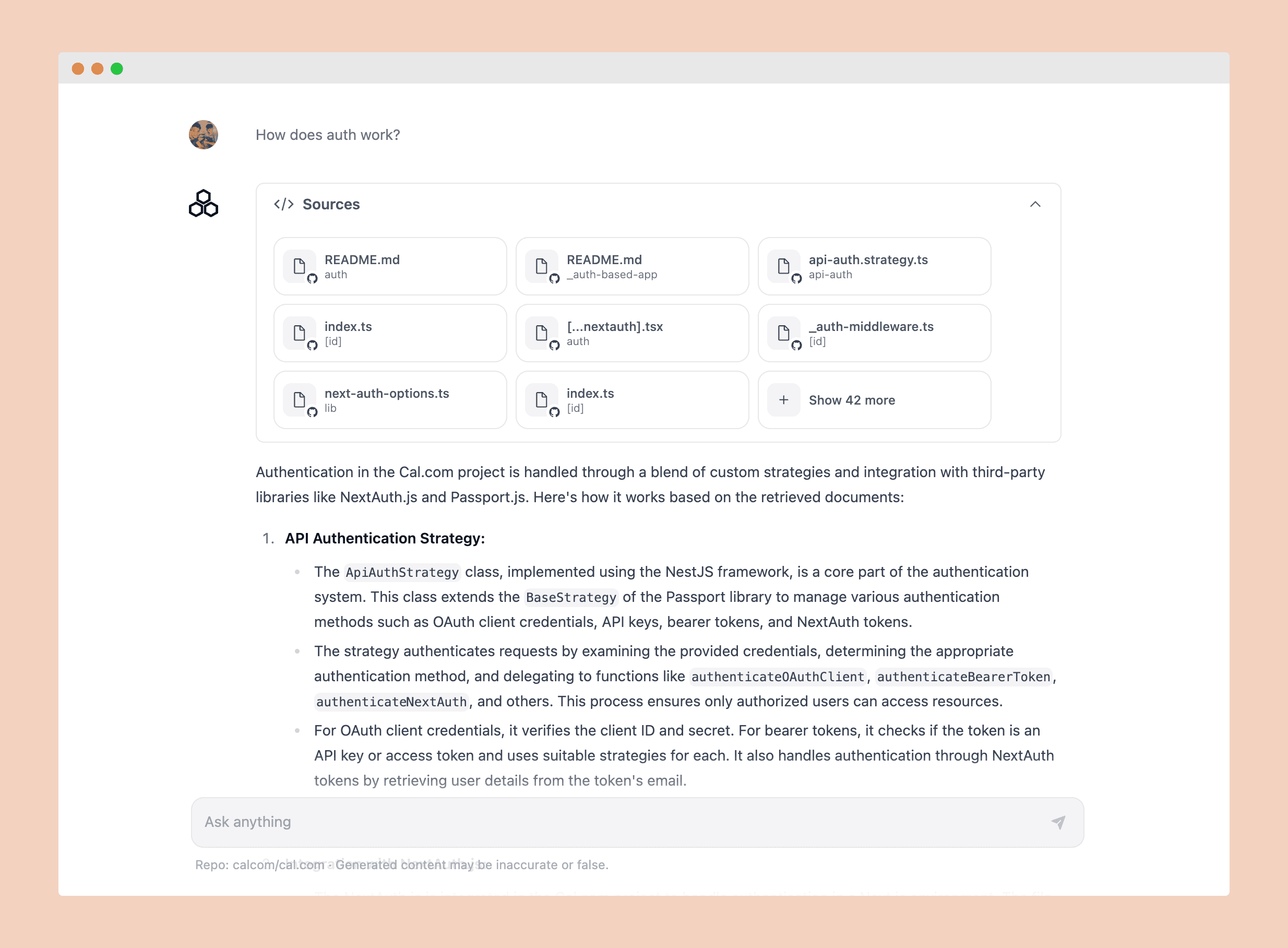

Suporte à conversão de texto para vídeo e de imagem para vídeo

Fornecer demonstração on-line do Gradio

Usando a Ajuda

Clone o repositório do projeto e instale o ambiente necessário

Faça o download dos pesos e coloque-os no catálogo correto

Executar código de amostra para conversão de texto em vídeo ou de imagem em vídeo

Veja a página do projeto para obter resultados detalhados e demonstrações

tempo de inferência

ModelscopeT2V como um modelo básico

| taxa de quadros | Tempo de inferência de visualização mais rápido (256×256) | Tempo de raciocínio para o resultado final (720×720) |

|---|---|---|

| 24 quadros | 40 segundos. | 165 segundos. |

| 56 quadros | 75 segundos | 360 segundos |

| 80 quadros | 110 segundos. | 525 segundos. |

| 240 quadros | 340 segundos. | 1610 segundos (cerca de 27 minutos) |

| 600 quadros | 860 segundos. | 5128 segundos (cerca de 85 minutos) |

| 1200 quadros. | 1710 segundos (cerca de 28 minutos) | 10225 segundos (cerca de 170 minutos) |

AnimateDiffcomo modelo básico

| taxa de quadros | Tempo de inferência de visualização mais rápido (256×256) | Tempo de raciocínio para o resultado final (720×720) |

|---|---|---|

| 24 quadros | 50 segundos. | 180 segundos. |

| 56 quadros | 85 segundos. | 370 segundos. |

| 80 quadros | 120 segundos. | 535 segundos. |

| 240 quadros | 350 segundos. | 1620 segundos (cerca de 27 minutos) |

| 600 quadros | 870 segundos. | 5138 segundos (~85 minutos) |

| 1200 quadros. | 1720 segundos (cerca de 28 minutos) | 10235 segundos (cerca de 170 minutos) |

SVDComo um modelo básico

| taxa de quadros | Tempo de inferência de visualização mais rápido (256×256) | Tempo de raciocínio para o resultado final (720×720) |

|---|---|---|

| 24 quadros | 80 segundos. | 210 segundos. |

| 56 quadros | 115 segundos. | 400 segundos. |

| 80 quadros | 150 segundos. | 565 segundos. |

| 240 quadros | 380 segundos. | 1650 segundos (cerca de 27 minutos) |

| 600 quadros | 900 segundos. | 5168 segundos (~86 minutos) |

| 1200 quadros. | 1750 segundos (aprox. 29 minutos) | 10265 segundos (~171 minutos) |

Todas as medições foram feitas usando a GPU NVIDIA A100 (80 GB). Quando o número de quadros excedeu 80, foi usada a mistura aleatória. Para a mistura aleatória, ochunk_sizee o valor deoverlap_sizesão definidos como 112 e 32, respectivamente.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...