StableAnimator: gera animação de vídeo de alta qualidade que mantém as características do personagem.

Introdução geral

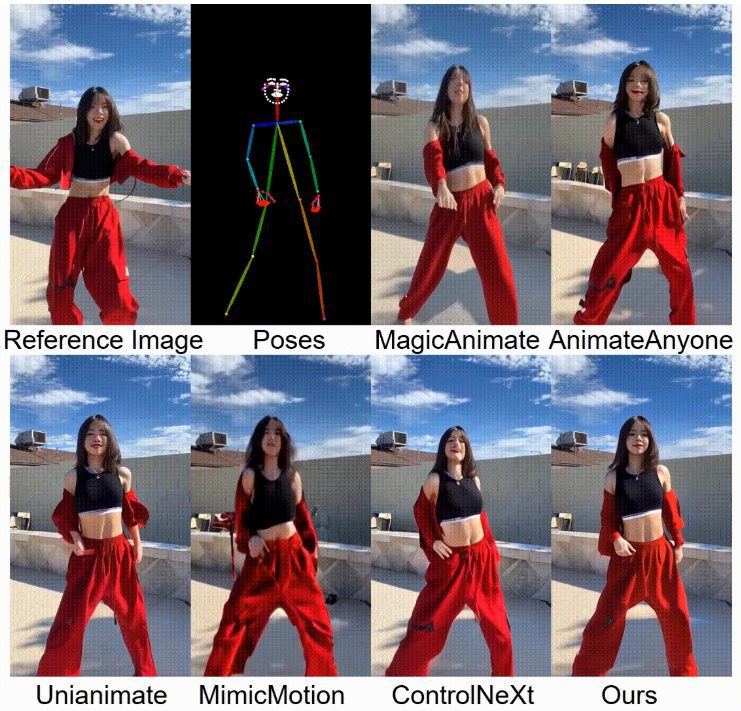

O StableAnimator é uma estrutura inovadora de difusão de vídeo com preservação de identidade de ponta a ponta, capaz de sintetizar vídeos de alta qualidade com base em uma imagem de referência e uma série de poses sem nenhum pós-processamento. Desenvolvido em colaboração com pesquisadores da Fudan University, Microsoft Research Asia, Huya Inc e Carnegie Mellon University, o StableAnimator garante a consistência da identidade do vídeo. consistência de identidade em vídeo. A estrutura apresenta bom desempenho em vários benchmarks e gera animações de retrato de alta fidelidade e preservação da identidade.

Lista de funções

- Preservação da identidade Geração de vídeosGeração de vídeos de alta qualidade com base em imagens de referência e sequências de pose para garantir a consistência da identidade.

- Sem pós-processamentoO vídeo resultante não requer pós-processamento com nenhuma ferramenta de troca de rosto ou modelos de restauração de rosto.

- Codificador facial com reconhecimento de conteúdo globalOtimização adicional da incorporação facial por meio da interação com a incorporação de imagens.

- Adaptador de identidade com reconhecimento de distribuiçãoEvite a interferência da camada de tempo e mantenha a consistência da identidade.

- Otimização de Hamilton-Jacobi-BellmanQualidade facial: a qualidade facial é aprimorada ainda mais com a resolução da equação HJB durante o processo de raciocínio.

Usando a Ajuda

Processo de instalação

- armazém de clonesClone o repositório do StableAnimator executando o seguinte comando em um terminal:

git clone https://github.com/Francis-Rings/StableAnimator.git

- Instalação de dependênciasInstalação de dependências: Vá para o diretório do repositório e instale as dependências necessárias:

cd StableAnimator

pip install -r requirements.txt

- Executar o aplicativoUse o seguinte comando para iniciar o aplicativo:

python app.py

Processo de uso

- Preparação de imagens de referência e sequências de poseImagem de referência: Certifique-se de que você tenha uma imagem de referência e uma série de imagens de pose que serão usadas para gerar a animação.

- Execução de scripts de inferênciaUse o seguinte comando para executar o script de inferência para gerar a animação de vídeo:

python inference_basic.py --reference_image path_to_reference_image --pose_sequence path_to_pose_sequence

- Exibir resultados geradosVídeo: O vídeo gerado será salvo no diretório de saída especificado e você poderá visualizar o resultado usando qualquer reprodutor de vídeo.

Operação detalhada da função

- Preservação da identidade Geração de vídeosStableAnimator: Ao fornecer uma imagem de referência e uma sequência de poses, o StableAnimator é capaz de gerar animações de vídeo de alta qualidade, garantindo que a identidade das pessoas no vídeo seja consistente com a imagem de referência.

- Codificador facial com reconhecimento de conteúdo globalEsse módulo otimiza ainda mais a incorporação facial interagindo com a incorporação de imagem para garantir alta fidelidade dos detalhes faciais no vídeo gerado.

- Adaptador de identidade com reconhecimento de distribuiçãoDurante a geração do vídeo, o módulo garante a consistência da identidade no vídeo por meio de técnicas de alinhamento que evitam a interferência da camada de tempo.

- Otimização de Hamilton-Jacobi-BellmanQualidade e consistência dos rostos no vídeo gerado: A qualidade e a consistência dos rostos no vídeo gerado são aprimoradas ainda mais com a solução da equação HJB durante o processo de inferência.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...