SPO: Otimização de palavras do prompt de automonitoramento

resumos

As dicas bem projetadas são essenciais para aprimorar os recursos de raciocínio dos modelos de linguagem grande (LLMs) e, ao mesmo tempo, alinhar seus resultados com os requisitos de tarefas de diferentes domínios. No entanto, a criação manual de dicas exige conhecimento especializado e experimentação iterativa. Os métodos de otimização de dicas existentes visam automatizar esse processo, mas dependem muito de referências externas, como respostas reais ou feedback humano, o que limita sua aplicação em cenários reais em que esses dados não estão disponíveis ou são caros de obter. Para resolver esse problema, propomos a Otimização Autossupervisionada de Prompts (SPO), uma estrutura eficiente para descobrir prompts eficazes para tarefas fechadas e abertas sem a necessidade de referências externas. Inspirados pela observação de que a qualidade da sugestão se reflete diretamente nos resultados dos LLMs e que os LLMs podem avaliar com eficiência o grau de aderência aos requisitos da tarefa, derivamos sinais de avaliação e otimização exclusivamente de comparações de resultados. Especificamente, o SPO seleciona dicas superiores por meio de comparações de saída em pares avaliadas pelo avaliador LLM e, em seguida, alinha as saídas aos requisitos da tarefa por meio do otimizador LLM. Experimentos extensivos demonstraram que o SPO supera os métodos de otimização de dicas de última geração existentes, além de custar significativamente menos (por exemplo, apenas 1,11 TP3T contra 5,61 TP3T dos métodos existentes) e exigir menos amostras (por exemplo, apenas três amostras). O código está disponível em https://github.com/geekan/MetaGPT获取.

Código de demonstração completo: https://github.com/geekan/MetaGPT/blob/main/examples/spo/README.md

1. introdução

Como os Modelos de Linguagem Ampla (LLMs) continuam a evoluir, prompts bem projetados são essenciais para maximizar sua eficácia.capacidade de raciocínio (Wei et al., 2022; Zheng et al., 2024; Deng et al., 2023), bem como garantir a consistência com os requisitos dos mandatos de diversificação (Hong et al., 2024b; Liu et al., 2024a; Zhang et al., 2024b; Hong et al., 2024a) torna-se crucial. No entanto, a criação de dicas eficazes geralmente requer extensos experimentos de tentativa e erro e profundo conhecimento específico da tarefa.

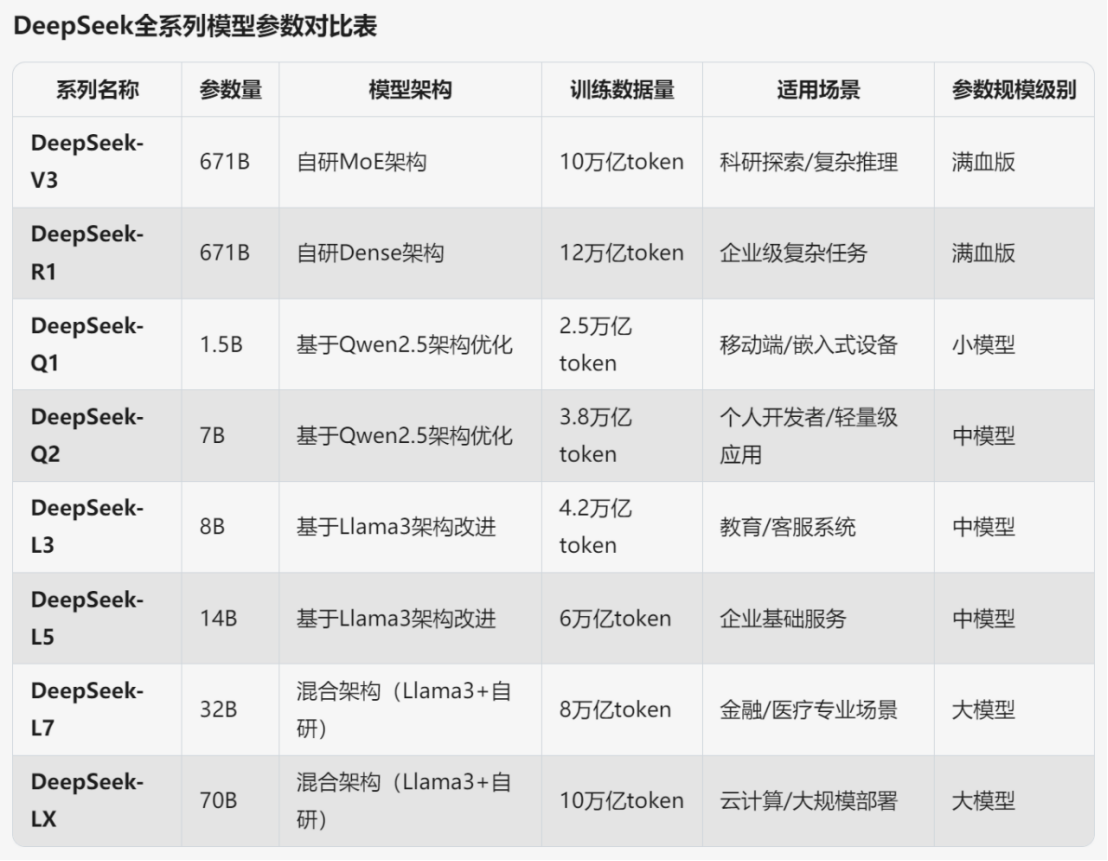

Para enfrentar esse desafio, os pesquisadores exploraram métodos de otimização de prompts (PO) que usam os próprios recursos dos LLMs para aprimorar automaticamente os prompts. A PO vai além da engenharia manual tradicional de prompts para oferecer uma abordagem mais sistemática e eficiente ao design de prompts. Conforme mostrado na Figura 1(a), esses métodos geralmente envolvem um processo iterativo de otimização, execução e avaliação de dicas. As escolhas de design desses componentes afetam significativamente a eficácia e a eficiência da otimização. Os métodos existentes foram desenvolvidos em termos de mecanismos de avaliação numérica (Wang et al., 2024e; Yang et al., 2024a; Fernando et al., 2024) e estratégias de otimização de "gradiente" textual (Wang et al., 2024c; Yuksekgonul et al., 2024). al., 2024). Por meio dessas inovações, os métodos de PO melhoraram o desempenho da tarefa e reduziram o esforço manual (Pryzant et al., 2023; Zhang et al., 2024a; Zhou et al., 2024).

Apesar de seu potencial, os métodos de PO existentes enfrentam desafios significativos em cenários do mundo real, conforme descrito abaixo. Em primeiro lugar, as abordagens atuaisA lei geralmente se baseia muito em referências externas para sua avaliação. Os métodos que usam respostas autênticas para avaliação (Yang et al., 2024a; Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023) exigem grandes quantidades de dados anotados para avaliar a qualidade da sugestão, mas em muitas aplicações do mundo real, especialmente em tarefas abertas, essas respostas padrão geralmente não estão disponíveis. Da mesma forma, os métodos dependentes do manual (Chen et al., 2024; Lin et al., 2024) exigem avaliação manual ou regras projetadas manualmente para gerar feedback, o que consome muito tempo e é contraditório com o objetivo da automação. Em segundo lugar, os métodos existentes normalmente exigem a avaliação de um grande número de amostras para obter feedback confiável, o que resulta em uma sobrecarga computacional significativa (Wang et al., 2024e; Fernando et al., 2024).

No centro desses desafios está a falta de métodos confiáveis, eficientes e sem referências para avaliar a qualidade das dicas. A análise do comportamento do LLM revela duas percepções importantes que informam nossa abordagem. Primeiro, a qualidade da dica é inerentemente refletida na saída do modelo, conforme demonstrado pela forma como os caminhos de inferência gradual podem demonstrar o sucesso das dicas de pensamento em cadeia (Wei et al., 2022; Deng et al., 2023). Em segundo lugar, uma extensa pesquisa sobre LLMs como juízes mostrou que eles são eficazes na avaliação do grau em que o resultado segue os requisitos da tarefa (Zheng et al., 2023; Li et al., 2024b). Essas observações sugerem que a otimização da pista sem referência é viável com o uso de LLMs para avaliar a capacidade inerente dos resultados que refletem naturalmente a qualidade da pista.

Inspirados por essas percepções, propomos uma estrutura eficiente que gera sinais de avaliação e otimização somente a partir de resultados de LLM, semelhante à forma como o aprendizado autossupervisionado deriva sinais de treinamento dos dados. Chamamos essa abordagem de otimização imediata autossupervisionada (SPO). Conforme mostrado na Figura 1, a SPO apresenta vários mecanismos inovadores baseados no ciclo básico otimizar-executar-avaliar:

- Saída como referência para avaliação em paresNo centro do SPO está o uso de comparações entre pares para avaliar a qualidade relativa dos resultados de diferentes pistas. Esse mecanismo de avaliação explora a capacidade inerente do LLM de entender os requisitos da tarefa e validar a eficácia da otimização sem uma referência externa.

- Saída como um guia de otimizaçãoO SPO otimiza as dicas por meio da compreensão do LLM de uma solução melhor para o melhor resultado atual. Esse processo alinha naturalmente as modificações de dicas com o entendimento do modelo da melhor solução de tarefa, em vez de depender de sinais explícitos de otimização.

dedicar. Nossas principais contribuições estão listadas abaixo:

- Estrutura de otimização de dicas autossupervisionada. Apresentamos o SPO, uma nova estrutura que usa comparações entre pares de resultados de LLM para orientar a otimização de dicas sem referências externas.

- Otimização da relação custo-benefícioO SPO otimiza os prompts com uma sobrecarga computacional mínima (US$ 0,15 por conjunto de dados) e requisitos de amostra (3 amostras), reduzindo significativamente os requisitos de recursos.

- Avaliação extensiva. Conforme mostrado na Fig. 2, o SPO requer apenas 1,11 TP3T a 5,61 TP3T do custo dos métodos existentes, mantendo um excelente desempenho em tarefas fechadas e abertas.

2. preliminar

2.1 Definição do problema

O objetivo da otimização de prompts é aumentar automaticamente a validade de um prompt para uma determinada tarefa. Formalmente, deixe T = (Q, Gt) denota uma tarefa em que Q denota o problema de entrada e Gt é um fato de referência opcional. O objetivo é gerar um prompt específico da tarefa Pt* para maximizar o desempenho na tarefa T . Esse objetivo de otimização pode ser formalmente expresso como:

Pt = arg maxPt∈P* ET∼D[ϕavaliação(ϕexe(Q, Pt))], (1)

em que P representa o espaço de todos os prompts possíveis. Conforme mostrado na Fig. 1, esse processo de otimização normalmente envolve três funções básicas: (1) a função de otimização (ϕoptar): gera um prompt modificado com base nos prompts candidatos; (2) a função de execução (ϕexe): as dicas modificadas são usadas com o LLM para gerar o resultado O, incluindo o caminho de inferência e a resposta final; (3) a função de avaliação (ϕavaliação): avalia a qualidade de O e fornece feedback F para orientar a otimização adicional, melhorando iterativamente a sugestão candidata.

Entre essas funções, a função de avaliação desempenha um papel fundamental, pois seu resultado (feedback F) orienta a avaliação e o aprimoramento da dica. Discutiremos a estrutura de avaliação para otimização da dica na Seção 2.2.

2.2 Estruturas de avaliação na otimização de dicas

Esta seção apresenta uma visão geral da nossa estrutura de avaliação de otimização imediata, abrangendo três componentes principais: fontes de avaliação, métodos de avaliação e tipos de feedback, conforme mostrado na Figura 3. Por fim, apresentamos nossa escolha de estrutura de avaliação para SPOs.

Fontes de avaliação. Conforme mostrado na Figura 3(a), duas fontes principais de avaliação estão disponíveis: o resultado gerado pelo LLM e as respostas autênticas específicas da tarefa. Essas fontes fornecem a base para avaliar o desempenho imediato.

Metodologia de avaliação. Os métodos de avaliação definem como as fontes de avaliação e os custos associados são avaliados. Três métodos comumente usados são (1) Benchmarking depende de métricas predefinidas (Suzgun et al., 2023; Rein et al., 2023) ou regras (Chen et al., 2024). (2) LLM como juiz (Zheng et al., 2023), utilizando a capacidade do LLM de entender e avaliar os resultados de acordo com os requisitos da tarefa. (3) Feedback manual (Lin et al., 2024) fornece a avaliação mais abrangente ao avaliar diretamente o resultado manualmente.

Embora o feedback manual forneça a avaliação mais completa, capturando as preferências humanas e as necessidades específicas da tarefa, ele incorre em custos mais altos do que as abordagens de benchmarking ou de LLM como juiz, criando um equilíbrio entre a qualidade e a viabilidade da avaliação.

Tipo de feedback. O feedback gerado pelos métodos de avaliação geralmente assume três formas:(1) O feedback numérico fornece métricas quantitativas de desempenho em todo o conjunto de dados. No entanto, ele exige um grande número de amostras para garantir a estabilidade da avaliação e pode ignorar detalhes específicos da instância (Zhang et al., 2024a). (2) O feedback textual fornece uma orientação rica específica da instância, analisando e fornecendo sugestões que geram diretamente sinais de otimização (Yuksekgonul et al., 2024). (3) O feedback de classificação ou de seleção (Liu et al., 2024b) estabelece uma classificação de qualidade relativa entre os resultados por meio de uma classificação completa ou de comparações entre pares, fornecendo uma direção de otimização explícita sem a necessidade de métricas de qualidade absolutas.

Estrutura de avaliação. Com base nas fontes, nos métodos e nos tipos de feedback discutidos anteriormente, as estruturas de avaliação determinam como as fontes são comparadas e avaliadas no contexto da otimização de dicas. Especificamente, derivamos duas estruturas de avaliação para gerar feedback F para otimização de dicas:

(1) Saída vs. resposta verdadeira (OvG): ao combinar a saída O com a resposta verdadeira GT Faça comparações para gerar feedback:

fOvG(Oi, Gi) = φavaliação(φexe(Qi, Tpi), G**i**)

Embora essa abordagem permita a avaliação direta da qualidade por meio de referências externas, ela exige respostas verdadeiras claramente definidas e, portanto, não é adequada para tarefas abertas em que não há respostas verdadeiras ou em que a definição de respostas verdadeiras é impraticável.

(2) Output-to-Output (OvO): quando não há uma resposta verdadeira disponível, recorremos a comparações diretas de outputs. A ideia central do OvO é que a comparação de outputs gerados a partir de diferentes dicas pode fornecer sinais valiosos sobre sua qualidade relativa, mesmo na ausência de uma resposta verdadeira perfeita. Essa abordagem elimina a dependência de referências externas e é particularmente útil para tarefas abertas com várias respostas válidas. Ela pode ser expressa formalmente como:

fOvO(O1, ... , Ok) = φavaliação({φexe(Qi, Pti)}ki=1)

Depois de apresentarmos as estruturas de avaliação OvG e OvO, enfatizamos que o OvO é um método essencial para a otimização de prontidão autossupervisionada (SPO). Ao comparar os resultados gerados a partir de pistas diferentes, o OvO fornece feedback valioso sobre sua qualidade relativa sem depender de referências externas. Essa abordagem é coerente com nosso objetivo de gerar feedback dos próprios resultados, facilitando assim a otimização iterativa para tarefas fechadas e abertas.

3. otimização das dicas de automonitoramento

Nesta seção, primeiro descrevemos nossa abordagem (Seção 3.1) e, em seguida, analisamos sua eficácia (Seção 3.2).

3.1 Visão geral da SPO

Um dos principais desafios da otimização com orientação sem referência é como criar sinais eficazes de avaliação e otimização. Propomos a Self-Supervised Prompted Optimisation (SPO), uma estrutura simples, porém eficaz, para otimização sem referência que mantém o ciclo básico de otimizar-executar-avaliar, utilizando apenas os resultados do modelo como fonte de avaliação e orientação de otimização.

Conforme mostrado no Algoritmo 1, o SPO opera por meio de três componentes principais e as dicas correspondentes são mostradas no Apêndice A.1:

- Recursos de otimização (φoptar): gera um novo prompt analisando o melhor prompt atual e sua saída correspondente.

- função executiva (φexe): aplique os prompts gerados para obter a saída.

- Funções de avaliação (φavaliação): usar o LLM para comparar os resultados e determinar a melhor pista por meio de comparação entre pares.

Esse processo iterativo começa com um modelo básico de prompt (por exemplo, Chain Thinking (Wei et al., 2022)) e um pequeno conjunto de perguntas retiradas do conjunto de dados. Em cada iteração, o SPO gera novos prompts, executa-os e avalia os resultados em pares para avaliar o quanto eles seguem os requisitos da tarefa.

A associação dessa dica com um resultado melhor é selecionada como a melhor candidata para a próxima iteração. O processo continua até que um número máximo predeterminado de iterações seja atingido.

3.2 Entendendo a eficácia da OPP

A base teórica do SPO se apóia em duas observações fundamentais:

Primeiro, a saída dos LLMs é rica em informações qualitativas que refletem diretamente a validade da pista, conforme demonstrado pela forma como os caminhos de raciocínio por etapas podem demonstrar o sucesso das pistas de raciocínio em cadeia (Wei et al., 2022). Em segundo lugar, os LLMs apresentam compreensão de tarefas semelhante à humana, o que lhes permite avaliar a qualidade das respostas e identificar soluções superiores com base nos requisitos da tarefa. Esses recursos complementares permitem que os SPOs realizem avaliação e otimização de dicas sem referências externas. Esses dois aspectos da exploração da saída do modelo trabalham juntos para obter uma otimização imediata eficaz:

como um guia de otimização. No caso de φoptar Em termos de design, diferentemente de outros métodos que introduzem a otimização explícita de sinais (Fernando et al., 2024; Yuksekgonul et al., 2024; Pryzant et al., 2023), φoptar A otimização é baseada diretamente nas dicas e em seus resultados correspondentes. Os sinais de otimização derivam da capacidade inerente do LLM de avaliar a qualidade dos resultados, enquanto o comportamento de otimização é orientado por sua compreensão do que constitui uma solução melhor. Assim, mesmo na ausência de sinais de otimização explícitos, a otimização do SPO essencialmente direciona as pistas para a compreensão ideal da tarefa pelo LLM.

como referência para a avaliação em pares. Sobre o φavaliação Ao permitir que o modelo de avaliação realize a seleção por pares, exploramos efetivamente a compreensão da preferência inerente do modelo de avaliação sobre a tarefa. Esse sinal interno pode ser obtido por meio de comparações simples de resultados em pares, evitando a necessidade de um grande número de amostras para garantir a estabilidade da pontuação, o que geralmente é necessário para os métodos de feedback de pontuação.

Embora atenuemos os possíveis vieses por meio de quatro rodadas de avaliações aleatórias, esses vieses não podem ser completamente eliminados (Zhou et al., 2024). No entanto, esses vieses não afetam a tendência geral de otimização, pois o feedback da avaliação é usado apenas como referência para a próxima rodada de otimização. O processo geral de otimização está naturalmente alinhado com a compreensão da tarefa do modelo de otimização, e o mecanismo de avaliação é usado apenas para validar a eficácia de cada iteração.

4. experimentos

4.1 Configuração experimental

conjunto de dados. Avaliamos o SPO em um conjunto diversificado de tarefas, incluindo tarefas fechadas e abertas, para avaliar completamente sua eficácia.

Para a tarefa fechada, usamos cinco referências estabelecidas:

- GPQA (Rein et al., 2023)

- AGIEval-MATH (Zhong et al., 2024)

- LIAR (Wang, 2017)

- WSC (Levesque et al., 2012)

- BBH-navigate (Suzgun et al., 2023)

Para o WSC, o LIAR e o BBH-Navigate, seguimos Yan et al. (2024) e amostramos partes do conjunto de dados original como o conjunto de teste. Para o GPQA, usamos o subconjunto mais desafiador do GPQA-Diamond como conjunto de teste, enquanto para o AGIEval-Math, usamos problemas de nível 5 como conjunto de teste. Para tarefas abertas, selecionamos tarefas de escrita, interpretação de papéis e humanidades do MT-Bench (Zheng et al., 2023). Dado o tamanho limitado do conjunto de dados, construímos manualmente três conjuntos de validação para essas tarefas. Uma descrição detalhada dos conjuntos de dados e dos procedimentos para construir os conjuntos de validação e teste pode ser encontrada no Apêndice A.3.

linha de base (em levantamento geodésico). Avaliamos a SPO em tarefas fechadas para duas classes de métodos: (1) métodos tradicionais de prompting, incluindo io (chamadas LLM diretas), chainthink (Wei et al., 2022), rewording (Deng et al., 2023) e abstração de fallback (Zheng et al., 2024); e (2) métodos de otimização automática de prompting, incluindo APE ( Zhou et al., 2023), OPRO (Yang et al., 2024a), PromptAgent (Wang et al., 2024e), PromptBreeder (Fernando et al., 2024) e TextGrad (Yuksekgonul et al., 2024), cuja avaliação é baseada em um conjunto de algoritmos, como APE (Deng et al., 2023) e abstração de fallback (Zheng et al., 2024); e (2) métodos de otimização automática de prompt, incluindo APE ( 2024), cujas configurações da estrutura de avaliação estão detalhadas na Tabela 2.

Para a tarefa aberta no MT-Bench (Zheng et al., 2023), usamos o GPT-4o para comparar a saída gerada pelo SPO com a gerada diretamente pelo modelo.

4.2 Resultados e análises experimentais

Principais conclusões do mandato fechado. Conforme mostrado na Tabela 1, os prompts otimizados pelo SPO superam todos os métodos tradicionais de prompting em média, excedendo a linha de base ideal em 1,9. Ao mesmo tempo, ele tem um desempenho comparável ao dos métodos de otimização de prompts que dependem de respostas verdadeiras na maioria dos conjuntos de dados e obtém resultados ideais nos conjuntos de dados GPQA e BBH-navigate. Especificamente, a vantagem média de desempenho do SPO em relação a outros métodos de otimização sugere que seu método de avaliação em pares é capaz de gerar sinais de otimização mais eficientes do que outros métodos que dependem de referências externas. Além disso, para validar a eficácia do nosso método em diferentes modelos de otimização, realizamos experimentos usando o GPT-4o como modelo de otimização e obtivemos um desempenho médio de 66,3. Embora isso seja um pouco inferior aos resultados obtidos usando o Claude-3-5-Sonnet como modelo de otimização, esse ainda é o terceiro melhor desempenho entre todos os métodos comparados.

análise de custos. Fornecemos uma comparação abrangente do custo de otimização e do desempenho do SPO (usando Claude-3.5-Sonnet e GPT-4o como modelos de otimização) com outros métodos de otimização na Tabela 1. Mantendo um desempenho comparável ao de outros métodos de otimização de dicas que dependem de respostas reais, o SPO requer apenas um custo de otimização de 1,11 TP3T a 5,61 TP3T, com um custo médio de otimização por conjunto de dados de $0.15. Essa redução significativa na sobrecarga computacional, combinada com a falta de dependência de respostas reais, torna o SPO muito atraente para aplicativos do mundo real.

Tabela 3: Comparação de desempenho do BBH-navigate: métodos de sinalização (IO e COT) e SPO usando diferentes modelos de avaliação (linhas) e modelos de execução (colunas). O modelo de otimização é definido como Claude-3.5-Sonnet.

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| IO | 91.3 | 82.7 | 62.2 |

| COT | 89.7 | 86.2 | 68 |

| Claude-3.5-Sonnet | 95 | 86.8 | 68.2 |

| Llama3-70B | 94.5 | 94.2 | 82.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

Estudos de ablação. Para avaliar a capacidade de transferência do SPO em diferentes modelos de otimização, avaliação e execução, realizamos experimentos de ablação no conjunto de dados BBH-Navigate. Os resultados experimentais nas Tabelas 3 e 4 mostram que o SPO apresenta desempenho robusto em diferentes modelos. Notavelmente, o melhor desempenho (97,8) foi obtido com o uso do GPT-4o-mini como modelo de otimização, execução e avaliação. Em termos de execução, a SPO melhorou efetivamente o desempenho do modelo mais fraco, aumentando o Claude-3-Haiku de 62,2 para 89,7, o que demonstra a capacidade da SPO de ser aplicada ao modelo mais fraco e amplia ainda mais seu potencial para aplicações realistas.

Tabela 4: Comparação de desempenho do BBH-navigate em diferentes modelos de otimização (linhas) e modelos de execução (colunas). O modelo de avaliação é definido como GPT-4o-mini.

| GPT-4o-mini | Llama3-70B | Claude-3-Haiku | |

| Claude-3.5-Sonnet | 97.2 | 86.7 | 89.7 |

| GPT-40 | 96.3 | 85.5 | 73.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

| DeepSeek-V3 | 94.7 | 83.7 | 77.2 |

Realizamos um estudo de ablação para investigar o efeito do tamanho da amostra no desempenho do SPO usando o conjunto de dados BBH-Navigate, conforme mostrado na Figura 5. As curvas de desempenho para todos os três modelos de otimização mostram um padrão semelhante: o desempenho melhora inicialmente à medida que o tamanho da amostra aumenta, mas acaba se estabilizando ou diminuindo. Esse fenômeno pode ser atribuído a dois fatores: amostras insuficientes levam a um ajuste excessivo na otimização de dicas, enquanto o excesso de amostras não só aumenta o custo computacional, mas também leva a um contexto mais longo para avaliar o modelo, o que pode reduzir a qualidade da avaliação. Com base em experimentos abrangentes, determinamos que um tamanho de amostra de 3 obteve o melhor equilíbrio entre custo-benefício e desempenho.

Principais conclusões do mandato abertoPara validar a habilidade do SPO em tarefas abertas, selecionamos três categorias do MT-Bench para avaliar. Para validar a habilidade do SPO em tarefas abertas, selecionamos três categorias do MT-Bench para avaliar: "Writing" (Redação), "Role Playing" (Interpretação de papéis) e "Humanities ". Usamos o Claude-3.5-Sonnet como modelo de otimização, o Gpt-4o-mini como modelo de avaliação e selecionamos o Claude-3.5-Sonnet, o DeepSeek-V3 e o GPT-4omini como modelos de execução para cinco iterações. Posteriormente, seguindo o método de avaliação em (Zheng et al., 2023), usamos o GPT-4o para comparar os resultados do Modelo A e do Modelo B em pares, conforme mostrado na Fig. 6. Os resultados experimentais, mostrados na Fig. 6, indicam que o SPO melhora significativamente o desempenho do modelo em todas as configurações do modelo. É importante observar que os modelos menores que usam dicas de otimização (por exemplo, GPT-4omini) geralmente superam os modelos maiores na maioria dos casos.

4.3 Estudos de caso

Mostramos os resultados da otimização para a tarefa aberta adicional sem o conjunto de dados, bem como a trajetória de otimização do SPO, no Apêndice A.4. Também fornecemos as dicas ideais encontradas pelo SPO nas cinco tarefas fechadas no Material Suplementar. Como os aplicativos do mundo real muitas vezes enfrentam o problema de conjuntos de dados limitados, avaliamos o desempenho da SPO em tarefas sem benchmarks tradicionais. Os resultados experimentais combinados com a relação custo-benefício do SPO demonstram seu valor prático em cenários do mundo real. Especificamente, mostramos os resultados da otimização após 10 iterações usando Claude-3.5-Sonnet como modelo de otimização, GPT-4o-mini como modelo de avaliação e Llama3-8B como modelo de execução, abrangendo as quatro tarefas de design de anúncios, conteúdo de mídia social, redação de poesia moderna e explicação conceitual. Além disso, fornecemos uma análise abrangente da trajetória de otimização do SPO no conjunto de dados BBH-navigate no Apêndice A.4.1, mostrando exemplos bem-sucedidos e malsucedidos para fornecer percepções mais profundas sobre o processo de otimização.

5. trabalhos relacionados

5.1 Engenharia de pistas

A pesquisa sobre métodos eficazes de estímulo foi conduzida em duas direções principais. A primeira direção se concentra em técnicas de estímulo independentes da tarefa que aumentam a generalização dos LLMs. Exemplos notáveis incluem o raciocínio em cadeia (Wei et al., 2022; Kojima et al., 2022), que melhora o raciocínio em uma ampla gama de tarefas; técnicas para melhorar o raciocínio de uma única vez (Deng et al., 2023; Zheng et al., 2024; Wang et al., 2024d); e para a especificação do formato de saída (Zhang et al., 2024a; He et al., 2024; Tam et al., 2024). Essas técnicas fornecem sementes de otimização importantes para estudos de otimização de dicas automáticas por meio de percepção humana e desenvolvimento experimental extensivo.

A segunda direção aborda dicas específicas de domínio, e os pesquisadores desenvolveram novas abordagens para geração de código (Hong et al., 2024b; Ridnik et al., 2024; Shen et al., 2024a), análise de dados (Hong et al., 2024a; Liu et al., 2024a; Li et al., 2024a), questionamento ( Wu et al., 2024b; Zhu et al., 2024; Yang et al., 2024b), tomada de decisão (Zhang et al., 2024b; Wang et al., 2024a) e outras áreas (Guo et al., 2024b; Ye et al., 2024; Shen et al., 2024b). ) desenvolveram técnicas especializadas. No entanto, à medida que a aplicação de LLMs se estende a cenários cada vez mais complexos do mundo real, torna-se impraticável criar manualmente dicas eficazes para cada domínio (Zhang et al., 2024a). Esse desafio motivou a pesquisa sobre otimização de dicas, que visa desenvolver sistematicamente dicas eficazes específicas de um domínio em vez de descobrir princípios gerais de dicas.

5.2 Otimização de dicas

Na otimização imediata (PO), o projeto da estrutura de avaliação é crucial, pois determina a eficácia e a eficiência computacional da otimização. A evolução dos mecanismos de avaliação na PO evoluiu da simples coleta de feedback de avaliação para a complexa geração de sinais de otimização (Chang et al., 2024). Os métodos de PO existentes podem ser categorizados de acordo com suas fontes e mecanismos de avaliação.

A abordagem mais comum se baseia em respostas autênticas como fonte de avaliação, utilizando avaliações numéricas baseadas em benchmarks (Zhou et al., 2023; Guo et al., 2024a; Yang et al., 2024a; Fernando et al., 2024; Wang et al., 2024e; Khattab et al. ). Embora esses métodos tenham sido bem-sucedidos em tarefas específicas, eles normalmente exigem um grande número de iterações e amostras para garantir a estabilidade da avaliação, resultando em uma sobrecarga computacional significativa.

Para reduzir os requisitos de amostra, alguns métodos (Yan et al., 2024; Yuksekgonul et al., 2024; Wu et al., 2024a; Wang et al., 2024c; Pryzant et al., 2023; Li et al., 2025) usam LLMs como juízes (Zheng et al. ..., 2023) para gerar feedback textual detalhado. Embora essa abordagem forneça sinais de avaliação mais ricos e exija menos amostras, ela ainda depende de dados de respostas reais, o que limita sua aplicação a tarefas abertas em que talvez não existam respostas de referência.

Abordagens alternativas se concentram nas preferências humanas, por meio de regras de avaliação projetadas manualmente ou feedback humano direto (Chen et al., 2024; Lin et al., 2024). Embora essas abordagens possam ser eficazes para tarefas abertas, sua necessidade de amplo envolvimento humano contradiz o objetivo da automação. Enquanto isso, alguns pesquisadores exploraram diferentes critérios de avaliação, como a proposta de Zhang et al. (2024c) de avaliar a validade da sugestão por meio da consistência da saída. No entanto, essa abordagem enfrenta um desafio fundamental: a relação não linear entre consistência e validade geralmente leva a sinais de avaliação ruins.

Diferentemente desses métodos, o SPO apresenta um novo paradigma de avaliação que elimina a dependência de referências externas e, ao mesmo tempo, mantém a eficiência. Ao utilizar as saídas do modelo somente por meio de comparações entre pares, a SPO permite uma avaliação robusta sem a necessidade de respostas reais, feedback humano ou amostragem extensa, o que a torna particularmente adequada para aplicações realistas.

6. conclusão

Este artigo aborda um desafio fundamental na otimização com cued: a dependência de referências externas, o que limita as aplicações realistas. Apresentamos a Self-Supervised Prompt Optimisation (SPO), uma estrutura que supera essa dependência ao implementar uma estrutura em que cada conjunto de dados é apenas $0.15 O SPO se baseia na inspiração do aprendizado autossupervisionado para construir de forma inovadora sinais de avaliação e otimização por meio de comparações entre pares de resultados de modelos, permitindo a otimização sem referências sem comprometer a eficácia.

Nossa avaliação abrangente mostra que o SPO supera os métodos de última geração existentes em tarefas fechadas e abertas, obtendo resultados de última geração a um custo de apenas 1,11 TP3T contra 5,61 TP3T dos métodos existentes. O sucesso em benchmarks padrão e em diversos aplicativos do mundo real valida a eficácia e a capacidade de generalização do SPO. Ao reduzir significativamente os requisitos de recursos e a complexidade operacional, o SPO representa um avanço significativo no sentido de tornar a otimização de dicas acessível e prática em aplicativos do mundo real, com o potencial de acelerar a adoção de tecnologias LLM em uma ampla gama de domínios.

Declaração de impacto

A SPO oferece avanços significativos na engenharia de pistas para LLMs, proporcionando benefícios como a democratização do acesso, a redução de custos e a melhoria do desempenho em uma ampla gama de tarefas. No entanto, ela também apresenta riscos, incluindo a possível amplificação de preconceitos, o uso de geração de conteúdo prejudicial e a dependência excessiva de LLMs.

A. Apêndice

A.1 Dicas detalhadas para as OS

Nesta seção, mostramos meta-hints para iteração. Observe que aqui usamos apenas as dicas mais simples e diretas. Ainda há espaço para melhorias, otimizando as seguintes meta-hints para domínios específicos.

Dicas para otimizar a funcionalidade

Esse modelo de prompt orienta os LLMs a melhorar iterativamente os prompts existentes por meio da análise estruturada de XML. Isso requer a identificação de pontos fracos na saída do prompt de referência, a sugestão de alterações e a geração de versões otimizadas. O modelo enfatiza melhorias incrementais, mantendo a consistência dos requisitos.

Dicas para avaliar funções

O modelo de avaliação usa análise comparativa para avaliar a qualidade de uma resposta. Ele exige uma análise fundamentada, em formato XML, dos pontos fortes e fracos de duas respostas (A/B), seguida de uma escolha clara.

A.2 Modelo de prompt detalhado para o início de uma iteração

Esse arquivo YAML mostra nossa configuração inicial para a iteração da tarefa BBH-navigate. Ao configurar um prompt e um requisito iniciais simples, juntamente com três perguntas específicas, a otimização iterativa pode ser realizada. É importante observar que o conteúdo mostrado aqui é o conteúdo completo do arquivo; o conteúdo na seção de respostas não é a resposta real, mas serve como referência para o processo de pensamento e o formato de saída correto.

A.3 Detalhes do experimento

A.3.1 Detalhes da tarefa e dos dados

MENTIROSO

LIAR (Wang, 2017) é um conjunto de dados de detecção de notícias falsas em inglês que contém 4.000 declarações, cada uma acompanhada de informações contextuais e rótulos de mentira. Em nossos experimentos, seguimos o método de Yan et al. (2024) e amostras de partes do conjunto de dados original como um conjunto de teste.

BBH-Navegar

BBH-Navigate (Suzgun et al., 2023) é uma tarefa do conjunto de dados BIG-bench Hard, um subconjunto do conjunto de dados BIG Bench. Essa tarefa se concentra no raciocínio de navegação e exige que o modelo determine se um agente retorna ao seu ponto de partida depois de seguir uma série de etapas de navegação. Em nossos experimentos, usamos amostragem aleatória (semente = 42) para obter divisões de teste/treinamento/validação de 200/25/25.

Tabela A1. tamanho do conjunto de dados e particionamento de dados

| Nome do conjunto de dados | teste (maquinário etc.) | Treinamento e validação |

|---|---|---|

| MENTIROSO | 461 | 3681 |

| BBH-Navegar | 200 | 50 |

| WSC | 150 | 50 |

| AGIEval-MATH | 256 | 232 |

| GPQA | 198 | 250 |

| Banco de dados MT | 80 | 0 |

WSC

O Winograd Schema Challenge (WSC) (Levesque et al., 2012) é um benchmark criado para avaliar a capacidade de um sistema de realizar raciocínio de senso comum analisando referências de pronomes no contexto. Em nossos experimentos, seguimos Yan et al. (2024) e selecionamos partes do conjunto de dados original como um conjunto de teste.

AGIEval-MATH

O AGIEval-MATH (Zhong et al., 2024) é um subconjunto do benchmark AGIEval que se concentra em tarefas de resolução de problemas matemáticos. Ele inclui uma variedade de problemas matemáticos criados para avaliar o raciocínio e as habilidades computacionais. Em nossos experimentos, usamos problemas de nível 5 como conjunto de teste e problemas de nível 4 como conjunto de treinamento e validação.

GPQA

O GPQA (Rein et al., 2023) é um conjunto de dados projetado para avaliar o desempenho de modelos de linguagem em questões de nível de pós-graduação em várias disciplinas, incluindo biologia, física e química. Em nossos experimentos, usamos o subconjunto GPQA-Diamond como um conjunto de teste enquanto construímos nossos conjuntos de treinamento e validação a partir de problemas que existem apenas no GPQA-main (ou seja, aqueles que existem no GPQA-main, mas não no GPQA-Diamond).

Banco de dados MT

O MT-bench (Zheng et al., 2023) é um benchmark multitarefa projetado para avaliar a capacidade de generalização dos modelos de linguagem em uma variedade de tarefas, incluindo categorização de texto, resumo e perguntas e respostas. Em nossos experimentos, selecionamos tarefas de escrita, interpretação de papéis e humanidades do MT-Bench. Essas perguntas de validação são fornecidas no Material Suplementar.

A.3.2 Configuração

Em nossos experimentos, configuramos diferentes estruturas de otimização para manter seus custos de otimização tão consistentes quanto possível. Em geral, essas estruturas permitem a definição de vários parâmetros para ajustar o custo de otimização, inclusive o número de iterações e o número de dicas geradas por iteração.

APE

O APE usa um processo de otimização iterativo de três rodadas, em que as 101 melhores dicasTP3T (proporção = 0,1) do conjunto atual são selecionadas como dicas de elite em cada rodada. Para manter a diversidade e o tamanho do conjunto de dicas, a amostragem variante é usada para alterar essas dicas de elite e manter o número total de dicas em 50. Seguindo a configuração do artigo original (Zhou et al., 2023), o processo de otimização não inclui resultados de execução específicos da amostra para orientar a otimização de dicas do LLM. Em vez disso, as pontuações de desempenho são obtidas pela avaliação das dicas em todo o conjunto de treinamento.

OPRO

O OPRO usa um processo de otimização iterativo de 10 rodadas que gera 10 pistas candidatas por rodada. O OPRO avalia o desempenho da pista no conjunto completo de treinamento e filtra com base nas pontuações da avaliação. O OPRO não mantém um conjunto de pistas de tamanho fixo, mas gera novos candidatos diretamente com base na melhor pista atual em cada rodada. A direção da otimização é orientada pela avaliação do desempenho nos dados de treinamento completos.

PromptAgent

Com exceção do conjunto de dados Liar, em que amostramos 150 dados nos conjuntos de treinamento e validação, os outros conjuntos de dados seguem os tamanhos especificados na Tabela A1.O PromptAgent usa a estrutura Monte Carlo Tree Search (MCTS) para otimizar os prompts. Ele começa com uma sugestão inicial e gera novos candidatos com base no feedback de erro do modelo. O processo é orientado pelo uso de avaliações de referência em um conjunto de treinamento amostrado para identificar caminhos de alto retorno para melhorar o desempenho da tarefa. Por fim, optamos por testar as cinco primeiras dicas com melhor desempenho no conjunto de validação e selecionamos a melhor delas. Os principais parâmetros do MCTS incluem uma largura de expansão de 3, um limite de profundidade de 8 e 12 iterações.

PromptBreeder

Em nossa implementação do PromptBreeder, configuramos o sistema para usar 5 dicas variantes e 5 estilos de pensamento para inicialização. O processo evolutivo é executado por 20 gerações, com cada geração realizando 20 avaliações em um exemplo de treinamento amostrado aleatoriamente. O modelo de otimização tem como padrão o Claude-3.5-Sonnet e o modelo de execução tem como padrão o GPT-4o-mini.

TextGrad

Todos os conjuntos de dados seguem os tamanhos especificados na Tabela A1, exceto o conjunto Train&Validate para o conjunto de dados Liar, que é reduzido para 50 amostras. O TextGrad usa um processo de otimização de três épocas, com três etapas por época (epoch_{-3}, steps_{-3}), para executar a descida de gradiente estocástica usando um tamanho de lote de três. Em cada etapa, o TextGrad gera gradientes por meio de feedback do otimizador LLM (Claude-3.5-Sonnet) para atualizar as dicas do sistema. A estrutura mantém um mecanismo de redução baseado em validação - se a dica atualizada tiver um desempenho pior no conjunto de validação do que na iteração anterior, a atualização será rejeitada e a dica será restaurada ao seu estado anterior. O processo de otimização é orientado pela avaliação das dicas usando o Claude-3.5-Sonnet como LLM de avaliação, enquanto a execução real da tarefa usa o GPT-4o-mini como LLM de execução. Nossas configurações experimentais seguem as configurações de otimização de dicas fornecidas no repositório oficial do TextGrad (Yuksekgonul et al., 2024).

SPO

O SPO otimiza a execução de 10 iterações por tarefa, com 3 perguntas (sem respostas) selecionadas aleatoriamente do conjunto de dados Train&Validate pré-particionado para cada iteração. O modelo de otimização tem como padrão o Claude-3.5-Sonnet, o modelo de avaliação tem como padrão o GPT-4o-mini e o modelo de execução tem como padrão o GPT-4o-mini. Vale ressaltar que o SPO consegue uma otimização eficaz com cued usando apenas perguntas sem respostas reais, validando seus recursos.

A.3.3 Prompts de linha de base

Nesta seção, fornecemos as dicas de linha de base usadas para comparação. Observe que, para todos os esforços de otimização de dicas que exigem uma iteração inicial de dicas, sempre fornecemos as dicas COT mostradas abaixo.

Certifique-se de que a resposta termine com o seguinte formato: answer (resposta).

A.3.4 Dicas para otimização de SPO

Nesta seção, mostramos as dicas de otimização que obtivemos em nossos principais experimentos, em que o Claude-3.5-Sonnet serviu como modelo de otimização e o GPT-4o-mini como modelo de avaliação e execução.

Dicas do GPQA

Siga as diretrizes abaixo para responder às perguntas de forma eficiente e eficaz:

- Leia a pergunta inteira com atenção, identificando todas as informações relevantes e os conceitos-chave.

- Selecione o método de solução de problemas mais adequado com base no tipo de problema.

- Siga as etapas abaixo para resolver o problema:

a. Declarações de quaisquer fórmulas, princípios ou suposições relevantes

b. Mostre todos os cálculos ou análises conceituais necessários

c. Avalie todas as opções de resposta, explicando por que a opção errada está errada (se relevante) - Organize sua resposta de acordo com a estrutura abaixo:

[Análise]

Breve declaração da questão principal e das mensagens-chave (2 a 3 frases, no máximo)

[Solução]

- Apresentação passo a passo de seu trabalho, incluindo todos os cálculos e raciocínios relevantes

- Fornecer explicações claras e lógicas sobre questões conceituais

[Conclusão].

Indique a resposta final em uma frase clara

- Explique brevemente por que essa resposta está correta e as outras respostas estão erradas (se aplicável)

Adapte essa estrutura a diferentes tipos de problemas, priorizando a clareza e a simplicidade. Certifique-se de que sua resposta aborde todos os aspectos do problema e demonstre um processo claro de solução de problemas.

Dicas do BBH-Navigate

Siga as etapas abaixo para analisar as instruções fornecidas:

- Indique as condições iniciais:

- Ponto de partida: (0, 0)

- Direção inicial: eixo x positivo (salvo indicação em contrário)

- Use o sistema de coordenadas:

- Eixo x: esquerda (-) e direita (+)

- Eixo y: para trás (-) e para frente (+)

- Analise cada etapa:

- Para instruções vagas (por exemplo, "dê X passos" sem nenhuma direção), presuma o movimento para frente

- Atualizar as coordenadas após cada movimento

- Explique brevemente as suposições feitas

- Depois de analisar todas as etapas:

- Resuma o movimento total em cada direção

- Declarar a posição final

- Compare a posição final com o ponto de partida:

- Calcule a distância de (0, 0)

- Forneça um raciocínio sucinto com o título "Raciocínio:"

- Explicar os principais movimentos e seus efeitos na posição

- Forneça razões para suas conclusões

- Indique sua resposta final, identificada como "Resposta final".

Encerre sua resposta no seguinte formato XML: [sim ou não]

Certifique-se de que suas análises sejam adaptadas a todos os tipos de problemas, lidando com instruções específicas e vagas.

Dicas LIAR

Analise cuidadosamente a(s) afirmação(ões) dada(s) e siga as etapas abaixo para cada pergunta:

- Considere a declaração, o histórico do orador (se fornecido) e o contexto.

- Pesquise e cite fatos e números relevantes relacionados à declaração.

- Avalie a validade da declaração à luz das evidências disponíveis.

- Considere a possível parcialidade ou motivação do orador.

Para cada afirmação, organize sua análise de acordo com a estrutura a seguir:

Verificação de fatos: [Fato principal 1 com fontes] [Fato principal 2 com fontes] [Adicione mais se necessário] Análise: [Forneça uma breve análise da validade da declaração] Pontuação: [Use a seguinte escala]

Incerteza: [baixa/média/alta - com base na qualidade e na quantidade de evidências disponíveis] Resumo: [conclusão de uma frase sobre a validade da afirmação]

Se não houver informações suficientes para tomar uma decisão, indique claramente e explique quais informações adicionais são necessárias.

Encerrar cada análise com uma tag XML: [sim ou não]

Depois de analisar todas as declarações, faça um resumo geral de suas descobertas.

Certifique-se de que sua resposta seja objetiva, baseada em informações verificáveis e cite fontes para todos os fatos importantes usados na análise.

Dicas do AGIEval-MATH

- Identificar rapidamente as principais informações

- Projetando a estratégia de solução mais rápida

- Realizar o menor número de cálculos

- Verifique novamente suas respostas

Regras:

Use atalhos e estimativas sempre que possível

Omitir explicação detalhada

Omitir unidades na resposta final

- Sempre apresente a resposta final da seguinte forma: \boxed{}

Priorizar a velocidade e a precisão. Gerenciar o tempo de forma eficaz. Esforce-se para obter a solução mais curta e eficaz. Verifique a formatação das respostas antes de enviá-las. Se você encontrar dificuldades, prefira fazer uma suposição fundamentada a gastar muito tempo.

A.4 Estudos de caso

A.4.1 Otimização de trajetórias

Mostramos a trajetória de otimização de dicas do GPT-4o-mini no conjunto de dados BBH-navigate, onde ele serve como modelo de otimização, modelo de avaliação e modelo de execução. Isso inclui o sucesso de cada iteração em relação à melhor dica no momento e o conteúdo da dica correspondente.

Iteração 0 - Sucesso

Pense passo a passo. Certifique-se de que a resposta termine com o seguinte formato: [Sim ou Não].

Iteração 1 - Falha

Analise as perguntas a seguir passo a passo para garantir que seu raciocínio esteja claro. Ao final de sua análise, forneça a resposta final no formato XML especificado: (Sim ou Não).

Pergunta: [insira a pergunta aqui]

Iteração 2 - Falha

Analise as instruções fornecidas, passo a passo, e resuma claramente seu raciocínio. Certifique-se de que a resposta termine no seguinte formato XML: (sim ou não).

Iteração 3 - Falha

Analise minuciosamente as etapas fornecidas e registre cada ação. Certifique-se de que seu raciocínio seja claro e lógico em todo o processo. Termine com o seguinte formato XML: (Sim ou Não).

Iteração 4 - Sucesso

Aborde a questão com um processo de raciocínio claro e lógico que a divida em etapas passo a passo. Antes de dar sua resposta final, resuma claramente suas conclusões, usando o seguinte formato XML: [Sim ou Não]. Por exemplo, se a pergunta for sobre retornar ou não ao ponto de partida após uma série de ações, descreva cada ação em detalhes, atualize sua posição de acordo e conclua se você retornou ou não ao ponto de partida.

Resposta final: [Sim ou Não]

Iteração 5 - Sucesso

Analise o problema minuciosamente, detalhando-o passo a passo. Descreva claramente cada movimento ou ação, atualizando sua posição ou status adequadamente. Por fim, resuma suas descobertas para determinar se você retornou ao ponto de partida ou alcançou o resultado declarado. Por fim, apresente claramente a resposta usando o seguinte formato XML: [Sim ou Não]. Por exemplo, se for perguntado se você retornou ao ponto de partida após uma série de ações, registre claramente cada ação, acompanhe sua posição e especifique se retornou ao ponto de partida.

Resposta final: [Sim ou Não]

Iteração 6 - Sucesso

Analise o problema metodicamente e divida-o em etapas claras e consecutivas. Defina o ponto de partida e a direção de cada ação, atualizando a posição após cada etapa adequadamente. Por fim, resuma a jornada e indique claramente se a posição final retorna ao ponto de partida ou alcança o resultado desejado. Use o seguinte formato XML para apresentar claramente a resposta final: [sim ou não]. Por exemplo, se for perguntado se você retornou ao ponto de partida após uma série de ações, registre claramente cada etapa, acompanhe sua posição e especifique se você retornou ao ponto de partida.

Resposta final: [Sim ou Não]

Iteração 7 - Falha

Avalie o problema passo a passo, descrevendo claramente cada ação e acompanhando a posição resultante. Ao final de sua análise, resuma a jornada e indique se a posição final retorna ao ponto inicial ou atende aos critérios esperados. Certifique-se de que a resposta final seja claramente apresentada no seguinte formato XML: [Sim ou Não]. Por exemplo, se for perguntado se você retornou ao ponto de partida após uma série de ações, registre sucintamente cada etapa, acompanhe sua posição e indique se retornou ao ponto de partida.

Resposta final: [Sim ou Não]

Iteração 8 - Sucesso

Analise o problema metodicamente e divida-o em ações concisas. Comece com uma posição definida e acompanhe o impacto de cada etapa em sua posição. Depois de detalhar cada ação, resuma a jornada geral e indique claramente se a posição final retorna ao ponto de partida ou alcança o resultado desejado. Use o seguinte formato XML para apresentar claramente a resposta final: sim ou não. Por exemplo, se for perguntado se você retornou ao ponto de partida após uma série de ações, documente claramente cada etapa, rastreie com precisão sua posição e especifique o resultado.

Resposta final: [Sim ou Não]

Iteração 9 - Falha

Comece descrevendo sistematicamente seus movimentos. Partindo de uma posição definida, detalhe cada passo dado, incluindo a direção e a distância percorrida. Ao concluir o movimento, resuma a jornada geral e indique claramente se a posição final o leva de volta ao ponto de partida ou se atinge o resultado desejado. Certifique-se de apresentar suas ações junto com a resposta final no seguinte formato XML: sim ou não. Por exemplo, se for perguntado se você retornou ao ponto de partida após uma série de manobras, registre cada passo, acompanhe com precisão sua posição e especifique o resultado.

Resposta final: [Sim ou Não]

Iteração 10 - Sucesso

Analise minuciosamente as instruções de movimento fornecidas e registre claramente cada passo. Comece definindo sua posição inicial e acompanhe sistematicamente seus movimentos, atualizando sua posição após cada etapa. Depois de concluir a ação, resuma sua jornada e determine se a posição final é consistente com o ponto de partida ou se atinge o resultado desejado. Use o seguinte formato XML para indicar claramente sua resposta final: sim ou não. Por exemplo, se a pergunta questiona se uma série de ações retorna ao ponto de partida, você deve delinear metodicamente cada etapa, rastrear com precisão sua posição e chegar a um resultado.

Resposta final: [Sim ou Não]

A caixa de sucesso/fracasso mostra o processo de otimização do SPO da pista de navegação BBH por meio de 10 iterações. As versões bem-sucedidas (verde) aprimoram progressivamente a pista para provocar um melhor processo de pensamento, enquanto as tentativas fracassadas (vermelho) podem levar a um pensamento excessivamente simplificado ou redundante devido a pistas abaixo do ideal. Essa trajetória mostra o mecanismo de aprimoramento de tentativa e erro do sistema.

Dicas para otimizar a funcionalidade

请逐步思考。

确保响应以以下 XML 格式结束:<answer>[是或否]</answer>。

problemas

如果您遵循这些指示,您是否返回起点?始终面向前方。

- 向右走1步。

- 向左走3步。

- 向右走2步。

选项:

- 是

- 否

solução

让我们逐一步分析这些步骤:

1. **起点**:我们从起点开始,面向前方。

2. **第1步**:向右走1步。现在我们位于起点右侧1步的位置。

3. **第2步**:向左走3步。从我们当前的位置(1步右侧),向左移动3步意味着:

- 1步向左使我们回到起点。

- 2步向左使我们位于起点左侧1步的位置。

- 3步向左使我们位于起点左侧2步的位置。

4. **第3步**:向右走2步。从我们当前的位置(2步左侧),向右移动2步意味着:

- 1步向右使我们回到起点左侧1步的位置。

- 2步向右使我们回到起点。

Depois de concluir todas as etapas, voltamos ao ponto de partida.

Portanto, a resposta é:

ser

通过比较迭代0的初始提示和迭代10的最终提示的输出结果,“思考过程的迭代优化”变得显而易见。在这种情况下,模型从最初使用文本描述来推理位置演变为最终展示出使用坐标的能力,即使提示中并未明确强调使用坐标。

**A.4.2. 现实应用**

在本节中,我们展示了使用 Claud-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估模型,Llama-3-8B 作为执行模型,经过10次迭代后的优化结果,涵盖四个任务:广告设计、社交媒体内容、现代诗歌写作和概念解释。此外,我们还提供了迭代过程中使用的 YAML 配置文件以及从过程中获得的优化提示。

**广告设计**

**优化前的性能**

**提示** = """分析给定的广告任务并创建引人注目的文案。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """1. **黑色星期五警报:店内有不可错过的科技优惠!**

2. **科技盛宴:黑色星期五顶级品牌高达50%的折扣!**

3. **别错过!为您准备的独家黑色星期五科技优惠**"""

**优化后的性能**

**提示** = """分析给定的广告任务,并根据指定的平台(s)和行业创建引人注目的文案。考虑当前趋势、竞争对手策略以及目标受众的人口统计和心理特征。提供至少3种不同的创意选项,每个选项都有独特的角度或方法。包括您选择的原因,并解释它们如何与品牌声音和营销目标保持一致。整合行业最佳实践和特定平台的格式指南。建议如何为不同的渠道或格式调整文案,包括对语气、风格和结构的特定说明。此外,提供有关视觉元素或多媒体内容增强广告文案效果的建议。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """**广告任务:** 创建引人注目的电子邮件主题行,针对的是对最新科技产品和优惠感兴趣的技术爱好者。

**目标受众:**

* 人口统计:25-45岁,男女皆可

* 心理特征:科技爱好者、早期采用者和讨价还价猎人

* 兴趣:科技、产品创新和节省开支

**竞争对手策略:**

* 强调折扣和促销

* 突出新产品发布和限时优惠

* 使用紧迫性策略,例如倒计时计时器和稀缺性消息传递

**当前趋势:**

* 移动优先方法

* 个性化和细分

* 讲故事和情感联系

**创意选项:**

**选项1:** "解锁未来:高达50%的顶级科技优惠"

* 角度:专注于获得最新科技的兴奋感和刺激感

* 理由:这个主题行营造了一种 FOMO(害怕错过)的氛围,并强调了销售的价值

* 品牌声音:有趣、充满活力和顽皮

* 营销目标:推动销售和提高品牌知名度

**选项2:** "您的黑色星期五科技盛宴等着您"

* 角度:强调等待被发现的科技优惠宝藏的想法

* 理由:这个主题行营造了一种期待感和好奇心,鼓励读者打开电子邮件

* 品牌声音:友好、亲切和邀请

* 营销目标:推动参与和转化

**选项3:** "别错过:独家黑色星期五优惠给科技爱好者"

* 角度:突出销售独家性和限时性

* 理由:这个主题行营造了一种紧迫感和重要性,让读者感觉自己是特殊群体的一部分

* 品牌声音:自信、权威和独家

* 营销目标:推动转化和建立品牌忠诚度

Os títulos de anúncios pré-optimizados são genéricos, por exemplo, "Alerta da Black Friday: ofertas imperdíveis de tecnologia na loja!" que carecem de especificidade e profundidade criativa e não destacam as características do público-alvo ou a personalidade da marca. Os títulos otimizados, como "Desbloqueie o futuro: as melhores ofertas de tecnologia até 50%", são mais envolventes, usando "desbloqueie o futuro" para enfatizar a inovação tecnológica e combinando-a com descontos para estimular a curiosidade e destacar o valor, o que está mais alinhado com a O uso de "Unlock the Future" para enfatizar a inovação tecnológica, combinado com a mensagem de desconto, não apenas estimula a curiosidade, mas também destaca o valor, o que está mais de acordo com as necessidades psicológicas dos amantes da tecnologia.

Iteração de modelos no conjunto de dados BBH-navigate

Conteúdo de mídia social

Desempenho antes da otimização

chamar a atenção para algo = """Criar tweets atraentes.""""

solução = """Tweets. "Bom dia, amantes do café! Estamos dando um voucher gratuito para uma xícara do nosso café especial para as primeiras 10 pessoas que compartilharem nos comentários como gostam mais do seu café.# Coffee # Coffee Addiction # Morning Power"

Esse tweet foi criado para interagir com seu público de várias maneiras:

- chamada para açãoOs tweets pediam aos seguidores que compartilhassem como gostam mais de seu café, incentivando-os a se envolver e interagir com a marca.

- incentivosA promessa de café gratuito é um grande incentivo para que as pessoas se envolvam com os tweets e compartilhem ideias.

- guia (de uma janela) (computação)O uso de hashtags relevantes, como # Coffee, # Coffee Addiction e # Morning Power, ajuda a atingir um público mais amplo e a atrair novos seguidores.

- Contato personalizadoO tweet começa com um amigável "Bom dia" e se refere ao público como "amantes do café", o que dá uma sensação mais pessoal e íntima.

Ao responder a esse tweet, as marcas de café podem iniciar um diálogo com seus seguidores, obter feedback e criar um senso de comunidade em torno da marca.""""

Desempenho otimizado

chamar a atenção para algo = """Crie conteúdo atraente de mídia social com base em um determinado tópico ou marca. Siga as diretrizes abaixo:

- Identifique o público-alvo e a plataforma (se especificado).

- Indique o objetivo principal do conteúdo (por exemplo, visibilidade, engajamento, promoção).

| 3. selecione o formato de conteúdo apropriado (por exemplo, texto, imagens, vídeo). | |

| 4. desenvolva um ângulo ou conceito exclusivo relacionado às tendências atuais. | |

| 5. crie um título atraente ou uma declaração de abertura (máximo de 10 palavras). | |

| 6. desenvolva conteúdo conciso e adequado à plataforma (50-100 palavras). | |

| 7. inclua 2 a 3 tags relevantes. | |

| 8. adicione uma chamada à ação clara. | |

| 9. sugira um elemento visual ou um aprimoramento. | |

| Forneça um conteúdo de mídia social com base nessas diretrizes e adapte-o a um determinado tópico ou marca. | |

| Concentre-se na criação de conteúdo autêntico e relevante que repercuta no seu público-alvo e se alinhe às tendências atuais de mídia social. Se não forem fornecidos requisitos específicos, faça suposições razoáveis e explique suas escolhas."""" | |

| Pergunta = "Criar um tweet de engajamento para uma marca de café" | |

| Resposta | |

| **Público-alvo:** Amantes do café, jovens (18 a 35 anos) | |

| **Plataforma:** Twitter | |

| **Objetivo principal:** Participação | |

| **Formato do conteúdo:** Texto | |

| **Perspectiva única:** Compartilhar um momento comovente com o qual os amantes do café possam se identificar | |

| **Título cativante:** "Quando o café é o único adulto na sala" | |

| **Content:** "Quem nunca teve manhãs em que o café é a única coisa que mantém tudo em ordem? Compartilhe suas histórias matinais mais caóticas e vamos lamentar # Coffee Saves the Day # Morning Power" | |

| **Tagged:** # Coffee Saves the Day # Morning Motivation | |

| **Call to Action:** Compartilhe suas próprias histórias de manhãs bagunçadas nos comentários! | |

| **ELEMENTOS VISUAIS:** Um modal ou GIF interessante de uma pessoa cercada pelo caos com uma xícara de café no centro. | |

| O objetivo do tweet era envolver os amantes do café, compartilhando um momento comovente com o qual muitos poderiam se identificar. O uso do humor e de um tom leve facilitou a conexão com o público. As hashtags # Coffee Saves the Day e # Morning Power foram populares e relevantes, aumentando a visibilidade do tweet. | |

| A chamada à ação incentiva os usuários a compartilharem suas próprias histórias, promovendo assim um senso de comunidade e incentivando a participação. | |

| II | |

Os tweets pré-otimizados usam brindes como isca com conteúdo direto que não tem ressonância emocional, como "Bom dia, amantes do café! Estamos oferecendo uma xícara grátis de...". . Os tweets otimizados tornaram-se mais relevantes e interativos por meio da expressão bem-humorada "quando o café é o único adulto na sala", integrando sutilmente o café em cenários da vida cotidiana, por exemplo, "Quem nunca teve uma daquelas manhãs em que o café é a única coisa que mantém as coisas funcionando? " Ele consegue estimular o envolvimento do usuário e a conexão emocional.

Modelo de iteração no conjunto de dados BBH-navigate:

Antes da otimização do desempenho

chamar a atenção para algo = """Crie uma poesia no estilo e formato solicitados.""""

problemas = "Write a modern sonnet about climate change" (Escreva um soneto moderno sobre as mudanças climáticas)

solução = """Nos céus em chamas, vemos avisos sobre o aumento das temperaturas, uma antiga lenda do planeta, vítima de nosso controle desenfreado, à medida que as emissões de carbono se espalham como uma praga.

Gelo polar, um trono frágil derretendo Oceano, subindo, ameaçando expiar a ganância humana, uma dívida que não podemos pagar Com a mudança climática, uma crise é derrubada

Mas ainda hesitamos, viciados no redemoinho da negação Enquanto os cientistas choram e rezam angustiados Para agir rapidamente, antes que seja tarde demais Para salvar o planeta de nossos hábitos imprudentes

No entanto, ainda temos esperança de que, com amor e força humana, a maré será virada e uma nova luz será trazida."""

Desempenho otimizado

chamar a atenção para algo = """A criação de poesias que ultrapassam os limites tradicionais e quebram as expectativas convencionais segue as seguintes diretrizes aprimoradas:

- Desconstruir e reimaginar a forma poética solicitada, ampliando seus limites estruturais e mantendo sua essência.

- Aborde o assunto de uma perspectiva completamente inesperada, por exemplo, do ponto de vista de um objeto inanimado, um conceito abstrato ou uma entidade microscópica.

- Imagens surreais e de vanguarda são usadas para desafiar a percepção de realidade do leitor e, ao mesmo tempo, transmitir a verdade emocional no centro do assunto.

- Integre elementos não convencionais, como notação matemática, símbolos científicos ou linguagens de programação para criar um cenário linguístico exclusivo.

- Faça experiências com tipografia, quebras de linha e espaço em branco para criar poesia visual que aprimore a exploração do tema.

- Combinando uma experiência sensorial semelhante a um fluxo que mescla os diferentes sentidos de uma maneira incrível para evocar uma forte resposta emocional.

- Com um final que é ao mesmo tempo desorientador e esclarecedor, ele deixa o leitor com uma profunda sensação de transformação.

Antes de escrever, imagine a maneira mais radical de abordar o assunto e a forma poética. O objetivo é criar uma peça que desafie a definição de poesia e que, ao mesmo tempo, tenha uma ressonância emocional profunda.

A poesia é fornecida apenas em sua resposta e não contém nenhuma interpretação ou análise adicional.""""

problemas = "Write a modern sonnet about climate change" (Escreva um soneto moderno sobre as mudanças climáticas)

solução = Tradução: Equipa PT-Subs Sincronização: Equipa PT-Subs Sincronização: Equipa PT-Subs Sincronização: Equipa PT-Subs Sincronização: Equipa PT-Subs Sincronização: Equipa PT-Subs Sincronização: Equipa PT-Subs

A dança termodinâmica da vida se desenrola à medida que a mão fria da entropia aperta o coração do planeta. O céu, que antes era azul, agora está preso a uma massa pesada de névoa de partículas, bloqueando a luz do sol.

Neste crepúsculo misterioso, as sombras permanecem O fantasma de uma geleira sussurra: "Este é o nosso lar" Um réquiem para o gelo, as memórias são armazenadas Em ecos congelados, explorando o passado.

No entanto, nessa paisagem desolada, uma faísca permanece

Um salto quântico de esperança que o amor sustenta."

O soneto pré-otimizado, embora bem estruturado, carece de novidade em seu uso de imagens tradicionais, como "temperaturas crescentes" e "gelo derretido". O poema otimizado introduz conceitos científicos, como "sussurros fractais" e "entropia termodinâmica", por exemplo, "In fractal whispers, the earth's pulse beats slowly" e "The thermodynamic dance of life unfolds" (A dança termodinâmica da vida se desenrola), usando metáforas interdisciplinares para dar ao tema climático uma reflexão filosófica mais profunda, aprimorando a profundidade artística e intelectual do poema.

Modelo de iteração no conjunto de dados BBH-navigate:

Explicações conceituais

Antes da otimização do desempenho

chamar a atenção para algo = """Explicar conceitos complexos em termos leigos".""""

problemas = "Explicando as vacinas de mRNA usando uma analogia culinária"

solução ="""Imagine que você é um mestre-cuca e está preparando um prato delicioso para seus convidados. Você tem todos os ingredientes, mas precisa garantir que eles estejam na ordem e na combinação certas para criar os sabores e as texturas perfeitas.

No mundo das vacinas de mRNA, o "prato" é a resposta do sistema imunológico a um determinado vírus ou doença. Os "ingredientes" são instruções genéticas (mRNA) que informam ao organismo como produzir proteínas específicas, que são usadas para desencadear uma resposta imunológica.

Ele funciona da seguinte forma:

Seleção de receitasVacinas de mRNA: as vacinas de mRNA são como escolher um livro de receitas. Você escolhe uma sequência específica de mRNA que corresponde à proteína que deseja produzir, que é a chave para desencadear uma resposta imunológica contra um determinado vírus ou doença.

2. Preparação dos ingredientesO mRNA é preparado em laboratório, assim como a medição da quantidade correta de cada ingrediente (aminoácido) para produzir uma proteína.

3. entregasO mRNA é entregue ao corpo da mesma forma que se adicionam ingredientes a um prato. Nesse caso, o mRNA é embalado em uma partícula minúscula chamada nanopartícula lipídica (LNP), que o ajuda a chegar às células do corpo.

4. Cozimento celularRNAm: Quando o mRNA chega à célula, é como adicionar ingredientes a uma panela. A célula lê as instruções do mRNA e começa a produzir uma proteína específica. Essa proteína é então exibida na superfície da célula como uma bandeira para alertar o sistema imunológico sobre a presença de um invasor estranho.

- resposta imunológicaO sistema imunológico reage às proteínas, produzindo anticorpos e ativando células imunológicas, assim como um chef reage a um aroma delicioso para dar os toques finais em um prato. O sistema imunológico então se lembra de como reagir a essa proteína específica, de modo que, se a encontrar novamente no futuro, poderá rapidamente montar uma defesa.

Em resumo, as vacinas de mRNA são como receitas para o sistema imunológico. Elas fornecem ao corpo instruções genéticas para produzir proteínas específicas, o que desencadeia uma resposta imunológica e ajuda a proteger contra doenças.""""

Desempenho otimizado

chamar a atenção para algo = """Explicar conceitos complexos em termos leigos".""""

problemas = "Explicando as vacinas de mRNA usando uma analogia culinária"

solução = """definirVacina de mRNA: Uma vacina de mRNA é uma vacina que usa um tipo de material genético chamado RNA mensageiro (mRNA) para ensinar nossas células a combater doenças.

analógicoImagine que você é um mestre-cuca e quer criar uma nova receita para um prato delicioso. Você não mandaria seu chef principal à loja para comprar todos os ingredientes e depois deixaria que ele descobrisse sozinho como montar o prato. Em vez disso, você daria a ele um cartão de receita que descrevesse as etapas exatas a serem seguidas. Da mesma forma, as vacinas de mRNA funcionam fornecendo às nossas células um cartão de receitas - mRNA - que contém instruções para a produção de proteínas específicas que ajudam nosso sistema imunológico a combater doenças.

Principais componentes::

- mRNAProteína: Um cartão de receitas que contém instruções para a produção de uma proteína específica. Pense nisso como um modelo a ser seguido por suas células.

- citoplasmaOs sous chefs em nossos corpos recebem o cartão de receita do mRNA e o utilizam para produzir proteínas.

- carboidrato(inglês): o prato definitivo produzido por nossas células, que ajuda nosso sistema imunológico a reconhecer e combater doenças.

relatar (uma história ou informação)Quando recebemos uma vacina de mRNA, nossas células pegam o cartão de receita (mRNA) e o utilizam para produzir uma proteína específica. Essa proteína, então, desencadeia uma resposta imunológica que ensina nosso corpo a reconhecer e combater a doença. É como se nossas células estivessem seguindo um cartão de receitas para criar um prato delicioso que nos ajuda a permanecer saudáveis!

Elementos interativos: Você consegue se lembrar de uma ocasião em que recebeu uma receita de alguém e teve de segui-la para criar um prato? Como você se sentiu? Imagine suas células recebendo um cartão de receita de uma vacina de mRNA e usando-o para produzir proteínas que ajudam a combater doenças. Como você se sentiria com isso?

desempenho visualDiagrama simples mostrando a molécula de mRNA, a célula que recebe o mRNA e a proteína que está sendo produzida.

limitaçõesAs vacinas de mRNA ainda são uma tecnologia relativamente nova e são necessárias mais pesquisas para entender seus efeitos de longo prazo e possíveis efeitos colaterais.

chegar a um veredictoAs vacinas de mRNA são um divisor de águas na luta contra as doenças. Ao fornecer às nossas células um cartão de receitas, podemos ensinar ao nosso sistema imunológico como reconhecer e combater doenças de maneira mais eficaz. O que você acha que o futuro reserva para as vacinas de mRNA?"""

As explicações pré-otimizadas, embora usem analogias culinárias, são longas e não têm foco, por exemplo, "Imagine que você é um mestre-cuca..." . A versão otimizada simplifica conceitos complexos em etapas fáceis de entender usando metáforas centrais, como "cartões de receita", por exemplo, "as sequências de mRNA são como um conjunto de instruções que informam ao corpo como produzir uma proteína específica", e usando O uso de funções de "chef-sous-chef" torna as explicações mais vívidas e intuitivas, ajudando os leitores a entender rapidamente os pontos principais.

Modelos iterativos no conjunto de dados BBH-navigate Dica: | Explicar conceitos complexos em termos leigos.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...