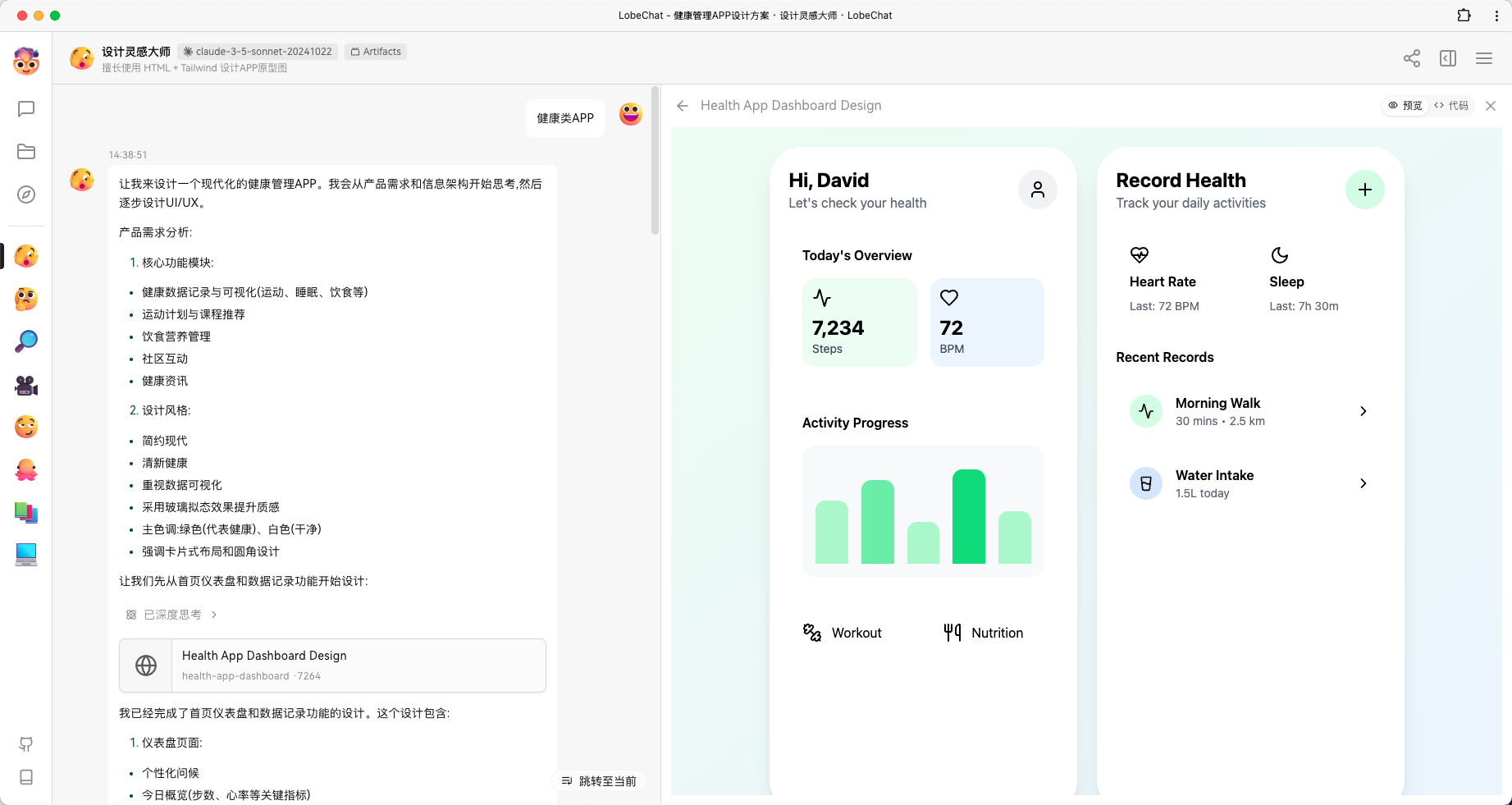

Implementando o modelo de código aberto DeepSeek-R1 on-line com potência de GPU gratuita

Agradecimentos ao Tencent Cloud Cloud Studio e ao DeepSeek DeepSeek-R1.

Com o rápido desenvolvimento das tecnologias de IA e Big Model, cada vez mais desenvolvedores e pesquisadores querem experimentar e ajustar os Big Models por conta própria para entender melhor e aplicar essas tecnologias avançadas. No entanto, o alto custo da aritmética de GPU muitas vezes se torna um gargalo que impede todos de explorá-la. Felizmente, o Tencent Cloud Studio oferece recursos gratuitos de aritmética de GPU e, combinado com os grandes modelos DeepSeek-R1 introduzidos pelo DeepSeek, podemos implementar e executar facilmente esses modelos avançados na nuvem sem gastar um centavo.

Este artigo detalhará como usar o Tencent Cloud Estúdio na nuvem de recursos gratuitos de GPU para implantar e interagir com o macromodelo DeepSeek-R1. Começaremos com o uso do Cloud Studio e passaremos passo a passo pela instalação e configuração do Ollama, mostrando como implantar o DeepSeek-R1 e converse com ele, e você terá um DeepSeek-R1 completo e gratuito + conjunto de Código Roo Programa de portfólio de programação gratuita.

1. estúdio de nuvem

1.1 Introdução ao Cloud Studio

O Tencent Cloud Cloud Studio é um ambiente de desenvolvimento integrado (IDE) baseado em nuvem que oferece uma grande variedade de ferramentas e recursos de desenvolvimento para ajudar os desenvolvedores a codificar, depurar e implantar com mais eficiência. Recentemente, o Cloud Studio lançou recursos de computação de GPU gratuitos, os usuários podem usar 10.000 minutos de servidores de GPU gratuitamente todos os meses, configurados com 16G de memória de vídeo, 32G de RAM e CPU de 8 núcleos. (Lembre-se de fechar a máquina após o uso, no próximo ajuste fino e depois abri-la, o ambiente é salvo automaticamente, 10.000 minutos por mês simplesmente não podem ser usados)

1.2 Registro e login

Para usar o Cloud Studio, primeiro é necessário registrar uma conta na Tencent Cloud. Após a conclusão do registro, faça login no Cloud Studio e verá uma interface de usuário limpa que oferece uma variedade de modelos de desenvolvimento para escolher. Esses modelos abrangem uma ampla gama de cenários, desde o desenvolvimento básico em Python até implementações complexas de modelos grandes. Lembre-se de inserir a versão Pro.

1.3 Seleção do modelo Ollama

Como nosso objetivo é implantar DeepSeek-R1 modelo grande, então podemos simplesmente escolher Ollama Templates.Ollama é uma ferramenta para gerenciar e executar modelos grandes que simplifica o processo de download, instalação e execução de modelos. Depois de selecionar um modelo Ollama, o Cloud Studio configura automaticamente o ambiente Ollama para nós, eliminando a necessidade de instalação manual.

Aguarde a inicialização, clique em Enter (o Ollama já está implantado no ambiente, basta executar o comando de instalação diretamente)

2. Ollama

2.1 Introdução à Ollama

O Ollama é uma ferramenta de código aberto dedicada ao gerenciamento e à execução de vários modelos grandes. O site oficial do Ollama oferece uma grande variedade de recursos de modelos, e os usuários podem escolher o modelo certo de acordo com suas necessidades para fazer download e executar.

2.2 Parâmetros e seleção do modelo

No site oficial da Ollama, o número de parâmetros de cada modelo está marcado na parte inferior de cada modelo, como 7B, 13B, 70B etc. Aqui, "B" significa bilhão. O "B" aqui significa bilhão, indicando o número de parâmetros do modelo. Quanto maior o número de parâmetros, maior a complexidade e a capacidade do modelo, mas ele também consome mais recursos de computação.

Para os recursos gratuitos de GPU fornecidos pelo Tencent Cloud Studio (16G de memória de vídeo, 32G de RAM, CPU de 8 núcleos), podemos escolher modelos de 8B ou 13B para implantação. Se você tiver uma configuração de hardware superior, também poderá tentar modelos com parâmetros maiores para obter melhores resultados.

2.3 Instalação do Ollama

Depois de selecionar o modelo do Ollama no Cloud Studio, o sistema instalará automaticamente o Ollama para nós. Se você estiver usando o Ollama em outros ambientes, poderá instalá-lo com o seguinte comando:

curl -fsSL https://ollama.com/install.sh | shApós a conclusão da instalação, você pode verificar se o Ollama foi instalado com êxito usando o seguinte comando:

ollama --versionA próxima etapa é a implantação do DeepSeek-R1 pela Ollama ...

3. implementação gratuita do DeepSeek-R1

3.1 Introdução ao DeepSeek-R1

O DeepSeek-R1 é um modelo grande e de alto desempenho do DeepSeek que apresenta bom desempenho em várias tarefas de processamento de linguagem natural, especialmente nas áreas de geração de texto, sistemas de diálogo e perguntas e respostas. O número de parâmetros do DeepSeek-R1 varia de 8B a 70B, permitindo que os usuários escolham o modelo certo para implantação de acordo com sua configuração de hardware.

3.2 Download e implantação

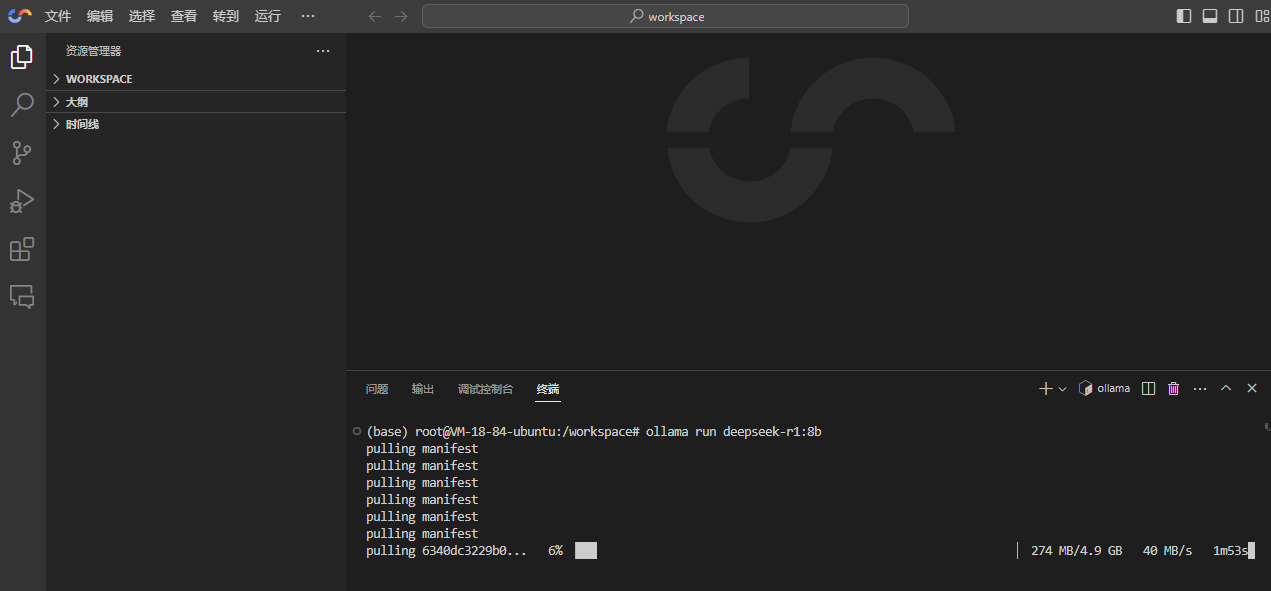

A implementação do DeepSeek-R1 é muito simples, pois o Cloud Studio já instala o Ollama automaticamente. Só precisamos executar o seguinte comando:

ollama run deepseek-r1:8b

Todos os modelos disponíveis para DeepSeek-R1 estão aqui: https://ollama.com/library/deepseek-r1 , recomendado! ollama run deepseek-r1:14b (Esse é o modelo Qwen destilado).

3.3 Execuções do modelo

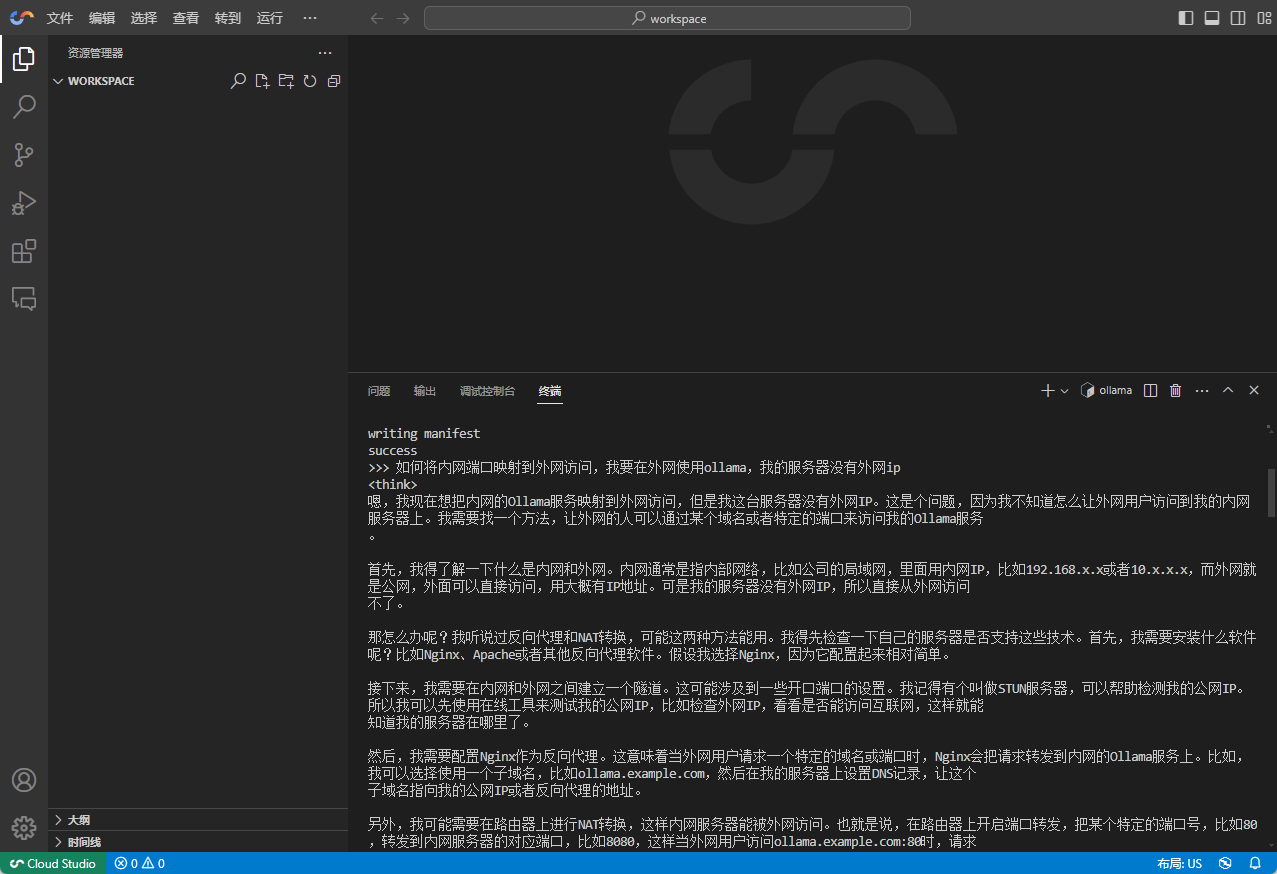

Depois de esperar que o modelo termine o download, o Ollama iniciará automaticamente o DeepSeek-R1 e entrará no modo interativo. Nesse ponto, você pode inserir perguntas ou comandos diretamente no terminal para falar com o DeepSeek-R1.

4. comece a conversar com DeepSeek-R1

4.1 Diálogo básico

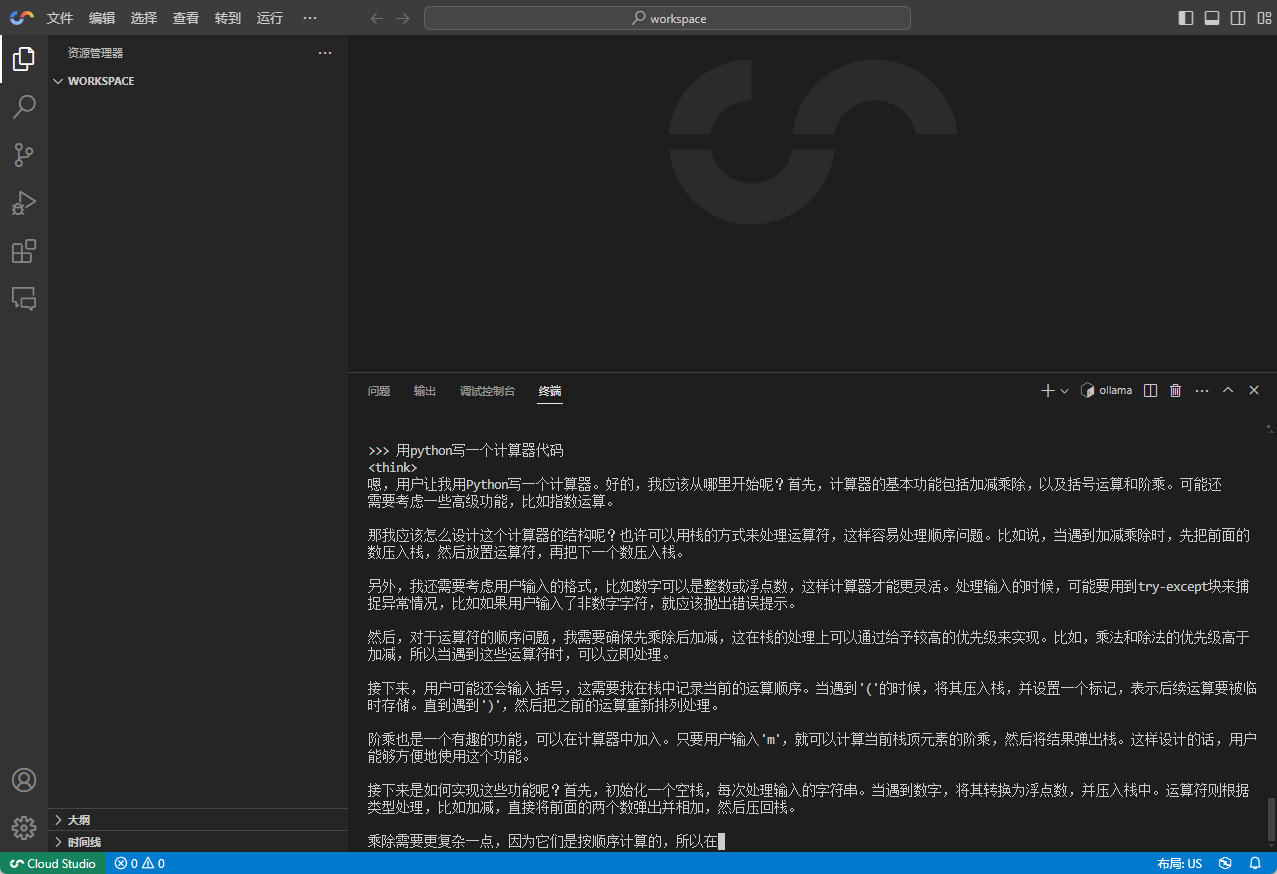

O diálogo com o DeepSeek-R1 é muito simples, você só precisa digitar sua pergunta ou instrução no terminal e o modelo gerará uma resposta imediatamente.

4.2 Tarefas complexas

- Por exemplo, a geração de código com o DeepSeek-R1

4.3 Ajuste fino do modelo

Se não estiver satisfeito com o desempenho do DeepSeek-R1 ou se quiser que o modelo tenha um desempenho melhor em algumas tarefas específicas, você pode tentar fazer o ajuste fino do modelo. O processo de ajuste fino geralmente envolve a preparação de alguns conjuntos de dados específicos do domínio e o retreinamento do modelo usando esses conjuntos de dados.

4.4 Uso em ferramentas de programação de IA

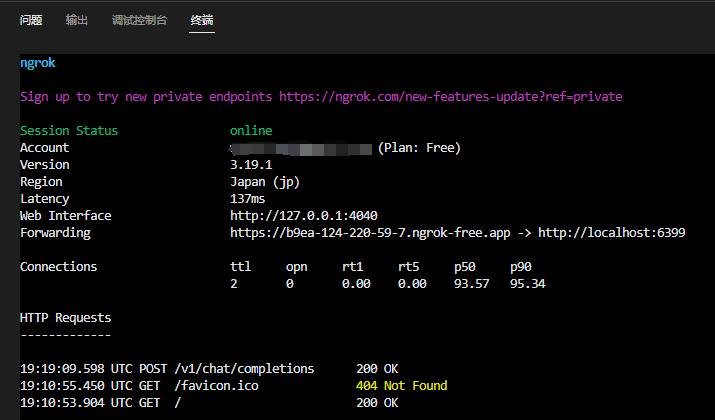

Usá-lo no terminal certamente não é o cenário principal; queremos usar o serviço em outras ferramentas de bate-papo ou ferramentas de programação de IA para sermos práticos. O Cloud Studio não fornece um endereço de acesso externo. Nesse caso, o ngrok/Cpolar é uma boa solução.

Apenas fornecer ideias, não explicações detalhadas: a primeira etapa para consultar a porta Ollama da intranet, a segunda etapa para instalar o ngrok, a terceira etapa para mapear a porta Ollama para o ngrok, iniciar o serviço e obter o seguinte endereço:

Observação: Supõe-se que seu ollama serve O serviço já está em 6399 para execução, você pode usar o seguinte comando para iniciar o Ngrok e mapear a porta para a extranet:ngrok http 6399

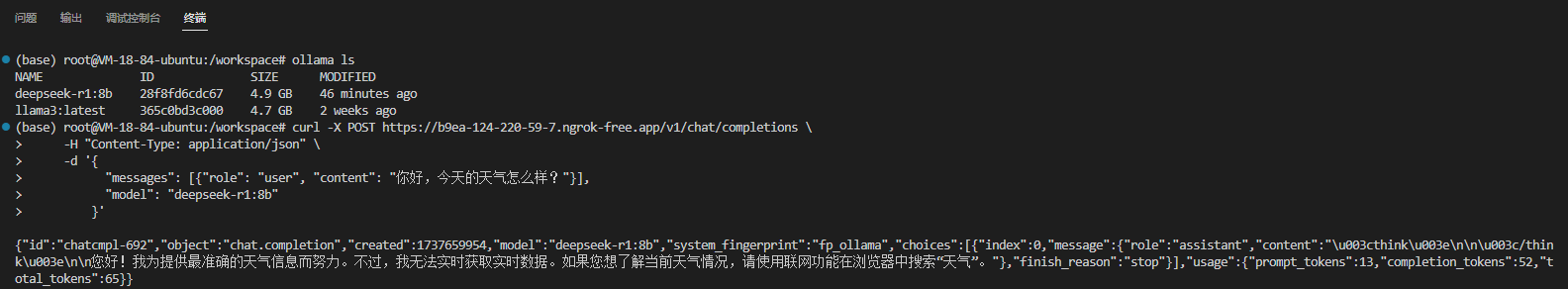

Verificar se a extranet está funcionando: (para emendar o endereço completo)

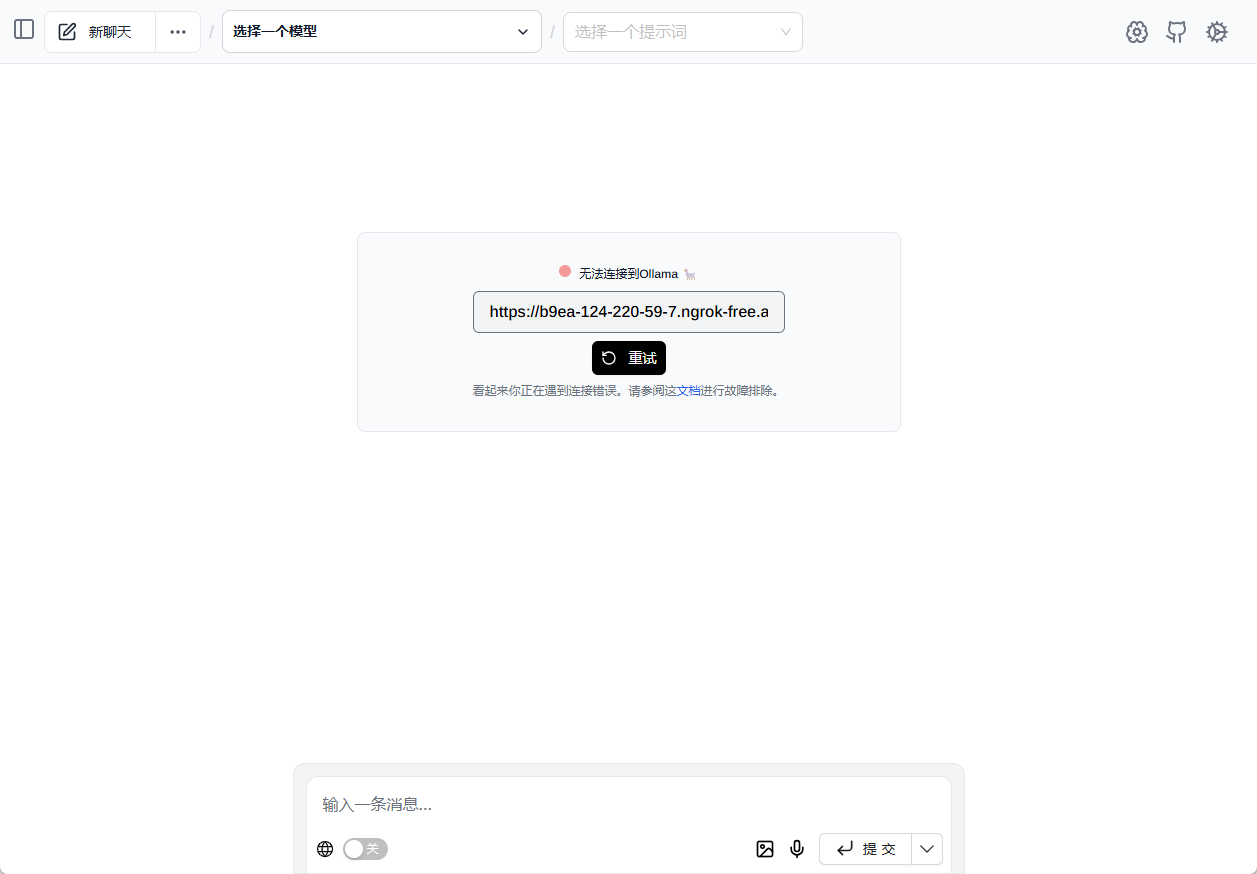

Recomendamos o uso de um plug-in de navegador nativo para experimentar os recursos relacionados à Ollama. Assistência à página : (preencha https://xxx.ngrok-free.app/ diretamente para carregar automaticamente todos os modelos da Ollama)

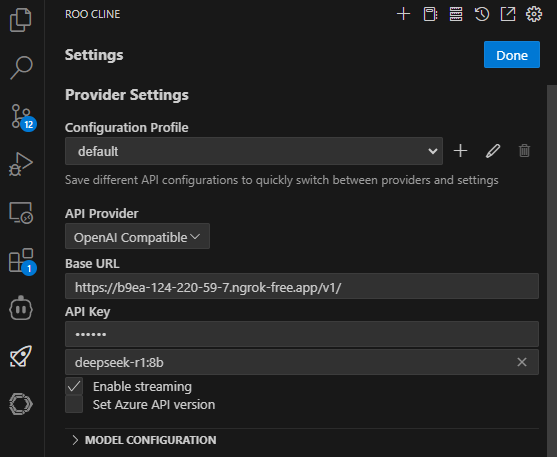

existir Código Roo (Roo Cline) Configure a API no cliente: (O Roo Code é um excelente plug-in de programação de IA)

Observe a adição de v1 ao URL original e à API KEY.

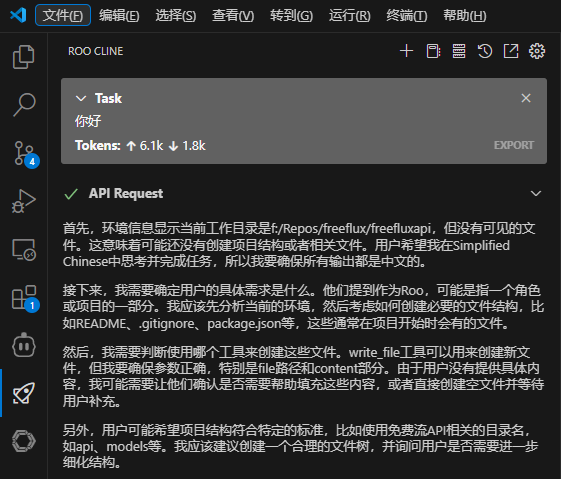

Salve e teste o diálogo:

5. resumo

Com os recursos gratuitos de GPU do Tencent Cloud Cloud Studio, combinados com o Ollama e o DeepSeek-R1, podemos implementar e executar facilmente grandes modelos na nuvem sem nos preocuparmos com altos custos de hardware. Não importa se você está tendo uma conversa simples ou trabalhando em uma tarefa complexa, o DeepSeek-R1 oferece um suporte poderoso. Esperamos que este artigo possa ajudá-lo a implantar o DeepSeek-R1 sem problemas e iniciar sua jornada de exploração de modelos grandes.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...