Quais são os requisitos mínimos de hardware para implementar o modelo deepseek localmente?

Análise dos requisitos de hardware para a implantação local dos modelos DeepSeek

- Análise dos principais elementos de hardware

Os requisitos de hardware para a implementação do modelo dependem de três dimensões principais:

- nível de parâmetroOs requisitos de memória para diferentes modelos de escala, como o 7B/67B, variam muito, sendo o maior Tutorial de implantação local do DeepSeek R1 671B: baseado em Ollama e quantificação dinâmica

- modo de inferênciaDimensionamento de FP16/INT8 reduz o espaço ocupado pela memória gráfica do 40-60%

- Cenários de usoDiferença no consumo de recursos entre raciocínio conversacional e em lote pode ser de 5 a 10 vezes

2) Exemplo de configuração típica (em termos de precisão de FP16)

Para aqueles que não entendem o FP16, podem ler:O que é quantificação de modelo: explicação dos tipos de dados FP32, FP16, INT8 e INT4Por isso, há relativamente mais versões otimizadas, por exemplo:São necessários apenas 14 GB de RAM para executar o DeepSeek-Coder V3/R1 (Q4_K_M quantised) localmente.

| tamanho do modelo | Requisitos mínimos de memória de vídeo | Placas de vídeo recomendadas | Alternativa de CPU |

|---|---|---|---|

| 7B | 14 GB | RTX3090 | 64 GB DDR4 + conjunto de instruções AVX512 |

| 20B | 40 GB | A100-40G | São necessárias estruturas de raciocínio distribuídas |

| 67B | 134 GB | 8 x A100 | Soluções somente para CPU não são recomendadas |

Fórmula de cálculo da memória da tela: número de parâmetros × 2 bytes (FP16) × 1,2 (fator de segurança)

3. principais técnicas de otimização

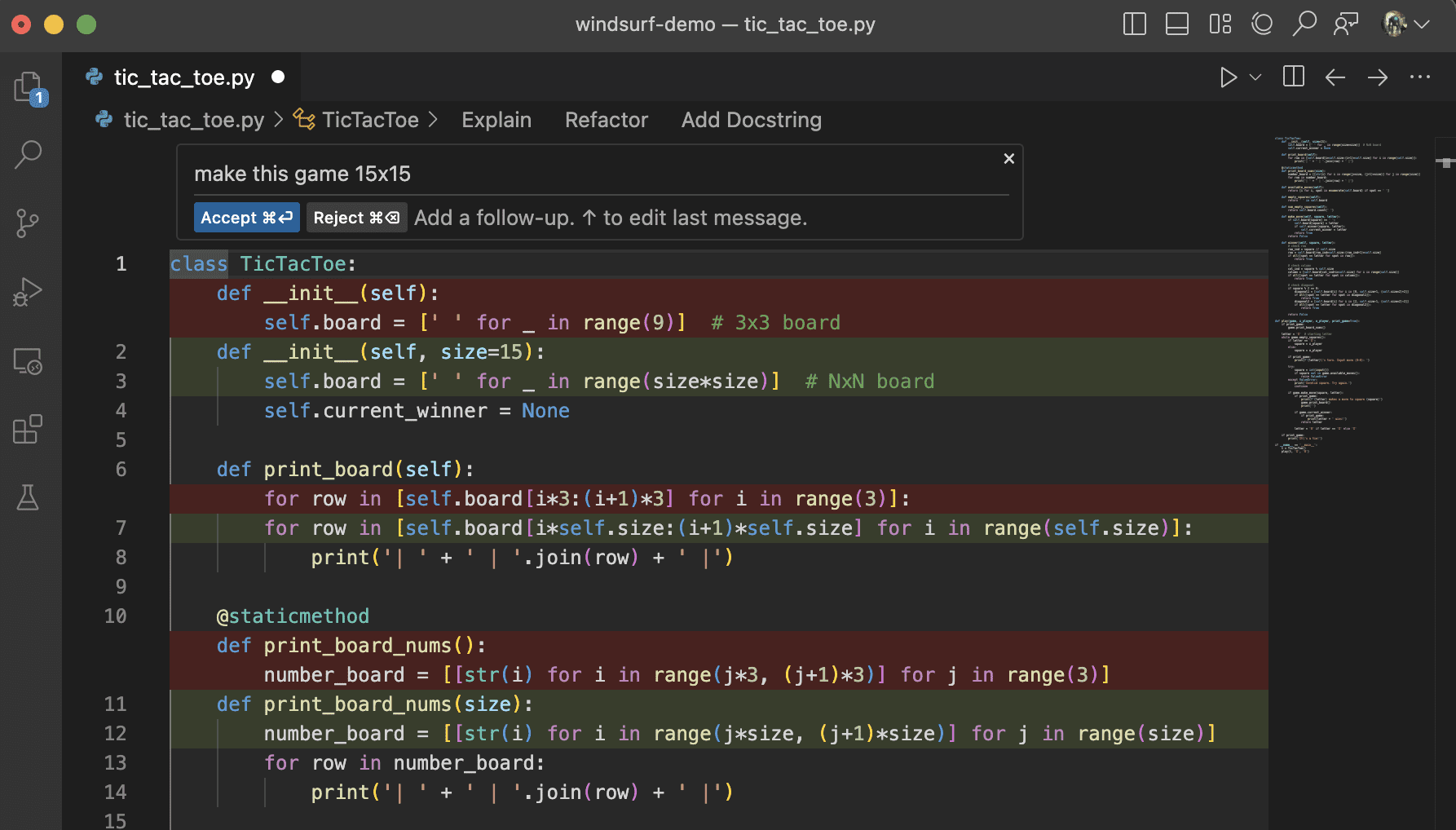

# 量化技术示例(伪代码)

model = load_model("deepseek-7b")

quantized_model = apply_quantization(model, precision='int8') # 显存降低40%

- Tecnologia de compactação de memória VGA::

- Estrutura vLLMDescrição: Aprimoramento do rendimento do 20% por meio do mecanismo PageAttention

- FlashAttention-2Redução do espaço ocupado pela memória de vídeo do 30%

- Quantificação de AWQMemória 50% reduzida, mantendo a precisão de 97%

4. comparação de casos reais de implantação

| evento esportivo | RTX3060(12G) | RTX4090(24G) | A100 (80G) |

|---|---|---|---|

| DeepSeek-7B | Necessidade de quantificar a implementação | suporte nativo | Suporte a várias instâncias |

| velocidade de inferência | 8 tokens/s | 24 tokens/s | Mais de 50 tokens/s |

| Contexto máximo | 2K tokens | 8K tokens | 32 mil tokens |

5. requisitos de armazenamento e sistema

- espaço em disco::

- Modelo básico: número de parâmetros × 2 (por exemplo, 7B requer 14 GB)

- Pacote de implantação completo: recomenda-se 50 GB de espaço

- sistema operacional::

- Ubuntu 20.04+ (recomendado)

- O Windows requer suporte a WSL2

- dependência de software::

- CUDA 11.7+

- PyTorch 2.0+

Leitura recomendada

Implementação privada sem GPUs locais DeepSeek-R1 32B

Recomendações para a práticaPara desenvolvedores individuais, a configuração de memória RTX3090 + 64 GB pode atender ao modelo 7B em execução sem problemas. Recomenda-se que a implementação em nível empresarial use o cluster A100/H100 com estruturas de otimização, como o vLLM, para obter uma inferência eficiente. A implementação quantitativa deve prestar atenção ao impacto da perda de precisão nos negócios, e recomenda-se testes e validação rigorosos.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...