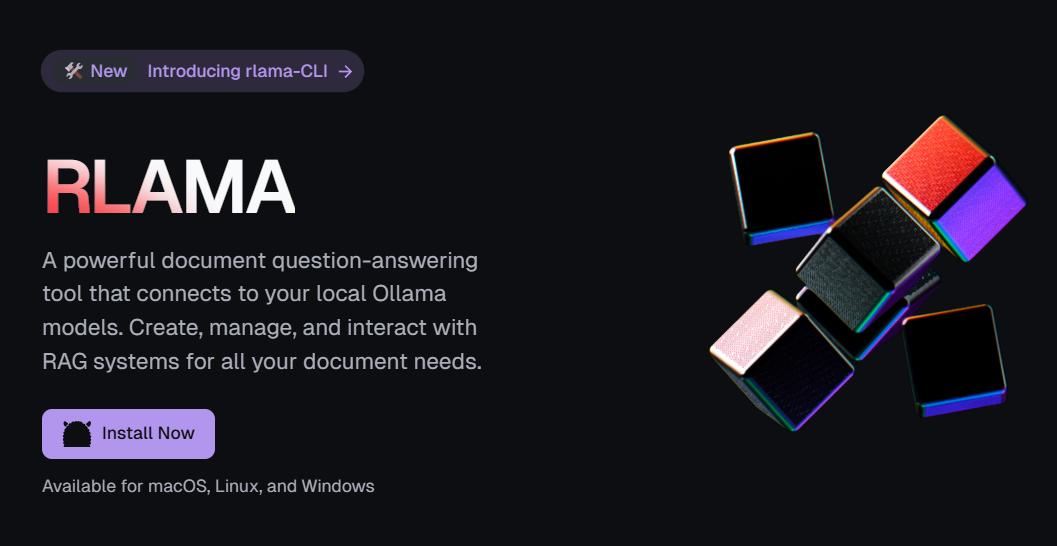

RLAMA: um sistema RAG para questionamento inteligente de documentos locais operado a partir da linha de comando

Introdução geral

O RLAMA é um sistema RAG (Retrieval Augmentation Generation) para inteligência de documentos desenvolvido pela DonTizi e hospedado no GitHub, cujo principal recurso é a funcionalidade por meio de operações de linha de comando. Os usuários podem se conectar a Ollama que indexa rapidamente documentos em pastas em uma base de conhecimento interativa com perguntas e respostas inteligentes. Seja um arquivo de código, um documento técnico ou um documento de escritório, o RLAMA está à altura da tarefa e é executado totalmente localmente, eliminando a necessidade de serviços em nuvem e protegendo a privacidade dos dados. Com suporte a vários formatos de arquivo e fácil instalação, o RLAMA é uma opção poderosa para o gerenciamento de documentos localizados, especialmente para desenvolvedores e entusiastas de tecnologia que estão acostumados a operações de linha de comando.

Lista de funções

- Criação de um sistema RAG na linha de comandoGeração de uma base de conhecimento de questionários inteligentes por meio da indexação de documentos de pastas com comandos.

- Perguntas e respostas sobre a interação com a linha de comandoUse a sessão de terminal para consultar os dados existentes RAG O conteúdo do documento no sistema.

- Administração do sistema RAGManutenção da base de dados de conhecimento com facilidade, listando e excluindo sistemas RAG com comandos.

- Integração do modelo localConexão perfeita com os modelos locais da Ollama, mantendo a localização completa.

- Gerenciamento de versões e atualizaçõesUse o comando para verificar a versão ou atualizar o sistema para o estado mais recente.

- Suporte a vários formatosCompatível com uma ampla variedade de formatos, incluindo texto, código e documentos de escritório.

- Desinstalação por linha de comandoFerramentas e dados de limpeza de comandos: fornece ferramentas e dados de limpeza de comandos.

Usando a Ajuda

Processo de instalação

O RLAMA é uma implementação de linha de comando do Document Intelligence Quiz para macOS, Linux e Windows, e as etapas a seguir são detalhadas:

1. condições prévias

- Instalar OllamaO modelo Ollama precisa ser executado localmente. Visite o site do Ollama para fazer o download e instalar, execute o programa

ollama run llama3(ou outros modelos) para confirmar a disponibilidade, o endereço padrãohttp://localhost:11434. - conexão de redeInstalação: A instalação requer uma conexão com a Internet para baixar scripts ou dependências.

- Dependências opcionaisPara oferecer suporte a mais formatos (por exemplo, .pdf, .docx), é recomendável que você execute o comando

install_deps.shFerramentas de instalação (por exemplopdftotext).

2. instalação por meio de script de linha de comando (recomendado)

Digite-o no terminal:

curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh

- O script conclui automaticamente o download e a configuração e, quando terminar, executa o script

rlama --versionVerifique a versão (por exemplov0.1.0) Confirmação de sucesso.

3. instalação manual do código-fonte (opcional)

Se a personalização for necessária:

- Armazém de Clonagem:

git clone https://github.com/DonTizi/rlama.git cd rlama - Compile e instale (é necessário um ambiente Go):

go build go install - Mova o executável para o PATH (por exemplo

/usr/local/bin), executerlama --helpValidação.

4. verificação da instalação

Em execução:

rlama --help

A exibição de uma lista de comandos é considerada bem-sucedida.

Funções principais

Criação de um sistema RAG a partir da linha de comando

Converta documentos em uma base de conhecimento de questionário inteligente. Por exemplo, a pasta ./docs incorporar readme.md responder cantando guide.pdf::

- Certifique-se de que o modelo Ollama seja executado (por exemplo

ollama run llama3). - Digite o comando:

rlama rag llama3 mydocs ./docsllama3Nome do modelo.mydocsNome do sistema RAG../docsCaminho do documento.

- Exemplo de saída:

Indexing documents in ./docs... Processed: readme.md Processed: guide.pdf RAG system "mydocs" created successfully!

Perguntas e respostas interativas por meio da linha de comando

Consultar o sistema RAG existente:

- Inicie a sessão:

rlama run mydocs - Digite a pergunta:

如何安装 rlama? - Obter respostas:

可通过终端运行 `curl -fsSL https://raw.githubusercontent.com/dontizi/rlama/main/install.sh | sh` 安装。 - importação

exitSair.

Gerenciamento do sistema RAG

- Sistema de listagem::

rlama listSaída de amostra:

Available RAG systems: - mydocs - Exclusão do sistema::

rlama delete mydocsou pular a confirmação:

rlama delete mydocs --force

Versões e atualizações

- Verificar versão::

rlama --versiontalvez

rlama -vO visor é o seguintev0.1.0. - Atualização do sistema::

rlama update(botânica) coca (palavra emprestada)

--forceAtualizações obrigatórias.

Desinstalação do sistema

- Ferramentas de remoção::

rlama uninstall - Limpeza de dadosOs dados são armazenados no

~/.rlamaExecutar:rm -rf ~/.rlama

Funções em destaque

1. operações de linha de comando

Todas as funções do rlama são implementadas por meio da linha de comando, o que é simples e eficiente. Por exemplo, uma linha de comando rlama rag mistral docs ./project Indexa instantaneamente pastas inteiras, adequado para usuários proficientes em linha de comando.

2. suporte a documentos em vários formatos

Há suporte para vários tipos de arquivos:

- Texto:

.txte.mde.htmle.jsone.csvetc. - Código:

.goe.pye.jse.javae.cppetc. - Documentação:

.pdfe.docxe.pptxe.xlsxetc.

estar em movimento./scripts/install_deps.shSuporte aprimorado. Exemplo:

rlama rag gemma code-docs ./src

3. operação localizada

Os dados são processados localmente em todo o processo, sem necessidade de nuvem, o que é adequado para documentos confidenciais. Por exemplo, indexação de documentos confidenciais da empresa:

rlama rag llama3 contracts ./legal

Dicas e solução de problemas

- Comando de precisãoDigite o parâmetro completo, por exemplo

rlama run mydocsem vez de taquigrafia para garantir a precisão. - Questão da OllamaSe a conexão falhar, verifique o

http://localhost:11434Em execuçãoollama psExibir status. - Suporte ao formatoSe a extração falhar, execute

install_deps.shInstale a dependência. - Resposta ruimConfirme se o documento está indexado e tente ser mais específico sobre o problema.

- apelo (por ajuda)Problemas podem ser enviados para os problemas do GitHub com comandos e versões.

Com os comandos acima, os usuários podem dominar rapidamente o rlama, gerenciar documentos locais e implementar perguntas e respostas inteligentes.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...