Raycast-G4F: Acesso gratuito a GPT-4, Llama-3 e muitos outros modelos de IA via Raycast!

Introdução geral

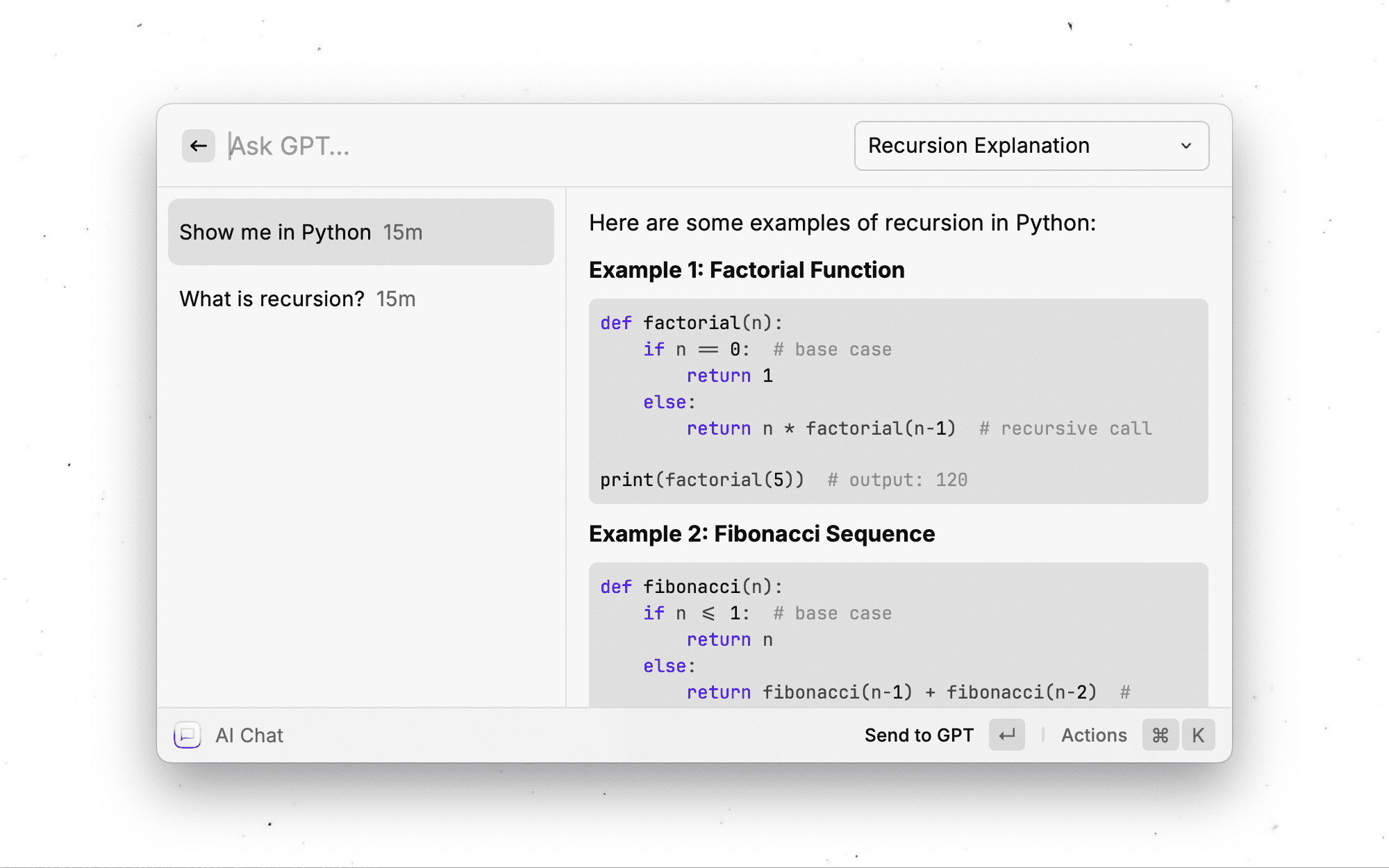

O Raycast-G4F (GPT4Free) é um poderoso Raycast A extensão oferece aos usuários acesso gratuito a uma ampla variedade de modelos avançados de IA, incluindo GPT-4 e Llama-3. A extensão não só fornece streaming de diálogo em tempo real, mas também oferece suporte a várias funções, como pesquisa na Web, upload de arquivos, geração de imagens, etc. Em especial, ela oferece suporte a mais de 40 modelos e provedores de IA diferentes. Em especial, ela oferece suporte a mais de 40 modelos e provedores de IA diferentes, permitindo que os usuários alternem livremente de acordo com suas necessidades. A extensão é totalmente de código aberto e se concentra na proteção da privacidade do usuário, com todos os dados armazenados localmente no dispositivo. Embora não esteja disponível no momento na loja oficial da Raycast, ela pode ser usada por meio de uma instalação simples do código-fonte e fornece atualizações automáticas para garantir que a versão mais recente esteja sempre disponível.

No momento, o Raycast-G4F está disponível apenas para macOS, com uma versão para Windows em desenvolvimento. Os usuários podem instalar a extensão a partir do código-fonte com etapas simples de instalação e aproveitar seus recursos avançados de IA.

Lista de funções

- Funcionalidade de transmissão de diálogo em tempo real com suporte para carregamento de mensagens instantâneas

- 18 comandos diferentes para vários cenários de uso

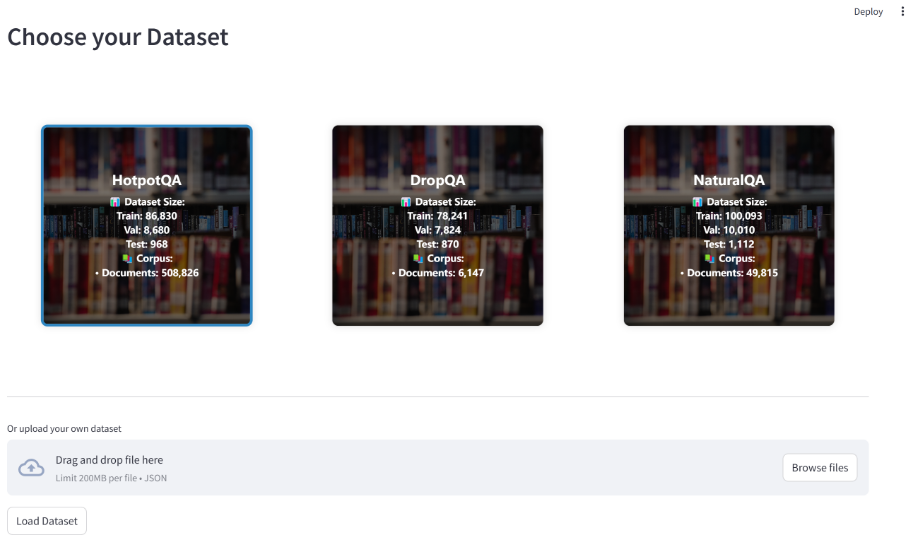

- Suporta acesso a mais de 40 modelos e provedores de IA

- Recursos inteligentes de salvamento de registros de bate-papo e nomeação de sessões

- Recurso integrado de pesquisa na Web para obter informações atualizadas

- Suporta uploads de arquivos de imagem, vídeo, áudio e texto

- Função de geração de imagem de IA

- Suporte para a criação de comandos de IA personalizados

- Função de intérprete de código (Beta)

- A função de armazenamento persistente garante a retenção segura dos dados

Usando a Ajuda

1. preparação para a pré-instalação

- Certifique-se de que o aplicativo Raycast esteja instalado (atualmente compatível apenas com o macOS)

- Instale o Node.js (versão recomendada v20.18.1 ou superior)

2. etapas de instalação

- Faça o download da versão mais recente do código-fonte do GitHub ou clone o repositório

- Abra o terminal e vá para a pasta de download

- estar em movimento

npm ci --productionInstalação de dependências - (Opcional) Executar

pip3 install -r requirements.txtInstalação das dependências do Python - estar em movimento

npm run devCriação e importação de extensões

3. modalidades de atualização

Atualização automática:

- Use o comando interno da extensão "Check for Updates".

- Ative a opção "Verificar automaticamente se há atualizações" em Preferências (ativada por padrão)

Atualização manual:

Execute os seguintes comandos em ordem:

git pullnpm ci --productionnpm run dev

4. descrição do uso das principais funções

Recurso de bate-papo com IA

- Suporte para fluxos de diálogo em tempo real

- Salvar automaticamente o histórico de bate-papo

- Nomeação inteligente de sessões

- A pesquisa na Web pode ser ativada em uma única sessão

Função de pesquisa na Web

São oferecidos quatro modos:

- Desativar (padrão)

- Modo automático: ativado automaticamente apenas no bate-papo com IA

- Modo equilibrado: ativado nos comandos de IA e no bate-papo

- Sempre ativado: a pesquisa na Web é usada para todas as consultas

Capacidade de processamento de documentos

- Suporta o upload de arquivos de texto (.txt, .md, etc.).

- Alguns provedores oferecem suporte a imagens, vídeos e arquivos de áudio

- Suporte ao comando "Ask Screen Content" (Perguntar conteúdo da tela)

Personalização

- Criação de comandos de IA personalizados

- Configuração de predefinições de IA

- Configuração do armazenamento persistente

- APIs personalizadas compatíveis com a OpenAI

5. configuração avançada de recursos

Configurações da API do Google Gemini

- Visite https://aistudio.google.com/app/apikey

- Faça login na Conta do Google

- Criação de uma chave de API

- Preencha a chave em Preferências estendidas

Interpretador de código (beta)

- Suporte para execução local de código Python

- Somente modelos específicos com capacidade de chamada de função são suportados

- As restrições de segurança foram configuradas para garantir a execução segura do código

Modelos gratuitos e provedores de serviços oferecidos

| provedor (empresa) | modelagem | funcionalidade | estado das coisas | tempo | Avaliações e notas estendidas do autor |

|---|---|---|---|---|---|

| Nexra | gpt-4o (padrão) | ▶️ | Ativo | muito rápido | 8,5/10, o modelo com melhor desempenho. |

| Nexra | gpt-4-32k | Ativo | moderado | 6,5/10, sem suporte a streaming, mas, fora isso, é um ótimo modelo. | |

| Nexra | chatgpt | ▶️ | Desconhecido | muito rápido | 7.5/10 |

| Nexra | Bing | ▶️ | Ativo | moderado | 8/10, baseado no GPT-4 e com recurso de pesquisa na Web. |

| Nexra | llama-3.1 | ▶️ | Ativo | afiado (de facas ou inteligência) | 7/10 |

| Nexra | gemini-1.0-pro | ▶️ | Ativo | afiado (de facas ou inteligência) | 6.5/10 |

| DeepInfra | meta-llama-3.3-70b | ▶️ | Ativo | afiado (de facas ou inteligência) | 8,5/10, o modelo mais recente com tamanhos de contexto grandes. |

| DeepInfra | meta-llama-3.2-90b-vision | ▶️ 📄¹ | Ativo | afiado (de facas ou inteligência) | 8/10, o modelo mais recente com recursos visuais. |

| DeepInfra | meta-llama-3.2-11b-vision | ▶️ 📄¹ | Ativo | muito rápido | 7.5/10 |

| DeepInfra | meta-llama-3.1-405b | ▶️ | Inativo | moderado | 8,5/10, modelo aberto de última geração para tarefas complexas. |

| DeepInfra | meta-llama-3.1-70b | ▶️ | Ativo | afiado (de facas ou inteligência) | 8/10 |

| DeepInfra | meta-llama-3.1-8b | ▶️ | Ativo | muito rápido | 7.5/10 |

| DeepInfra | llama-3.1-nemotron-70b | ▶️ | Ativo | afiado (de facas ou inteligência) | 8/10 |

| DeepInfra | WizardLM-2-8x22B | ▶️ | Ativo | moderado | 7/10 |

| DeepInfra | DeepSeek-V2.5 | ▶️ | Ativo | afiado (de facas ou inteligência) | 7.5/10 |

| DeepInfra | Qwen2.5-72B | ▶️ | Ativo | moderado | 7.5/10 |

| DeepInfra | Qwen2.5-Coder-32B | ▶️ | Ativo | afiado (de facas ou inteligência) | 7/10 |

| DeepInfra | QwQ-32B-Preview | ▶️ | Ativo | muito rápido | 7.5/10 |

| Blackbox | modelo personalizado | ▶️ | Ativo | afiado (de facas ou inteligência) | 7,5/10 com geração muito rápida com recursos integrados de pesquisa na Web, mas otimizado para codificação. |

| Blackbox | llama-3.1-405b | ▶️ | Ativo | afiado (de facas ou inteligência) | 8.5/10 |

| Blackbox | llama-3.1-70b | ▶️ | Ativo | muito rápido | 8/10 |

| Blackbox | gemini-1.5-flash | ▶️ | Ativo | Rápido como um relâmpago | 7.5/10 |

| Blackbox | qwq-32b-preview | ▶️ | Ativo | Rápido como um relâmpago | 6.5/10 |

| Blackbox | gpt-4o | ▶️ | Ativo | muito rápido | 7.5/10 |

| Blackbox | claude-3.5-sonnet | ▶️ | Ativo | afiado (de facas ou inteligência) | 8.5/10 |

| Blackbox | gemini-pro | ▶️ | Ativo | afiado (de facas ou inteligência) | 8/10 |

| DuckDuckGo | gpt-4o-mini | ▶️ | Ativo | Rápido como um relâmpago | 8/10, modelo autêntico GPT-4o-mini com forte proteção de privacidade. |

| DuckDuckGo | claude-3-haiku | ▶️️ | Ativo | Rápido como um relâmpago | 7/10 |

| DuckDuckGo | meta-llama-3.1-70b | ▶️️ | Ativo | muito rápido | 7.5/10 |

| DuckDuckGo | mixtral-8x7b | ▶️️ | Ativo | Rápido como um relâmpago | 7.5/10 |

| BestIM | gpt-4o-mini | ▶️ | Inativo | Rápido como um relâmpago | 8.5/10 |

| Rochas | claude-3.5-sonnet | ▶️ | Ativo | afiado (de facas ou inteligência) | 8.5/10 |

| Rochas | claude-3-opus | ▶️ | Ativo | afiado (de facas ou inteligência) | 8/10 |

| Rochas | gpt-4o | ▶️ | Ativo | afiado (de facas ou inteligência) | 7.5/10 |

| Rochas | gpt-4 | ▶️ | Ativo | afiado (de facas ou inteligência) | 7.5/10 |

| Rochas | llama-3.1-405b | ▶️ | Ativo | afiado (de facas ou inteligência) | 7.5/10 |

| Rochas | llama-3.1-70b | ▶️ | Ativo | muito rápido | 7/10 |

| ChatgptFree | gpt-4o-mini | ▶️ | Ativo | Rápido como um relâmpago | 8.5/10 |

| AI4Chat | gpt-4 | Ativo | muito rápido | 7.5/10 | |

| DarkAI | gpt-4o | ▶️ | Ativo | muito rápido | 8/10 |

| Mhystical | gpt-4-32k | Ativo | muito rápido | 6.5/10 | |

| PizzaGPT | gpt-4o-mini | Ativo | Rápido como um relâmpago | 7.5/10 | |

| Meta AI | meta-llama-3.1 | ▶️ | Ativo | moderado | 7/10, o modelo mais recente com acesso à Internet. |

| Replicar | mixtral-8x7b | ▶️ | Ativo | moderado | ?/10 |

| Replicar | meta-llama-3.1-405b | ▶️ | Ativo | moderado | ?/10 |

| Replicar | meta-llama-3-70b | ▶️ | Ativo | moderado | ?/10 |

| Replicar | meta-llama-3-8b | ▶️ | Ativo | afiado (de facas ou inteligência) | ?/10 |

| Phind | Phind Instant | ▶️ | Ativo | Rápido como um relâmpago | 8/10 |

| Empresa de Internet Google Gêmeos | automático (gemini-1.5-pro, gemini-1.5-flash) | ▶️ 📄 | Ativo | muito rápido | 9/10, modelo genérico muito bom, mas requer uma chave de API. (Ela égratuito(Consulte a seção a seguir) |

| Google Gemini (Experimental) | automático (muda com frequência) | ▶️ 📄 | Ativo | muito rápido | - |

| Google Gemini (Pensamento) | automático (muda com frequência) | ▶️ 📄 | Ativo | muito rápido | - |

| API personalizada compatível com OpenAI | - | ▶️ | Ativo | - | Permite que você use qualquer API personalizada compatível com a OpenAI. |

▶️ - Suporte a streaming.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...