Qwen2.5-Max baseado na arquitetura MoE supera completamente o desempenho do DeepSeek V3

Visão geral do modelo

A equipe da Qwen lançou recentemente o modelo Qwen2.5-Max, que emprega mais de 20 trilhões de tokens de dados de pré-treinamento e um esquema de pós-treinamento refinado, e fez avanços na aplicação de aumento de escala da arquitetura MoE. progresso. O modelo já está disponível emInterface da APItalvezQwen Chatplataforma para a experiência.

Características técnicas

1. inovações na arquitetura do modelo

- Otimização de sistema especialista híbridoAlocação eficiente de recursos de computação por meio de mecanismos de roteamento dinâmico

- Escalabilidade multimodalSuporte a vários tipos de entradas e saídas, como texto, dados estruturados, etc.

- aprimoramento da contextualizaçãoEntrada máxima: 30.720 tokens, pode gerar texto contínuo de até 8.192 tokens.

2) Matriz funcional principal

| dimensão funcional | Indicadores técnicos |

|---|---|

| Suporte a vários idiomas | Cobertura de 29 idiomas (incluindo chinês, inglês, francês, espanhol, etc.) |

| recursos computacionais | Operações matemáticas complexas e geração de código |

| Processamento estruturado | Geração e análise de dados JSON/tabela |

| compreensão contextual | Geração de concatenação de texto longo de 8K tokens |

| Adequação do aplicativo | Sistemas de diálogo/análise de dados/raciocínio baseado em conhecimento |

Avaliação de desempenho

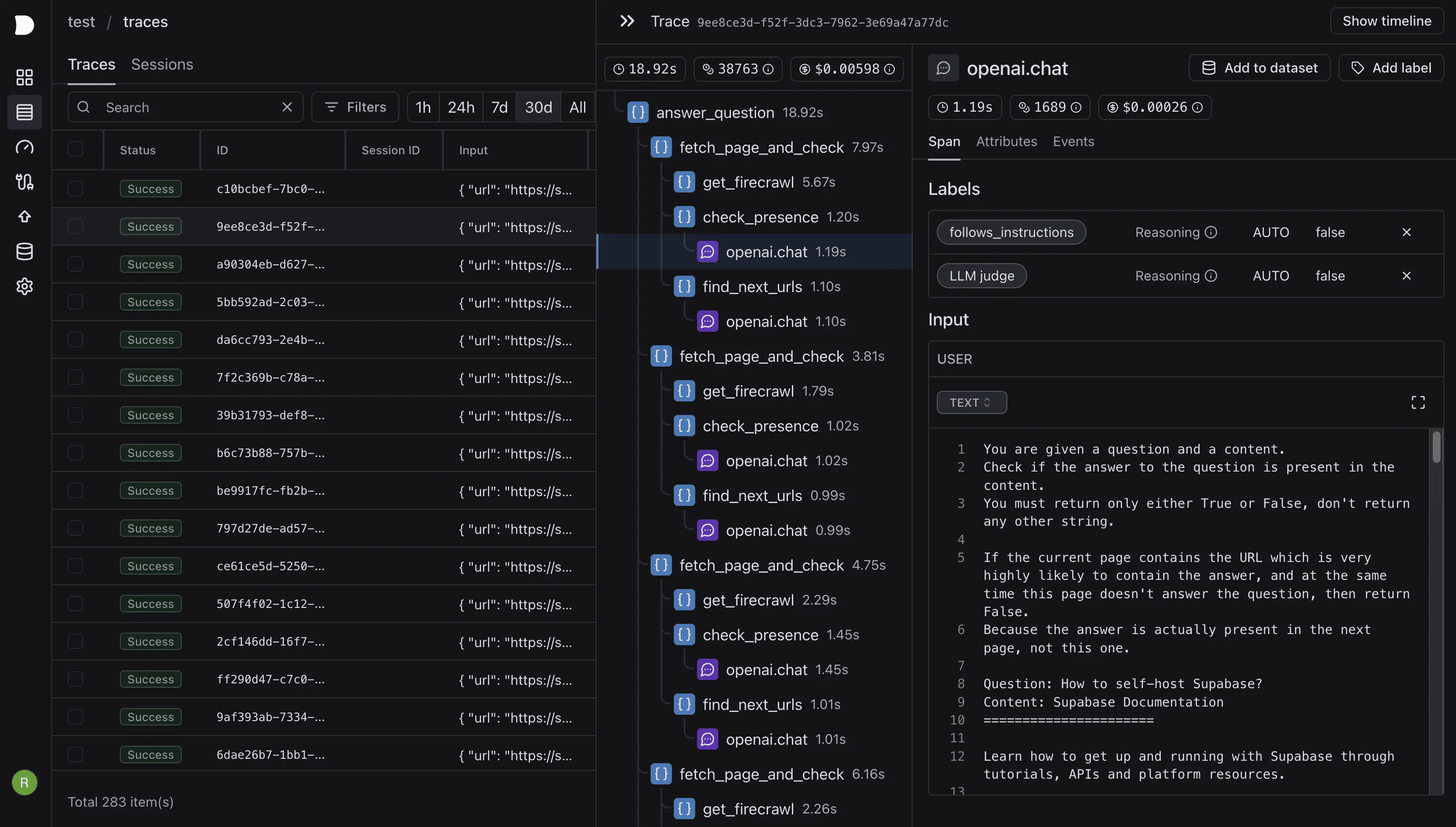

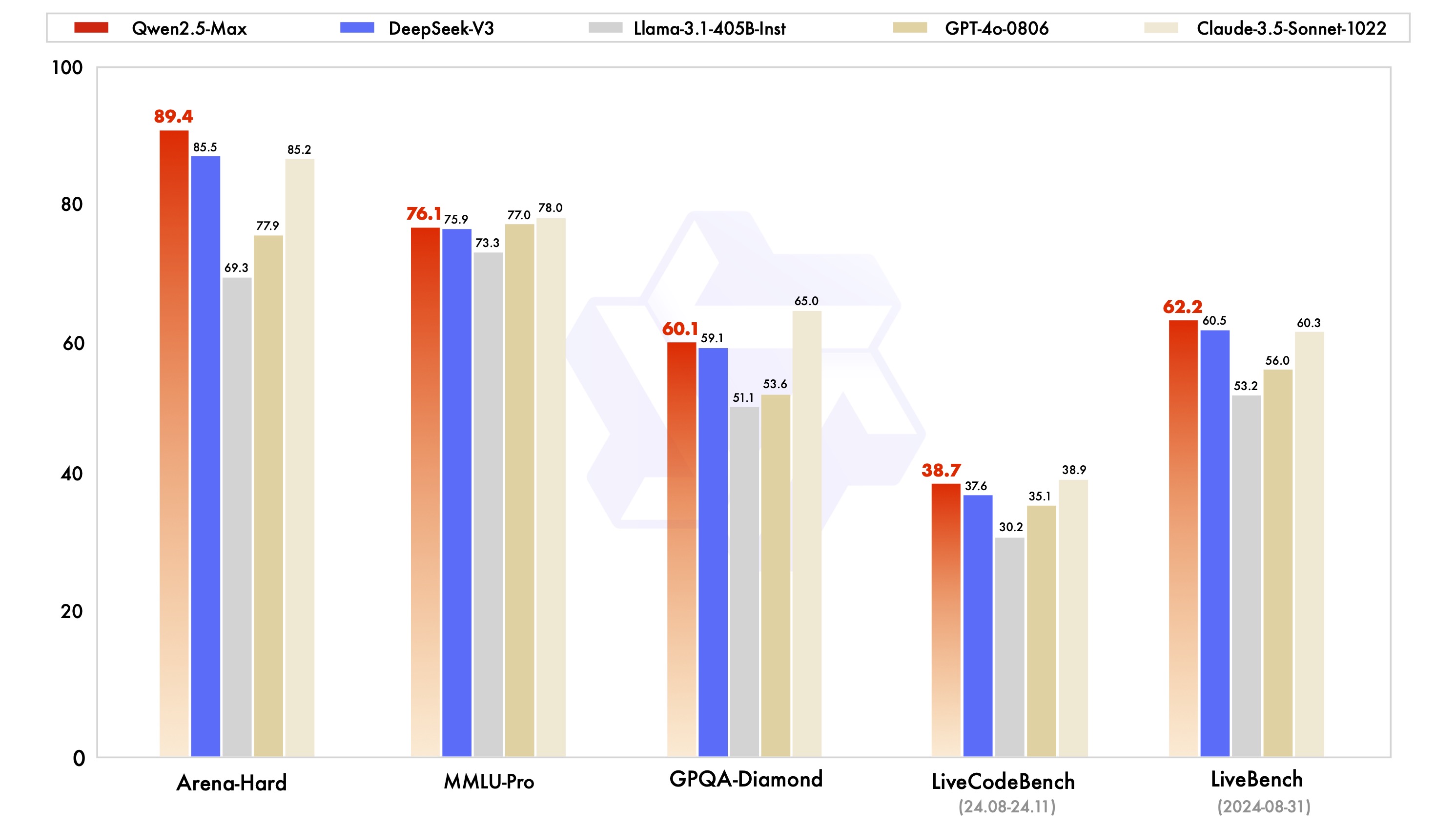

Comparação de modelos de comando

O Qwen2.5-Max mostra uma competitividade significativa em testes de benchmark, como o MMLU-Pro (teste de conhecimento universitário), o LiveCodeBench (avaliação da capacidade de programação) e o Arena-Hard (simulação de preferência humana):

Os dados de teste mostram que o modelo supera o DeepSeek V3 nas dimensões de capacidade de programação (LiveCodeBench) e raciocínio integrado (LiveBench), e atinge o nível superior no teste de raciocínio de alta ordem GPQA-Diamond.

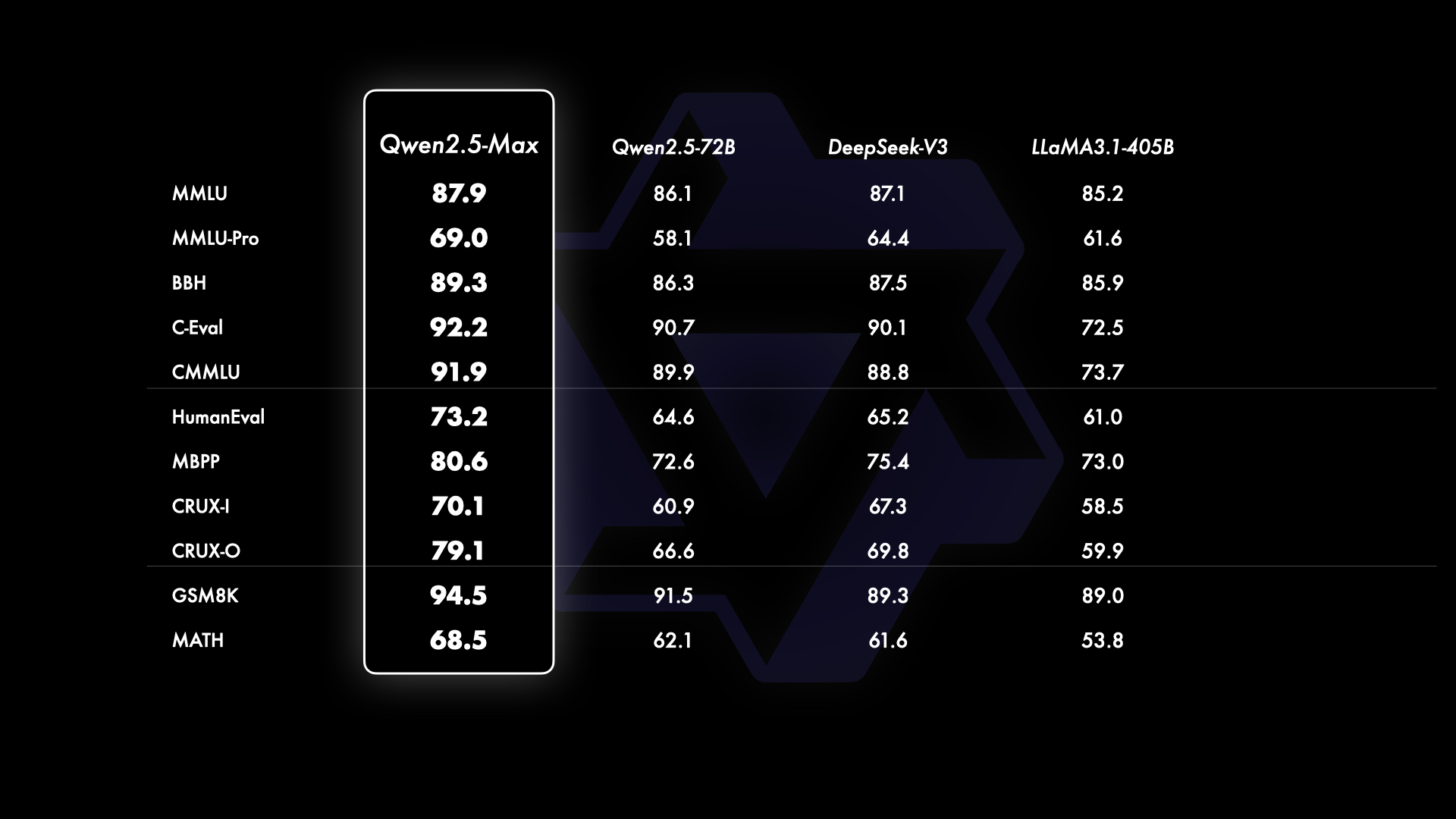

Comparação do modelo básico

Em comparação com os principais modelos de código aberto, o Qwen2.5-Max demonstra vantagens técnicas no nível dos recursos básicos:

Comparando o Llama-3.1 com uma escala de parâmetros de 405B e o Qwen2.5-72B com parâmetros de 720B, o Qwen2.5-Max mantém a liderança na maioria dos itens de teste, validando a eficácia da arquitetura MoE no dimensionamento do modelo.

Acesso e uso

1. acesso à API da nuvem

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscale.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role':'system', 'content':'设定AI助手角色'},

{'role':'user', 'content':'输入查询内容'}

]

)

2. experiência interativa

- entrevistasEspaço de demonstração de rosto abraçado

- Iniciar o botão Run para carregar o modelo

- Interação em tempo real por meio de caixa de entrada de texto

3. implantação corporativa

- registroConta Aliyun

- Lançamento de uma grande plataforma de serviços modelo

- Criar chaves de API para integração do sistema

Direção da evolução tecnológica

A versão atual é continuamente otimizada nas seguintes áreas:

- Estratégias de aprimoramento da qualidade dos dados após o treinamento

- Colaboração de vários especialistas para otimização da eficiência

- Aceleração do raciocínio com baixo consumo de recursos

- Desenvolvimento de interface estendida multimodal

perspectivas futuras

O aprimoramento contínuo da escala de dados e da escala de parâmetros do modelo pode melhorar efetivamente o nível de inteligência do modelo. Em seguida, continuaremos a explorar, além do escalonamento do pré-treinamento, investiremos vigorosamente no escalonamento do aprendizado por reforço, na esperança de alcançar uma inteligência além dos seres humanos e levar a IA a explorar o reino desconhecido.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...