Lançado o novo modelo multimodal Qwen2.5-VL-32B-Instruct com desempenho de Super 72B!

Recentemente, o tão aguardado Qwen2.5-VL O Qwen2.5-VL-32B-Instruct, um novo membro da série Qwen2.5-VL, foi lançado. Esse modelo de linguagem visual multimodal em escala de 32 bilhões de parâmetros herda as vantagens da série Qwen2.5-VL e é otimizado ainda mais pela aprendizagem por reforço e outras técnicas para obter melhorias significativas de desempenho, especialmente em raciocínio complexo e experiência do usuário.

Entende-se que, no final de janeiro deste ano, a equipe da Qwen lançou a série de modelos Qwen2.5-VL e rapidamente ganhou atenção generalizada e feedback positivo da comunidade. Para atender às expectativas da comunidade e continuar a promover o desenvolvimento da tecnologia de modelagem multimodal, a equipe passou vários meses aprimorando cuidadosamente a série Qwen2.5-VL e, finalmente, lançou este novo modelo Qwen2.5-VL-32B-Instruct, que é de código aberto usando o protocolo Apache 2.0, com o objetivo de beneficiar uma gama maior de desenvolvedores e pesquisadores.

Um salto no desempenho, com uma série de métricas que superam as das gerações anteriores e modelos similares

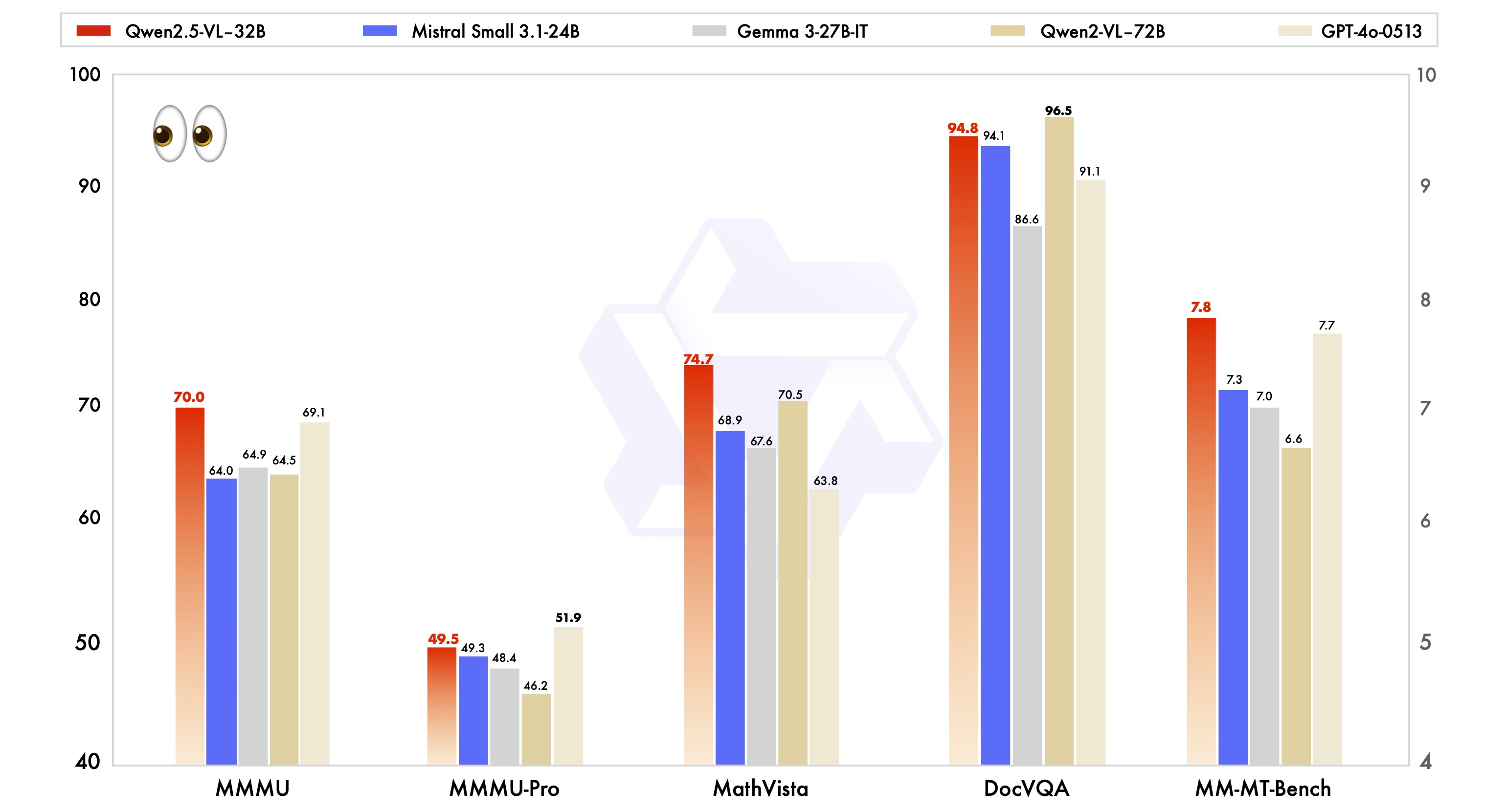

Os dados oficiais mostram que o modelo Qwen2.5-VL-32B-Instruct alcança melhorias significativas em vários indicadores-chave de desempenho em comparação com a série Qwen2.5-VL lançada anteriormente.

Em primeiro lugar, em termos de preferências subjetivas do usuário, o novo modelo, ao ajustar o estilo de saída, torna as respostas mais detalhadas e em um formato mais padronizado, o que está mais de acordo com os hábitos e preferências de leitura humanos. Isso significa que os usuários terão uma experiência de interação mais suave e natural durante o uso.

Em segundo lugar, em termos de capacidade de raciocínio matemático, o modelo Qwen2.5-VL-32B-Instruct teve um progresso significativo na precisão da solução de problemas matemáticos complexos. Isso indica que o modelo foi efetivamente aprimorado em termos de raciocínio lógico e capacidade de computação, e é mais capaz de lidar com tarefas que exigem pensamento aprofundado e computação precisa.

Além disso, o modelo Qwen2.5-VL-32B-Instruct mostra maior força na compreensão e no raciocínio de imagens de granulação fina. Seja na precisão da análise de imagens, na amplitude do reconhecimento de conteúdo ou na profundidade da inferência lógica visual, o novo modelo apresenta um nível mais alto e é capaz de analisar as informações da imagem com mais precisão e meticulosidade.

Para demonstrar as vantagens de desempenho do modelo Qwen2.5-VL-32B-Instruct, ele também foi testado em comparação com modelos líderes do setor do mesmo tamanho, incluindo Mistral-Small-3.1-24B e Gemma-3-27B-IT. Os resultados mostram que o modelo Qwen2.5-VL-32B-Instruct demonstra vantagens óbvias em muitas tarefas multimodais, e alguns dos índices superam até mesmo o modelo Qwen2-VL-72B-Instruct, de maior escala. Em particular, o excelente desempenho do modelo Qwen2.5-VL-32B-Instruct é impressionante em tarefas como MMMU, MMMU-Pro e MathVista, que enfatizam o raciocínio complexo em várias etapas. No benchmark MM-MT-Bench, que se concentra na experiência subjetiva do usuário, o modelo também fez um progresso significativo em comparação com seu antecessor, o Qwen2-VL-72B-Instruct.

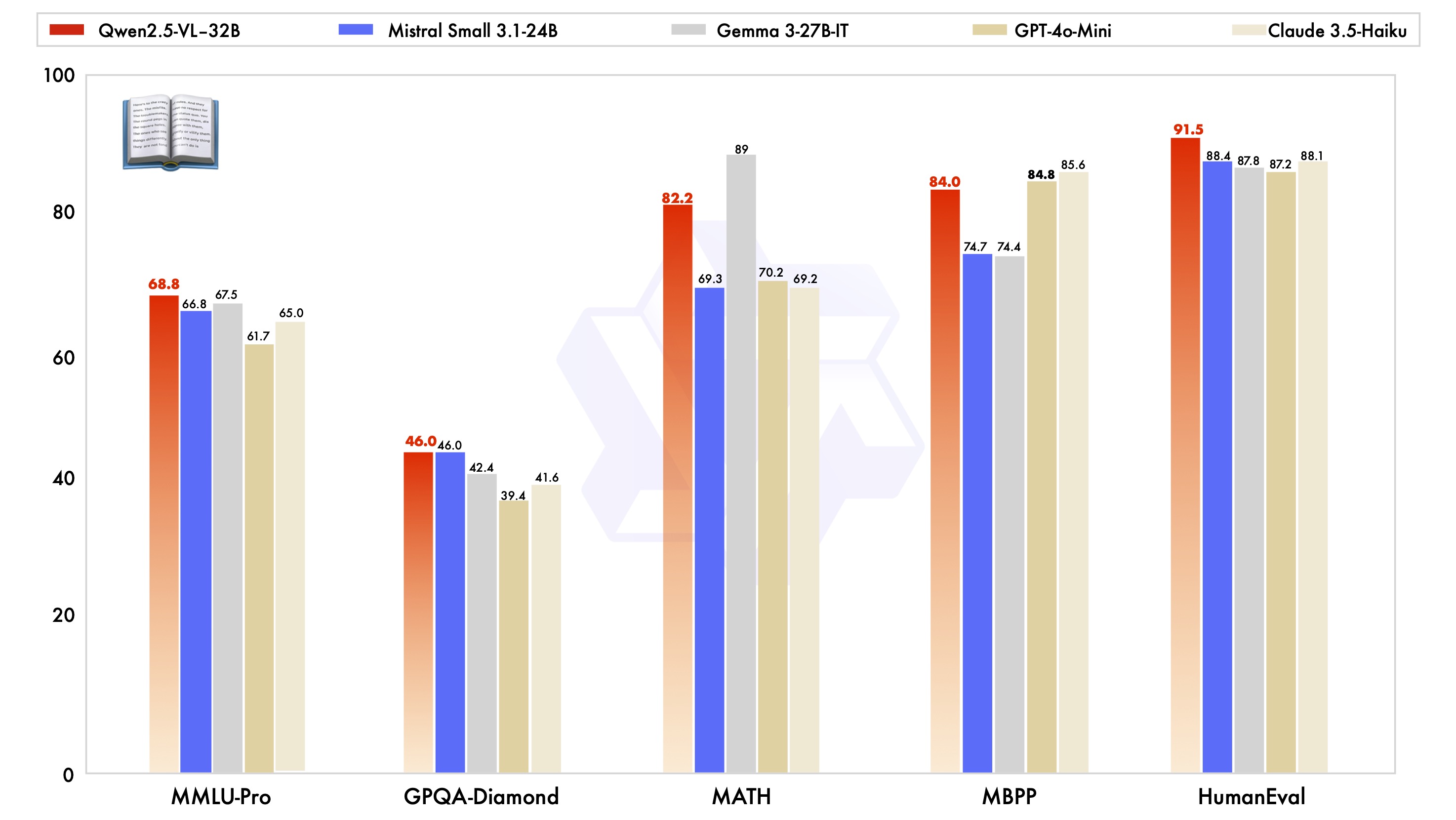

Vale a pena mencionar que o modelo Qwen2.5-VL-32B-Instruct não só tem um bom desempenho em termos de capacidade visual, mas também atinge o nível ideal do mesmo modelo de escala em termos de capacidade de texto simples.

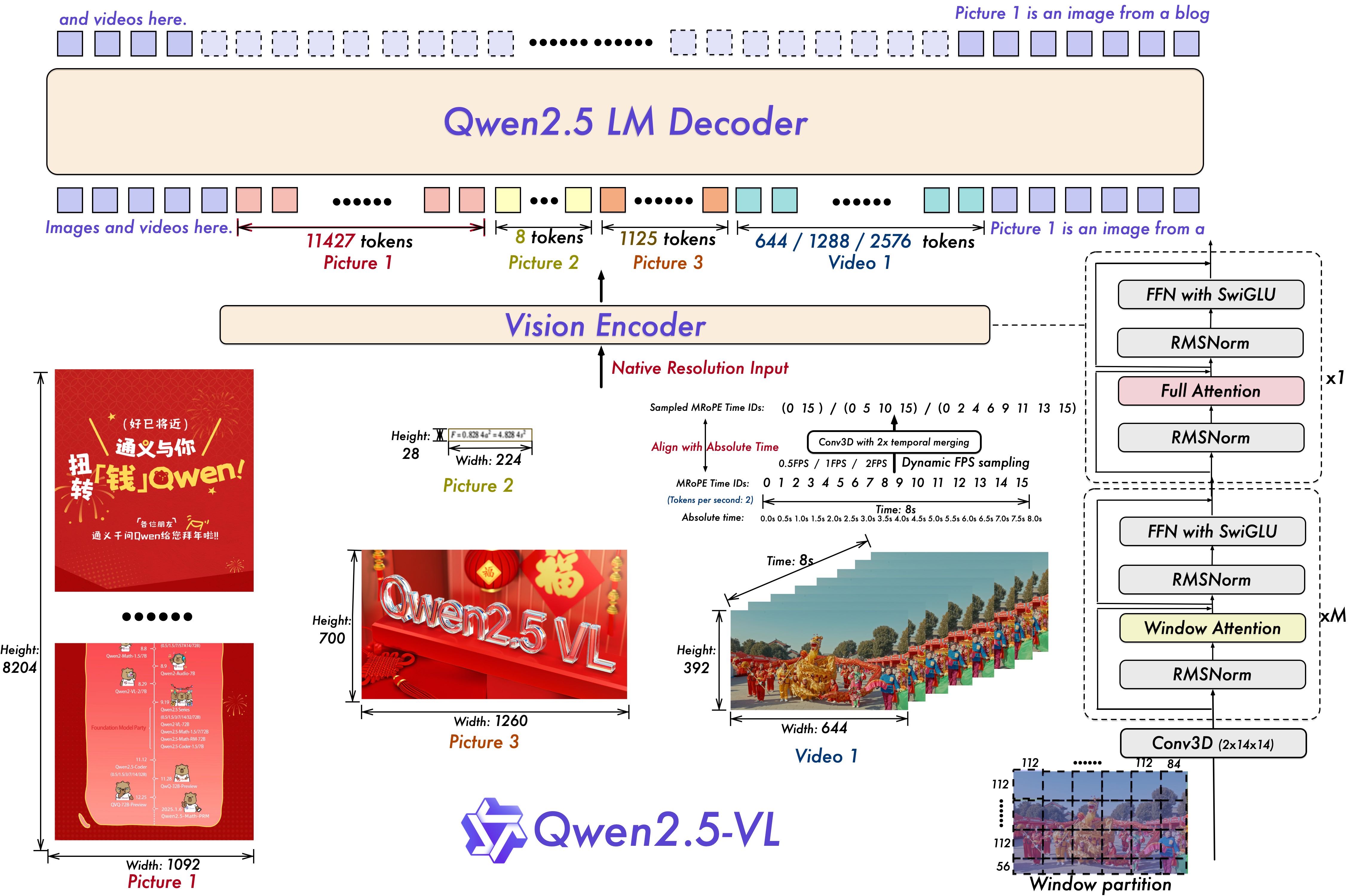

Destaques tecnológicos: resolução dinâmica, codificador visual eficiente

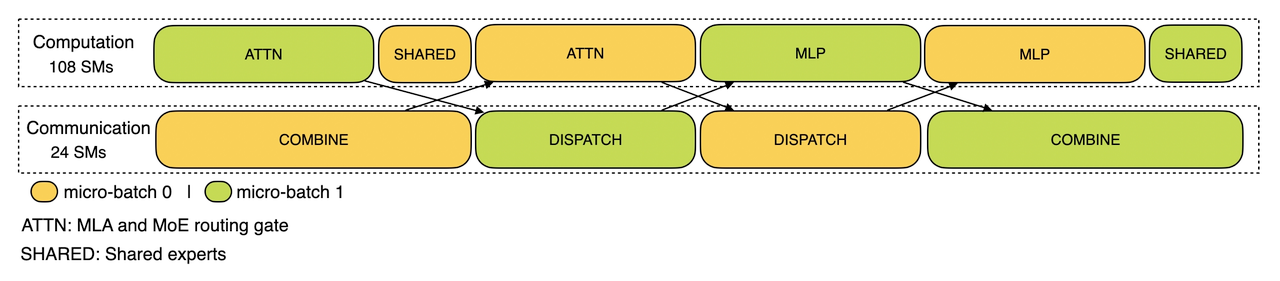

A série de modelos Qwen2.5-VL também apresenta uma série de inovações e atualizações na arquitetura técnica.

Para a compreensão de vídeo, o modelo usa técnicas de treinamento de resolução dinâmica e taxa de quadros, o que permite que o modelo compreenda o conteúdo de vídeo com diferentes taxas de amostragem por meio da introdução da amostragem dinâmica de FPS. Enquanto isso, a mRoPE (Multiple Relative Position Encoding) é atualizada na dimensão temporal e combinada com IDs e alinhamento de tempo absoluto para permitir que o modelo aprenda informações sobre séries temporais e velocidade, o que lhe dá a capacidade de capturar momentos importantes no vídeo.

Para o codificador de visão, a série de modelos Qwen2.5-VL usa um codificador de visão simplificado e eficiente, que pode ser usado no codificador ViT (Vision). Transformador) introduz estrategicamente o mecanismo de atenção janelada no Qwen2.5 LLM e o combina com otimizações como SwiGLU e RMSNorm para tornar a arquitetura ViT mais consistente com a estrutura do Qwen2.5 LLM, melhorando efetivamente a velocidade de treinamento e inferência do modelo.

Inclusão de código aberto para inovação de aplicativos multimodais

O lançamento de código aberto do modelo Qwen2.5-VL-32B-Instruct sem dúvida injetará nova vitalidade no campo da linguagem visual multimodal. Com base nesse modelo, os desenvolvedores e pesquisadores podem realizar pesquisas mais aprofundadas e desenvolver aplicativos mais abrangentes, como compreensão de conteúdo de imagem e vídeo, agente inteligente, geração de conteúdo multimodal, etc.

O modelo Qwen2.5-VL-32B-Instruct já está disponível no Hugging Face Transformers e no ModelScope, com exemplos detalhados de código e instruções para que os usuários possam começar rapidamente, e a equipe da Qwen indicou que continuará a se concentrar no feedback da comunidade para otimizar e melhorar a série Qwen2.5-VL. Os modelos da série Qwen2.5-VL continuarão a monitorar o feedback da comunidade, otimizá-los e melhorá-los, além de contribuir para o desenvolvimento da tecnologia multimodal.

Para aqueles que desejam experimentar o modelo Qwen2.5-VL-32B-Instruct, um início rápido pode ser feito da seguinte maneira:

Configuração do ambiente

Recomenda-se que os usuários criem a biblioteca de transformadores a partir da fonte para garantir a compatibilidade:

pip install git+https://github.com/huggingface/transformers accelerateExemplo de código de início rápido (usando 🤗 Transformers).

from transformers import Qwen2_5_VLForConditionalGeneration, AutoTokenizer, AutoProcessor

from qwen_vl_utils import process_vision_info

# 加载模型

model = Qwen2_5_VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen2.5-VL-32B-Instruct", torch_dtype="auto", device_map="auto"

)

# 加载 processor

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-32B-Instruct")

# 构建 messages

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "https://qianwen-res.oss-cn-beijing.aliyuncs.com/Qwen-VL/assets/demo.jpeg",

},

{"type": "text", "text": "Describe this image."},

],

}

]

# 预处理

text = processor.apply_chat_template(

messages, tokenize=False, add_generation_prompt=True

)

image_inputs, video_inputs = process_vision_info(messages)

inputs = processor(

text=[text],

images=image_inputs,

videos=video_inputs,

padding=True,

return_tensors="pt",

)

inputs = inputs.to("cuda")

# 模型推理

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

O lançamento do modelo Qwen2.5-VL-32B-Instruct traz, sem dúvida, novos avanços no campo dos modelos de linguagem visual multimodal, e espera-se que suas vantagens em termos de desempenho, tecnologia e código aberto acelerem a popularidade e a aplicação da tecnologia multimodal, o que merece a atenção contínua do setor.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...