par_scrape: uma ferramenta de rastreamento para extração inteligente de dados da Web

Introdução geral

O par_scrape é um rastreador da Web de código aberto baseado em Python, lançado no GitHub pelo desenvolvedor Paul Robello, projetado para ajudar os usuários a extrair dados de forma inteligente das páginas da Web. Ele integra duas poderosas tecnologias de automação de navegador, Selenium e Playwright, e as combina com recursos de processamento de IA para dar suporte ao rastreamento de dados de páginas estáticas simples a sites dinâmicos complexos. Seja para extrair preços, títulos ou outras informações estruturadas, o par_scrape conclui rapidamente a tarefa especificando campos e produz os resultados como Markdown, JSON ou CSV. Projeto para desenvolvedores, analistas de dados ou usuários que desejam automatizar a coleta de informações na Web, fácil de instalar e com recursos flexíveis, popular na comunidade de código aberto.

Lista de funções

- Extração inteligente de dadosAnálise de conteúdo da Web por meio de modelos de IA, como OpenAI ou Anthropic, para extrair com precisão os campos especificados pelo usuário.

- Suporte duplo para esteirasO site é compatível com as tecnologias Selenium e Playwright, que podem ser adaptadas a diferentes arquiteturas de sites.

- Vários formatos de saídaOs resultados da captura podem ser exportados para Markdown, JSON, CSV ou Excel para facilitar o processamento posterior.

- Captura de campos personalizadosOs usuários podem especificar os campos a serem extraídos, como título, descrição, preço, etc., para atender a necessidades personalizadas.

- captura paralelaSuporte a rastreamento multithread para aumentar a eficiência da coleta de dados em grande escala.

- Mecanismo de esperaForneça uma variedade de métodos de espera de carregamento de página (por exemplo, pausa, espera de seletor) para garantir o sucesso do rastreamento de conteúdo dinâmico.

- Seleção de modelos de IASuporte a vários provedores de IA (por exemplo, OpenAI, Anthropic, XAI) para adaptação flexível a diferentes tarefas.

- Otimização de cacheFunção de cache de dicas incorporada para reduzir o custo de solicitações repetidas e aumentar a eficiência.

Usando a Ajuda

Processo de instalação

Para usar o par_scrape, é necessário concluir as etapas de instalação a seguir para garantir que seu ambiente esteja bem preparado. A seguir, um guia de instalação detalhado:

1. preparação ambiental

- Versão PythonCertifique-se de que o Python 3.11 ou posterior esteja instalado em seu sistema usando o comando

python --versionVerificar. - Ferramentas GitUsado para clonar código do GitHub; se não estiver instalado, pode ser acessado por meio do

sudo apt install git(Linux) ou no site oficial para fazer o download e instalar. - Ferramentas UVRecomenda-se usar o UV para gerenciar as dependências; o comando de instalação é:

- Linux/Mac:

curl -LsSf https://astral.sh/uv/install.sh | sh - Windows:

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

- Linux/Mac:

2. clonagem de projetos

Clone o projeto par_scrape localmente digitando o seguinte comando no terminal:

git clone https://github.com/paulrobello/par_scrape.git

cd par_scrape

3. instalação de dependências

Use o UV para instalar as dependências do projeto:

uv sync

Ou instale diretamente do PyPI:

uv tool install par_scrape

# 或使用 pipx

pipx install par_scrape

4. instalação do dramaturgo (opcional)

Se você escolher o Playwright como rastreador, será necessário instalar e configurar o navegador adicionalmente:

uv tool install playwright

playwright install chromium

5. configurar a chave da API

O par_scrape é compatível com vários provedores de IA; você precisa configurar a chave correspondente na variável de ambiente. Editar ~/.par_scrape.env adicione o seguinte (selecione conforme necessário):

OPENAI_API_KEY=your_openai_key

ANTHROPIC_API_KEY=your_anthropic_key

XAI_API_KEY=your_xai_key

Ou defina a variável de ambiente antes de executar o comando:

export OPENAI_API_KEY=your_openai_key

Uso

Quando a instalação estiver concluída, você poderá executar o par_scrape na linha de comando:

Exemplo de uso básico

Suponha que você queira extrair o título, a descrição e o preço da página de preços da OpenAI:

par_scrape --url "https://openai.com/api/pricing/" -f "Title" -f "Description" -f "Price" --model gpt-4o-mini --display-output md

--urlEndereço da página da Web de destino: O endereço da página da Web de destino.-fCampo de extração: Especifique o campo de extração, que pode ser usado várias vezes.--modelSelecione o modelo de IA (por exemplo, gpt-4o-mini).--display-outputFormato de saída (md, json, csv, etc.).

Operação da função em destaque

- Troca de ferramentas de rastreamento

O Playwright é usado por padrão; se quiser usar o Selenium, você pode adicionar parâmetros:par_scrape --url "https://example.com" -f "Title" --scraper selenium - captura paralela

Defina o número máximo de solicitações paralelas para aumentar a eficiência:par_scrape --url "https://example.com" -f "Data" --scrape-max-parallel 5 - Espera de página dinâmica

Para conteúdo carregado dinamicamente, é possível definir tipos e seletores de espera:par_scrape --url "https://example.com" -f "Content" --wait-type selector --wait-selector ".dynamic-content"Os tipos de espera suportados incluem

noneepauseesleepeidleeselectorresponder cantandotext. - Caminho de saída personalizado

Salva os resultados na pasta especificada:par_scrape --url "https://example.com" -f "Title" --output-folder ./my_data

Detalhes do processo de operação

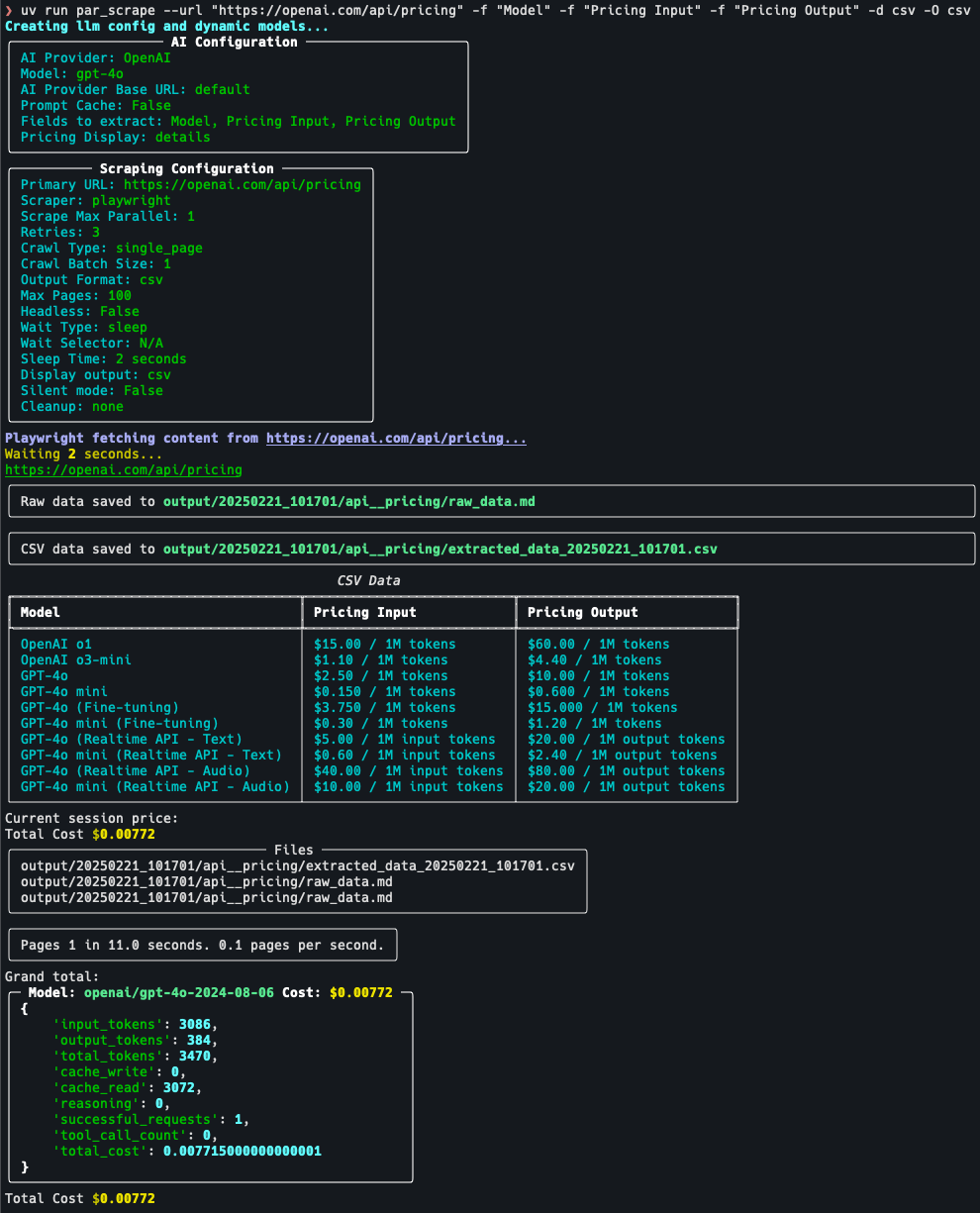

Veja a página de preços de rastreamento, por exemplo:

- definição de metasAcesse https://openai.com/api/pricing/ e confirme que você precisa extrair o "Model" (Modelo), "Pricing Input" (Entrada de preços) e " Pricing Output".

- Executar comando::

par_scrape --url "https://openai.com/api/pricing/" -f "Model" -f "Pricing Input" -f "Pricing Output" --model gpt-4o-mini --display-output json - Exibir resultadosDepois que o comando é executado, o terminal exibe os dados no formato JSON ou os salva no arquivo de saída padrão.

- Parâmetros de ajusteSe os dados estiverem incompletos, tente adicionar

--retries 5(número de novas tentativas) ou ajustes--sleep-time 5(Tempo de espera).

advertência

- Chave da APIVerifique se a chave é válida, caso contrário, a função de extração de IA não estará disponível.

- Restrições do siteAlguns sites podem ter um mecanismo anti rastreamento e é recomendável usar a opção

--headless(modo sem cabeça) ou para ajustar a frequência de agarramento. - Uso do cacheSe você rastrear a mesma página várias vezes, poderá ativar a opção

--prompt-cacheRedução de custos.

Com as etapas acima, os usuários podem começar a usar rapidamente o par_scrape e concluir facilmente as tarefas de extração de dados de páginas da Web.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...