A OpenAI começou a fornecer Prompt Caching para modelos grandes (modelos da série GPT): o preço das entradas do modelo da série GPT-4o foi reduzido pela metade e a velocidade de acesso foi aumentada em 801 TP3T

Em aplicativos de modelos grandes, o processamento de solicitações complexas geralmente é acompanhado de alta latência e custo, especialmente quando há muita repetição no conteúdo da solicitação. Esse problema de "solicitação lenta" é especialmente proeminente em cenários com solicitações longas e interações de alta frequência. Para enfrentar esse desafio, a OpenAI introduziu recentemente o Cache de prompts Função. Essa nova tecnologia evita a computação dupla ao armazenar em cache a mesma parte do prefixo processada pelo modelo, reduzindo significativamente o tempo de resposta e os custos associados à solicitação. Especialmente para solicitações de dicas longas com conteúdo estático, o armazenamento em cache de dicas pode aumentar significativamente a eficiência e reduzir a sobrecarga operacional. Neste documento, apresentaremos em detalhes como esse recurso funciona, os modelos compatíveis e como otimizar a taxa de acerto do cache por meio de uma estrutura de dica razoável para ajudar os desenvolvedores a melhorar a experiência de uso de modelos grandes.

O que é o Large Model Prompt Caching (Prompt Caching)?

O cache de prompts é um mecanismo usado para reduzir a latência e o custo computacional do processamento de prompts longos com conteúdo repetido. Um "prompt", nesse contexto, refere-se à entrada que você envia ao modelo. Em vez de recalcular os primeiros N tokens de entrada de uma dica todas as vezes durante o processo de solicitação, o sistema armazena em cache os resultados dos cálculos anteriores. Em vez disso, o sistema armazena em cache os resultados dos cálculos anteriores para que possa reutilizar os dados armazenados em cache para solicitações subsequentes com o mesmo prefixo de dica, o que acelera o processamento, reduz a latência e economiza custos.

Em termos simples, o cache de dicas funciona da seguinte forma:

- Armazenar em cache os primeiros 1024 tokens O sistema verifica se os primeiros 1024 tokens do conteúdo do prompt são os mesmos da solicitação anterior e, se forem, ele armazena em cache o cálculo desses tokens.

- acerto no cache Quando uma nova solicitação corresponde a uma dica armazenada em cache, nós a chamamos de "acerto de cache". Nesse momento, a resposta conterá informações detalhadas sobre o token de cache, ajudando a reduzir o tempo e o custo de computação.

- reduzir custos : em Tipo de implantação padrão no qual os tokens armazenados em cache serão cobrados a um preço com desconto; enquanto no Tipos de implementação pré-configurados em que as tags de cache podem até obter um desconto de 100%.

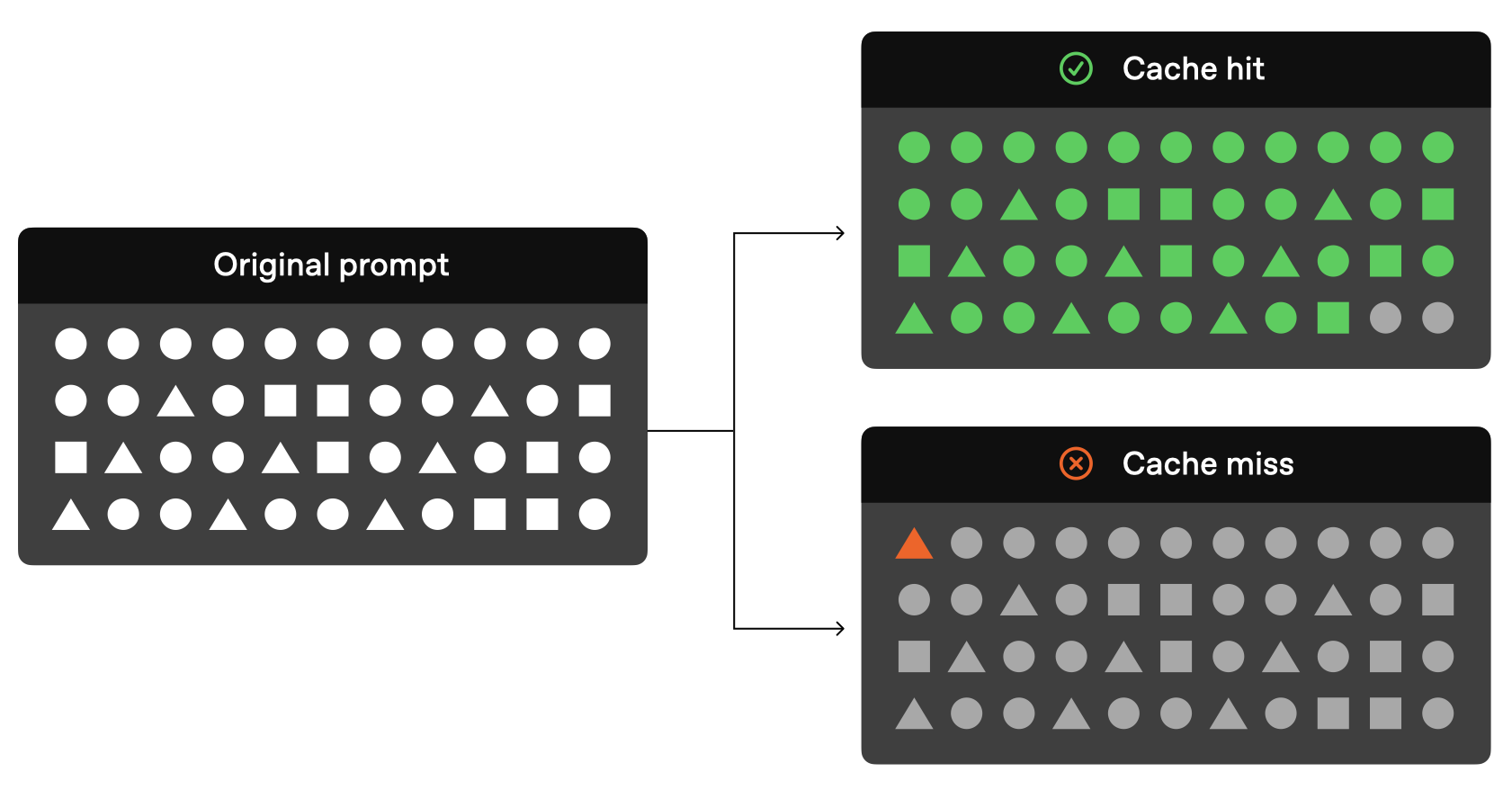

Um esquema bem gráfico do cache de dicas é fornecido oficialmente:

Como você pode ver na figura acima, se os tokens anteriores em sua solicitação original forem os mesmos da solicitação anterior, essa parte da solicitação poderá ser resolvida não por meio do modelo, mas apenas lida diretamente por meio dos resultados armazenados em cache.

Atualmente, a OpenAI fornece oficialmente os seguintes modelos armazenáveis em cache:

| modelagem | Custos de entrada de texto | Custos de entrada de áudio |

|---|---|---|

| gpt-4o (excluindo gpt-4o-2024-05-13 e chatgpt-4o-latest) | Barato 50% | não aplicável |

| gpt-4o-mini | Barato 50% | não aplicável |

| gpt-4o-realtime-preview | Barato 50% | Barato 80% |

| o1-preview | Barato 50% | não aplicável |

| o1-mini | Barato 50% | não aplicável |

Os modelos atuais que suportam o cache de dicas (por exemplo, gpt-4o, gpt-4o-mini, gpt-4o-realtime-preview etc.) são todos eficazes na redução do custo da entrada de texto, especialmente com o desconto de custo de 50%, e o modelo gpt-4o-realtime-preview ainda conta com o desconto de custo de 80% ao processar a entrada de áudio. O suporte desses modelos não apenas melhora a eficiência da resposta do modelo, mas também oferece aos desenvolvedores uma solução de baixo custo e alto desempenho, especialmente para cenários que exigem solicitações repetidas com frequência ou que contêm grandes quantidades de conteúdo estático.

Como funciona o cache de dicas

De acordo com a documentação oficial atual do OpenAI, as seguintes condições devem ser atendidas se sua solicitação for usar o cache:

- O comprimento do prompt deve ser de pelo menos 1024 tags .

- solicitado Primeiras 1024 tags Deve estar em uma solicitação subsequente idêntico .

Além disso, deve-se observar que, oficialmente, os 1024 tokens iniciais são o comprimento mínimo do cache, mas os 128 tokens incrementais dos acessos posteriores, ou seja, o comprimento do cache são 1024, 1152, 1280, 1408, de modo a1024 tokens é o mínimo, com incrementos de 128 tokensA maneira como ele é salvo.

Quando ocorrer um "acerto no cache", a resposta da API conterá cached_tokensque indica quantos tokens vieram do cache. Por exemplo, o número de tokens enviados para o1-preview-2024-09-12 Uma solicitação de um modelo pode retornar a seguinte resposta:

{"created":1729227448,"model":"o1-preview-2024-09-12","object":"chat.completion","usage":{"completion_tokens":1518,"prompt_tokens":1566,"total_tokens":3084,"completion_tokens_details":{"reasoning_tokens":576},"prompt_tokens_details":{"cached_tokens":1408}}}

Neste exemplo, o1408 marcaçõesé buscado no cache, reduzindo significativamente o tempo e o custo de processamento.

Economizar tempo após o acerto do cache de dicas

A OpenAI afirma oficialmente que os modelos não mantêm informações em cache o tempo todo. O mecanismo atual relacionado ao cache de dicas para a série de modelos GPT é o seguinte:

- Duração do cache O cache estará no 5-10 minutosé apagado após o estado inativo do cache. Se o último uso do cache não tiver sido acessado por mais de uma hora, ele será removido completamente.

- Erros no cache Se um dos primeiros 1024 tokens do prompt for diferente, o Erros no cache neste momento

cached_tokensterá um valor de 0. - O cache não é compartilhado Dicas para que o cache não fique em um local diferenteassinarcompartilhado entre elas. Cada assinatura tem seu próprio cache.

Tipos de conteúdo em cache compatíveis

A funcionalidade do cache de dicas varia de acordo com o modelo usado. Por exemplo.Modelos da série o1Ele suporta apenas texto, não mensagens do sistema, imagens, chamadas de ferramentas ou saída estruturada, portanto, seu recurso de cache é aplicável principalmente à parte da mensagem do usuário. O gpt-4o e gpt-4o-mini O modelo suporta o armazenamento em cache de mais tipos de conteúdo, incluindo:

- mensagens Mensagens do sistema: um conjunto completo de mensagens, incluindo mensagens do sistema, mensagens do usuário e mensagens auxiliares.

- imagens Imagens (links ou dados codificados em base64) contidas nas mensagens do usuário, desde que o

detailOs parâmetros são consistentes. - Chamada de ferramenta Inclui matrizes de mensagens e caches definidos por ferramentas.

- Saída estruturada Modo de saída estruturado anexado a uma mensagem do sistema.

Para aumentar a probabilidade de acertos no cache, recomenda-se que as duplicatas sejam colocadas na frente da matriz de mensagens.

Sugestão da versão da API do OpenAI que é compatível com o cache

O recurso de cache de dicas foi introduzido pela primeira vez no Versão da API 2024-10-01-preview no fornecimento de suporte. Para o1 Série de modelos Além disso, a resposta da API agora inclui o cached_tokens para mostrar o número de tokens atingidos pelo cache.

Etapas para ativar o cache de dicas:

- comprimento mínimo Verifique se o prompt tem pelo menos 1024 tokens.

- prefixo consistente (matemática) Garanta que os primeiros 1024 tokens do prompt sejam consistentes entre as solicitações.

- Resposta da API Quando ocorre um acerto no cache, a resposta da API exibe o

cached_tokensindicando quantos tokens são armazenados em cache.

É possível desativar o cache de dicas?

As dicas são armazenadas em cache em todos os modelos compatíveis Ativado por padrão e atualmente está Nenhuma opção de desativação . Isso significa que, se você estiver usando um modelo compatível, o armazenamento em cache será ativado automaticamente, desde que a solicitação seja elegível.

Por que o cache de dicas é tão importante?

O cache de dicas traz dois benefícios principais:

- Redução do atraso Cache: o cache acelera significativamente os tempos de resposta, evitando o processamento duplicado do mesmo conteúdo.

- economizar custos Cache: o cache reduz o número de tokens que precisam ser processados e, portanto, reduz o custo computacional geral, especialmente para prompts longos com muito conteúdo duplicado.

O armazenamento em cache de dicas é particularmente vantajoso para cenários de aplicativos em que os mesmos dados ou dicas precisam ser processados com frequência, como sistemas de IA de conversação, extração de dados e consultas repetitivas.

Práticas recomendadas para o cache de dicas da OpenAI

Para aumentar a probabilidade de acertos no cache, a OpenAI também dá alguns conselhos oficiais:

- Prompts estruturados: coloque conteúdo estático ou repetitivo na frente do prompt e conteúdo dinâmico atrás do prompt.

- Monitore as métricas do cache: otimize as políticas de hinting e de cache monitorando as taxas de acerto do cache, a latência e as porcentagens de marca do cache.

- Utilize dicas longas e horários fora do pico: use dicas mais longas e inicie solicitações em horários fora do pico para aumentar as chances de acertos no cache, pois o cache será limpo com mais frequência durante os horários de pico.

- Manter a consistência: reduza a probabilidade de descargas de cache usando periodicamente solicitações rápidas com o mesmo prefixo.

Perguntas e respostas frequentes sobre a técnica de cache de dicas da OpenAI

- Como o armazenamento em cache garante a privacidade dos dados?

Os caches de dicas não são compartilhados entre organizações diferentes. Somente membros da mesma organização podem acessar o mesmo cache de dicas. - O armazenamento em cache de dicas afeta a marcação de saída ou a resposta final?

Cue Cachenão afetaráA saída do modelo. A saída gerada é sempre a mesma, independentemente de o cache ser usado ou não. Como somente os próprios prompts são armazenados em cache, a resposta real é recalculada a cada vez com base nos prompts armazenados em cache.

- É possível limpar o cache manualmente?

No momento, não há suporte para a limpeza manual do cache. Os prompts que não foram usados por um longo período são automaticamente removidos do cache. Normalmente, o cache é limpo na seção 5-10 minutos é apagado após um período de inatividade, mas durante períodos de baixo tráfego, o cache pode durar no máximo uma hora . - Preciso pagar mais para usar o cache de dicas?

Não é necessário. O cache é ativado automaticamente, sem nenhuma ação ou custo adicional para o usuário. - As dicas armazenadas em cache contam para os limites do TPM?

Sim, o armazenamento em cache não afeta a limitação de taxa, os acessos ao cache ainda contam para o número total de solicitações. - Posso usar descontos de cache de dica na API Scale Tier e Bulk?

Dica Os descontos de cache não se aplicam à API em massa, mas se aplicam ao Scale Tier. Com o Scale Tier, os tokens de estouro também estão sujeitos a descontos de cache. - O cache de dicas se aplica a solicitações de retenção zero de dados?

Sim, o cache imediato está em conformidade com a política existente de retenção zero de dados.

resumos

O recurso de cache de dicas do Azure OpenAI oferece uma solução de otimização valiosa para lidar com dicas longas e solicitações repetitivas. Ele melhora significativamente a eficiência do modelo, reduzindo a latência e o custo computacional.

À medida que mais modelos forem suportados e o recurso de cache de dicas continuar a ser otimizado, espera-se que os usuários do Azure OpenAI possam desfrutar de uma experiência de serviço mais eficiente e econômica.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...