Os modelos de próxima geração da OpenAI enfrentam um grande gargalo, e o ex-cientista-chefe revela uma nova rota

A próxima geração do modelo de linguagem grande da OpenAI, o Orion, pode estar atingindo um gargalo sem precedentes. De acordo com o The Information, os funcionários da OpenAI afirmam que os ganhos de desempenho do modelo Orion ficaram aquém das expectativas e que os ganhos de qualidade são "muito menores" do que a atualização do GPT-3 para o GPT-4.

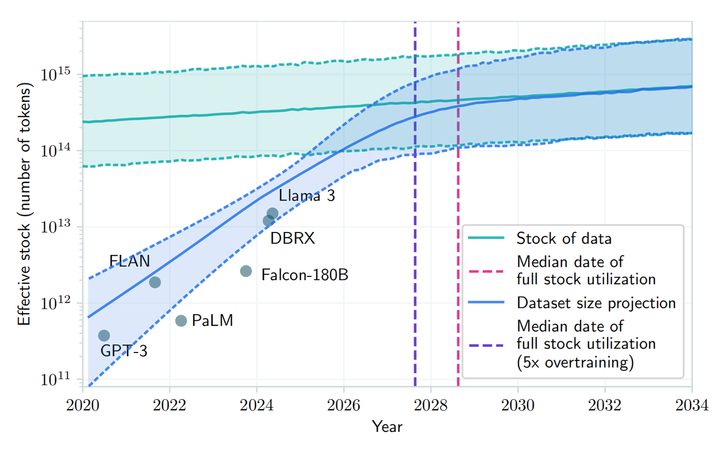

Além disso, o Orion não é tão estável quanto seu antecessor GPT-4 em determinadas tarefas. Apesar dos maiores recursos linguísticos do Orion, o desempenho da programação pode não superar o do GPT-4. A diminuição dos recursos para treinamento de textos de alta qualidade e outros dados tornou mais difícil encontrar dados de treinamento de alta qualidade, retardando o desenvolvimento de LLMs (Large Language Models).

Além disso, o treinamento futuro será ainda mais intensivo em termos de computação, em termos de dinheiro e até mesmo de eletricidade, o que significa que o custo do desenvolvimento do Orion e dos grandes modelos de linguagem subsequentes aumentará significativamente. O pesquisador da openAI, Noam Brown, disse recentemente na conferência TED AI que modelos mais avançados podem ser "economicamente inviáveis":

Vamos realmente gastar centenas de bilhões ou trilhões de dólares treinando modelos? Em algum momento, a lei do escalonamento será quebrada.

A OpenAI montou uma equipe de fundação, liderada por Nick Ryder, para analisar como lidar com a crescente escassez de dados de treinamento e quanto tempo durarão as leis de escalonamento de modelos grandes.

Noam Brown

As leis de escalonamento são uma das principais premissas da IA: enquanto houver mais dados aprendidos e mais capacidade computacional para conduzir o processo de treinamento, o desempenho de um modelo de linguagem grande pode continuar a melhorar na mesma proporção. Em resumo, a lei de escalonamento descreve a relação entre as entradas de recursos (quantidade de dados, capacidade de computação, tamanho do modelo) e o resultado do desempenho do modelo. Ou seja, a medida em que o desempenho melhora quando mais recursos são investidos no modelo de linguagem grande.

Por exemplo, o treinamento de um modelo de linguagem grande pode ser comparado à produção de um carro: inicialmente, a fábrica é pequena, com apenas algumas máquinas e alguns trabalhadores e, nesse ponto, cada máquina ou trabalhador adicional resulta em um aumento significativo na produção porque os recursos adicionais são diretamente traduzidos em produtividade. Entretanto, à medida que a fábrica aumenta de tamanho, o aumento da produção por máquina ou trabalhador adicional diminui, possivelmente devido ao aumento da complexidade do gerenciamento ou à colaboração menos eficiente dos trabalhadores.

Quando uma fábrica atinge um determinado tamanho, o acréscimo de mais máquinas ou trabalhadores pode resultar em um aumento mais limitado na produção, momento em que a fábrica pode estar se aproximando dos limites de seus recursos, como o fornecimento de terra e a logística. Nesse ponto, a fábrica pode estar se aproximando dos limites de seus recursos, como terra, fornecimento de energia e logística, e mais investimentos não podem mais trazer um aumento correspondente na capacidade de produção. Esse é exatamente o dilema enfrentado pelo modelo da Orion: à medida que o tamanho do modelo aumenta (semelhante à adição de mais máquinas e trabalhadores), a melhoria do desempenho do modelo é muito significativa nos estágios iniciais e de médio prazo, mas nos estágios posteriores, mesmo que o tamanho do modelo ou a quantidade de dados de treinamento seja aumentada, a melhoria do desempenho se torna menor. Isso é conhecido como "bater na parede".

De acordo com um artigo no arXiv, prevê-se que o desenvolvimento de grandes modelos de linguagem poderia esgotar os recursos públicos de texto humano entre 2026 e 2032 devido à crescente demanda e à disponibilidade limitada de dados públicos de texto humano. Apesar de apontar que há "problemas econômicos" com o treinamento de modelos futuros, Norm Brown argumenta contra o que foi dito acima, afirmando que "o desenvolvimento da IA não vai desacelerar tão cedo".

Em geral, os pesquisadores da OpenAI compartilham dessa opinião e, embora a lei do escalonamento possa ficar mais lenta, o desenvolvimento geral da IA não será afetado significativamente pela otimização dos tempos de inferência e pelas melhorias pós-treinamento. Os CEOs da Meta, Mark Zuckerberg, Sam Altman, CEO da OpenAI, e outros CEOs de desenvolvedores de IA também declararam publicamente que os limites tradicionais da lei do dimensionamento ainda não foram atingidos e que ainda estão desenvolvendo centros de dados caros para melhorar o desempenho dos modelos pré-treinados.

Peter Welinder, vice-presidente de produtos da OpenAI, também foi à mídia social para dizer que "as pessoas subestimam o poder da computação em tempo de teste". A computação em tempo de teste (TTC) é um conceito de aprendizado de máquina que se refere à computação que ocorre quando um modelo é implantado para fazer inferências ou previsões sobre novos dados de entrada, separado da computação que ocorre durante o treinamento. A fase de treinamento é o processo pelo qual o modelo aprende padrões de dados, enquanto a fase de teste é o processo pelo qual o modelo é aplicado a tarefas do mundo real.

Os modelos tradicionais de aprendizado de máquina normalmente preveem novas instâncias de dados sem computação adicional após terem sido treinados e implantados. No entanto, alguns modelos mais complexos, como certos tipos de modelos de aprendizagem profunda, podem exigir computação adicional no momento do teste (tempo de inferência). O modelo 'o1' desenvolvido pela OpenAI emprega esse tipo de padrão de inferência. O setor de IA como um todo está mudando seu foco para a fase de otimização do modelo após a conclusão do treinamento inicial.

Peter Welinder

Ilya Sutskever, um dos cofundadores da OpenAI, admitiu em uma entrevista recente à Reuters que a melhoria na eficácia da fase de pré-treinamento, que usa grandes quantidades de dados não rotulados para treinar modelos de IA para entender padrões e estruturas linguísticas, atingiu um patamar. "A década de 2010 foi a era da expansão, e agora estamos de volta à era da exploração e da descoberta", disse ele. Ele também observou: "Melhorar a precisão é mais importante do que nunca".

O Orion está programado para ser lançado em 2025, e a OpenAI o batizou de "Orion" em vez de "GPT-5", talvez sugerindo uma revolução totalmente nova. Embora atualmente seja "difícil de produzir" devido a limitações teóricas, ainda se espera que esse recém-nomeado "recém-nascido" traga uma oportunidade transformadora para a macromodelagem de IA.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...