OpenAI-o3 e ideias de Monte-Carlo

A o3 está aqui para compartilhar algumas percepções pessoais. Sobre o tempo de teste Lei de escala progresso, muito mais rápido do que pensávamos. Mas eu diria que o caminho é, na verdade, um pouco complicado - é a maneira da OpenAI de fazer uma curva em sua busca pela AGI.

Aprendizado intensivo e pensamento de atalho

Por que isso acontece? Vamos explorar isso por meio de dois exemplos.

O primeiro exemplo vem do aprendizado por reforço. Na RL, o fator de desconto desempenha um papel fundamental, o que implica que a recompensa obtida diminuirá gradualmente à medida que as etapas da tomada de decisão avançarem. Portanto, o objetivo do aprendizado por reforço geralmente é maximizar as recompensas no menor tempo possível e no menor número possível de etapas. No centro dessa estratégia, a ênfase está nos "atalhos", ou seja, obter a recompensa o mais rápido possível.

O segundo exemplo é o processo de ajuste fino de modelos grandes. Um modelo pré-treinado que não tenha sido ajustado geralmente não tem direção ou controle claros. Quando perguntamos ao modelo "Onde fica a capital da China?" ele pode primeiro dizer "Essa é uma boa pergunta" e depois sair pela tangente antes de finalmente dar a resposta "Pequim". Entretanto, quando a mesma pergunta é feita a um modelo ajustado, a resposta é direta e clara: "Pequim".

Esse modelo ajustado demonstra uma maneira de obter atalhos por meio de uma estratégia de otimização - semelhante à jornada evolutiva dos seres humanos - sempre buscando o menor consumo de energia e o caminho mais curto.

Por que raciocinar?

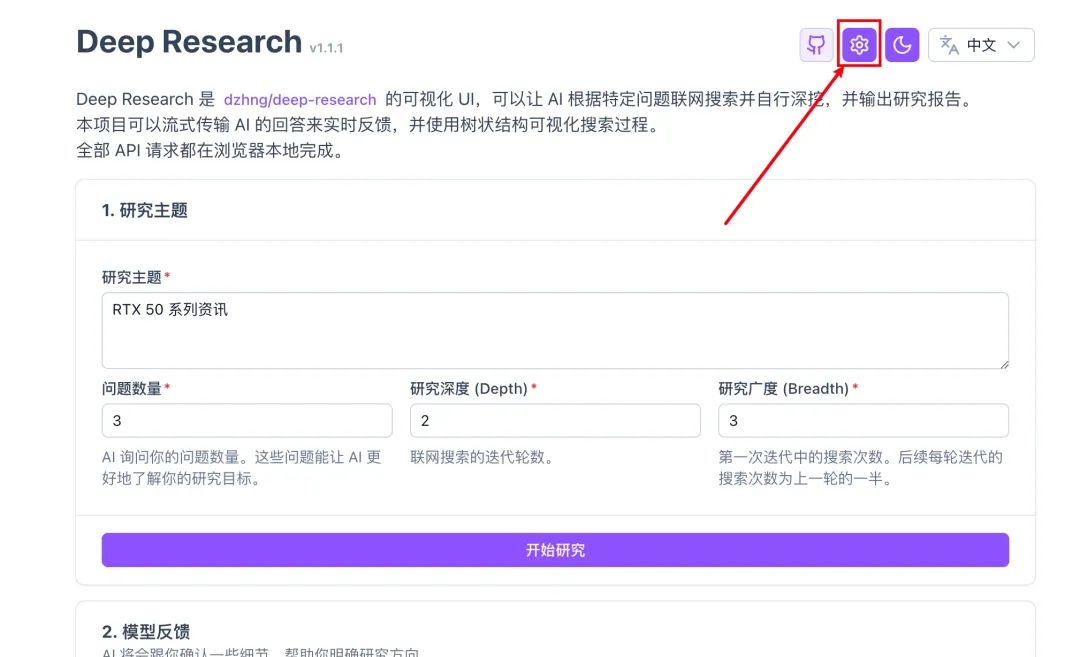

Se você visualizar o processo de amostragem do Reasoning como uma árvore:

Jornada de replicação do O1: Parte 1

À esquerda está o aprendizado por atalhos que buscamos no passado: o menor número de etapas para chegar ao resultado correto. À direita está o paradigma "reflexivo e retrospectivo" representado pela OpenAI o1.

Sabemos que, à medida que a o1 realiza uma pesquisa, o modelo está constantemente refletindo e retrocedendo, e esse processo geralmente é acompanhado por despesas gerais adicionais. O problema é que quem quer gastar tempo e dinheiro em uma pesquisa complexa se o modelo pode realmente dar a resposta certa várias vezes? A OpenAI não é burra, e todos sabemos que os atalhos são melhores!

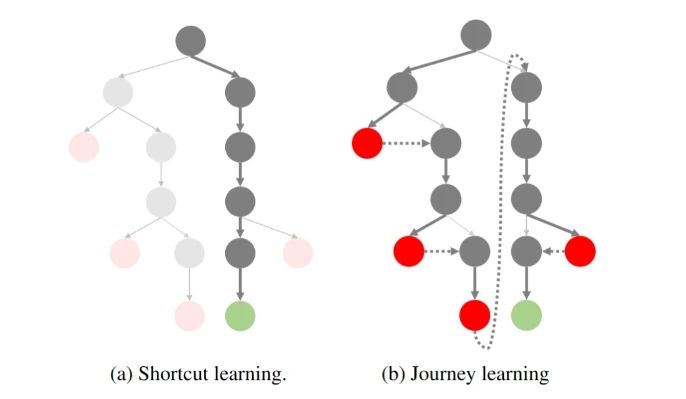

Quanto mais difícil for o problema, maior será a árvore de ideias em potencial, maior será o espaço de pesquisa em cada etapa e menor será a probabilidade de um atalho levar à resposta certa. Então, o que fazer? Uma maneira intuitiva de pensar sobre isso é optar pela poda! Cortar os nós da árvore que provavelmente não chegarão ao ponto final antes do tempo, comprimindo o espaço de pesquisa e transformando a árvore em uma árvore estreita. É isso que muitos esforços atuais estão tentando fazer, por exemplo:

Otimização da cadeia de preferências (CPO)

A otimização da cadeia de preferências consiste em construir naturalmente dados de preferências a partir da árvore de raciocínio e, em seguida, usar o DPO para otimizá-los, de modo que o modelo tenha uma probabilidade maior de selecionar o nó da árvore que alcançará o ponto final.

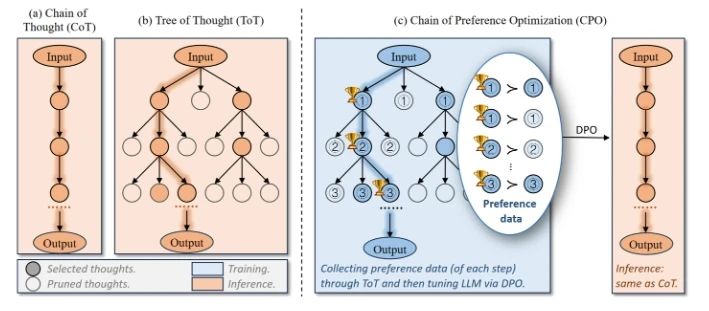

Modelos de valor supervisionados por resultados (OVM)

Os modelos de valor supervisionados por resultados são a modelagem do raciocínio como um processo MDP, em que a probabilidade de chegar à resposta correta na etapa atual (valor) é usada para orientar a otimização da estratégia.

Por que a OpenAI optou por abandonar os atalhos tradicionais?

Voltando à o1, por que você optou por quebrar a ideia do atalho tradicional e optar pelo "desvio" da Tree Search?

Se, no passado, tendíamos a explorar os recursos básicos dos modelos (Exploit), seria de se supor que os modelos GPT-4 existentes fossem capazes de satisfazer a maioria das necessidades de diálogo e raciocínio simples. E essas tarefas podem ser bem amostradas, as preferências avaliadas e otimizadas iterativamente.

No entanto, essa perspectiva ignora a necessidade de tarefas mais complexas, como raciocínio matemático (AIME, Frontier Math), geração de código (SWE-Bench, CodeForce) etc., que geralmente são difíceis de recompensar em curto prazo. -Suas recompensas são muito esparsas, e as recompensas só se tornam aparentes quando a resposta correta é finalmente alcançada.

Consequentemente, o aprendizado tradicional por atalhos não é mais adequado para lidar com esse tipo de tarefa complexa: como é possível falar em otimizar a probabilidade de o modelo escolher o caminho correto quando não é possível nem mesmo obter uma amostra do caminho correto?

Voltando à "ideia de Monte-Carlo" no título deste artigo, podemos ver que, na verdade, é a mesma coisa: o núcleo da abordagem de Monte-Carlo para o aprendizado por reforço está em estimar o valor de uma política por meio de amostragem várias vezes e, assim, otimizar o modelo. No entanto, essa abordagem tem uma limitação natural: se as políticas amostradas não puderem amostrar os caminhos ideais, a otimização do modelo sempre terminará com um ótimo local. É por isso que optamos por estratégias mais exploratórias no MC Learning.

Assim, a OpenAI optou por quebrar as escalas do aprendizado por reforço, afastando-se da mentalidade tradicional de atalhos em favor da exploração de reforço (Explore).

o1 Inovações: da exploração à otimização

Nesse contexto, a OpenAI propôs o paradigma o1. Essa mudança permite que o modelo comece a receber recompensas esparsas gradualmente ao enfrentar tarefas complexas! E, por meio dessas recompensas, a estratégia pode ser continuamente otimizada. Embora esse processo de exploração possa parecer incômodo e ineficiente, ele estabelece a base para uma maior otimização do modelo.

Então, de onde veio o o1? Muitos trabalhos sobre a replicação da o1 também apareceram recentemente. O que eles estão fazendo? Se a política comportamental usada para a exploração for a abordagem On-Policy, ela é uma amostragem com o modelo atual (por exemplo, GPT-4o), que ainda é muito ineficiente.

Assim, os rapazes escolheram por unanimidade o método Off-Policy:

A OpenAI gasta muito dinheiro para contratar estudantes de doutorado para fazer anotações nos dados do Long CoT; não há dinheiro? O que podemos fazer se não tivermos dinheiro? Então, podemos colaborar com humanos e máquinas para anotar os dados (destilar manualmente o1) e reduzir os requisitos para os anotadores; Não temos dinheiro nem para encontrar anotadores? Então temos que destilar R1 / QwQ ou pensar em outras maneiras (crítica, PRM etc.). Também gostaria de lembrar aos grandes fabricantes e laboratórios que estão reproduzindo ativamente o o1 que não se esqueçam de que o objetivo final da exploração ainda é a otimização!

插一句题外话,虽然大家都在骂 o1 隐藏了真正的思维链,只展示 Summary 的捷径版本。殊不知这个 Summary 才是优化策略的关键数据!但 OpenAI 并不害怕其他人蒸馏这些 Summary,因为蒸馏这些数据还有一个前提——基础模型的能力足够强大,不然步子迈太大还容易闪了腰。

并且 OpenAI 还将探索的成本转嫁给了用户。虽然在初期花很多钱来标注探索型数据,但现在有了 o1 后,用户使用的过程中又无形地为他标注了更多数据。OpenAI 再次实现了伟大的数据飞轮!

Evolução rápida de o1 para o3

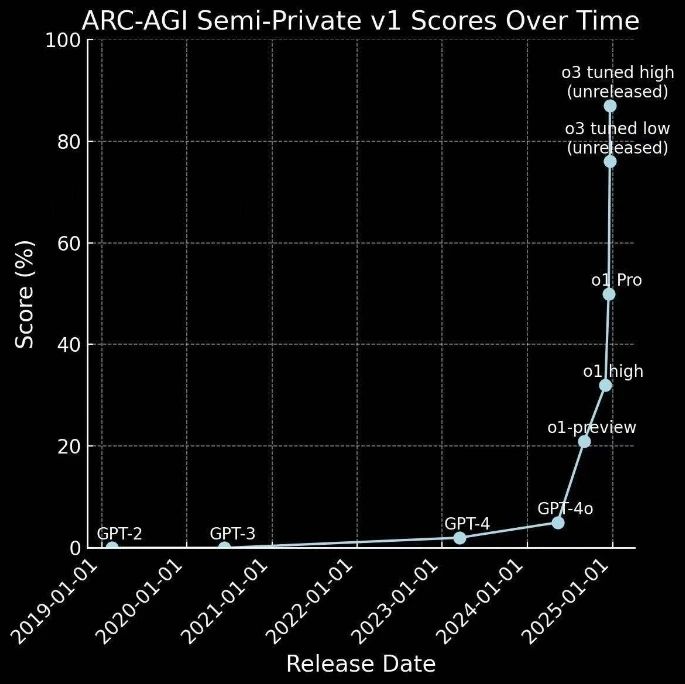

O o1 acabou de ser lançado há alguns meses e agora vem o o3.

Na verdade, isso contorna a conjectura anterior: se o GPT-4 representa uma progressão de 0 a 1 - ou seja, de tarefas simples para obter recompensas - então o1 representa um salto de 1 a 10 - explorando tarefas complexas e obtendo recompensas raras. recompensas raras, fornecendo uma quantidade sem precedentes de dados de alta qualidade para otimização adicional da estratégia.

Portanto, o progresso foi mais rápido do que se esperava:

Essa não é apenas uma aplicação bem-sucedida da estratégia de exploração, mas também uma etapa importante da tecnologia de IA em direção à AGI.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...