Introdução ao macromodelo OpenAI o1-mini

Promoção de técnicas de raciocínio econômicas.

Lançamos o OpenAI o1-mini, um modelo de inferência econômico. O o1-mini é excelente em STEM, especialmente em matemática e programação, com desempenho quase tão bom quanto o do OpenAI o1 desempenho comparável em benchmarks de análise, como o AIME e o Codeforces. Prevemos que o o1-mini se tornará uma opção mais rápida e econômica para cenários de aplicativos que exigem raciocínio, mas não dependem de amplo conhecimento do mundo.

Hoje, estamos oferecendo o OpenAI o1-preview para 80% mais barato do que o OpenAI o1-preview. Usuários da API de nível 5 (abre em uma nova janela) Lançamento do o1-mini. Os usuários do ChatGPT Plus, Team, Enterprise e Edu podem usar o o1-mini como uma alternativa ao o1-preview, desfrutando de limites de uso mais altos e menor latência, consulte [Velocidade do modelo.

Otimizado para raciocínio STEM

Modelos de linguagem grandes, como o o1, geralmente são pré-treinados em conjuntos de dados textuais em grande escala. Apesar de seu amplo conhecimento do mundo, esses modelos de alta capacidade podem ser caros e lentos em aplicativos do mundo real. Em contrapartida, o o1-mini é um modelo pequeno otimizado especificamente para o raciocínio STEM durante a fase de pré-treinamento. Depois de ser treinado usando o mesmo pipeline de aprendizagem por reforço (RL) de alto volume computacional que o o1, o o1-mini tem desempenho comparável em muitas tarefas práticas de raciocínio, além de ser significativamente mais econômico.

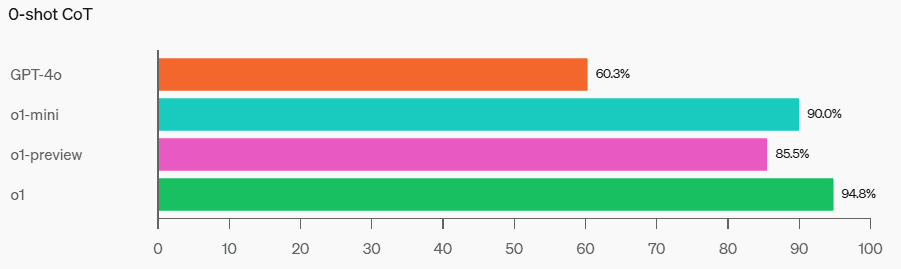

Em testes de benchmark que exigem inteligência e raciocínio, o o1-mini supera o o1-preview e o o1. No entanto, o o1-mini tem um desempenho ruim em tarefas que exigem conhecimento factual não-STEM, consulte [Limitações].

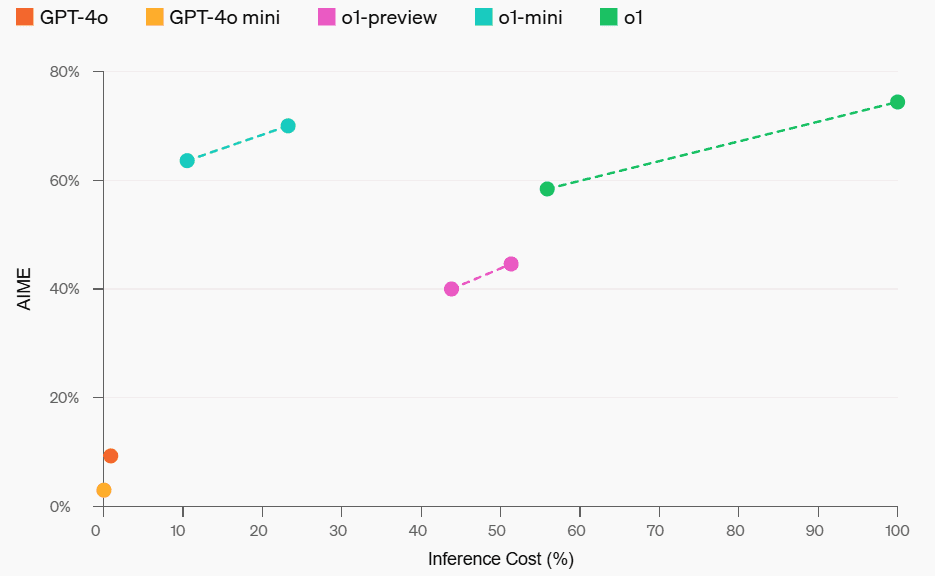

Desempenho matemático e custos de raciocínio

Matemática: Na competição de matemática da AIME para o ensino médio, o o1-mini (70,0%) teve um desempenho comparável ao do o1 (74,4%) - e foi significativamente mais barato - e melhor do que o o1-preview ( 44,6%). As pontuações do o1-mini (cerca de 15 de 11 perguntas respondidas corretamente) o colocam aproximadamente entre os 500 melhores alunos do ensino médio dos EUA.

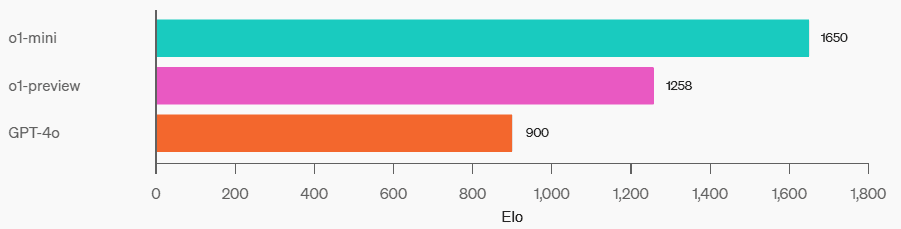

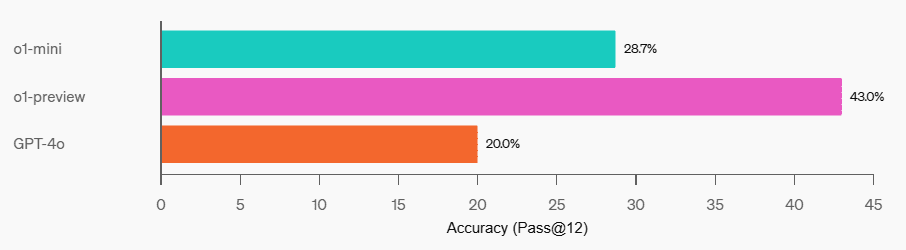

Programação: No site da competição Codeforces, o o1-mini tem uma pontuação Elo de 1650, que é comparável ao o1 (1673) e superior ao o1-preview (1258). Essa pontuação Elo coloca o o1-mini no 86º percentil superior de programadores na plataforma Codeforces. O o1-mini também teve um desempenho muito bom nos benchmarks de programação da HumanEval e nos desafios de segurança cibernética (CTFs) do ensino médio.

Forças de código

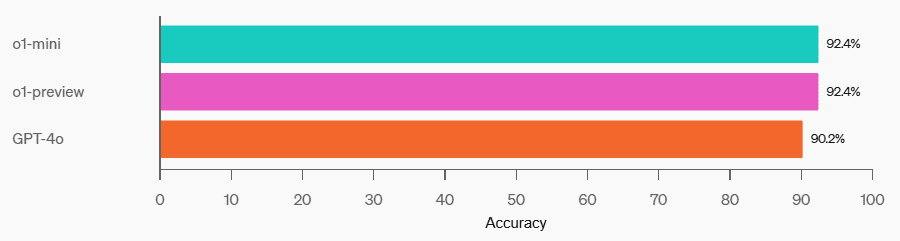

HumanEval

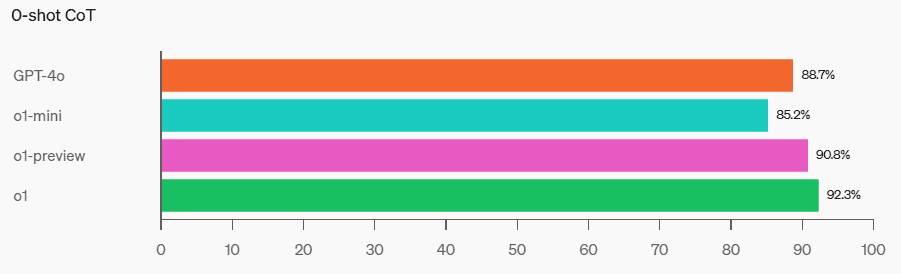

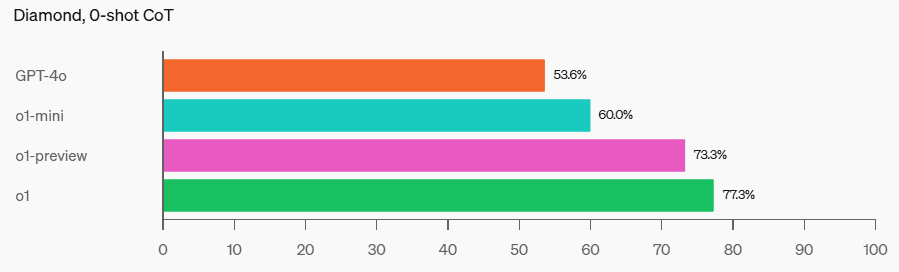

CTFs de segurança cibernética

STEM: Em alguns testes acadêmicos que exigem raciocínio, como o GPQA (ciências) e o MATH-500, o o1-mini supera o GPT-4o. O o1-mini não tem um desempenho tão bom quanto o GPT-4o na tarefa MMLU e fica atrás do o1-preview no GPQA porque não tem um conhecimento amplo do mundo.

MMLU

GPQA

MATH-500

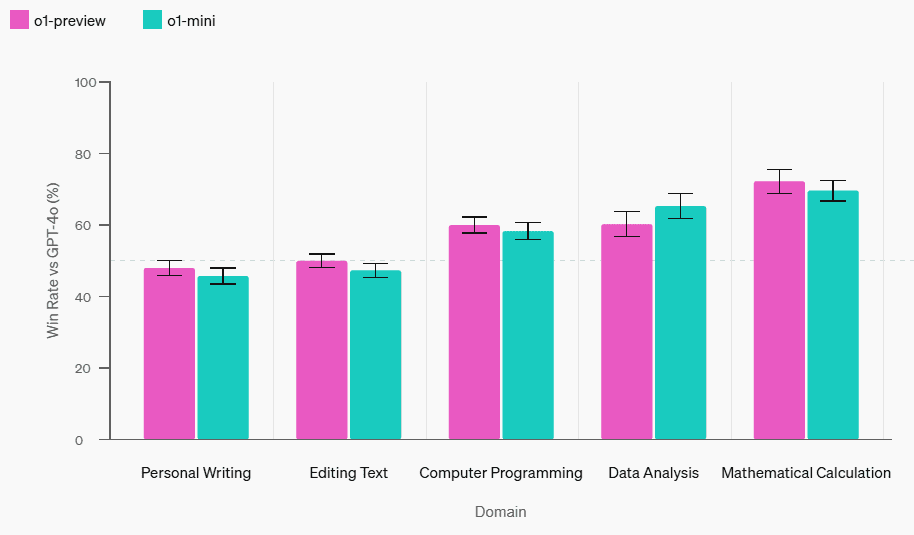

Avaliação da preferência humana: Pedimos aos avaliadores que comparassem o o1-mini com o GPT-4o em quebra-cabeças abertos em uma variedade de domínios, usando a mesma metodologia que usamos em [o1-preview compared to GPT-4o] (https://openai.com/index/learning-to-reason-with-llms/). Semelhante ao o1-preview, o o1-mini é mais popular que o GPT-4o em domínios que exigem raciocínio, mas menos popular que o GPT-4o em domínios focados em linguagem.

Avaliação da preferência humana vs. chatgpt-4o-latest

velocidade do modelo

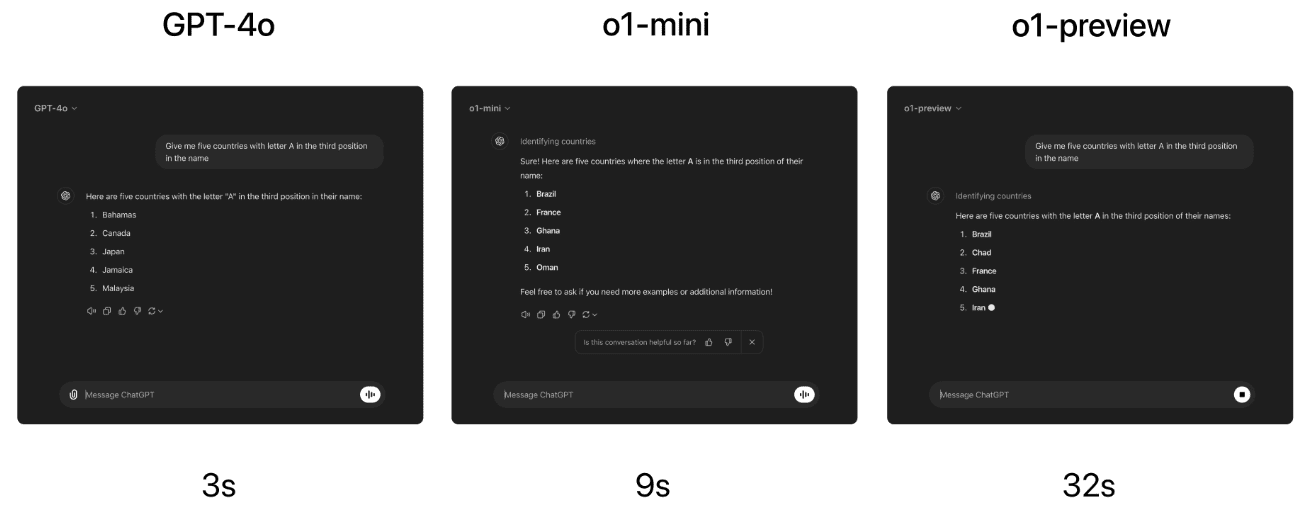

Como exemplo concreto, comparamos as respostas do GPT-4o, o1-mini e o1-preview em um problema de raciocínio lexical. Enquanto o GPT-4o deu uma resposta incorreta, tanto o o1-mini quanto o o1-preview deram a resposta correta, e o o1-mini respondeu cerca de 3 a 5 vezes mais rápido.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...