Como os bots da OpenAI "agiram como um ataque DDoS" para destruir o site da empresa de sete pessoas

No sábado, o CEO da Triplegangers, Oleksandr Tomchuk, foi notificado de que o site de comércio eletrônico de sua empresa estava fora do ar. Parecia ser algum tipo de ataque distribuído de negação de serviço.

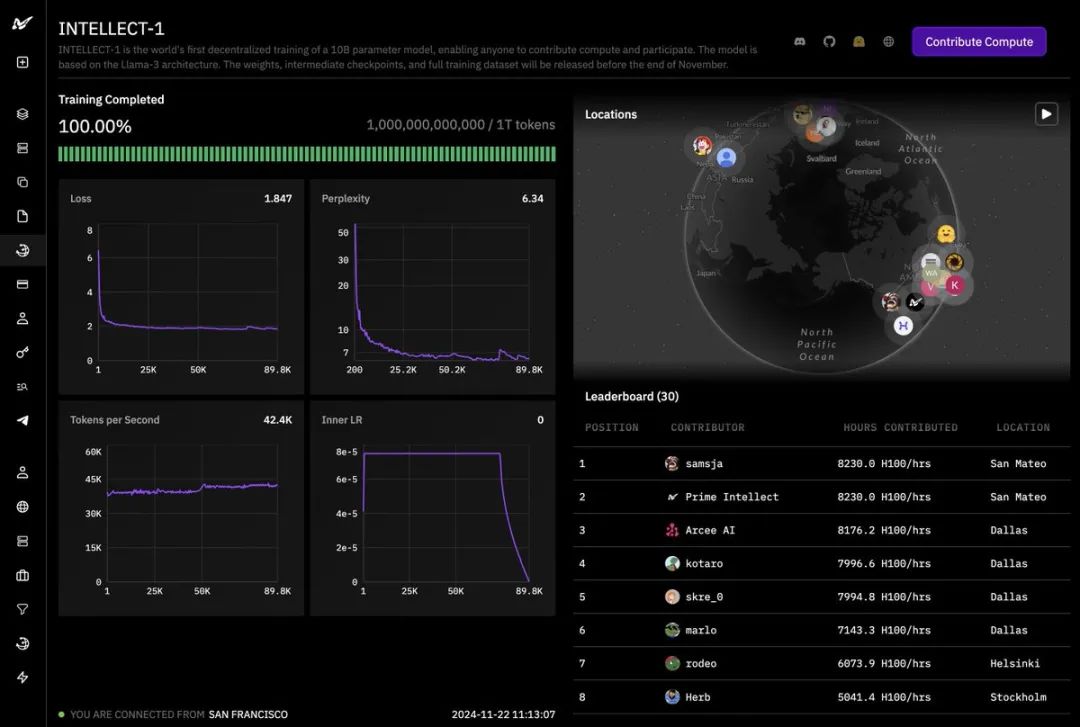

Ele logo descobre que o culpado é um dos bots da OpenAI, que está tentando incessantemente rastrear todo o seu enorme site.

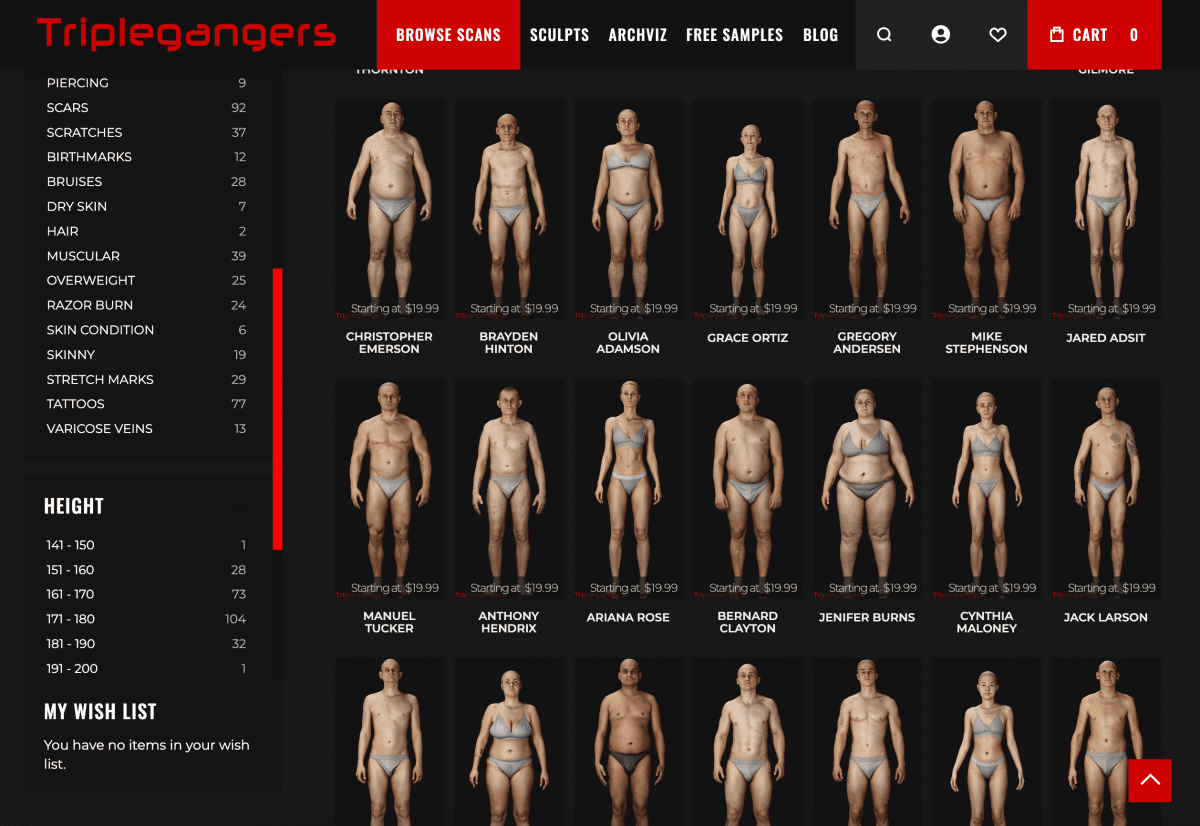

"Temos mais de 65.000 produtos, e cada produto tem uma página", disse Tomchuk ao TechCrunch. "Cada página tem pelo menos três fotos."

A OpenAI enviou "dezenas de milhares" de solicitações de servidor tentando fazer o download de todo esse conteúdo, incluindo centenas de milhares de fotos e suas descrições detalhadas.

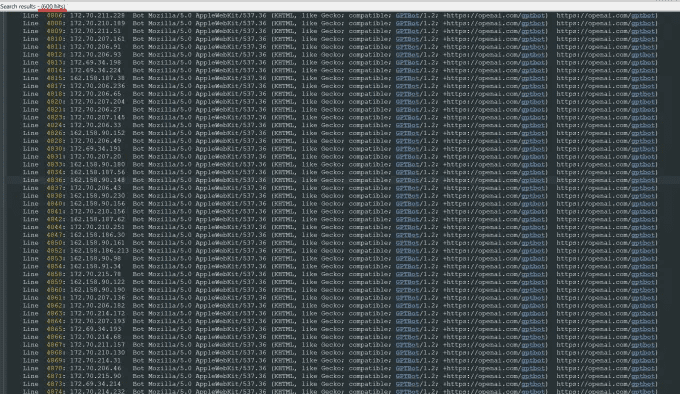

"A OpenAI usou 600 IPs para rastrear os dados, e ainda estamos analisando os registros da semana passada, então talvez o número seja ainda maior", disse ele sobre os endereços IP que o bot usou para tentar acessar seu site.

"Os rastreadores deles estavam destruindo nosso site", disse ele, "era basicamente um ataque DDoS".

O site da Triplegangers é o seu negócio. A empresa de sete funcionários passou mais de uma década reunindo o que chama de maior banco de dados de "duplos digitais humanos" na Web, ou seja, arquivos de imagem 3D digitalizados de manequins reais.

Ela vende arquivos de objetos 3D e fotografias para artistas 3D, produtores de videogames e qualquer pessoa que precise reconstruir digitalmente as características do corpo humano real, desde mãos até cabelos, pele e todo o corpo.

A equipe de Tomchuk está sediada na Ucrânia, mas também é licenciada em Tampa, Flórida, EUA, e seu site tem uma página de termos de serviço que proíbe que os bots acessem suas imagens sem permissão. Mas isso, por si só, não faz nada. O site deve usar um arquivo robot.txt configurado corretamente que contenha tags que digam explicitamente ao robô da OpenAI, o GPTBot, para não acessar o site. (A OpenAI tem vários outros robôs, ChatGPT-User e OAI-SearchBot, que têm suas próprias tags, com base em suas páginas de informações sobre o rastreador).

O arquivo robot.txt, também conhecido como Robots Exclusion Protocol, foi criado para informar aos sites de mecanismos de pesquisa o que não deve ser rastreado porque eles indexam a Web. A openAI afirma em sua página de informações que estará em conformidade com esses arquivos quando configurada com sua própria tag no-crawl, embora também avise que seus robôs podem levar até 24 horas para reconhecer um arquivo robot.txt atualizado.

Como Tomchuk observou, se um site não usa o arquivo robot.txt corretamente, a OpenAI e outros entendem que isso significa que eles podem rastrear o conteúdo à vontade. Esse não é um sistema de aceitação.

Para piorar a situação, não apenas os Triplegangers no horário comercial dos EUA estão sendo prejudicados pelo bot da OpenAI, mas Tomchuk espera um aumento significativo nas contas da AWS devido a toda a atividade de CPU e download do bot.

O Robot.txt também não é infalível. As empresas de IA o cumprem voluntariamente. Outra startup de IA, a Perplexity, ganhou notoriedade no verão passado como resultado de uma investigação da Wired Magazine, quando algumas das evidências sugeriam que Perplexidade Não há tempo para cumpri-la.

Não é possível determinar o que está sendo acessado

Na quarta-feira, alguns dias após o retorno do bot da OpenAI, os Triplegangers configuraram corretamente o arquivo robot.txt e criaram uma conta na Cloudflare para bloquear o GPTBot e alguns outros bots que ele encontrou, como o Barkrowler (um rastreador de SEO) e o Bytespider ( Tomchuk também espera ter bloqueado os rastreadores de outras empresas de modelagem de IA. Ele disse que o site não caiu na manhã de quinta-feira.

Mas Tomchuk ainda não tem uma maneira razoável de descobrir exatamente o que a OpenAI conseguiu acessar ou remover do material. A OpenAI não respondeu ao pedido de comentário do TechCrunch. A OpenAI não respondeu ao pedido de comentário do TechCrunch, e até agora a OpenAI não conseguiu entregar sua ferramenta de exclusão há muito prometida, como o TechCrunch informou recentemente.

Essa é uma questão particularmente espinhosa para a Triplegangers. "Os direitos são uma questão séria no negócio em que estamos, porque digitalizamos pessoas reais", diz ele. De acordo com leis como a GDPR da Europa, "eles não podem simplesmente tirar uma foto de qualquer pessoa na Web e usá-la".

O site da Triplegangers também é um achado particularmente saboroso para os rastreadores de IA. Foram fundadas startups multibilionárias, como a Scale AI, nas quais os seres humanos marcam meticulosamente as imagens para treinar a IA. O site da triplegangers contém fotos marcadas detalhadas: raça, idade, tatuagens e cicatrizes, todos os tipos de corpo e muito mais.

Ironicamente, a ganância do bot da OpenAI é o que faz com que os Triplegangers percebam o quanto estão expostos. Ele diz que, se tivesse arranhado com mais cuidado, Tomchuk nunca teria percebido.

"É assustador porque essas empresas parecem estar explorando uma brecha para rastrear dados e estão dizendo 'se você atualizar seu robot.txt com nossas tags, poderá optar por não participar'", disse Tomchuk, mas isso coloca o ônus sobre os proprietários de empresas sobre como impedi-los.

Ele quer que outras pequenas empresas on-line saibam que a única maneira de descobrir se um bot de IA está acessando o conteúdo protegido por direitos autorais de um site é procurar ativamente por ele. Ele certamente não é o único que está sendo aterrorizado por eles. Outros proprietários de sites contaram recentemente ao Business Insider como os bots da OpenAI estavam destruindo seus sites e aumentando suas contas de AWS.

Em 2024, o problema está crescendo exponencialmente. Um novo estudo da empresa de publicidade digital DoubleVerify descobriu que os rastreadores de IA e as ferramentas de rastreamento levaram a um aumento de 861 TP3T no "tráfego inválido geral" em 2024, ou seja, o tráfego que não vem de usuários reais.

No entanto, "a maioria dos sites ainda não sabe que está sendo rastreada por esses bots", adverte Tomchuk. "Agora temos que monitorar a atividade de registro diariamente para identificar esses bots."

Pensando bem, todo o modelo funciona um pouco como uma extorsão da máfia: a menos que você esteja protegido, os bots de IA pegarão o que quiserem.

"Eles deveriam estar pedindo permissão, não apenas coletando dados", disse Tomchuk.

Leitura relacionada.

1. A OpenAI lançou uma nova ferramenta de rastreamento da Web chamada GPTBot para tratar de questões de privacidade e propriedade intelectual levantadas pela coleta de dados em sites públicos. O objetivo da tecnologia é coletar dados públicos da Web de forma transparente e usá-los para treinar seus modelos de IA, tudo sob a bandeira da OpenAI.

2. a OpenAI usa rastreadores da Web ("bots") e agentes de usuário para executar ações para seus produtos que são automatizadas ou acionadas por solicitações do usuário. a openAI usa a seguinte tag robots.txt para permitir que os webmasters gerenciem como seus sites e conteúdo funcionam com a IA . Cada configuração é independente das outras - por exemplo, um administrador de site pode permitir que o OAI-SearchBot apareça nos resultados de pesquisa e, ao mesmo tempo, desativar o GPTbot para indicar que o conteúdo rastreado não deve ser usado para treinar o modelo de base de IA generativa da OpenAI. Para resultados de pesquisa, observe que pode levar cerca de 24 horas para que os ajustes sejam feitos a partir da atualização do robots.txt de um site em nosso sistema.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...