Open-LLM-VTuber: um companheiro virtual de IA animado em Live2D para interação de voz em tempo real

Introdução geral

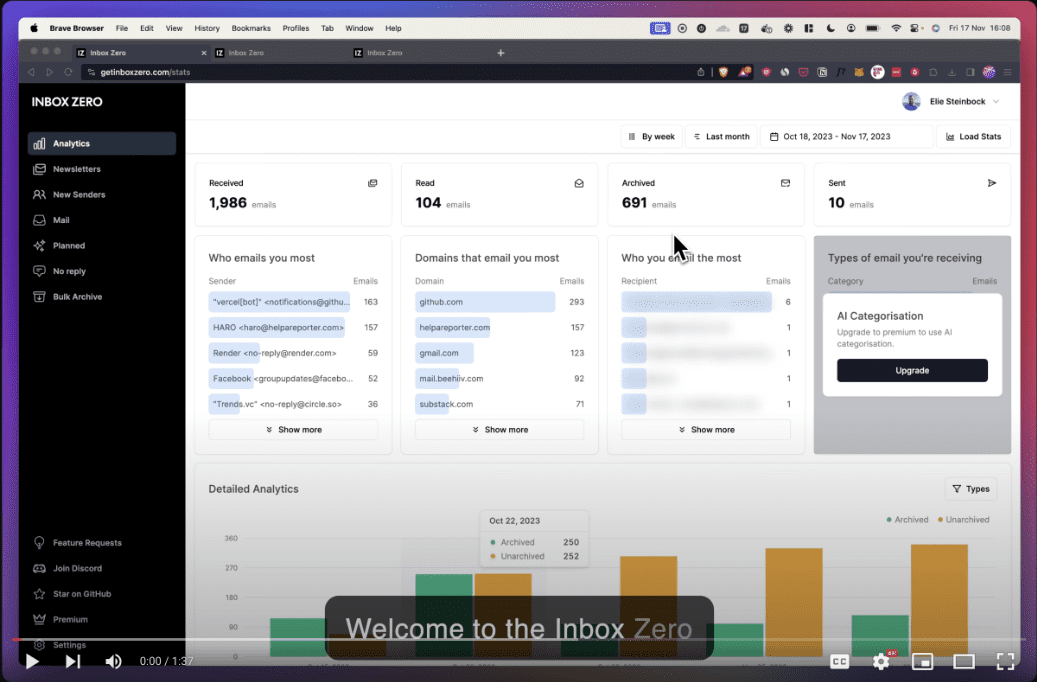

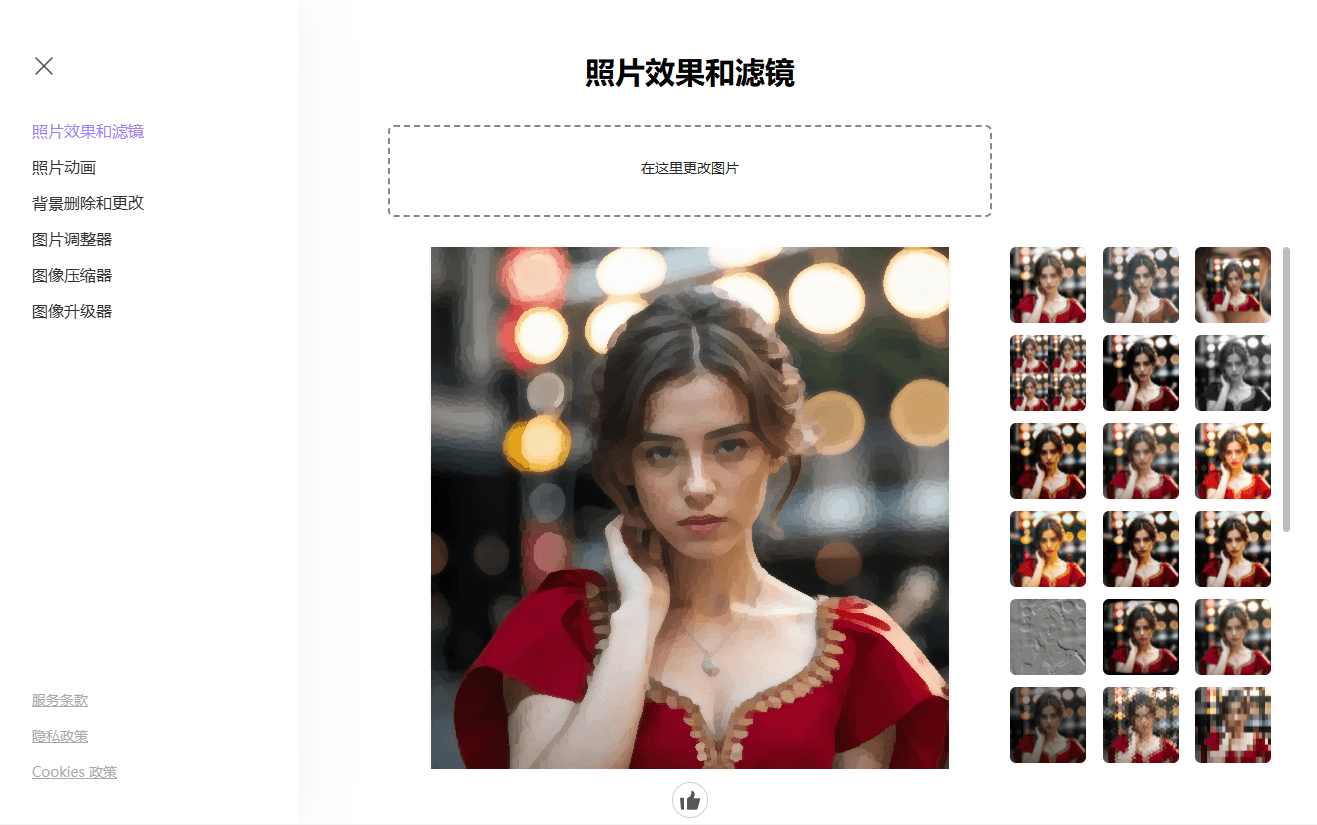

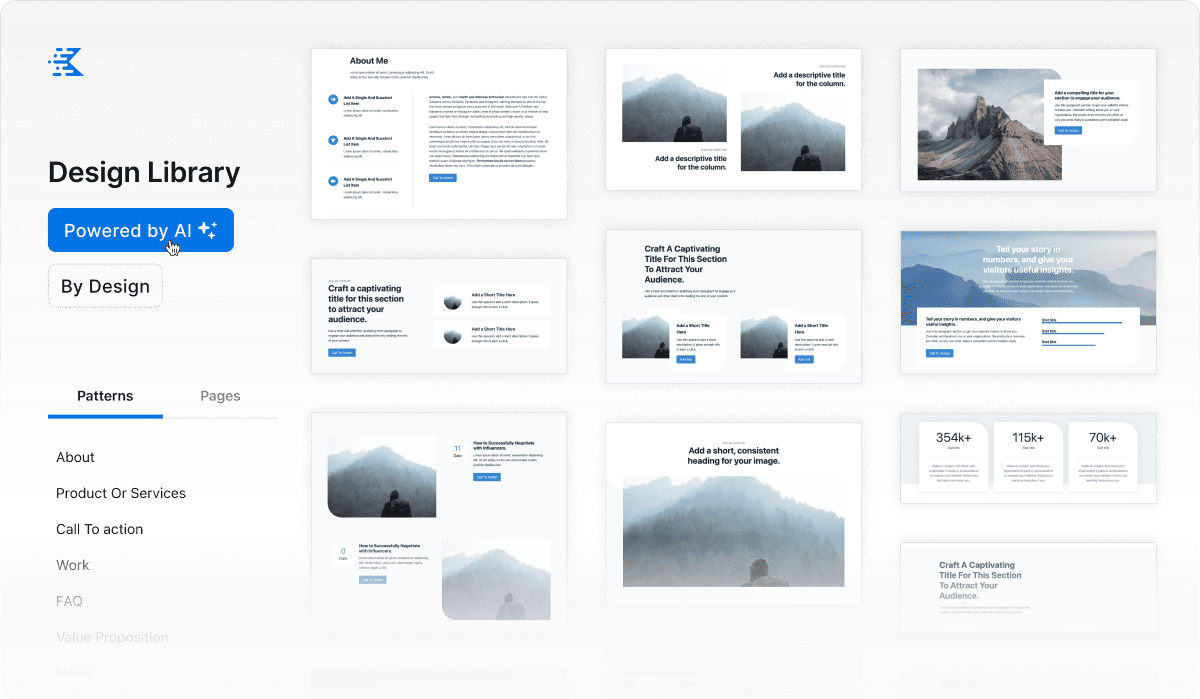

O Open-LLM-VTuber é um projeto de código aberto que permite que os usuários interajam com modelos de linguagem grande (LLMs) por meio de fala e texto, e incorpora a tecnologia Live2D para apresentar personagens virtuais dinâmicos. Ele é compatível com Windows, macOS e Linux, é executado totalmente off-line e tem modos de cliente da Web e de desktop. Os usuários podem usá-lo como namorada virtual, animal de estimação ou assistente de desktop, criando um companheiro de IA personalizado ao personalizar sua aparência, personalidade e voz. O projeto começou como uma réplica da âncora virtual de IA de código fechado "neuro-sama" e evoluiu para uma plataforma rica em recursos que suporta vários modelos de linguagem, reconhecimento de fala, conversão de texto em fala e percepção visual. A versão atual foi refatorada com a v1.0.0 e está em desenvolvimento ativo, com mais recursos a serem adicionados no futuro.

Lista de funções

- interação por vozSuporte ao diálogo de voz sem as mãos, os usuários podem interromper a IA a qualquer momento para uma comunicação tranquila.

- Animação Live2DAvatares dinâmicos incorporados que geram expressões e ações com base no conteúdo do diálogo.

- Suporte a várias plataformasCompatível com Windows, macOS e Linux, suporta operação de GPU e CPU NVIDIA/não-NVIDIA.

- operação off-lineTodas as funções podem ser executadas sem rede para garantir privacidade e segurança.

- Modo Desktop PetFundo transparente, topo global e penetração do mouse são suportados, e os caracteres podem ser arrastados para qualquer posição na tela.

- percepção visualInteração de vídeo com IA por meio de reconhecimento de conteúdo da câmera ou da tela.

- Suporte a vários modelosCompatível com uma ampla variedade de LLMs, como Ollama, OpenAI, Claude, Mistral e outros módulos de fala, como sherpa-onnx e Whisper.

- Personalização de personagensModelos Live2D podem ser importados para ajustar o caráter e a voz.

- feedback hápticoClique ou arraste o personagem para acionar uma resposta interativa.

- Manutenção de registros de bate-papoSuporte para alternar diálogos históricos e manter o conteúdo interativo.

Usando a Ajuda

Processo de instalação

O Open-LLM-VTuber precisa ser implantado localmente. Aqui estão as etapas detalhadas:

1. condições prévias

- softwareSuporte para computadores Windows, macOS ou Linux com GPUs NVIDIA recomendadas (pode ser executado sem uma GPU).

- hardwareInstale o Git, o Python 3.10+ e o uv (a ferramenta de gerenciamento de pacotes recomendada).

- reticulaçãoA implementação inicial requer uma conexão com a Internet para fazer o download da dependência; recomenda-se que os usuários chineses usem aceleração de proxy.

2. download do código

- Clone o projeto por meio do terminal:

git clone https://github.com/Open-LLM-VTuber/Open-LLM-VTuber --recursive cd Open-LLM-VTuber

- Ou baixe o arquivo ZIP mais recente da versão do GitHub e extraia-o.

- Observação: Se não for usado

--recursiveNecessário para executargit submodule update --initObtenha o submódulo de front-end.

3. instalação de dependências

- Instale o uv:

- Windows (PowerShell):

irm https://astral.sh/uv/install.ps1 | iex - macOS/Linux:

curl -LsSf https://astral.sh/uv/install.sh | sh

- Windows (PowerShell):

- Execute no diretório do projeto:

uv syncInstala automaticamente o FastAPI, o onnxruntime e outras dependências.

4. ambiente de configuração

- A primeira execução gera um arquivo de configuração:

uv run run_server.py - Editar o arquivo gerado

conf.yamlConfigure o seguinte:- LLMSelecione o modelo (por exemplo Ollama (para a API llama3 ou OpenAI, a chave precisa ser preenchida).

- ASRMódulo de reconhecimento de fala (por exemplo, sherpa-onnx).

- TTSMódulos de conversão de texto em fala (por exemplo, Edge TTS).

- Exemplo:

llm: provider: ollama model: llama3 asr: provider: sherpa-onnx tts: provider: edge-tts

5. ativação de serviços

- Em execução:

uv run run_server.py - entrevistas

http://localhost:8000Use a versão da Web ou faça o download do cliente para desktop para executá-la.

6. cliente de desktop (opcional)

- Download da versão do GitHub

open-llm-vtuber-electron(.exe para Windows, .dmg para macOS). - Inicie o cliente e certifique-se de que o serviço de back-end esteja em execução para experimentar o modo desktop pet.

7. atualização e desinstalação

- atualização: após a v1.0.0

uv run update.pyAtualizações, versões anteriores precisam ser reimplantadas com a documentação mais recente. - desinstalação: Exclua a pasta do projeto, verifique

MODELSCOPE_CACHEtalvezHF_HOMEarquivos de modelo, desinstalar ferramentas como o uv.

Função Fluxo de operação

interação por voz

- Ativar vozClique no ícone "Microfone" na página da Web ou no cliente.

- diálogosInterrupção: Fale diretamente e a IA responderá em tempo real; pressione o botão "Interrupt" para interromper a IA.

- otimização: em

conf.yamlAjuste os módulos ASR e TTS para melhorar o reconhecimento e a pronúncia.

Personalização de personagens

- Modelo de importaçãoColoque o arquivo .moc3 na pasta

frontend/live2d_modelsCatálogo. - Ajuste de personalidade:: Editorial

conf.yaml(usado em uma expressão nominal)promptComo uma "irmã mais velha gentil". - Personalização de somGravação de amostras usando ferramentas como o GPTSoVITS para gerar vozes exclusivas.

Modo Desktop Pet

- Modo abertoNo cliente, selecione "Desktop Pets", marque "Transparent Background" e "Top".

- imagem em movimentoArraste para qualquer posição na tela.

- interatividadeToque em um personagem para acionar o feedback tátil, ver um monólogo interno ou uma mudança de expressão.

percepção visual

- Ativar a câmeraClique em "Video Chat" para autorizar o acesso.

- reconhecimento na telaSelecione "Screen Sense" para que a IA analise o conteúdo da tela.

- exemplo típicoPergunte "what's on the screen" (o que está na tela) e a IA descreverá a imagem.

advertência

- navegador (software)Chrome é recomendado; outros navegadores podem afetar a exibição do Live2D.

- performancesAceleração da GPU: a aceleração da GPU requer drivers configurados corretamente e pode ser executada mais lentamente na CPU.

- licençaO modelo de amostra incorporado do Live2D está sujeito a uma licença separada; para uso comercial, entre em contato com a Live2D Inc.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...