Modelo de implantação local Ollama Access Dify

Dify Acesso ao suporte Ollama Implementação de recursos de inferência e incorporação de modelos de linguagem em larga escala.

Acesso rápido

- Baixar Ollama

entrevistas Instalação e configuração do OllamaPara obter mais informações, consulte o Tutorial de implantação local do Ollama. - Corra com Ollama e converse com Llama

ollama run llama3.1Após a inicialização bem-sucedida, o ollama inicia um serviço de API na porta local 11434, que pode ser acessado por meio do comando

http://localhost:11434Acesso.

Outros modelos estão disponíveis em https://ollama.ai/library para obter detalhes. - Acesso ao Ollama em Dify

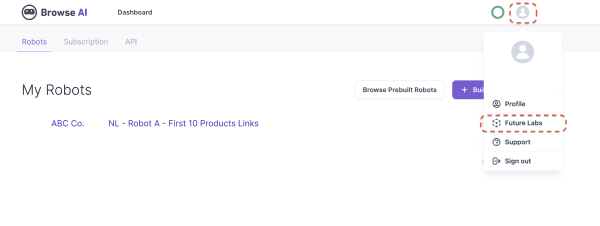

existir设置 > 模型供应商 > OllamaPreencha os espaços em branco:

- Nome do modelo:

llama3.1 - URL de base:

http://<your-ollama-endpoint-domain>:11434

O endereço do serviço Ollama que pode ser acessado é necessário aqui.

Se a Dify for implantada como uma doca, é recomendável preencher o endereço IP da LAN, por exemplo:http://192.168.1.100:11434ou o endereço IP do host da estação, por exemplo:http://172.17.0.1:11434.Observação: O comando Localizar endereço IP da LAN:

- No Linux/macOS, use o comando

ip addr showtalvezifconfig. - No Windows, use a opção

ipconfigpara encontrar endereços semelhantes. - Normalmente, esse endereço é exibido na interface eth0 ou wlan0, dependendo do fato de você estar usando uma rede com ou sem fio.

Se for implantado para o código-fonte local, preencha o campo

http://localhost:11434. - No Linux/macOS, use o comando

- Tipo de modelo:

对话 - Comprimento do contexto do modelo:

4096

O comprimento máximo do contexto do modelo; se não estiver claro, você pode preencher com o valor padrão 4096. - maior token Boné:

4096

O número máximo de tokens a ser retornado pelo modelo como conteúdo, que pode ser consistente com o comprimento do contexto do modelo, se não for especificado de outra forma pelo modelo. - Se o Vision é ou não compatível:

是

Quando o modelo oferece suporte à compreensão de imagens (multimodal), marque essa caixa, por exemplollava.

Clique em "Save" (Salvar) para verificar se o modelo está correto e pode ser usado em seu aplicativo.

O modelo Embedding é acessado de forma semelhante ao LLM, alterando o tipo de modelo para Text Embedding. - Nome do modelo:

- Usando o modelo Ollama

Vá para a página App Prompt Orchestration do aplicativo que você deseja configurar e selecione o provedor Ollama na seçãollama3.1configure os parâmetros do modelo e use-o.

PERGUNTAS FREQUENTES

⚠️ Se estiver usando o Docker para implantar o Dify e o Ollama, você poderá encontrar o seguinte erro.

httpconnectionpool(host=127.0.0.1, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost, port=11434): max retries exceeded with url:/cpi/chat (Caused by NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>: fail to establish a new connection:[Errno 111] Connection refused'))

Esse erro ocorre porque o contêiner do Docker não consegue acessar o serviço Ollama. O localhost geralmente se refere ao próprio contêiner, não ao host ou a outros contêineres. Para resolver esse problema, você precisa expor o serviço Ollama à rede.

Definição de variáveis de ambiente em um Mac

no caso de Ollama atuar como macOS estiver em execução, o seguinte comando deve ser usado para definir as variáveis de ambientelaunchctl ::

- Isso é feito chamando o

launchctl setenvConfiguração de variáveis de ambiente:launchctl setenv OLLAMA_HOST "0.0.0.0" - Reinicie o aplicativo Ollama.

- Se as etapas acima não funcionarem, você pode usar o seguinte método:

O problema é que, dentro do docker, você deve se conectar aohost.docker.internalpara acessar o host da estação, portanto, defina olocalhostSubstituir porhost.docker.internalO serviço está pronto para entrar em vigor:http://host.docker.internal:11434

Configuração de variáveis de ambiente no Linux

Se o Ollama estiver sendo executado como um serviço systemd, você deverá usar o comando systemctl Configuração de variáveis de ambiente:

- Isso é feito chamando o

systemctl edit ollama.serviceEdite o serviço systemd. Isso abrirá um editor. - Para cada variável de ambiente, a variável

[Service]Adicione uma linha abaixo da seçãoEnvironment::[Service] Environment="OLLAMA_HOST=0.0.0.0" - Salvar e sair.

- carga pesada (em um caminhão)

systemde reiniciar o Ollama:systemctl daemon-reload systemctl restart ollama

Configuração de variáveis de ambiente no Windows

No Windows, o Ollama herda as variáveis de ambiente do usuário e do sistema.

- Em primeiro lugar, clique em Ollama na barra de tarefas para sair do programa.

- Edite as variáveis de ambiente do sistema no painel de controle

- Edite ou crie novas variáveis para sua conta de usuário, como

OLLAMA_HOSTeOLLAMA_MODELSetc. - Clique em OK/Apply para salvar o aplicativo

- Executar em uma nova janela de terminal

ollama

Como faço para expor o Ollama em minha rede?

O Ollama se vincula à porta 11434 em 127.0.0.1 por padrão. OLLAMA_HOST As variáveis de ambiente alteram o endereço de vinculação.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...