o3 Demonstração prática da superioridade dos modelos de inferência genéricos em relação aos modelos de programação especializados em domínios de programação

Texto original:Um estudo sobre a competência em competições de programação com base em um modelo de raciocínio amploPara facilitar a leitura, apresentamos a seguir um breve resumo.

1. introdução

1.1 Histórico e motivação

Nos últimos anos, os modelos de linguagem grande (LLMs) fizeram um progresso significativo na geração de programas e em tarefas de raciocínio complexas. As competições de programação, especialmente as plataformas como a International Olympiad in Informatics (IOI) e a CodeForces, são bancos de testes ideais para avaliar os recursos de raciocínio dos sistemas de IA devido às suas rigorosas exigências de raciocínio lógico e habilidades de resolução de problemas.

1.2 Objetivos do estudo

Este estudo tem o objetivo de explorar as seguintes questões:

- Comparação de desempenho de modelos de raciocínio genéricos e específicos do domínioComparação do desempenho de modelos de inferência de uso geral (por exemplo, o1 e o3 da OpenAI) com modelos específicos de domínio projetados especificamente para competições de IOI (por exemplo, o1-ioi).

- O papel da aprendizagem por reforço no aprimoramento das habilidades de raciocínio de modelos: Avaliação do desempenho de grandes modelos de inferência treinados por aprendizado por reforço (RL) em tarefas de programação complexas.

- O surgimento de estratégias de raciocínio autônomo de modelosObservação: observe se o modelo pode desenvolver de forma autônoma estratégias de raciocínio eficazes sem intervenção humana.

2. metodologia

2.1 Introdução ao modelo

2.1.1 OpenAI o1

O OpenAI o1 é um modelo de linguagem em grande escala treinado pelo aprendizado por reforço para gerar e executar códigos. Ele resolve problemas passo a passo, gerando uma cadeia interna de raciocínio, otimizada pela RL.

2.1.2 OpenAI o1-ioi

O o1-ioi é uma versão aprimorada do o1, ajustada especificamente para a competição IOI. Ele emprega uma estratégia de tempo de teste semelhante ao sistema AlphaCode, que consiste em gerar um grande número de soluções candidatas para cada subtarefa e selecionar o melhor envio por meio de agrupamento e reordenação.

2.1.3 OpenAI o3

O o3 é o sucessor do o1 e melhora ainda mais a capacidade de inferência do modelo. Diferentemente do o1-ioi, o o3 não depende de estratégias de tempo de teste projetadas manualmente, mas desenvolve de forma autônoma estratégias de inferência complexas por meio de treinamento de RL de ponta a ponta.

2.2 Metodologia de avaliação

2.2.1 Competições de simulação do CodeForces

Simulamos o ambiente de competição do CodeForces, usando o conjunto completo de testes e impondo restrições apropriadas de tempo e memória para avaliar o desempenho do modelo.

2.2.2 Concurso ao vivo IOI 2024

O o1-ioi participou da competição IOI 2024, competindo nas mesmas condições que os competidores humanos.

2.2.3 Avaliação de tarefas de engenharia de software

Também avaliamos o desempenho do modelo nos conjuntos de dados HackerRank Astra e SWE-bench Verified para testar seus recursos em tarefas reais de desenvolvimento de software.

3. descoberta

3.1 Modelos genéricos versus modelos específicos de domínio

- o1-ioi na competição da IOINa competição da IOI de 2024, o o1-ioi marcou 213 pontos e ficou na posição 49%. Depois de relaxar as restrições de envio, sua pontuação melhorou para 362,14 pontos, o que está acima da linha de pontuação da medalha de ouro.

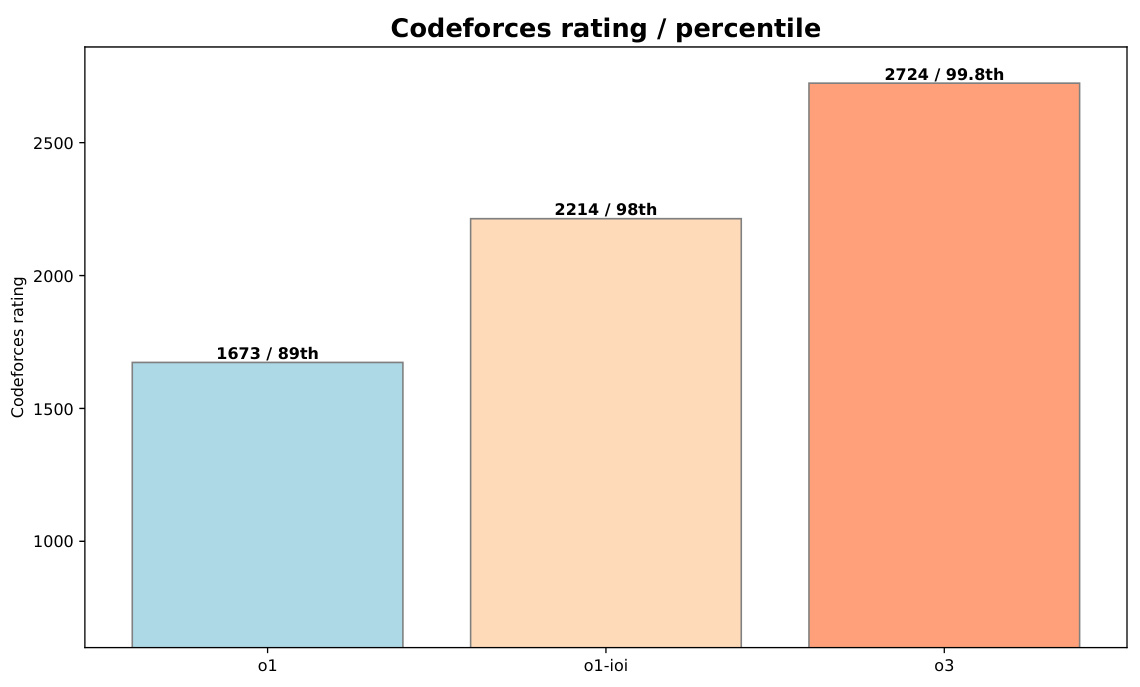

- o3 excelênciaO o3 teve um bom desempenho no benchmark CodeForces com uma classificação de 2724 (percentil 99,8), significativamente melhor que o o1-ioi (2214, percentil 98). No benchmark IOI 2024, o o3 também obteve uma pontuação de 395,64, excedendo a linha de pontuação da medalha de ouro, com um limite de apenas 50 envios.

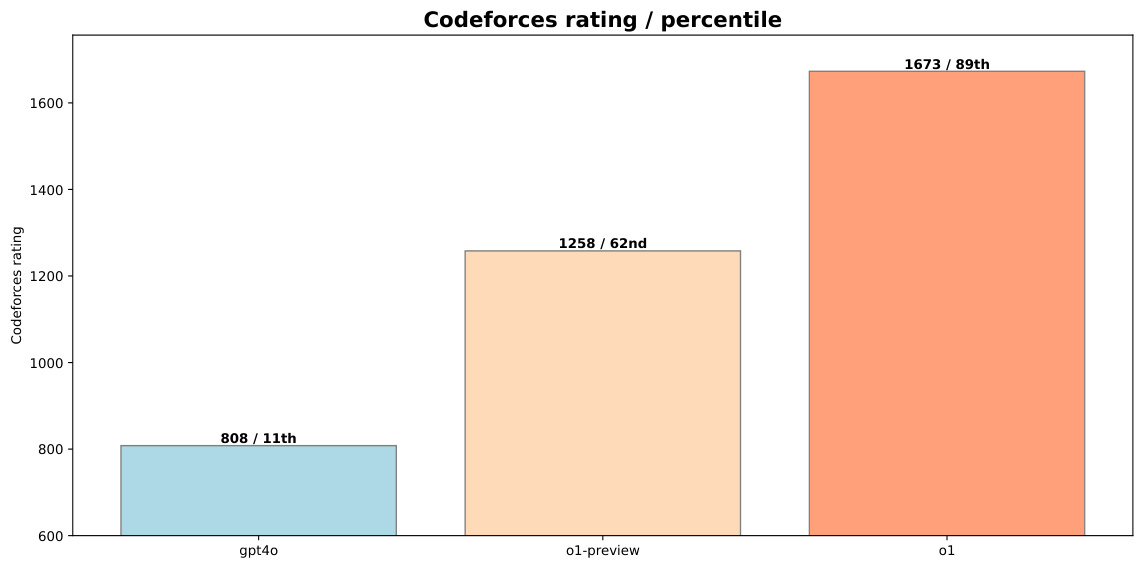

Figura 1: Comparação do desempenho do o1-preview e do o1 com gpt-4o no CodeForces

3.2 Aprimorando o papel da aprendizagem

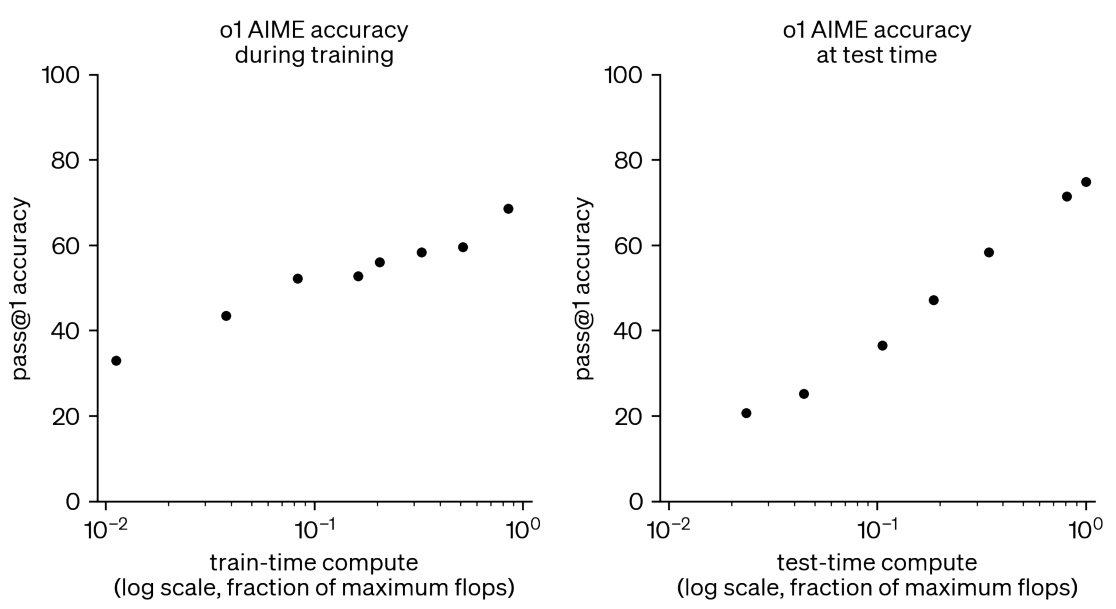

- Aumento da computação durante o treinamento e o teste de RLComo mostrado na Fig. 2, o aumento dos recursos computacionais durante o treinamento e o teste de RL pode melhorar significativamente o desempenho do modelo em tarefas matemáticas competitivas.

Figura 2: O treinamento adicional de RL e a computação em tempo de teste melhoram o desempenho em tarefas competitivas de matemática

3.3 Surgimento de estratégias de raciocínio autônomo de modelos

- Estratégias de raciocínio autônomo para o3O o3 apresenta cadeias de raciocínio mais complexas e ponderadas quando testado. Por exemplo, para problemas que requerem validação, ele gera soluções simples de força bruta e, em seguida, compara sua saída com uma implementação mais otimizada do algoritmo para detectar possíveis erros.

Figura 3: A própria solução de teste do o3, refletindo uma implementação parcial da estratégia de tempo de teste usada pelo o1-ioi no IOI 2024

4. conclusão

4.1 Principais conclusões

- Superioridade dos modelos generalizadosModelos específicos de domínio (por exemplo, o1-ioi) têm bom desempenho em tarefas específicas, mas os modelos de uso geral (por exemplo, o3) treinados em RL de larga escala conseguem superar esses resultados sem depender de heurística de inferência projetada manualmente.

- Eficácia do treinamento de RLA adição de recursos computacionais de treinamento e teste de RL pode melhorar consistentemente o desempenho do modelo, aproximando-o do desempenho dos melhores jogadores humanos do mundo.

- Modelagem da capacidade de desenvolver estratégias complexas de forma autônomaO O3 demonstra a capacidade do modelo de desenvolver de forma autônoma estratégias de inferência complexas, eliminando a necessidade de estratégias de tempo de teste projetadas manualmente.

4.2 Perspectivas futuras

Os resultados deste estudo mostram que o treinamento de RL em larga escala oferece um caminho robusto para obter IA de última geração em domínios de raciocínio, como a programação competitiva. No futuro, espera-se que os modelos de inferência de grande porte revelem muitos novos cenários de aplicação em diversos campos, como ciência, codificação e matemática.

5. exemplos

5.1 Exemplos de soluções da competição IOI 2024

5.1.1 Problema do Nilo

o1-ioi obteve nota máxima no problema do Nilo, aqui está o código de exemplo para a solução:

#include "nile.h"

#include <bits/stdc++.h>

using namespace std;

// ... (代码省略,详见附录C.1)

5.1.2 Problema de mensagem

o1-ioi obteve 79,64 pontos no problema Message e aqui está o código de exemplo para a solução:

#include "message.h"

#include <bits/stdc++.h>

using namespace std;

// ... (代码省略,详见附录C.2)

5.2 Exemplos de soluções em tarefas de engenharia de software

5.2.1 Conjunto de dados do HackerRank Astra

o1 no conjunto de dados do HackerRank Astra:

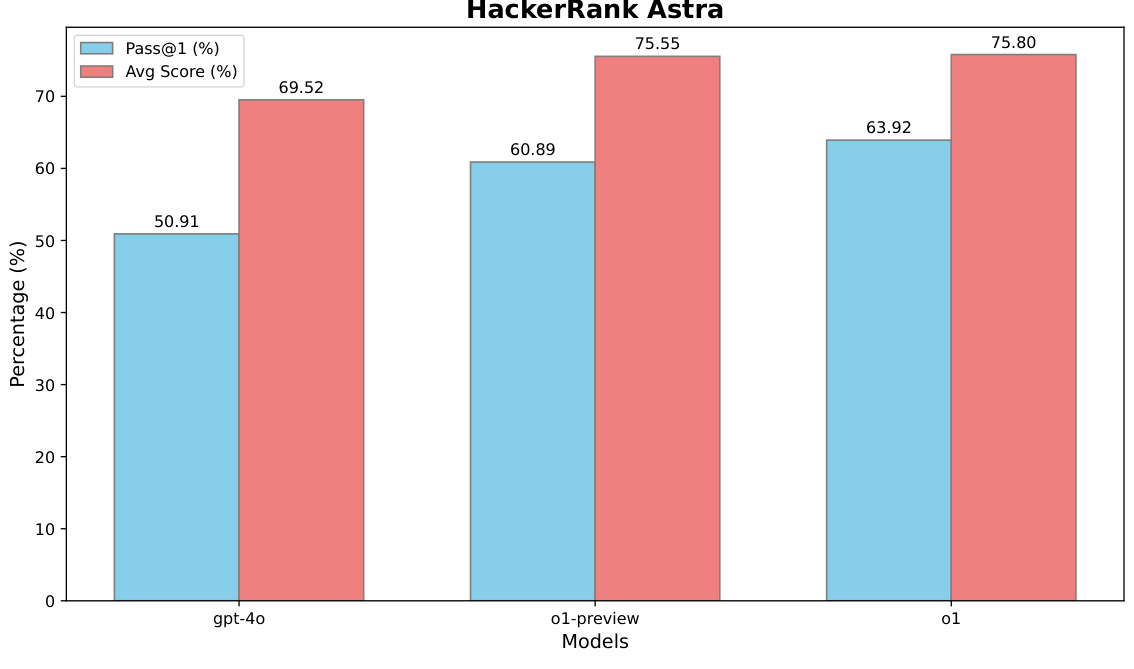

Figura 4: Desempenho de o1 no conjunto de dados HackerRank Astra

5.2.2 Conjunto de dados verificado do SWE-bench

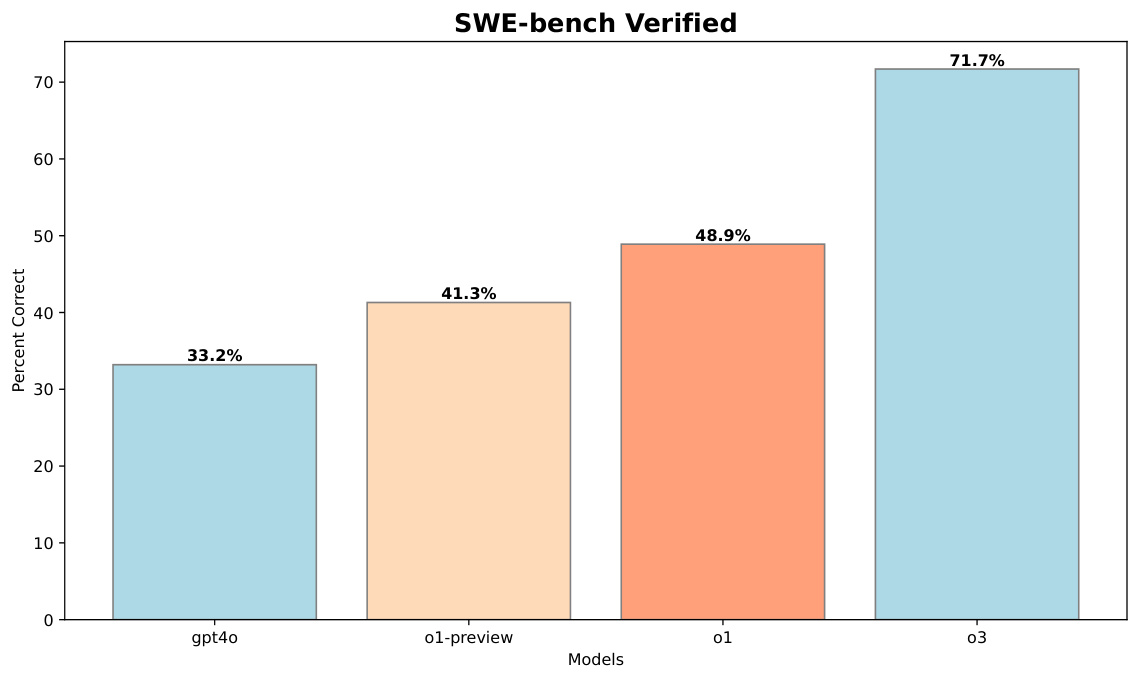

o3 no conjunto de dados SWE-bench Verified:

Figura 5: Desempenho do o3 no conjunto de dados SWE-bench Verified

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...