Modelo de geração de vídeo Mochi 1: SOTA em modelos de geração de vídeo de código aberto

Genmo AI é um laboratório de inteligência artificial de ponta, dedicado ao desenvolvimento de modelos de geração de vídeo de código aberto de última geração. Seu principal produto, o Mochi 1, é um modelo de geração de vídeo de código aberto capaz de gerar vídeos de alta qualidade a partir de dicas textuais. O objetivo da Genmo é impulsionar a inovação em inteligência artificial por meio da tecnologia de geração de vídeo, oferecendo possibilidades ilimitadas de exploração e criação virtual.

Models é uma biblioteca de código aberto de modelos de geração de vídeo, com os modelos mais recentes do Mochi 1. O Mochi 1 é baseado no Asymmetric Diffusion. Transformador A arquitetura AsymmDiT (AsymmDiT), com 1 bilhão de parâmetros, é o maior modelo de geração de vídeo lançado publicamente. O modelo é capaz de gerar vídeos de ação suaves e de alta qualidade que respondem a dicas textuais.

O Mochi 1 Preview é um modelo aberto e avançado de geração de vídeo com movimento de alta fidelidade e forte acompanhamento de dicas. Nosso novo modelo preenche significativamente a lacuna entre os sistemas de geração de vídeo fechados e abertos. Estaremos liberando o modelo sob uma licença liberal Apache 2.0.

Endereço de visualização do Mochi 1

Hugging Face (pesos do modelo)

Playground (demonstração on-line)

[bilibili]https://www.bilibili.com/video/BV1FRy6YeEui/[/bilibili]

Lista de funções

- Geração de vídeoGeração de conteúdo de vídeo de alta qualidade com a inserção de prompts de texto.

- modelo de código abertoMochi 1 está disponível como um modelo de código aberto, permitindo a adaptação individual e o desenvolvimento secundário pelo usuário.

- Qualidade de movimento de alta fidelidadeGeração de vídeos com movimentos suaves e física de alta fidelidade.

- Alinhamento potente do tacoCapacidade de gerar vídeos que atendam com precisão às necessidades do usuário com base em instruções de texto.

- Suporte à comunidadeFornecer uma plataforma de comunidade em que os usuários possam compartilhar e discutir o conteúdo de vídeo gerado.

- Suporte a várias plataformasSuporte para uso em várias plataformas, inclusive na Web e em dispositivos móveis.

Arquitetura do modelo Mochi 1

O Mochi 1 representa um avanço significativo na geração de vídeo de código aberto com um modelo de difusão de 10 bilhões de parâmetros baseado em nossa nova arquitetura Asymmetric Diffusion Transformer (AsymmDiT). Treinado inteiramente do zero, é o maior modelo de geração de vídeo já lançado publicamente. E o mais importante é que se trata de uma arquitetura simples e que pode ser hackeada.

A eficiência é fundamental para garantir que a comunidade possa executar nossos modelos. Além do Mochi, também abrimos o código-fonte do nosso VAE de vídeo, que comprime o vídeo em um tamanho 128 vezes menor, usando espaço 8x8 e compressão de tempo 6x para 12 canais de espaço potencial.

O AsymmDiT processa com eficiência as dicas do usuário e os marcadores de vídeo compactados, simplificando o processamento de texto e concentrando a capacidade da rede neural na inferência visual. O AsymmDiT usa um mecanismo de autoatenção multimodal para se concentrar conjuntamente no texto e nos marcadores visuais e aprende uma camada MLP separada para cada modalidade, semelhante à difusão estável.3 No entanto, devido às grandes dimensões ocultas, nossos têm quase quatro vezes mais parâmetros para o fluxo visual do que para o fluxo de texto. Para unificar as modalidades no mecanismo de autoatenção, usamos um QKV assimétrico e uma camada de projeção de saída. Esse design assimétrico reduz os requisitos de memória de inferência.

Muitos modelos modernos de propagação usam vários modelos de linguagem pré-treinados para representar as solicitações do usuário. Em contrapartida, o Mochi 1 codifica as dicas usando apenas um único modelo de linguagem T5-XXL.

A Mochi 1 usa um mecanismo de atenção 3D completo para raciocinar em conjunto em uma janela de contexto de 44.520 marcadores de vídeo. Para localizar cada marcador, estendemos a incorporação de posição rotacional (RoPE) aprendida para 3 dimensões. A rede aprende uma mistura de frequências de eixos espaciais e temporais de ponta a ponta.

O Mochi se beneficia de alguns dos mais recentes aprimoramentos em extensões de modelos de linguagem, incluindo a camada de alimentação SwiGLU, normalização de chave de consulta para aprimoramento da estabilidade e normalização de mezanino para controle da ativação interna.

Em seguida, será publicado um documento técnico que fornecerá mais detalhes para facilitar os avanços na geração de vídeos.

Processo de instalação do Mochi 1

- armazém de clones ::

git clone https://github.com/genmoai/models

cd models

- Instalação de dependências ::

pip install uv

uv venv .venv

source .venv/bin/activate

uv pip install -e .

- Download dos pesos do modelo Download do arquivo de pesos do Hugging Face ou por meio de um link magnético e salve-o em uma pasta local.

Processo de uso

- Iniciando a interface do usuário ::

python3 -m mochi_preview.gradio_ui --model_dir "<path_to_downloaded_directory>"

intercambialidade<path_to_downloaded_directory>é o diretório onde estão localizados os pesos do modelo.

- Geração de vídeo por linha de comando ::

python3 -m mochi_preview.infer --prompt "A hand with delicate fingers picks up a bright yellow lemon from a wooden bowl filled with lemons and sprigs of mint against a peach-colored background. The hand gently tosses the lemon up and catches it, showcasing its smooth texture. A beige string bag sits beside the bowl, adding a rustic touch to the scene. Additional lemons, one halved, are scattered around the base of the bowl. The even lighting enhances the vibrant colors and creates a fresh, inviting atmosphere." --seed 1710977262 --cfg_scale 4.5 --model_dir "<path_to_downloaded_directory>"

intercambialidade<path_to_downloaded_directory>é o diretório onde estão localizados os pesos do modelo.

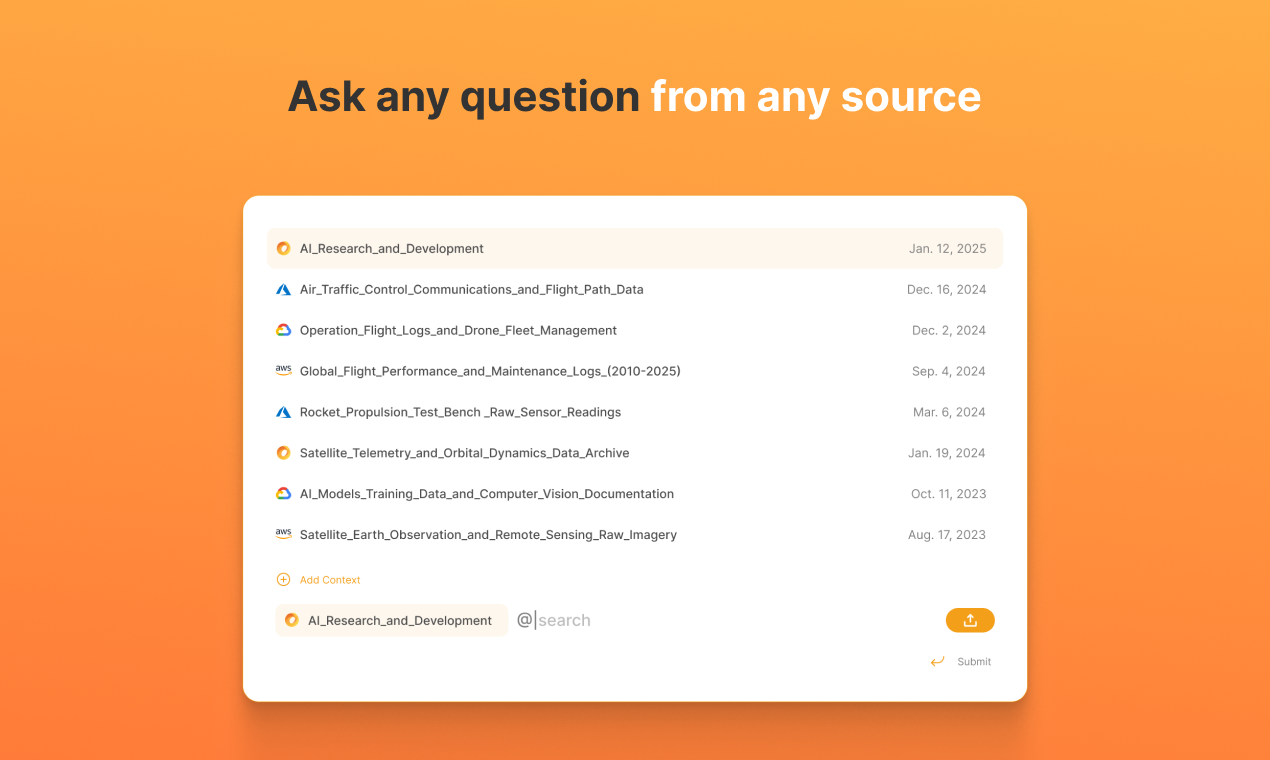

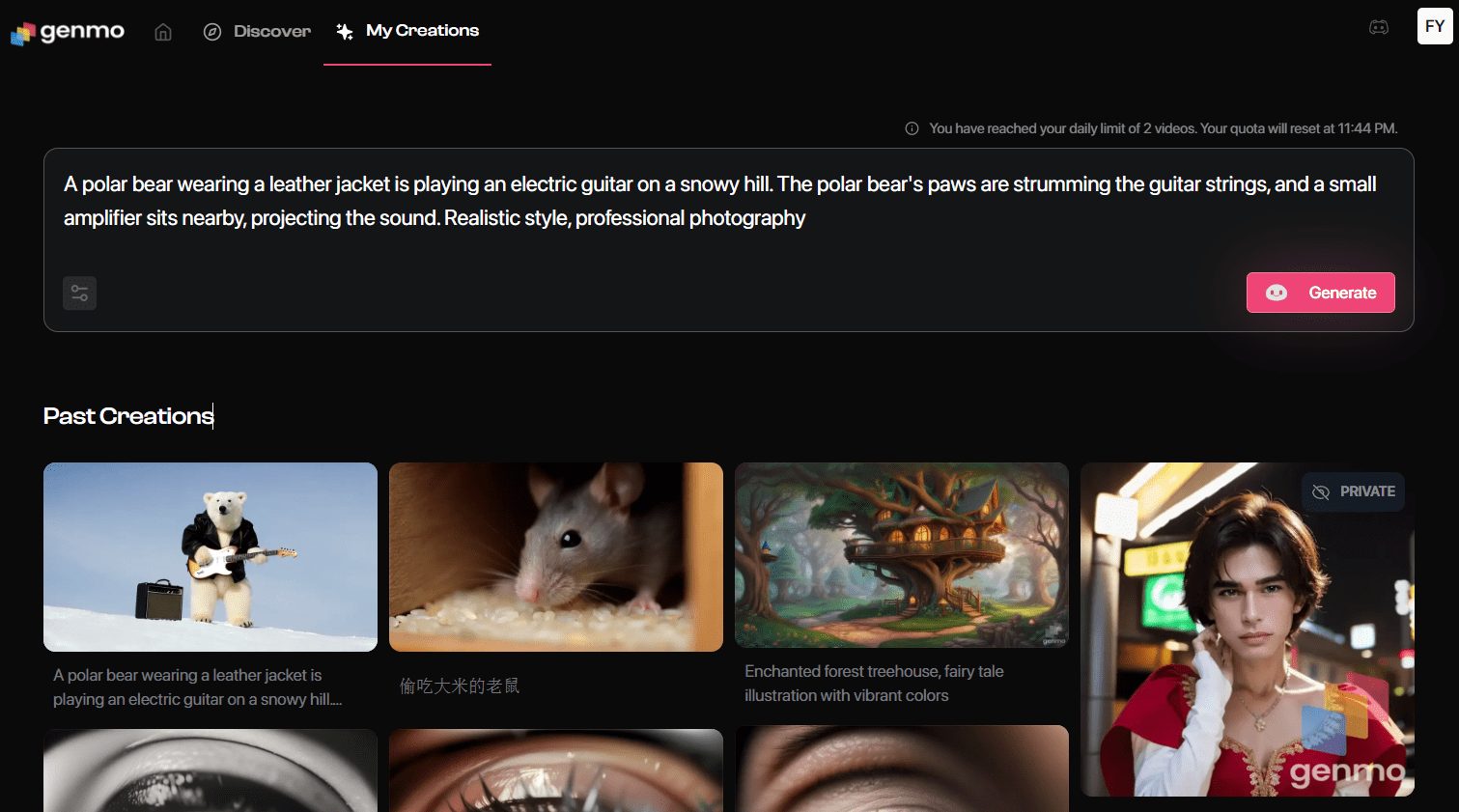

Experimente o Mochi 1 on-line

- Ir para a página de geraçãoApós fazer o login, clique em "Playground" para entrar na página de geração de vídeo.

- prompt de entradaDescrição do vídeo: Digite a descrição do vídeo que você deseja gerar na caixa de prompt. Por exemplo: "Um trailer de filme sobre as aventuras de um astronauta de 30 anos com um capacete de lã vermelho de motociclista".

- Seleção de configuraçõesSelecione o estilo de vídeo, a resolução e outras configurações, conforme necessário.

- Gerar vídeoClique no botão "Generate" (Gerar) e o sistema gerará o vídeo de acordo com suas instruções.

- Baixar e compartilharDepois de gerado, o vídeo pode ser visualizado e baixado localmente ou compartilhado diretamente em plataformas de mídia social.

Recursos avançados

- Modelos personalizadosOs usuários podem fazer o download dos pesos do modelo para o Mochi 1, treiná-los e ajustá-los localmente para personalização.

- Interação com a comunidadeParticipe da comunidade do Genmo no Discord para trocar experiências e compartilhar vídeos gerados com outros usuários.

- Interface APIOs desenvolvedores podem usar a interface API fornecida pelo Genmo para integrar a funcionalidade de geração de vídeo em seus aplicativos.

problemas comuns

- Falha na geração de vídeoVerifique se as instruções do prompt inseridas são claras e específicas, evitando descrições vagas ou complexas.

- Problemas de loginSe não conseguir fazer login, verifique sua conexão com a Internet ou tente usar um navegador diferente.

- Download do modeloVisite a página do Genmo no GitHub para fazer o download dos pesos mais recentes do modelo Mochi 1.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...