A Mistral lança o Mistral Small 3 de código aberto: o desempenho rivaliza com o GPT-4o e supera o Llama 3

Mistral Pequeno 3: protocolo Apache 2.0, 81% MMLU, 150 tokens/s.

Hoje, a Mistral AI lançou o Mistral Small 3, um modelo de 24 bilhões de parâmetros otimizado para latência, e o lançou sob o protocolo Apache 2.0.

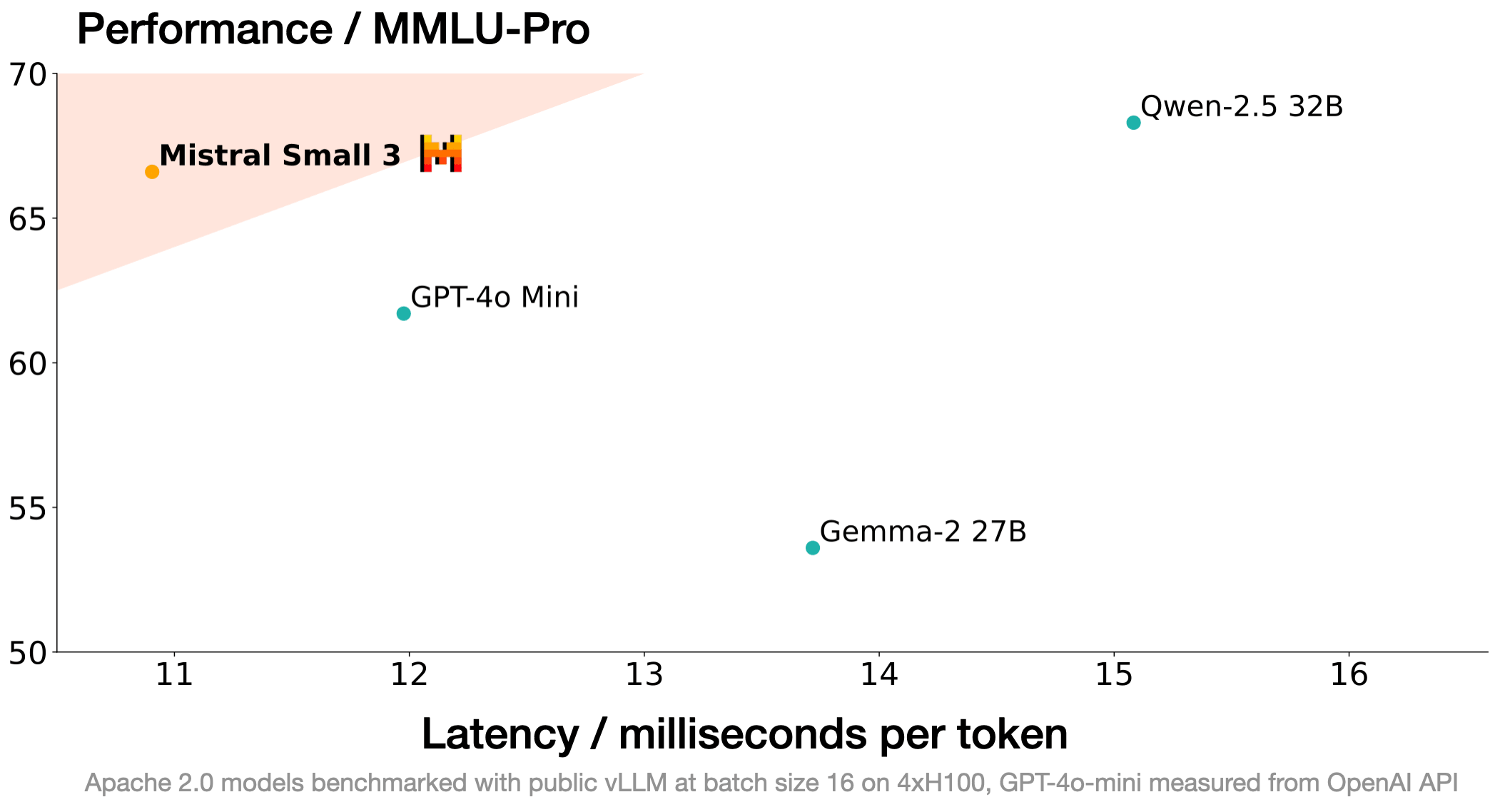

O Mistral Small 3 é comparável aos modelos maiores, como o Llama 3.3 70B ou o Qwen 32B, e é uma excelente alternativa de código aberto aos modelos proprietários opacos, como o GPT4o-mini. O Mistral Small 3 é comparável ao Llama 3.3 70B instruct, mas é mais de três vezes mais rápido no mesmo hardware.

O Mistral Small 3 é um modelo pré-treinado e com ajuste fino de instruções, projetado para atender às necessidades do '80%' em tarefas de IA generativa que exigem fortes recursos linguísticos e desempenho de aderência às instruções com latência muito baixa.

IA Mistral Esse novo modelo foi projetado para saturar o desempenho em uma escala adequada para a implantação local. Com uma precisão MMLU de mais de 81% e uma latência de 150 tokens/segundo, o Mistral Small é o modelo mais eficiente de seu tipo até o momento.

A Mistral AI está lançando pontos de verificação de pré-treinamento e ajuste fino de instruções sob o protocolo Apache 2.0. Esses pontos de verificação podem servir como uma base poderosa para o progresso acelerado. Observe que o Mistral Small 3 não é treinado usando nem o aprendizado por reforço (RL) nem dados sintéticos e, portanto, é mais eficiente no processo de produção de modelos do que o Mistral Small 3. Deepseek R1 (uma tecnologia de código aberto excelente e complementar!) A Mistral AI está ansiosa para ver como a comunidade de código aberto a adota e personaliza. Ele pode servir como um ótimo modelo básico para a construção de poder de raciocínio cumulativo. A Mistral AI está ansiosa para ver como a comunidade de código aberto o adota e personaliza.

performances

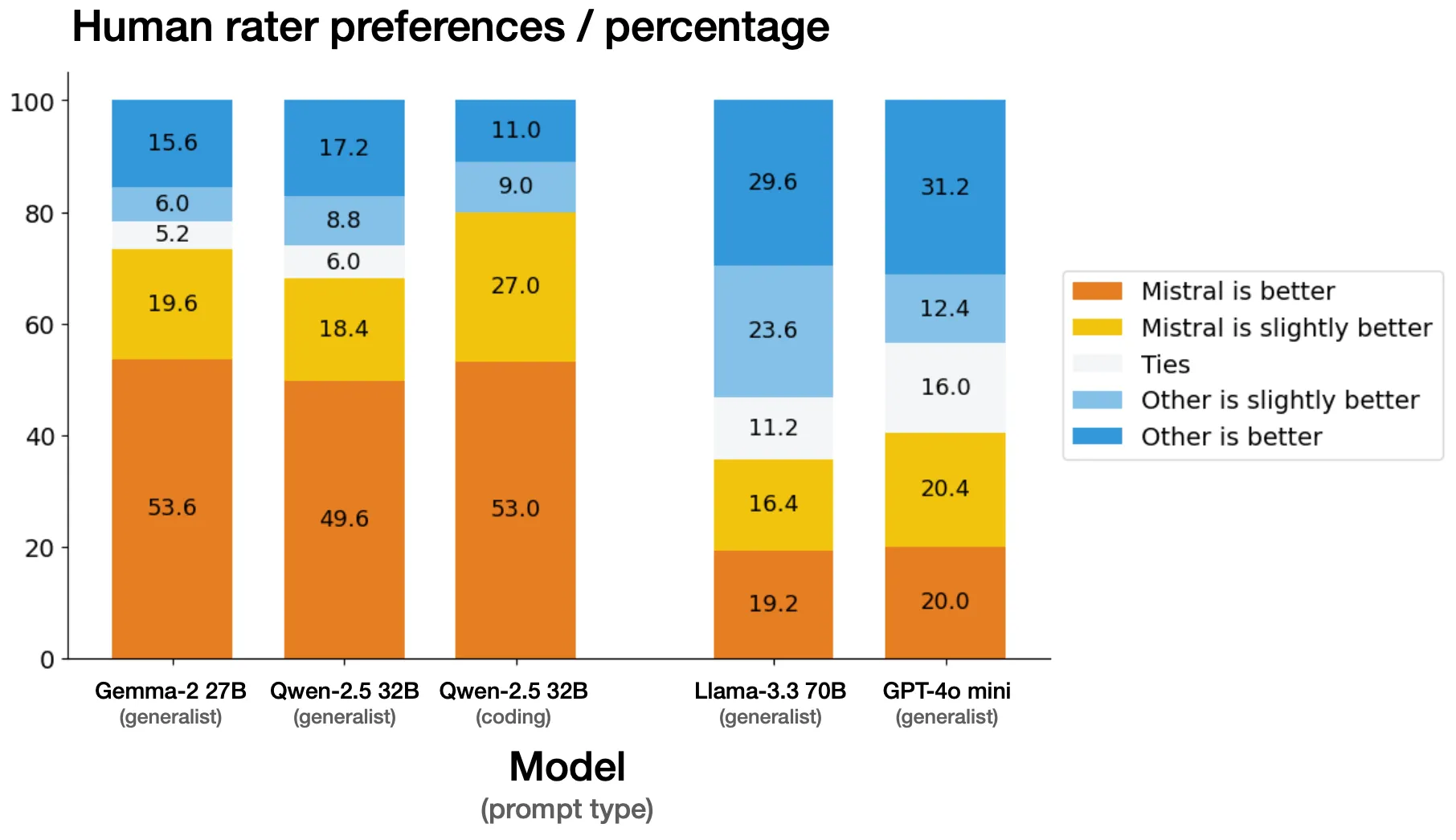

avaliação manual

A Mistral AI realizou avaliações lado a lado em um conjunto de mais de 1.000 códigos proprietários e dicas genéricas com um fornecedor externo de terceiros. Os avaliadores foram encarregados de selecionar sua resposta de modelo preferida a partir de um resultado anônimo gerado pelo Mistral Small 3 versus outro modelo. A Mistral AI está ciente de que, em alguns casos, os benchmarks de julgamento humano diferem significativamente dos benchmarks publicamente disponíveis, mas a Mistral AI tomou um cuidado extra para verificar a imparcialidade da avaliação. válidos.

função de diretriz

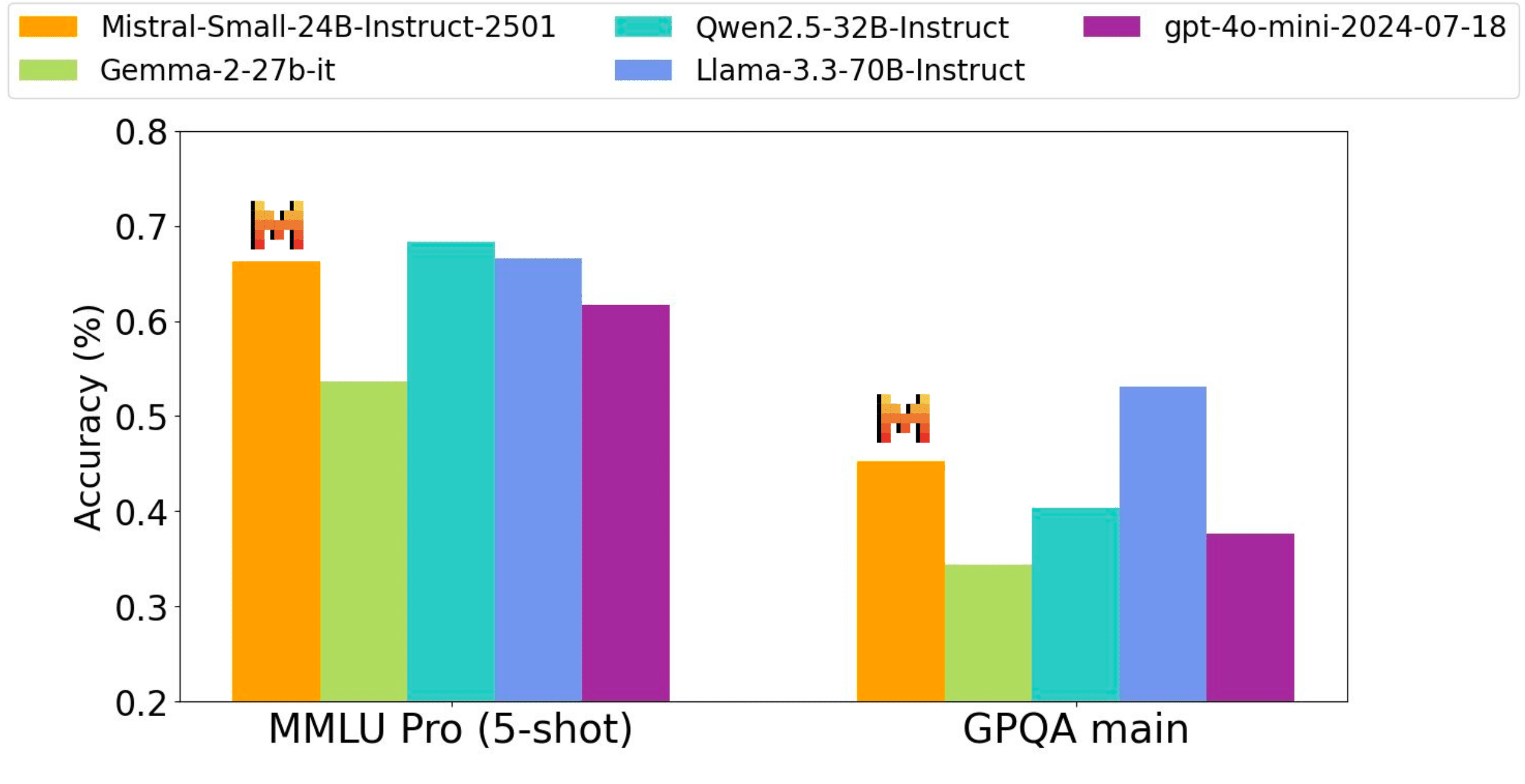

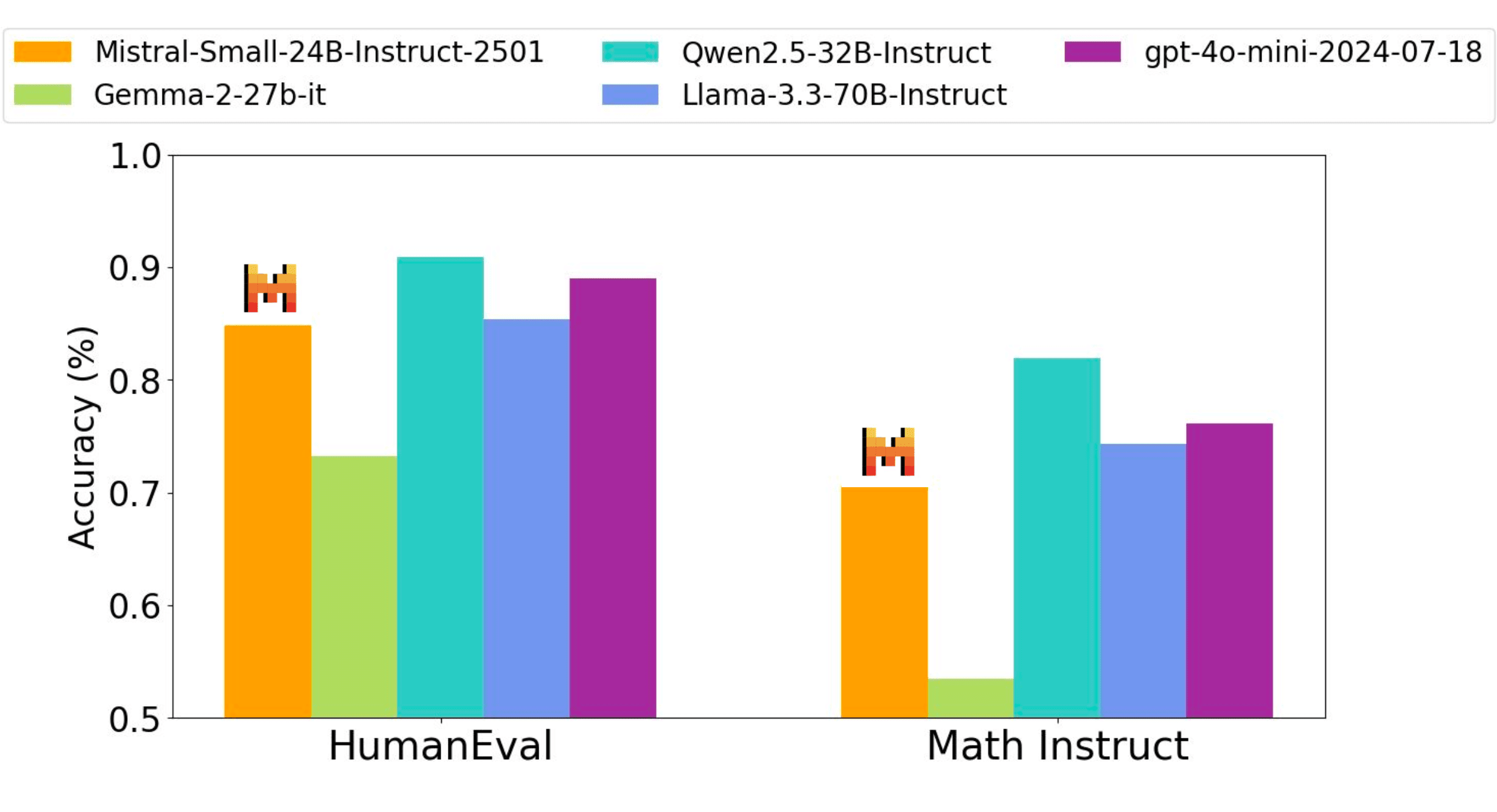

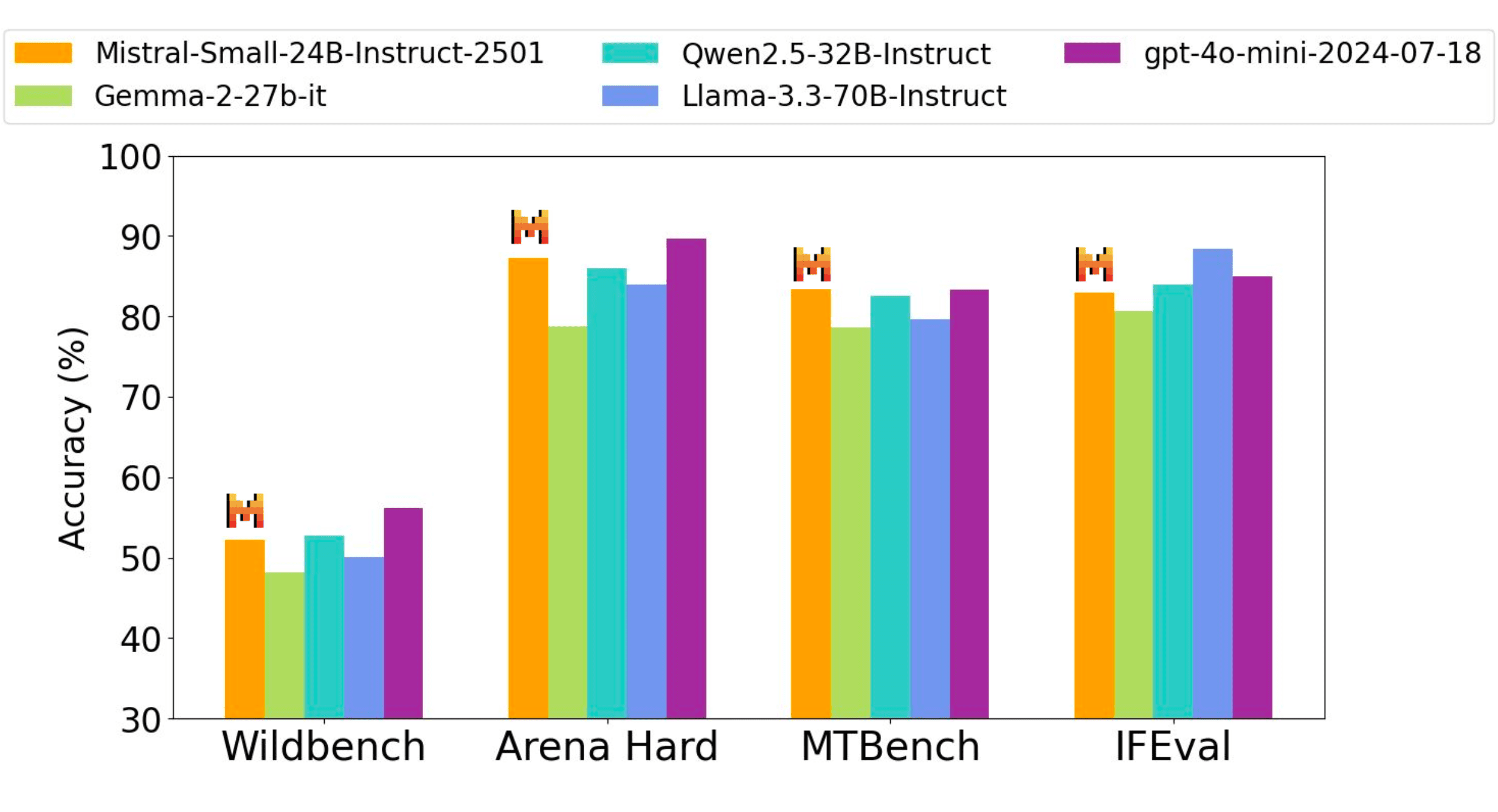

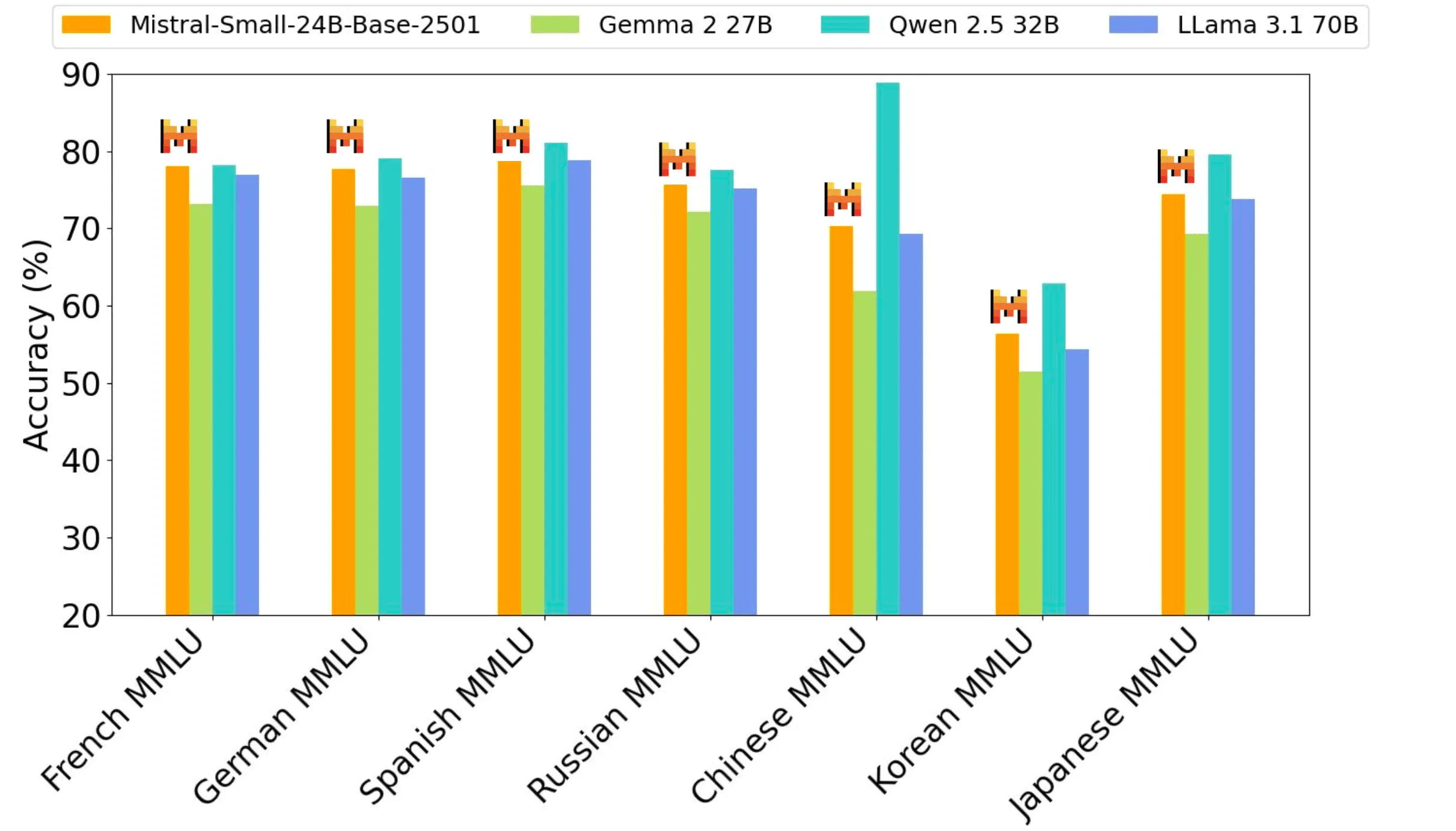

O modelo de ajuste fino de instruções da Mistral AI tem uma vantagem competitiva sobre os modelos de ponderação de código aberto que são três vezes maiores, bem como sobre o modelo proprietário GPT4o-mini, em benchmarks de código, matemática, conhecimento geral e instrução.

A precisão do desempenho de todos os benchmarks é obtida por meio do mesmo processo de avaliação interna; portanto, os números podem ser ligeiramente diferentes do desempenho relatado anteriormente (Qwen2.5-32B-Instruct, Llama-3.3-70B-Instruct, Gemma-2-27B-IT). Wildbench, Arena hard e MTBench Avaliações baseadas no juiz baseadas no gpt-4o-2024-05-13.

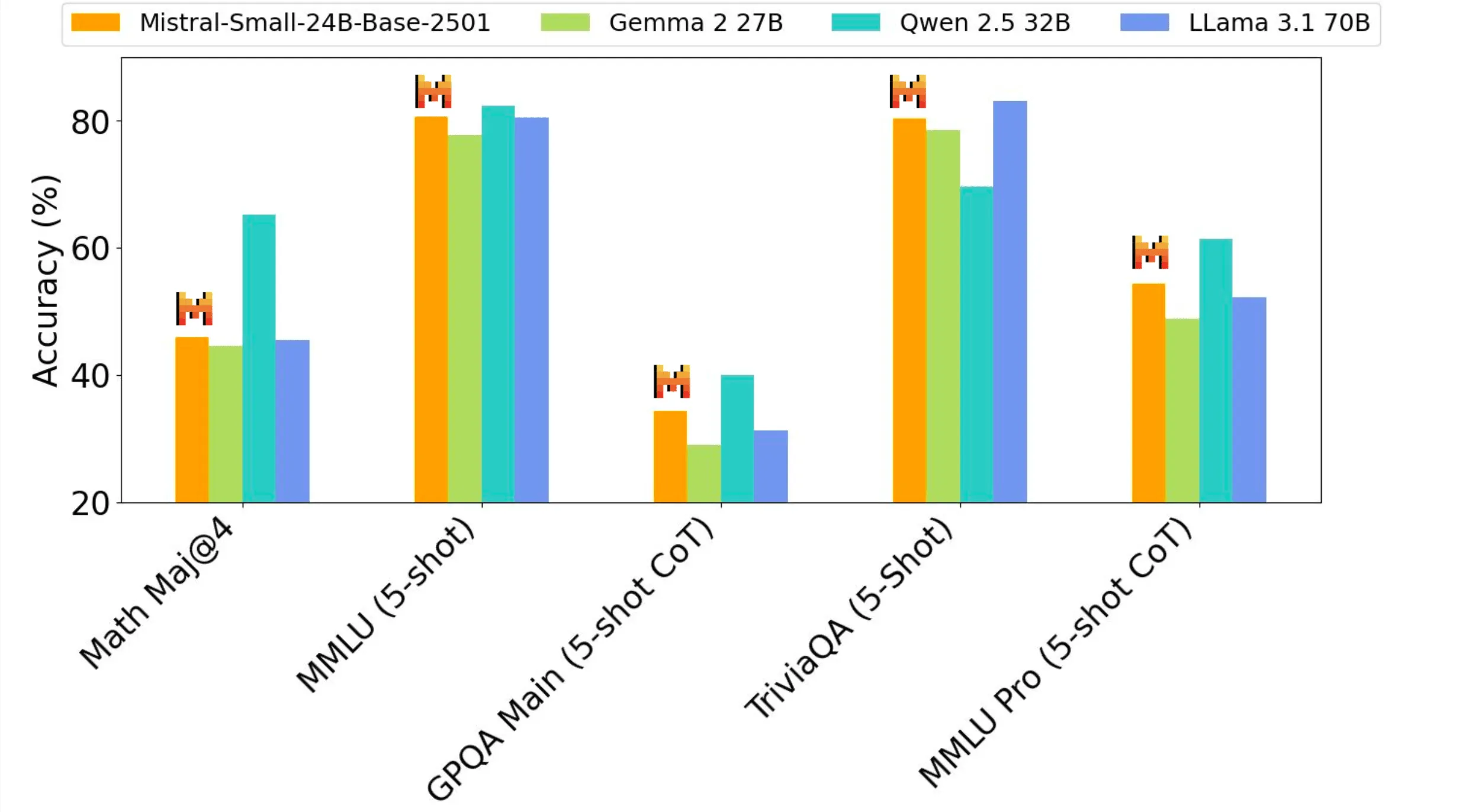

Desempenho pré-treinamento

O Mistral Small 3, como um modelo 24B, oferece o melhor desempenho para sua classe de tamanho e pode se equiparar a modelos três vezes maiores, como o Llama 3.3 70B.

Quando usar o Mistral Small 3

Entre os clientes e a comunidade da Mistral AI, a Mistral AI viu vários casos de uso exclusivos surgirem para modelos pré-treinados nessa escala:

- Assistência ao diálogo com resposta rápida: o Mistral Small 3 se destaca em cenários que exigem respostas rápidas e precisas. Isso inclui muitos cenários de assistente virtual em que os usuários esperam feedback instantâneo e interação quase em tempo real.

- Chamadas de função de baixa latência: o Mistral Small 3 pode lidar com a execução rápida de funções quando usado como parte de um fluxo de trabalho de automação ou agente.

- Ajuste fino para criar especialistas no assunto: o Mistral Small 3 pode ser ajustado para se concentrar em áreas específicas e criar especialistas no assunto altamente precisos. Isso é particularmente útil em áreas como consultoria jurídica, diagnóstico médico e suporte técnico, em que o conhecimento específico do domínio é fundamental.

- Raciocínio local: particularmente benéfico para entusiastas e organizações que lidam com informações confidenciais ou proprietárias. Ao quantificar, o Mistral Small 3 pode ser executado de forma privada em uma única RTX 4090 ou em um Macbook com 32 GB de RAM.

Os clientes da Mistral AI estão avaliando o Mistral Small 3 em vários setores, incluindo:

- Usado por clientes de serviços financeiros para detecção de fraudes

- Usado por prestadores de serviços de saúde para triagem de clientes

- Empresas de robótica, automotivas e de manufatura para comando e controle no dispositivo

- Os casos de uso horizontal entre clientes incluem atendimento virtual ao cliente e análise de sentimentos e feedback.

Usando o Mistral Small 3 em suas pilhas de tecnologia favoritas

O Mistral Small 3 agora está disponível em la Plateforme como um mistral-small-latest talvez mistral-small-2501 é fornecido na forma do modelo da Mistral AI. Consulte a documentação do Mistral AI para obter informações sobre como usar os modelos do Mistral AI para geração de texto.

A Mistral AI também tem o prazer de fazer parceria com Hugging Face, Ollama, Kaggle, Together AI e Fireworks AI para disponibilizar o modelo em suas plataformas a partir de hoje:

- Hugging Face (modelo básico)

- Ollama

- Kaggle

- Juntos IA

- IA de fogos de artifício

- Em breve no NVIDIA NIM, Amazon SageMaker, Groq, Databricks e Snowflake!

O caminho a seguir

O Mistral Small 3 complementa grandes modelos de inferência de código aberto, como o recém-lançado DeepSeek, e pode ser usado como um modelo de base avançado para trazer à tona os recursos de inferência.

Entre muitas outras coisas, procure modelos Mistral de pequeno e médio porte com recursos de raciocínio aprimorados a serem lançados nas próximas semanas. Se você estiver interessado em participar da jornada da Mistral AI (a Mistral AI está contratando) ou em ir além, quebrando o Mistral Small 3 e tornando-o melhor agora mesmo!

Modelo de código aberto da Mistral

A Mistral AI está reafirmando o compromisso da Mistral AI de usar o protocolo Apache 2.0 para modelos genéricos, já que a Mistral AI está eliminando gradualmente os modelos licenciados por MRL . Assim como no Mistral Small 3, os pesos do modelo estarão disponíveis para download e implantação local, e podem ser modificados e usados livremente em qualquer configuração. Os modelos também estarão disponíveis por meio de APIs sem servidor no La Plateforme, implantação local e VPC da Mistral AI, plataformas de personalização e orquestração e parceiros de inferência e nuvem da Mistral AI. As empresas e os desenvolvedores que exigem funcionalidade especializada (maior velocidade e contexto, conhecimento específico do domínio, modelos específicos de tarefas (por exemplo, conclusão de código)) podem contar com modelos comerciais adicionais para complementar as contribuições da Mistral AI para a comunidade.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...