MiniMax Primeiro MiniMax-01 de código aberto, contexto superlongo de 4M, nova arquitetura, desafio Transformer

"MoE" mais "introdução em larga escala sem precedentes em ambientes de produção". relâmpago Atenção", além de "refatoração de software e engenharia desde a estrutura até o nível CUDA", o que você obtém?

A resposta é um novo modelo que une os recursos dos principais modelos e aumenta o comprimento do contexto para o nível de 4 milhões de tokens.

No dia 15 de janeiro, a empresa de macromodelagem MiniMax lançou oficialmente a tão esperada nova série de modelos: MiniMax-01, que consiste no macromodelo de idioma básico MiniMax-Text-01 e no macromodelo visual multimodal MiniMax-VL-01, desenvolvido por meio da integração de um modelo ViT leve sobre ele.

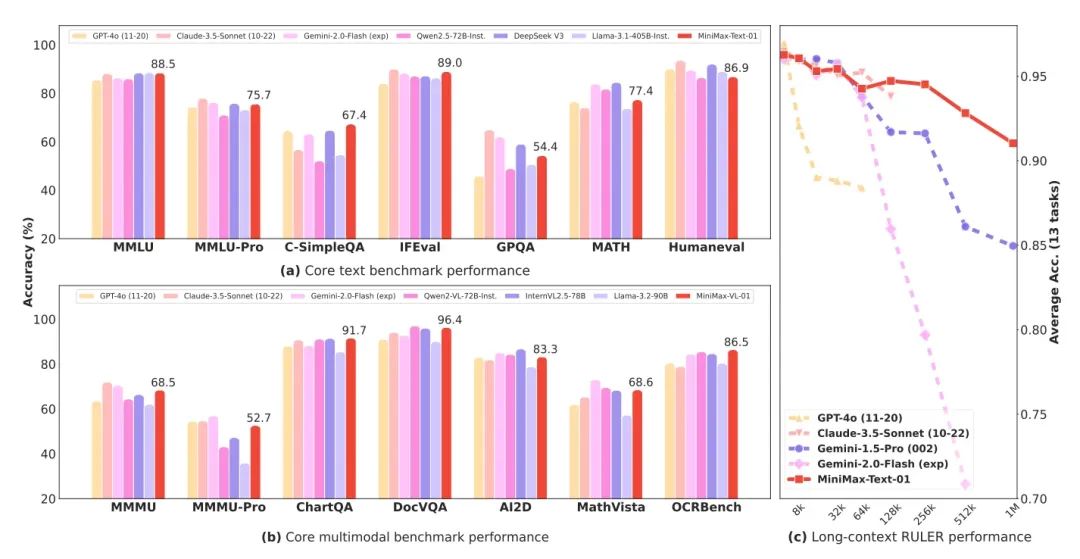

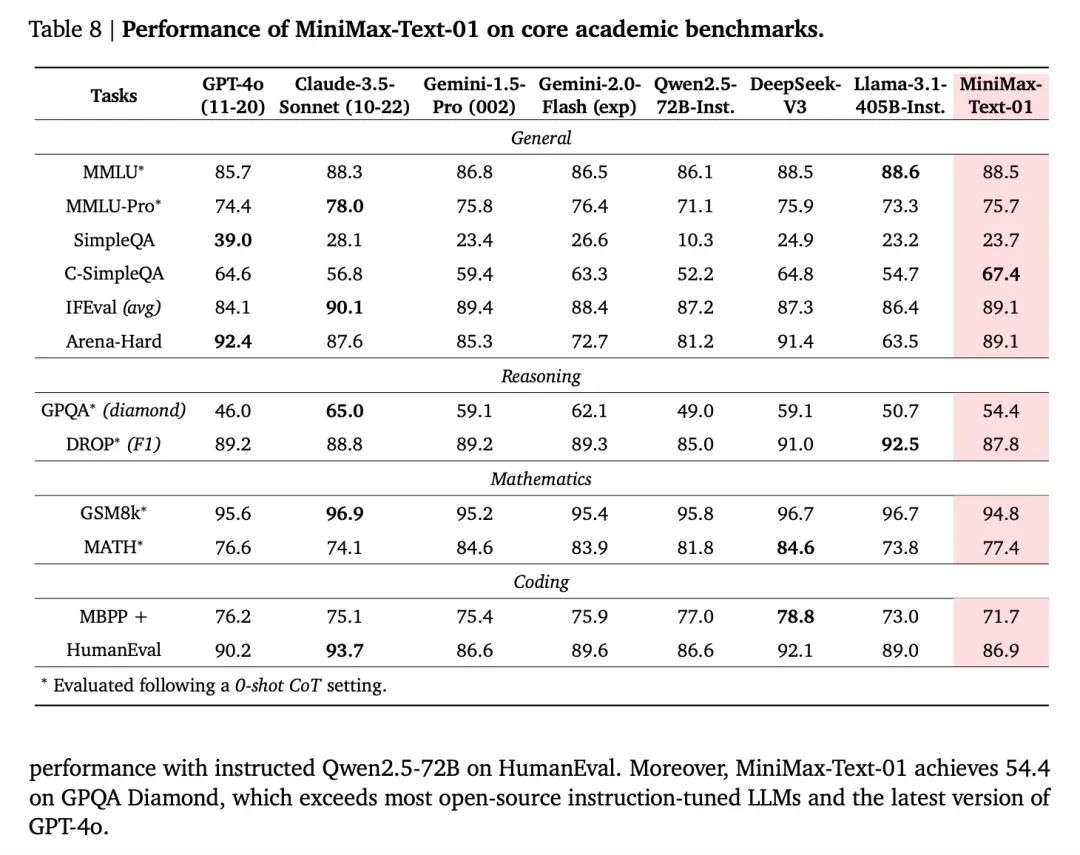

O MiniMax-01 é um modelo MoE (Mixed Expert) com 456 bilhões de parâmetros totais e 32 Experts, que está no mesmo nível do GPT-4o e do soneto Claude 3.5 em termos de potência combinada em vários conjuntos de análise convencionais, ao mesmo tempo em que tem de 20 a 32 vezes o comprimento do contexto dos principais modelos atuais e, com comprimentos de entrada mais longos, é também o modelo com a maior queda de desempenho. é o modelo com a queda de desempenho mais lenta. Ou seja, é um contexto real de 4 milhões de tokens.

- Macromodelo de linguagem básica MiniMax-Text-01, macromodelo visual multimodal MiniMax-VL-01

- A nova arquitetura de atenção do Lightning, Square to Linear, reduz drasticamente os custos de inferência

- Código aberto pesado, parâmetros de modelo de texto de até 456 bilhões, 32 especialistas

- Contexto ultra-ultra-longo de 4 milhões de palavras e desempenho que se equipara aos principais modelos estrangeiros

- O modelo, o código e o relatório técnico foram todos liberados, com muita sinceridade!

A experiência na Web e a API também já estão ativas e disponíveis on-line e comercialmente no endereço no final do artigo.

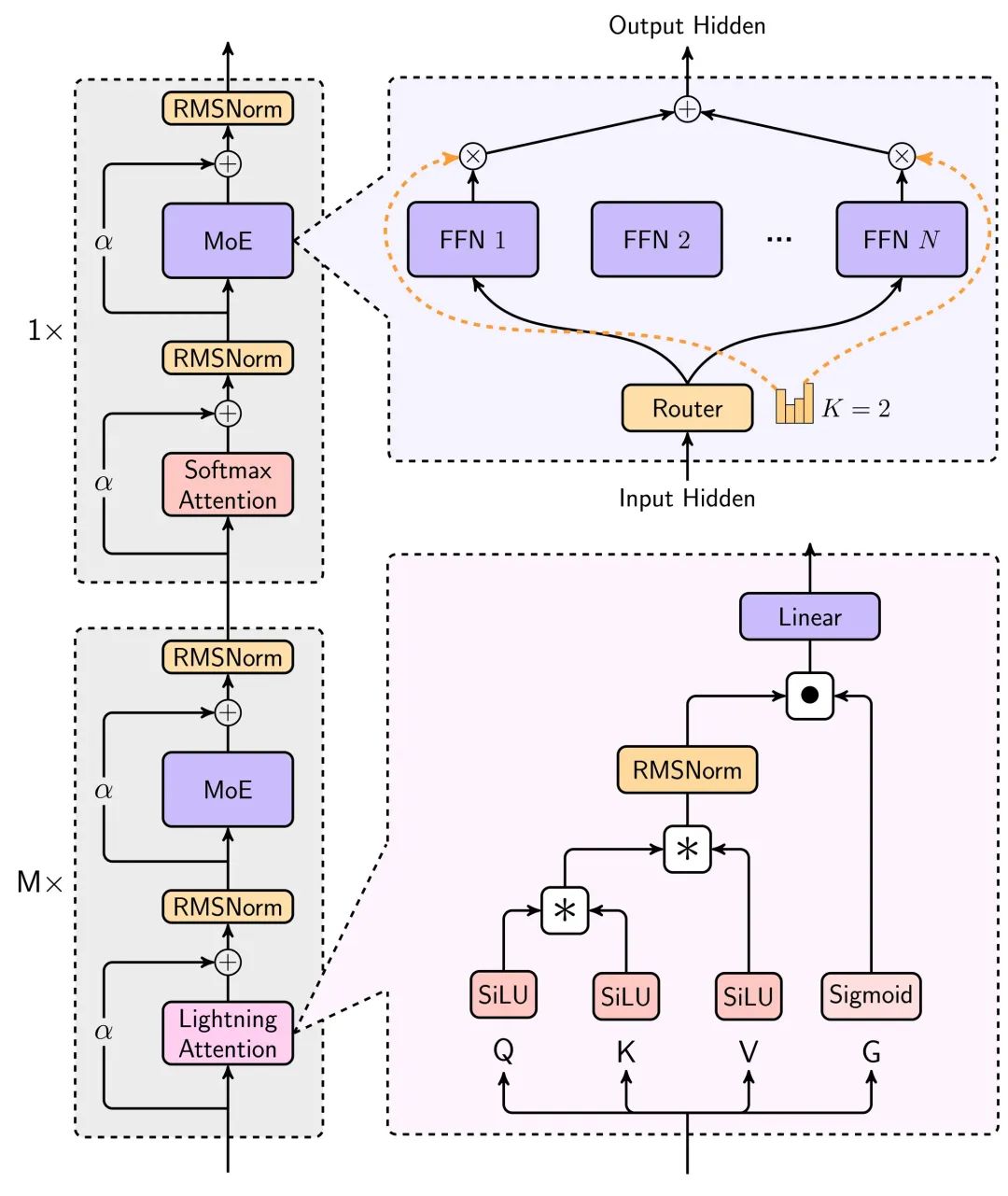

Nova tecnologia: atenção aos raios

O aspecto mais surpreendente desse modelo é a nova arquitetura de atenção linear.

Todos nós sabemos que, no uso real da IA, o texto longo é crucial, a memória longa do bate-papo com caracteres, a codificação da IA para escrever códigos, o agente para concluir uma variedade de tarefas, cujo cenário é inseparável do texto longo.

Os modelos grandes estão caindo de preço, mas quanto mais longo o contexto em que são usados, mais lentos e mais caros eles se tornam.

A raiz desse problema é Transformador A arquitetura tem uma complexidade computacional quadrática. O consumo aritmético do raciocínio aumenta exponencialmente à medida que o contexto aumenta.

Desta vez, o novo modelo da MiniMax usa o mecanismo de atenção Lightning, um mecanismo de atenção linear que pode reduzir significativamente o tempo de computação e inferência para textos longos.

Os principais diagramas de arquitetura para essa modelagem podem ser vistos no relatório técnico.

A redução no consumo de recursos de inferência de modelos por essa arquitetura é enorme, como pode ser visto no gráfico a seguir, que compara os tempos de inferência para textos longos, em que a atenção linear é usada para permitir que os tempos de inferência aumentem lentamente de forma quase linear, em vez de exponencialmente, à medida que o contexto continua a aumentar.

Uma descrição mais detalhada pode ser encontrada no relatório técnico no final do artigo.

A computação é reduzida, o preço cai e o desempenho não pode ser perdido por muito tempo para que o texto seja realmente utilizável.

O gráfico abaixo mostra o desempenho do Text-1 no conjunto de avaliação de textos muito longos, onde ele surpreendentemente supera o intervalo de comprimento de mais de 512K Gêmeos 2.0 Flash.

Outro ponto muito interessante do relatório técnico é que a capacidade de aprendizagem no contexto do modelo, que aumenta gradualmente à medida que o contexto melhora, pode ser de grande ajuda para a escrita de IA, bem como para tarefas que exigem memórias longas.

De modo geral, a aplicação do mecanismo de atenção Lightning faz com que a usabilidade de textos longos para modelos grandes aumente drasticamente, e o preço tem a chance de cair outra ordem de magnitude.

Desempenho do modelo, nivelando a primeira linha

Em termos de métricas de desempenho do modelo, como um modelo de código aberto, ele se aproxima dos melhores modelos de código fechado do exterior em muitas métricas.

E como o modelo tem feedback da plataforma Conch para otimização e iteração, a experiência do usuário em cenários reais também é garantida.

O uso oficial de cenários reais de uso do usuário para criar um conjunto de testes mostra que o desempenho em cenários reais também é muito bom, especialmente em três cenários de destaque: redação criativa, testes de conhecimento e texto longo.

Além disso, o desempenho do modelo de compreensão visual MiniMax-VL-01, basicamente em todos os índices, iguala ou supera os principais modelos do exterior, especialmente cenas práticas de OCR e gráficos.

Próximo momento Transformer

Quando as iterações geracionais de modelos não são mais ferozes, a extensão do contexto e o raciocínio lógico estão se tornando as duas direções mais focadas.

Em termos de contexto, o Gemini já foi o mais longo. Além disso, o CEO da DeepMind, Demsi Hassabis, revelou que, no Google, o modelo Gemini já alcançou 10 milhões de comprimentos de tokens em experimentos e acredita-se que, eventualmente, "alcançará comprimentos infinitos", mas o que está impedindo o Gemini de fazer isso agora é seu custo correspondente. Mas o que está impedindo a Gemini de fazer isso agora é o custo de fazê-lo. Em uma entrevista recente, ele disse que a Deepmind agora tem uma nova abordagem para resolver esse problema de custo.

Portanto, quem conseguir aumentar o comprimento do contexto primeiro e, ao mesmo tempo, reduzir o custo, provavelmente terá a vantagem. A julgar pelos resultados demonstrados pelo MiniMax-01, ele realmente obteve um aprimoramento qualitativo na eficiência.

Nesse exaustivo relatório técnico, a eficiência do uso do hardware pode ser vista em uma estatística - inferência, o MiniMax atinge 75% MFUs em GPUs H20.

MFU (Machine FLOPs Utilization) refere-se à utilização real da potência computacional do hardware (FLOPs, ou seja, operações de ponto flutuante por segundo) por um modelo durante a operação. Em resumo, a MFU descreve se um modelo faz uso total do desempenho do hardware. Uma alta taxa de utilização certamente trará vantagens de custo.

O MiniMax 01 é certamente uma das raras surpresas no recente debate sobre o assunto.Outro que gerou muita discussão recentemente foi o DeepSeek V3. Como mencionado acima, duas direções importantes atualmente, uma em inferência e outra em contextos mais longos, são representadas pelo Deepseek V3 e pelo MiniMax-01 cada.

É interessante notar que, em termos de rota técnica, até certo ponto ambos estão otimizando o mecanismo de atenção central no Transformer, que lançou as bases para o boom atual, e é uma refatoração ousada, hardware e software em um só. O deepSeek V3 foi descrito como uma ordenha dos cartões da Nvidia, e é crucial para a capacidade do MiniMax de alcançar uma MFU de inferência tão alta que eles também são Eles otimizam a estrutura de treinamento e o hardware diretamente.

De acordo com o relatório da MiniMax, eles desenvolveram um kernel CUDA para a capacidade de atenção linear diretamente por conta própria, passo a passo e em profundidade, a partir do zero, e desenvolveram várias estruturas de acompanhamento para esse fim, a fim de otimizar o uso eficiente dos recursos da GPU. Ambas as empresas alcançaram seus objetivos por meio de uma integração mais estreita dos recursos de hardware e software.

Outra observação interessante é que essas duas empresas de destaque são empresas que já haviam investido em pesquisa e desenvolvimento de tecnologia de modelos grandes antes do surgimento do ChatGPT, e o mais surpreendente sobre esses dois modelos não é o modo de "alcançar o GPT4" que estamos acostumados a ver no passado, mas sim, de acordo com seu próprio julgamento sobre a evolução da tecnologia, eles fizeram grandes investimentos e até mesmo algumas apostas em inovação, e entregaram a resposta após uma série de trabalho sólido e contínuo. Em vez disso, com base em seu próprio julgamento sobre a evolução da tecnologia, eles fizeram grandes investimentos e até mesmo algumas apostas em inovação, e entregaram a resposta após uma série de trabalhos sólidos e contínuos.

Todas elas estão tentando provar que algum conceito que antes estava preso no laboratório pode ter o efeito prometido quando implantado em escala em cenários do mundo real e, ao fazer isso, permitir que mais pessoas continuem a otimizá-lo.

É uma reminiscência de quando surgiu o Transformer.

Quando o mecanismo de atenção também se tornou viral no laboratório, mas a controvérsia ainda persistia, foi o Google, que acreditava em seu potencial, que realmente acumulou a aritmética e os recursos para levá-lo de um experimento teórico a uma coisa real implementada em larga escala. Em seguida, as pessoas se voltaram para o caminho comprovado para a prosperidade de hoje.

Com o Transformer empilhando mais camadas umas sobre as outras e usando mais energia, e o MiniMax-01 tentando reformular o antigo mecanismo de atenção, é um pouco como um déjà vu novamente. -Atenção é tudo o que você precisa.

"Atualmente, o modelo ainda retém 1/8 da atenção normal do softmax. Estamos trabalhando em arquiteturas mais eficientes que acabarão por remover totalmente a atenção softmax, possibilitando a obtenção de janelas de contexto ilimitadas sem sobrecarga computacional."

Preço do modelo

Entrada: $1/milhão token

Resultado: US$ 8/milhão de tokens

Basicamente, use-o com os olhos fechados.

Recursos de modelagem

Código:https://github.com/MiniMax-AI/MiniMax-01

Modelos:https://huggingface.co/MiniMaxAI/MiniMax-Text-01, https://huggingface.co/MiniMaxAI/MiniMax-VL-01

Relatório técnico:https://filecdn.minimax.chat/_Arxiv_MiniMax_01_Report.pdf

No lado da Web:https://hailuo.ai

API. https://www.minimaxi.com/

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...