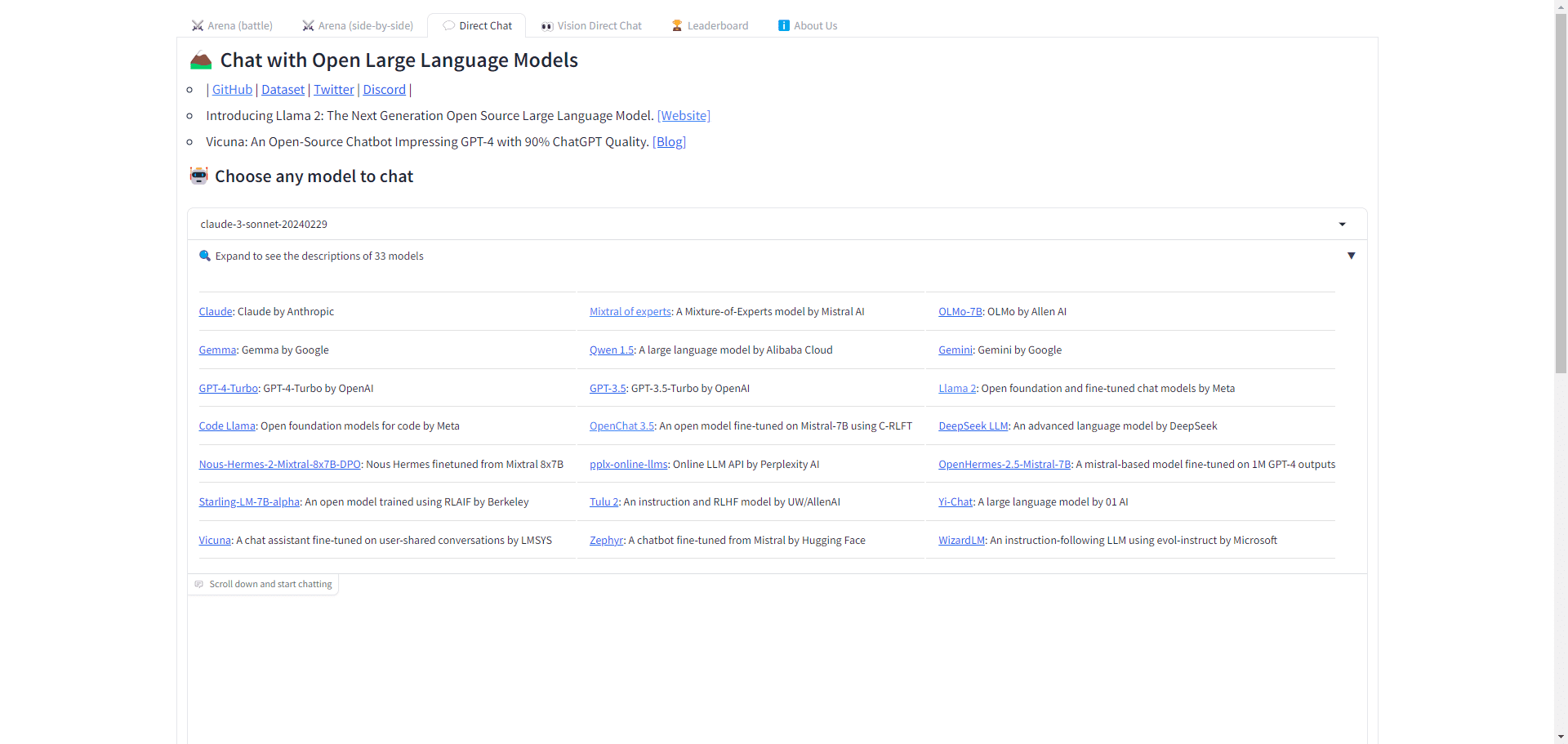

Chatbot Arena (LMSYS): uma plataforma competitiva on-line para avaliar modelos de linguagem grandes e comparar o desempenho de vários modelos

Introdução geral

A LMSYS Org, conhecida como Large Model Systems Organization, é uma organização de pesquisa aberta co-fundada por estudantes e professores da Universidade da Califórnia, Berkeley, em colaboração com a Universidade da Califórnia, San Diego e a Universidade Carnegie Mellon. O objetivo da organização é tornar os modelos grandes acessíveis a todos por meio do co-desenvolvimento de modelos, conjuntos de dados, sistemas e ferramentas de avaliação abertos.

O Chatbot Arena é uma plataforma on-line voltada para a avaliação e a comparação do desempenho de diferentes modelos de linguagem ampla (LLMs). A plataforma foi criada por pesquisadores para oferecer aos usuários um ambiente anônimo e aleatório para interagir e avaliar vários chatbots de IA lado a lado. Por meio de análises detalhadas de qualidade, desempenho e preço, o Chatbot Arena ajuda os usuários a encontrar a solução de IA que melhor atenda às suas necessidades.

Modelo PK: https://lmarena.ai/

Lista de funções

- Vicuna: um chatbot com qualidade 90% ChatGPT, disponível nos tamanhos 7B/13B/33B.

- Chatbot Arena: avaliação escalonável e gamificada de LLMs por meio de crowdsourcing e do sistema de classificação Elo.

- SGLang: Interface e tempo de execução eficientes para programas LLM complexos.

- LMSYS-Chat-1M: um conjunto de dados em grande escala de diálogos LLM reais.

- FastChat: uma plataforma aberta para treinamento, atendimento e avaliação de chatbots baseados em LLM.

- MT-Bench: um conjunto de perguntas desafiadoras, com várias rodadas e abertas para avaliar chatbots.

Usando a Ajuda

- comparação de modelos::

- Visite a página Comparação de modelos.

- Selecione os modelos que deseja comparar e clique no botão "Add to Compare" (Adicionar para comparar).

- Veja os resultados da comparação, incluindo qualidade, desempenho, preço e outras métricas.

- controle de qualidade::

- Na página Detalhes do modelo, visualize os resultados do teste de qualidade.

- Saiba mais sobre pontuações e classificações específicas para diferentes dimensões do teste.

- Análise de preços::

- Na página de detalhes do modelo, veja a análise de preços.

- Compare os preços de diferentes modelos para encontrar a opção mais econômica.

- Avaliação de desempenho::

- Na página Detalhes do modelo, visualize os resultados da avaliação de desempenho.

- Entenda a velocidade de saída do modelo, a latência e outras métricas de desempenho.

- análise da janela de contexto::

- Na página Detalhes do modelo, visualize a Análise da janela de contexto.

- Entenda o tamanho da janela de contexto do modelo para diferentes cenários de aplicativos.

Seguindo essas etapas, os usuários podem obter uma compreensão abrangente do desempenho e das características de diferentes modelos de linguagem em larga escala e fazer a escolha que melhor atenda às suas necessidades.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...