Velocidade do LM: teste rápido do desempenho de APIs de modelos grandes

Introdução geral

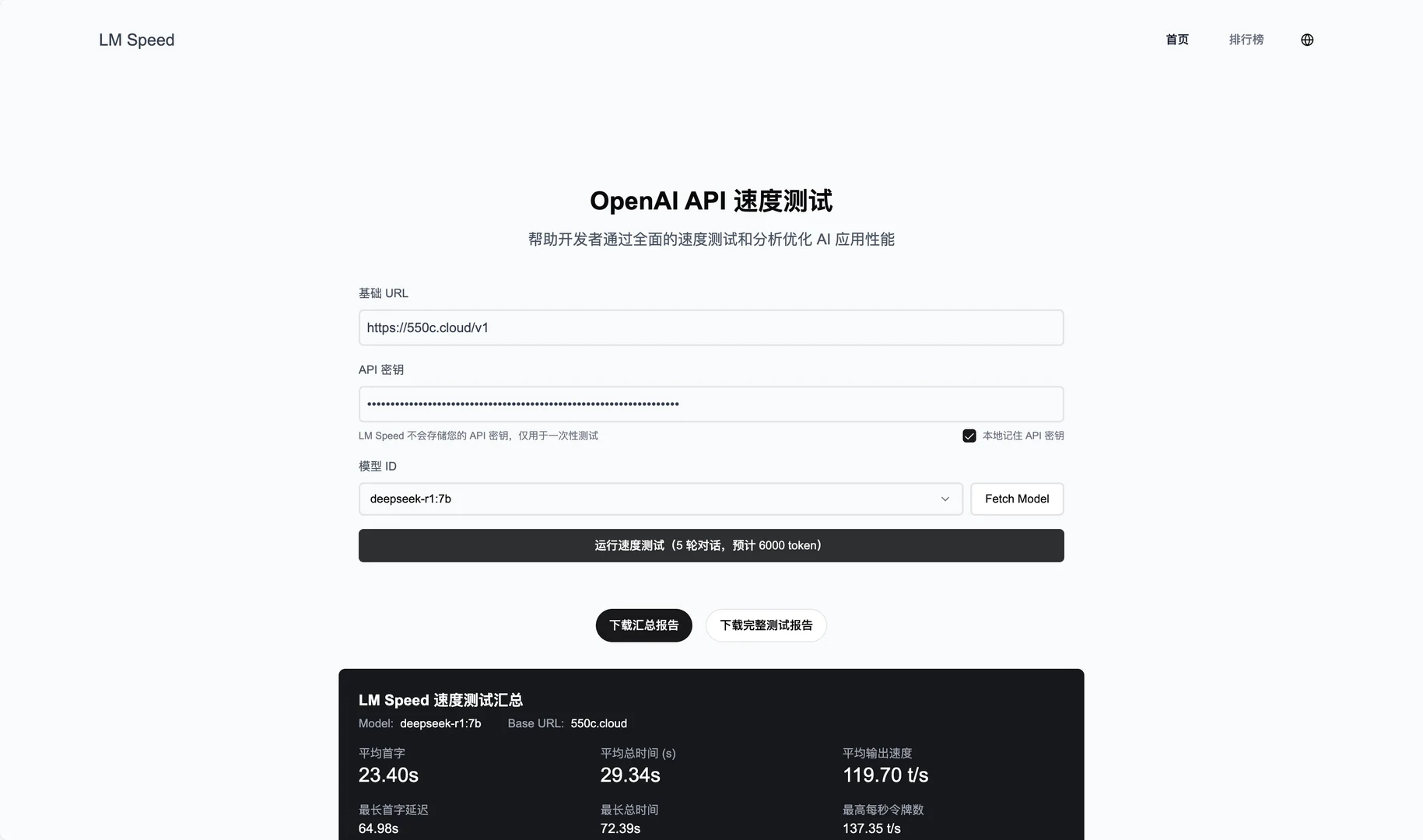

O LM Speed é uma ferramenta projetada especificamente para desenvolvedores de IA e está disponível como um serviço on-line em lmspeed.net. Sua principal função é testar e analisar o desempenho das APIs de modelos de linguagem, ajudando os usuários a identificar rapidamente os gargalos de velocidade e otimizar as estratégias de chamada. A ferramenta é compatível com várias interfaces, inclusive a API OpenAI, e fornece monitoramento de dados em tempo real e relatórios de desempenho detalhados. Seja você um desenvolvedor individual ou uma equipe, o LM Speed facilita a comparação do desempenho de diferentes modelos e fornecedores por meio de gráficos de dados intuitivos e testes automatizados.

Lista de funções

- Monitoramento de desempenho em tempo real: exibe dados multidimensionais, como processamento por segundo token (TPoS).

- Avaliação abrangente do desempenho: meça as principais métricas, como a latência do primeiro token, o tempo de resposta e muito mais.

- Visualização de dados: gere gráficos avançados para visualizar as tendências de desempenho.

- Testes de estresse automatizados: cinco rodadas consecutivas de testes para garantir dados confiáveis.

- Geração de relatórios com um clique: crie automaticamente relatórios de teste profissionais, suporte à exportação e ao compartilhamento.

- Teste rápido para parâmetros de URL: inicie o teste diretamente do link sem entrada manual.

- Salvamento de dados históricos: registre os resultados dos testes e dê suporte à análise de tendências.

Usando a Ajuda

Uso de serviços on-line

- Acesso ao site

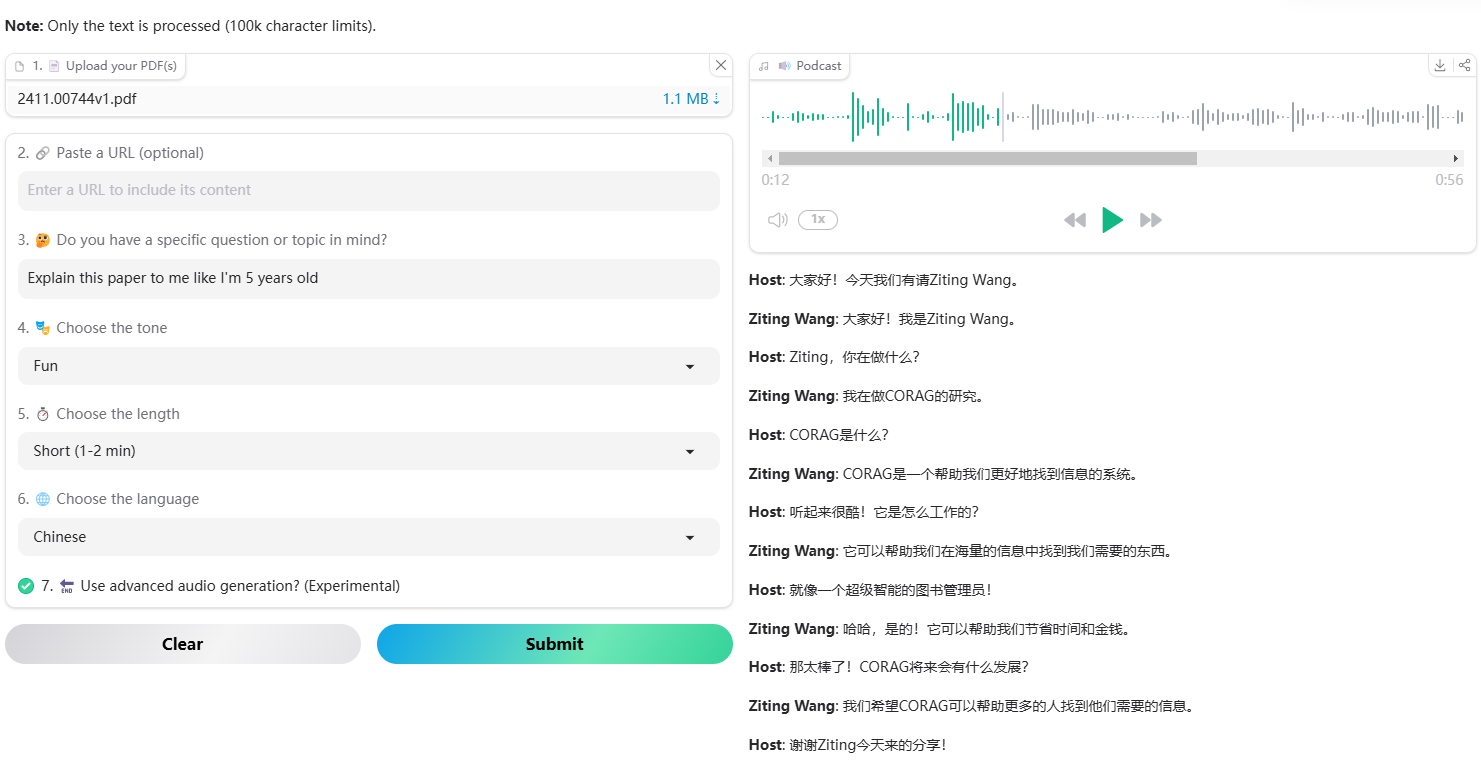

Abra seu navegador e acesse https://lmspeed.net. - Parâmetros de teste de entrada

Preencha o formulário da página com as seguintes informações:baseUrlEndereço do serviço de API, por exemplo.https://api.deepseek.com/v1.apiKeySua chave de API.modelIdID do modelo a ser testado, por exemplofree:QwQ-32B.

- teste de inicialização

Clique no botão "Start Test" e o sistema executará automaticamente cinco rodadas de testes de estresse. Durante o teste, você verá atualizações de dados em tempo real, incluindo TPoS e tempos de resposta. - Exibir resultados

Após a conclusão do teste, a página exibe gráficos e métricas detalhados, como a latência do primeiro token e o desempenho médio. Você pode clicar no botão "Generate Report" (Gerar relatório) para fazer o download do PDF ou compartilhá-lo com sua equipe. - Teste rápido de parâmetros de URL

Se não quiser inseri-lo manualmente, você pode iniciar o teste diretamente com um link. Exemplo:

https://lmspeed.net/?baseUrl=https://api.suanli.cn/v1&apiKey=sk-你的密钥&modelId=free:QwQ-32B

Após abrir o link, o teste é iniciado automaticamente. Observação: por motivos de segurança, é recomendável não passar a chave da API diretamente no URL.

Processo de instalação da implantação local

- Preparação do ambiente

Certifique-se de que seu computador tenha o Git, o Node.js (recomenda-se a versão 16 ou superior), o Docker e o Docker Compose instalados; caso contrário, faça o download e instale-os primeiro. - armazém de clones

Abra um terminal e digite o seguinte comando para fazer o download do código:

git clone https://github.com/nexmoe/lm-speed.git

cd lm-speed

- Implementação do Docker

- estabelecer

docker-compose.ymlcopie o código fornecido oficialmente:version: '3.8' services: app: image: nexmoe/lmspeed:latest ports: - "8650:3000" environment: - DATABASE_URL=postgresql://postgres:postgres@db:5432/nexmoe - NODE_ENV=production depends_on: - db restart: always db: image: postgres:16 restart: always environment: POSTGRES_USER: postgres POSTGRES_PASSWORD: postgres POSTGRES_DB: nexmoe volumes: - postgres_data:/var/lib/postgresql/data volumes: postgres_data: - É executado no terminal:

docker-compose up -d - Após a implantação bem-sucedida, acesse o

http://localhost:8650Serviços de visualização.

- Implementação manual

- Instale a dependência:

npm install - Copiar e configurar variáveis de ambiente:

cp .env.example .envcompilador

.envpreencha o endereço do banco de dados e a configuração da API. - Inicie o serviço:

npm run dev - entrevistas

http://localhost:3000.

Operação da função em destaque

- monitoramento em tempo real

Ao testar on-line, a página exibe dinamicamente as alterações de TPoS e de tempo de resposta. Você pode passar o mouse sobre os gráficos para ver os valores exatos. - teste automatizado

Após clicar em "Start Test" (Iniciar teste), o sistema realiza automaticamente cinco rodadas de testes. Os resultados de cada rodada são registrados, e a média e o intervalo de flutuação são gerados no final para ajudá-lo a avaliar a estabilidade da API. - Exportação de relatórios

Quando o teste for concluído, clique em "Exportar relatório" e selecione o formato PDF. O relatório contém o ambiente de teste, as métricas de desempenho e os gráficos, e é adequado para compartilhamento ou arquivamento pela equipe. - Análise de dados históricos

O serviço on-line mantém um registro dos seus testes. Depois de fazer o login, vá para a página "History" (Histórico) para visualizar os resultados de testes anteriores e as tendências de desempenho.

advertência

- Certifique-se de que a chave da API seja válida ou o teste falhará.

- Quando implantado localmente, verifique se o firewall tem portas abertas (padrão 3000 ou 8650).

- Se o gráfico estiver carregando lentamente, pode haver um problema de rede e recomendamos atualizar a página e tentar novamente.

Com essas etapas, você pode testar o desempenho da API de modelagem de linguagem on-line ou localmente com o LM Speed. A operação é simples, os resultados são claros e muito úteis.

cenário do aplicativo

- Os desenvolvedores escolhem os serviços de API

Teste de desenvolvedor com o LM Speed DeepSeek e APIs, como o Silicon Flow, para selecionar o fornecedor mais adequado para o projeto. - Chamada de modelo de otimização de equipe

As equipes de IA o utilizam para monitorar o desempenho das APIs sob alta carga, ajustando as estratégias de chamada para melhorar a eficiência dos aplicativos. - Os pesquisadores analisam as flutuações de desempenho

- Os pesquisadores estudaram as mudanças no desempenho do modelo sob diferentes condições por meio de cinco rodadas de testes e dados históricos para escrever o relatório acadêmico.

QA

- Quais APIs são compatíveis com o LM Speed?

Ele é compatível principalmente com APIs no formato OpenAI, como DeepSeek, Suanli e assim por diante. Desde que a API seja compatível com o OpenAI SDK, ela pode ser testada. - E quanto aos resultados instáveis dos testes?

Verifique se a conexão de rede está estável ou aumente o número de rodadas de teste (o código pode ser modificado para implantação local). Grandes flutuações nos resultados podem ser um problema com o provedor de API. - Preciso pagar?

Atualmente, os serviços on-line são gratuitos, mas a funcionalidade pode ser limitada. A implementação local é totalmente gratuita e o código-fonte é aberto.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...