LLManager: uma ferramenta de gerenciamento que combina aprovações de processos automatizados inteligentes com auditorias humanas

Introdução geral

O LLManager é uma ferramenta de gerenciamento de aprovação inteligente de código aberto baseada na tecnologia LangChain LangGraph Estrutura desenvolvida para se concentrar na automação do processamento de solicitações de aprovação e, ao mesmo tempo, otimizar a tomada de decisões em conjunto com a revisão humana. Ele aprende com o histórico de aprovações por meio de pesquisa semântica, aprendizado sem amostras e mecanismos reflexivos para melhorar a precisão da aprovação. Os usuários podem usar o Caixa de entrada do agente Visualizando e respondendo a solicitações, suportando critérios personalizados de aprovação e rejeição e adaptando-se a vários modelos de linguagem (por exemplo, OpenAI, Anthropic), o LLManager é adequado para cenários de aprovação de orçamento empresarial, gerenciamento de projetos e revisão de conformidade, e o código é hospedado no GitHub, permitindo que os desenvolvedores ampliem livremente a funcionalidade. A ferramenta enfatiza a IA e a colaboração humana, equilibrando eficiência e confiabilidade.

Lista de funções

- Aprovações automatizadasGeração automática de recomendações de aprovação com base em critérios de aprovação e rejeição definidos pelo usuário.

- Auditoria HumanaSuporte à aceitação, modificação ou rejeição manual de aprovações geradas por IA para garantir uma tomada de decisão precisa.

- pesquisa semânticaExtrair 10 amostras semanticamente semelhantes de solicitações históricas para melhorar a relevância contextual das aprovações.

- aprendizado com menos amostrasOtimize os recursos futuros de tomada de decisão do modelo com base nos dados históricos de aprovação.

- Mecanismos de reflexãoAnálise dos resultados das aprovações modificadas e geração de relatórios reflexivos para melhorar o desempenho do modelo.

- Personalização do modeloSuporte para modelos como OpenAI, Anthropic, etc., com suporte para a função de chamada de ferramenta.

- Caixa de entrada interativa do agenteInterface intuitiva para visualizar, responder e gerenciar solicitações de aprovação.

- Criação de dicas dinâmicasAjuste dinâmico dos avisos com base nas solicitações para se adequar a diversos cenários de aprovação.

- Avaliação de ponta a pontaExecute casos de teste para verificar a confiabilidade e a precisão do fluxo de trabalho.

Usando a Ajuda

Processo de instalação

O LLManager é baseado no projeto de código aberto LangChain e LangGraph e precisa ser implantado localmente. Veja a seguir as etapas detalhadas de instalação:

- Clonagem da base de código::

Execute o seguinte comando no terminal para obter o código do LLManager:git clone https://github.com/langchain-ai/llmanager.git cd llmanager - Instalação de dependências::

Certifique-se de que o Python 3.11 ou posterior e o Node.js (para Yarn) estejam instalados em seu sistema. Crie um ambiente virtual e instale as dependências:python3 -m venv venv source venv/bin/activate yarn installAs dependências padrão incluem o LangChain e o pacote de integração Anthropic/OpenAI. Instalações adicionais são necessárias se você estiver usando outros modelos (por exemplo, Google GenAI):

yarn install @langchain/google-genai - Configuração de variáveis de ambiente::

Copie o arquivo de ambiente de amostra e preencha as informações necessárias:cp .env.example .envcompilador

.envadicione a chave da API do LangSmith e o arquivo Antrópica Chave de API (se estiver usando o modelo Anthropic):LANGCHAIN_PROJECT="default" LANGCHAIN_API_KEY="lsv2_..." LANGCHAIN_TRACING_V2="true" LANGSMITH_TEST_TRACKING="true" ANTHROPIC_API_KEY="your_anthropic_key"O LangSmith é usado para rastreamento e depuração e recomenda-se que seja ativado.

- Iniciando o servidor de desenvolvimento::

Execute o seguinte comando para iniciar o servidor LangGraph:yarn devPor padrão, o servidor é executado no

http://localhost:2024Em ambientes de produção, implemente em um servidor de nuvem e atualize a URL. Em um ambiente de produção, implemente em um servidor de nuvem e atualize o URL.

Uso

O núcleo do LLManager é gerenciar e responder às solicitações de aprovação por meio da Caixa de entrada do agente. Abaixo está o fluxo de operação detalhado:

- Execução de uma avaliação de ponta a ponta::

- Execute o seguinte comando para gerar um novo assistente de aprovação e executar 25 casos de teste:

yarn test:single evals/e2e.int.test.ts - O terminal gera o UUID do novo assistente, registrando esse ID para a configuração da Caixa de entrada do agente.

- Se precisar reutilizar o mesmo assistente, você pode modificar o

evals/e2e.int.test.tsSe estiver usando um ID de auxiliar fixo, use o ID de auxiliar fixo.

- Execute o seguinte comando para gerar um novo assistente de aprovação e executar 25 casos de teste:

- Configuração de regras de aprovação::

- existir

config.jsonDefina os critérios de aprovação e rejeição na seção Exemplo:{ "approvalCriteria": "请求需包含详细预算和时间表", "rejectionCriteria": "缺少必要文件或预算超标", "modelId": "anthropic/claude-3-7-sonnet-latest" } - Quando nenhuma regra é definida, o LLManager aprende com base em dados históricos, mas a definição de regras acelera a adaptação do modelo.

modelIdapoiar algoprovider/model_nameformato, comoopenai/gpt-4otalvezanthropic/claude-3-5-sonnet-latest.

- existir

- Uso da caixa de entrada do agente::

- Vá para dev.agentinbox.ai e clique em "Add Inbox".

- Digite as seguintes informações:

- Assistente/Graph IDUUID gerado pela avaliação de ponta a ponta.

- URL de implantação::

http://localhost:2024(ambiente de desenvolvimento). - NomePersonalize o nome, por exemplo.

LLManager.

- Atualize a caixa de entrada após o envio para ver as solicitações pendentes.

- Para cada solicitação, a Caixa de entrada do agente é exibida:

- Recomendações de aprovação geradas por IA e relatórios de raciocínio.

- Opções de ação: Aceitar, Modificar (editar sugestões ou instruções) ou Rejeitar (fornecer motivos).

- As solicitações modificadas ou aceitas são armazenadas automaticamente na biblioteca Less Sample Example para otimizar as aprovações subsequentes.

- Visualizar e otimizar o histórico de aprovações::

- Na Caixa de entrada do agente, clique em Solicitações processadas para visualizar detalhes de aprovação, relatórios de inferência de IA e registros de modificação manual.

- O sistema extrai solicitações semelhantes do histórico como modelos de entrada contextual por meio de pesquisa semântica.

- A solicitação modificada aciona o mecanismo de reflexão, que gera um relatório de reflexão que é armazenado no repositório de reflexão e usado para aprimorar o modelo.

Operação da função em destaque

- pesquisa semânticaQuando uma nova solicitação é recebida, o sistema extrai 10 solicitações semanticamente semelhantes (incluindo o conteúdo da solicitação, a resposta final e a descrição) do histórico como um contexto de solicitação para melhorar a precisão da aprovação.

- Mecanismos de reflexão::

- Se o manual modificar apenas a descrição (resposta correta, mas raciocínio incorreto), acione a função

explanation_reflectionnós para analisar erros de raciocínio e gerar novas reflexões. - Se tanto a resposta quanto a descrição forem modificadas, acione

full_reflectionnós, analisando erros gerais e gerando reflexões. - Os relatórios de reflexão são depositados em um banco de reflexões para otimizar o raciocínio subsequente.

- Se o manual modificar apenas a descrição (resposta correta, mas raciocínio incorreto), acione a função

- Criação de dicas dinâmicasAjusta dinamicamente os avisos com base no conteúdo da solicitação e nos dados históricos para garantir que as aprovações sejam adaptadas a uma variedade de cenários.

- Mudança de modelo: modificando o

config.jsonacertou em cheiomodelIdmudar para um modelo que ofereça suporte a chamadas de ferramentas (por exemploopenai/gpt-4o), você precisa se certificar de que o pacote de integração correspondente esteja instalado.

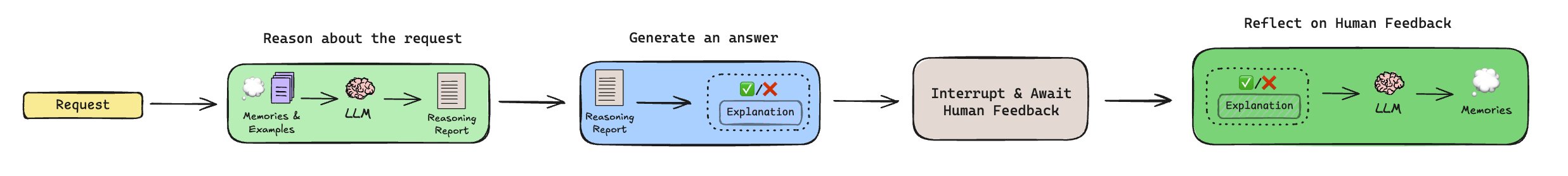

Explicação do fluxo de trabalho

O processo de aprovação do LLManager inclui as seguintes etapas:

- Raciocínio::

- Extração de reflexões históricas e exemplos de amostras menores (via pesquisa semântica).

- Gera um relatório de raciocínio que analisa se a solicitação deve ser concedida, mas não toma a decisão final.

- Gerar resposta::

- Combine o relatório de raciocínio e o contexto para gerar uma recomendação de aprovação final (aprovar ou rejeitar) e uma descrição.

- Revisão humana::

- Suspender o fluxo de trabalho e aguardar a revisão manual por meio da Caixa de entrada do agente.

- Um ser humano pode aceitar, modificar ou rejeitar sugestões, e as modificações são depositadas na Lesser Sample Example Library.

- Reflexão::

- Se a recomendação for modificada, um mecanismo de reflexão será acionado para gerar recomendações de aprimoramento.

- As solicitações não modificadas ignoram essa etapa.

advertência

- Certifique-se de que a chave da API do LangSmith seja válida e que os ambientes de desenvolvimento e produção tenham redes estáveis.

- Os modelos não-OpenAI/Anthropic exigem a instalação de pacotes de integração adicionais; consulte a documentação do LangChain.

- As implementações de produção exigem a transferência do servidor LangGraph para a nuvem e a atualização do URL da Caixa de entrada do agente.

cenário do aplicativo

- Aprovação do orçamento da empresa

O LLManager automatiza o processamento de solicitações de orçamento de funcionários, gerando recomendações com base em regras predefinidas (por exemplo, limites orçamentários, tipos de projeto). A equipe financeira analisa, modifica ou confirma os resultados via Agent Inbox, reduzindo as tarefas repetitivas. - Alocação de tarefas do projeto

Os gerentes de projeto usam o LLManager para aprovar solicitações de atribuição de tarefas. O sistema analisa as prioridades das tarefas e os requisitos de recursos para gerar recomendações de alocação. O gerente revisa manualmente a solicitação para garantir uma alocação de tarefas eficiente e razoável. - Análise de conformidade

O LLManager verifica a conformidade regulamentar dos documentos enviados e sinaliza possíveis problemas. A equipe de conformidade confirma ou ajusta os resultados por meio do Inbox, aumentando a eficiência da análise. - Gerenciamento de solicitações de clientes

As equipes de atendimento ao cliente usam o LLManager para aprovar reembolsos de clientes ou solicitações de serviços. O sistema gera recomendações com base em dados históricos e a equipe as analisa manualmente para garantir que as decisões sejam justas e consistentes.

QA

- Quais modelos são compatíveis com o LLManager?

Os modelos de suporte, como OpenAI, Anthropic etc., precisam suportar a função de chamada de ferramenta. Os modelos não padrão exigem a instalação de pacotes de integração do LangChain, como@langchain/google-genai. - Como faço para reutilizar o mesmo assistente?

modificaçõesevals/e2e.int.test.tsSe estiver usando uma ID de auxiliar fixa ou procurando uma ID existente antes de executar uma avaliação, evite gerar um novo auxiliar. - Como ele é implementado em um ambiente de produção?

Implante o LangGraph em um servidor de nuvem, atualize o URL de implantação da Caixa de entrada do agente e use o LangSmith para monitorar o desempenho do fluxo de trabalho. - Como posso personalizar meu fluxo de trabalho?

Edite o subgráfico de raciocínio (para ajustar a lógica de geração do prompt) ou o subgráfico de reflexão (para controlar as regras de geração de reflexão) para se adaptar a cenários de aprovação específicos.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...