Estreia da série Llama 4: um novo começo para a inovação de IA multimodal nativa?

Em 5 de abril de 2025, a Meta lançou o Llama 4, a mais recente adição à sua família Llama de modelos de linguagem de grande porte, marcando um avanço significativo no campo da IA, particularmente na multimodalidade nativa e na arquitetura do modelo. No centro do anúncio estão os modelos Llama 4 Scout e Llama 4 Maverick, bem como uma prévia do modelo gigante de "professor" que sustenta a tecnologia, o Llama 4 Behemoth. Esse movimento não apenas demonstra o compromisso da Meta em se atualizar e tentar superar os principais modelos do setor, mas também dá continuidade à sua estratégia de promover um ecossistema de IA de código aberto.

Visão geral dos modelos principais da série Llama 4

A Meta está lançando dois modelos da série Llama 4 para desenvolvedores e aplicativos:

- Llama 4 ScoutO modelo tem 17 bilhões de parâmetros ativos e 16 Experts, totalizando 109 bilhões de parâmetros. O destaque é o melhor recurso multimodal da categoria, que supera todos os modelos anteriores da Llama. Ainda mais notável é o fato de que ele suporta até 10 milhões de token janela de contexto, excedendo em muito os 128K do Llama 3. A Meta afirma que o modelo supera o Gemma 3 e Gêmeos 2.0 Flash-Lite e IA Mistral (usado em uma expressão nominal) Mistral 3.1 e quantificado pelo Int4 para ser implantado em uma única GPU NVIDIA H100, mostrando um foco na eficiência.

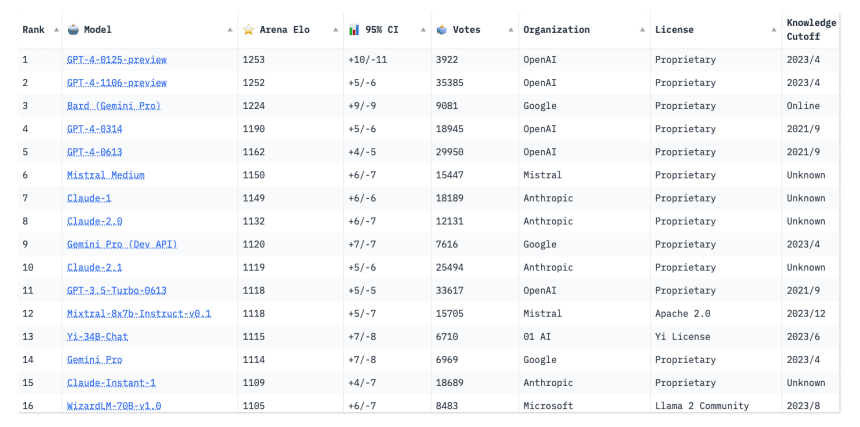

- Llama 4 MaverickEle também tem 17 bilhões de parâmetros ativos, mas é equipado com 128 especialistas e 400 bilhões de parâmetros totais. Posicionado como o melhor modelo multimodal de sua classe, ele pretende desafiar o GPT-4o da OpenAI e o Gemini 2.0 Flash do Google. De acordo com os dados publicados pela Meta, o Maverick tem um bom desempenho em vários benchmarks e chega perto de ter o dobro de parâmetros que seu parâmetro ativo, em termos de inferência e poder de codificação. DeepSeek v3 . Uma versão experimental do bate-papo está disponível em LMArena A tabela de classificação recebeu uma pontuação ELO de 1417, mostrando seu potencial para recursos de diálogo. O modelo pode ser executado em um único host NVIDIA H100 DGX.

Além disso, o Meta visualizou Llama 4 Behemoth Modelagem. É um gigante com 288 bilhões de parâmetros ativos, 16 especialistas e quase 2 trilhões de participantes no total. Ainda está em treinamento e não foi lançado, mas serve como um modelo "professor" para o Scout e o Maverick, aumentando o desempenho deste último por meio da destilação de conhecimento. O Behemoth se destaca em benchmarks de matemática, multilíngue e de imagem, e a Meta afirma que ele supera o GPT-4.5 em alguns benchmarks STEM, como o MATH-500 e o GPQA Diamond, Antrópica (usado em uma expressão nominal) Claude Sonnet 3.7 e Gemini 2.0 Pro do Google.

Principais inovações tecnológicas: MoE, multimodalidade e contextos longos

A série Llama 4 apresenta uma série de inovações tecnológicas importantes que sustentam seus aprimoramentos de desempenho.

Arquitetura híbrida do modelo de especialização (MoE)

A Llama 4 é a primeira família de modelos do Meta a adotar a arquitetura Mixed Expert (MoE), que tem atraído muita atenção nos últimos anos porque permite que os modelos ativem apenas um pequeno número de parâmetros (ou seja, "especialistas") em um momento de inferência, embora tenham um grande número de parâmetros totais. Esse projeto permite um desempenho mais alto do que os modelos densos tradicionais (Dense) para um determinado orçamento computacional de treinamento e melhora a eficiência computacional do treinamento e da inferência.

Como exemplo, o Llama 4 Maverick tem 400 bilhões de parâmetros totais distribuídos entre 128 especialistas em roteamento e um especialista compartilhado. Ao raciocinar, cada token é enviado para o especialista compartilhado e para um dos especialistas em roteamento. O modelo usa camadas densas e de MoE alternadas para equilibrar desempenho e eficiência. Essa arquitetura permite que o Maverick seja implantado em um único host H100 DGX ou maximize a eficiência por meio do raciocínio distribuído, reduzindo o custo e a latência dos serviços do modelo.

Multimodalidade nativa e integração precoce

Diferentemente das abordagens anteriores que treinaram modelos linguísticos antes de adaptá-los aos recursos visuais, o Llama 4 foi projetado para ser um modelo multimodal nativo. Ele emprega uma estratégia de fusão antecipada que integra perfeitamente tokens textuais e visuais na rede de backbone do modelo. Isso significa que o modelo pode ser pré-treinado em conjunto com grandes quantidades de dados de texto, imagem e vídeo não rotulados. A Llama 4 também aprimorou seu codificador visual, que se baseia no MetaCLIP, mas é treinado em conjunto com um modelo Llama congelado para acomodar melhor modelos de linguagem grandes. O modelo pode lidar com até 48 entradas de imagem no pré-treinamento e tem bom desempenho com até 8 entradas de imagem em testes pós-treinamento, além de ser capaz de lidar com várias entradas de imagem e dicas textuais para raciocínio e compreensão visual.

Janela de contexto de 10 milhões de tokens

Outro recurso diferenciado do Llama 4 Scout é sua janela de contexto líder do setor, com até 10 milhões de tokens. Essa enorme capacidade de contexto abre novas possibilidades para o processamento de documentos muito longos, a análise de conjuntos de dados em grande escala ou a condução de diálogos que exigem memória de longo prazo, por exemplo:

- Resumo e perguntas e respostas de vários relatórios ou livros extensos.

- Analisar a base de código completa para entender as dependências ou encontrar erros.

- Fornecer serviços personalizados e detalhados com base em semanas ou até meses de atividade do usuário.

- Extração e análise de informações em áreas como direito ou medicina, onde grandes quantidades de texto precisam ser processadas.

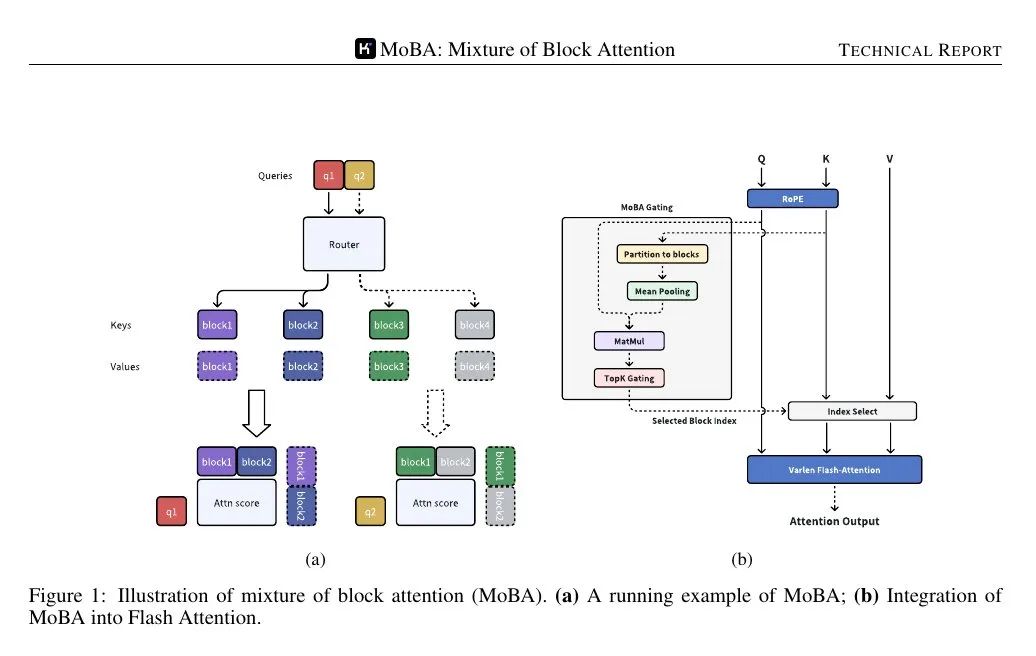

O Meta atribui as capacidades de longo contexto da Scout à sua inovadora iRoPE Arquitetura. A arquitetura usa um comprimento de contexto de 256K tanto para o pré-treinamento quanto para o pós-treinamento e combina camadas de atenção intercaladas (sem embeddings de posição) e escala de temperatura do tempo de inferência para aprimorar a generalização do comprimento. O "i" significa intercalado, e "RoPE" refere-se a Rotary Position Embeddings, sugerindo seu suporte para "comprimento de contexto infinito". sugerindo uma meta de longo prazo de suporte a comprimentos de contexto "infinitos".

Métodos de treinamento e desempenho

O desenvolvimento da Llama 4 envolveu muitos aprimoramentos no processo de treinamento.

Fase de pré-treinamento:

- Dados e escalaDados de treinamento: A quantidade total de dados de treinamento é superior a 30 trilhões de tokens, mais do que o dobro do Llama 3, e inclui um conjunto diversificado de conjuntos de dados de texto, imagem e vídeo. Suporte para 200 idiomas, sendo que mais de 100 idiomas têm mais de 1 bilhão de tokens de dados de treinamento.

- Eficiência e precisãoTreinamento: O treinamento é realizado com precisão FP8 para aumentar a eficiência computacional (390 TFLOPs/GPU para o Behemoth em GPUs de 32K), sem sacrificar a qualidade.

- Otimização de hiperparâmetrosDesenvolvimento de uma nova técnica denominada MetaP para definir de forma confiável os principais hiperparâmetros (por exemplo, taxa de aprendizado por camada, escala de inicialização) e constatou que esses parâmetros migraram bem entre tamanhos de lote, larguras de modelo, profundidades e número de tokens de treinamento.

- Meio do treinamentoIntrodução de métodos de treinamento e conjuntos de dados específicos após o pré-treinamento para ampliar os recursos de contexto longo e melhorar o desempenho principal.

Fase pós-treinamento:

- novo processoUm novo processo de Ajuste fino supervisionado leve (SFT) -> Aprendizado por reforço on-line (RL) -> Otimização de preferência direta leve (DPO) foi adotado. A Meta descobriu que o SFT e a DPO tradicionais poderiam restringir demais o modelo, limitando a exploração no estágio de RL e afetando a inferência, a codificação e a capacidade matemática.

- Filtragem de dadosRemover mais de 50% de dados de SFT rotulados como "fáceis" usando o modelo Llama como juiz e concentrando-se em SFT leve em conjuntos de dados mais difíceis.

- Aprendizado intensivo on-lineConclusão: Melhorias significativas no desempenho foram obtidas com a seleção cuidadosa de prompts (prompts) mais difíceis durante a fase de RL on-line multimodal. Uma estratégia de RL on-line contínua foi empregada, alternando entre o treinamento do modelo e o uso de dados filtrados pelo modelo, com apenas prompts de dificuldade moderada a difícil retidos, alcançando assim um equilíbrio entre computação e precisão.

- DPO levePor fim, um DPO leve é executado para lidar com casos de limite relacionados à qualidade da resposta do modelo, equilibrando a inteligência do modelo e os recursos de diálogo.

Comparação de desempenho:

A Meta publicou resultados de benchmark que mostram:

- Llama 4 MaverickDesempenho superior ao do GPT-4o e do Gemini 2.0 em benchmarks de codificação, inferência, multilíngue, contexto longo e imagem. Comparável ao DeepSeek v3.1 com escalas de parâmetros maiores em codificação e inferência.

- Llama 4 ScoutDesempenho superior, superando o Gemma 3, Gemini 2.0 Flash-Lite, Mistral 3.1 e todos os modelos Llama da geração anterior. Supera todos os modelos Llama anteriores em aterramento de imagem.

É importante observar que os resultados de benchmark são normalmente obtidos em condições específicas e o desempenho em aplicativos do mundo real pode variar. No entanto, esses dados pelo menos mostram que o Llama 4 tem o potencial de competir com os modelos líderes do setor em várias dimensões.

Behemoth: o "professor" de 2 trilhões de parâmetros e o desafio do treinamento

O Llama 4 Behemoth existe não apenas para demonstrar a capacidade do Meta de treinar modelos de escala muito grande, mas também para atuar como um "professor" no desenvolvimento do Llama 4. Por meio da codistilação, o Behemoth transferiu seu poder em matemática, multilinguismo e compreensão de imagens para o modelo menor Maverick, e o Meta desenvolveu uma nova função de perda de codistilação que ajusta dinamicamente os pesos do alvo suave (distribuições de probabilidade do modelo do professor) e do alvo difícil (os rótulos reais) durante o processo de treinamento. pesos. Essa destilação colaborativa durante o pré-treinamento amortiza o custo computacional significativo do cálculo das metas de destilação para o modelo do aluno.

O treinamento de um modelo com 2 trilhões de parâmetros é um enorme desafio de engenharia por si só. A meta divulgou alguma experiência com a fase pós-treinamento:

- poda de dadosPara maximizar o desempenho, os dados de SFT precisam ser podados de forma mais agressiva do que os modelos menores, em até 95%, para se concentrar em dados difíceis e de alta qualidade.

- Aprendizado intensivoA estratégia de RL concentra-se na seleção de pistas difíceis por meio da análise pass@k e na construção de sessões de treinamento de dificuldade crescente. A filtragem dinâmica de dicas de vantagem zero e a mistura de dicas de diferentes dimensões de habilidade em lotes de treinamento são essenciais para melhorar o desempenho matemático, de raciocínio e de codificação.

- As instruções são as seguintesA amostragem de diversas instruções do sistema (instruções do sistema) é essencial para garantir que o modelo mantenha uma boa aderência às instruções em tarefas de raciocínio e codificação.

- infraestruturaPara a arquitetura MoE e a hiperescala, a Meta otimizou seu projeto de paralelização e desenvolveu uma estrutura de treinamento de RL on-line totalmente assíncrona. A estrutura permite a alocação flexível de diferentes modelos a diferentes GPUs, equilibrando os recursos com base na velocidade de computação e, segundo consta, melhorando a eficiência do treinamento em cerca de 10 vezes em relação à geração anterior.

Segurança e mitigação de preconceitos

Como todos os desenvolvedores de modelos em grande escala, a Meta enfatizou seu foco em segurança e IA responsável no desenvolvimento do Llama 4. Sua abordagem abrange todo o ciclo de vida do desenvolvimento de modelos:

- Mitigação pré e pós-treinamentoUso de medidas como filtragem de dados na fase de pré-treinamento; aplicação de várias técnicas na fase de pós-treinamento, incluindo a injeção da quantidade certa de dados de segurança em cada estágio para que o modelo esteja em conformidade com a estratégia de uso.

- Ferramentas em nível de sistemaMeta: O Meta abre uma série de ferramentas de segurança para que os desenvolvedores possam integrá-las:

- Llama Guard: modelo de detecção de segurança de entrada/saída desenvolvido com base na taxonomia de risco da MLCommons.

- Guarda imediata:: modelos de classificadores para detectar dicas mal-intencionadas (por exemplo, ataques de jailbreak) e ataques de injeção.

- CyberSecEvalFerramenta de avaliação para avaliar e atenuar os riscos de segurança de redes de IA generativas.

O Meta enfatiza a capacidade de personalização dessas ferramentas, permitindo que os desenvolvedores adaptem as políticas de segurança às suas próprias necessidades.

- Avaliação e teste de equipe vermelhaDescrição: realizou testes de modelo do sistema com sondagem adversária automatizada e manual. Desenvolveu um sistema chamado GOAT (teste de agente ofensivo generativo) para melhorar a cobertura e a eficiência dos testes, simulando várias rodadas de interações de atacantes moderadamente habilidosos, permitindo que os especialistas humanos da equipe vermelha se concentrem em áreas de risco mais avançadas.

Abordagem de preconceitos

O Meta reconhece o problema da parcialidade que prevalece nos modelos de linguagem de grande porte, em especial a tendência histórica de favorecer determinadas posições em tópicos políticos e sociais controversos, o que decorre, em parte, da parcialidade inerente dos dados de treinamento da Internet. O objetivo do Llama 4 é remover a parcialidade dos modelos para que eles possam entender e articular diferentes lados de questões polêmicas sem parcialidade ou julgamento.

A Meta afirma que a Llama 4 fez progressos significativos nessa área, superando a Llama 3 e se comparando favoravelmente com a Grok Bastante:

- Em questões políticas e sociais polêmicas, a porcentagem de recusas de resposta caiu de 7% no Llama 3.3 para menos de 2%.

- A proporção de prompts que mostraram recusas desiguais (tendenciosas) foi menor do que o 1% para respostas de recusa.

- Em um conjunto de questões políticas ou sociais controversas, a Llama 4 mostra uma forte tendência política com uma frequência de respostas comparável à da Grok, cerca de metade da Llama 3.3.

A Meta afirma que continuará a trabalhar para reduzir a taxa de viés em seus modelos.

Abertura, usabilidade e ecossistemas

O Llama 4 Scout e o Llama 4 Maverick já estão disponíveis para download no site llama.com e no Hugging Face, e serão disponibilizados para todos os principais parceiros de computação em nuvem, de dados e de borda. Os usuários também podem experimentar o Llama 4-powered Meta AI .

A Meta enfatizou novamente seu compromisso com um ecossistema aberto, acreditando que a abertura impulsiona a inovação. O lançamento do Llama 4, em especial sua arquitetura MoE, recursos multimodais nativos e janelas de contexto ultralongas, certamente oferece novas ferramentas poderosas para desenvolvedores e pesquisadores de IA. No entanto, o desempenho real desses modelos avançados, sua facilidade de uso, o custo do ajuste fino e os possíveis riscos que eles representam ao conduzir "experiências personalizadas" ainda precisam ser testados e observados. Se a série Llama 4 realmente dará início a uma nova era de IA liderada pela Meta é algo que o mercado acabará respondendo. A Meta também anunciou que compartilhará mais informações sobre sua visão na LlamaCon, em 29 de abril.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...