LiveTalking: sistema interativo digital humano ao vivo em tempo real de código aberto para obter um diálogo síncrono de áudio e vídeo

Introdução geral

O LiveTalking é um sistema humano digital interativo em tempo real de código aberto, dedicado à criação de soluções humanas digitais ao vivo de alta qualidade. O projeto usa o protocolo de código aberto Apache 2.0 e integra várias tecnologias de ponta, incluindo renderização ER-NeRF, processamento de fluxo de áudio e vídeo em tempo real, sincronização labial e assim por diante. O sistema suporta renderização e interação humana digital em tempo real e pode ser usado para transmissão ao vivo, educação on-line, atendimento ao cliente e muitos outros cenários. O projeto ganhou mais de 4.300 estrelas e 600 ramificações no GitHub, mostrando uma forte influência da comunidade. O LiveTalking dá atenção especial ao desempenho em tempo real e à experiência interativa, e oferece aos usuários uma estrutura completa de desenvolvimento humano digital por meio da integração da tecnologia AIGC. O projeto é continuamente atualizado e mantido, e conta com o suporte de uma documentação abrangente, o que o torna a escolha ideal para a criação de aplicativos de pessoas digitais.

Lista de funções

- Há suporte para vários modelos humanos digitais:ernerfemusetalkewav2lipeUltraleve-Digital-Humano

- Obter diálogo simultâneo de áudio e vídeo

- Suporte para clonagem de som

- Pessoas pró-digital falando e sendo interrompidas

- Suporta emenda de vídeo de corpo inteiro

- Suporte a fluxos de envio RTMP e WebRTC

- Suporte para agendamento de vídeos: reproduza vídeos personalizados quando não estiver falando

- Oferece suporte a várias simultaneidades

Usando a Ajuda

1. processo de instalação

- Requisitos ambientais : Ubuntu 20.04, Python 3.10, Pytorch 1.12, CUDA 11.3

- Instalação de dependências ::

conda create -n nerfstream python=3.10

conda activate nerfstream

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

Se você não treinar. ernerf as seguintes bibliotecas não precisam ser instaladas:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

pip install --upgrade "protobuf<=3.20.1"

2. início rápido

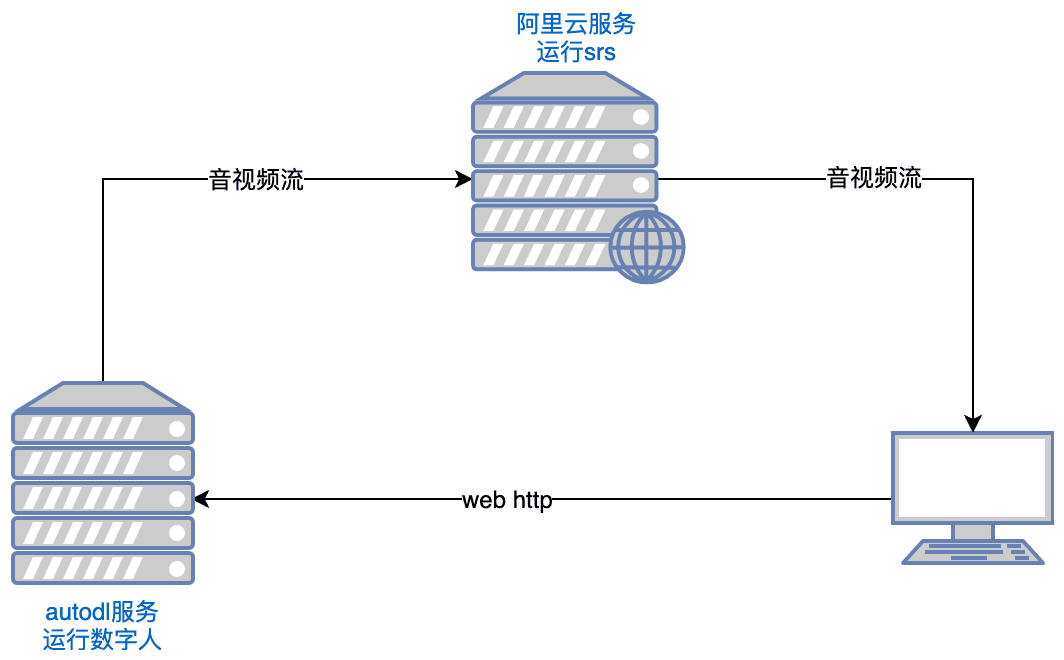

- Executando o SRS ::

export CANDIDATE='<服务器外网ip>'

docker run --rm --env CANDIDATE=$CANDIDATE -p 1935:1935 -p 8080:8080 -p 1985:1985 -p 8000:8000/udp registry.cn-hangzhou.aliyuncs.com/ossrs/srs:5 objs/srs -c conf/rtc.conf

Observações: o servidor precisa abrir as portas tcp:8000,8010,1985; udp:8000

- Lançamento da pessoa digital ::

python app.py

Se não for possível acessar o Huggingface, execute-o antes da execução:

export HF_ENDPOINT=https://hf-mirror.com

Abra com seu navegador http://serverip:8010/rtcpushapi.htmlSe você digitar algum texto na caixa de texto, envie-o, e a pessoa digital transmitirá a passagem.

Mais instruções de uso

- Docker em execução Não é necessário fazer a instalação anterior, basta executá-la:

docker run --gpus all -it --network=host --rm registry.cn-beijing.aliyuncs.com/codewithgpu2/lipku-metahuman-stream:vjo1Y6NJ3N

O código está no /root/metahuman-streamanterior git pull Obtenha o código mais recente e, em seguida, execute o comando como nas etapas 2 e 3.

- Espelhamento ::

- imagem automática:tutorial de autodl

- espelhos do ucloud:Tutorial do ucloud

- problemas comuns : Você pode consultar este artigo para obter informações sobre a configuração do ambiente CUDA do Linux:artigo de referência

3. instruções de configuração

- Configuração do sistema

- Edite o arquivo config.yaml para definir os parâmetros básicos

- Configuração de câmeras e dispositivos de áudio

- Configuração de parâmetros e caminhos do modelo de IA

- Configurar parâmetros de transmissão push ao vivo

- Preparação do modelo humano digital

- Suporte para importação de modelos 3D personalizados

- Modelos de exemplo pré-criados podem ser usados

- Suporta a importação de modelos MetaHuman

Funções principais

- Diálogo síncrono de áudio e vídeo em tempo real::

- Selecionar modelo de digitalizador: Selecione o modelo de digitalizador apropriado (por exemplo, ernerf, musetalk, etc.) na página de configuração.

- Seleção do método de transmissão de áudio/vídeo: selecione o método de transmissão de áudio/vídeo apropriado (por exemplo, WebRTC, RTMP, etc.) de acordo com os requisitos.

- Iniciar um diálogo: Inicie a transmissão de áudio/vídeo para obter um diálogo síncrono de áudio/vídeo em tempo real.

- Troca de modelo humano digital::

- Entrar na página de configuração: Na página Project Run, clique no botão Setup para entrar na página de configuração.

- Select New Model (Selecionar novo modelo): Selecione um novo modelo de Digimon na página Settings (Configurações) e salve as configurações.

- Restart Project (Reiniciar projeto): reinicia o projeto para aplicar a nova configuração do modelo.

- Ajuste dos parâmetros de áudio e vídeo::

- Entrar na página de configuração de parâmetros: Na página de execução do projeto, clique no botão de configuração de parâmetros para entrar na página de configuração de parâmetros.

- Parâmetros de ajuste: Ajuste os parâmetros de áudio e vídeo (como resolução, taxa de quadros, etc.) conforme necessário.

- Salvar e aplicar: Salva as configurações e aplica a nova configuração de parâmetros.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...