Guia rápido do gerente de produto para palavras-chave comumente usadas

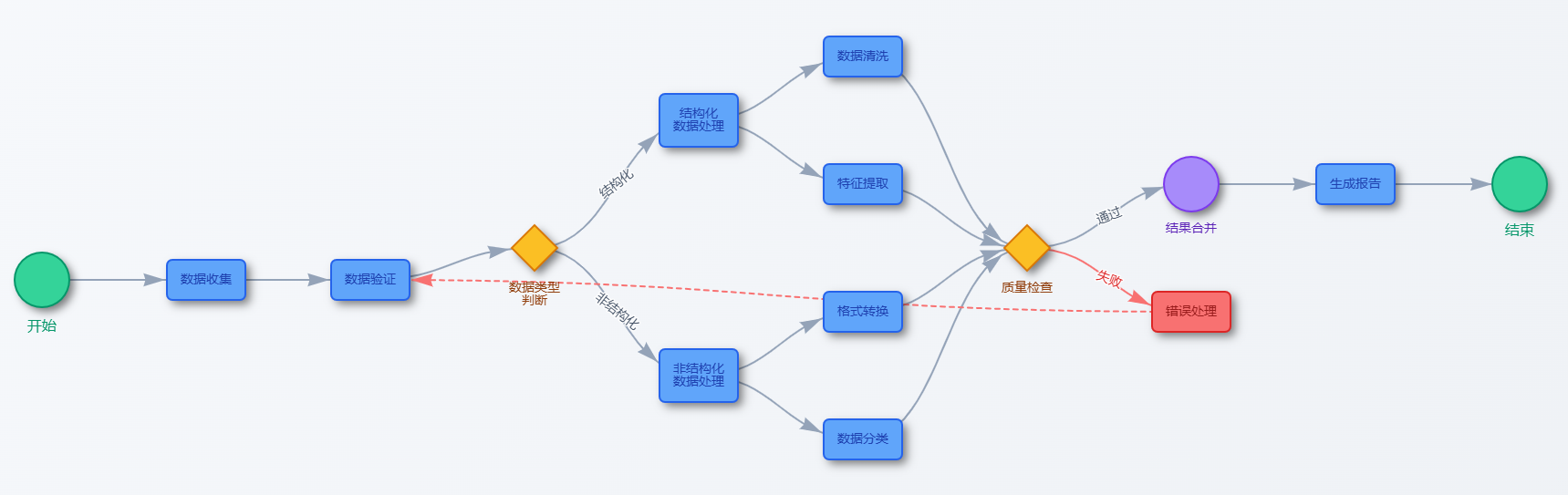

Introdução Bem-vindo ao Manual de Referência Rápida do Product Manager Cue Words. Este manual é uma coleção de dicas e truques que os gerentes de produto podem precisar usar em seu trabalho diário. O conteúdo abrange desde o aprimoramento de habilidades básicas, estudo de caso, aplicação de estrutura de gerenciamento até a seleção de ferramentas, lançamento de produtos, processamento de feedback do usuário, análise de dados...

![[转]从零拆解一款火爆的浏览器自动化智能体,4步学会设计自主决策Agent](https://aisharenet.com/wp-content/uploads/2025/01/e0a98a1365d61a3.png)