Resolvendo a confusão o1, os modelos de inferência como o DeepSeek-R1 estão pensando ou não?

Encontrei um artigo divertido sobre oThoughts Are All Over the Place: Sobre a subestimação de LLMs do tipo o1", o tópico é analisar o tipo o1 de modelo de raciocínio Mudança frequente de caminhos de pensamento e falta de foco no pensamento, conhecido como"subestimar".Também são apresentados métodos de mitigação. Este artigo responde simultaneamente à pergunta se o modelo de inferência está pensando novamente ou não, e esperamos que o leitor encontre sua própria resposta.

I. Histórico:

Nos últimos anos, os Modelos de Linguagem Grandes (LLMs), representados pelo modelo o1 da OpenAI, demonstraram capacidades superiores em tarefas de raciocínio complexas, nas quais imitam a profundidade do pensamento humano ao aumentar a quantidade de computação envolvida no processo de raciocínio. Entretanto, os estudos existentes questionaram a profundidade do pensamento dos LLMs:Esses modelos estão realmente pensando profundamente?

Para responder a essa pergunta, os autores deste artigo propõem"Pensamento insuficiente".do conceito e o analisa sistematicamente. Os autores argumentam que onão há alimento suficiente para reflexãoé a classe o1 dos LLMs na solução de problemas complexos.O abandono de caminhos de inferência promissores muito cedo leva a uma profundidade de pensamento insuficiente e, em última análise, afeta o desempenho do modelo. Esse fenômeno é particularmente proeminente nos quebra-cabeças de matemática.

II. métodos de reflexão e pesquisa:

Para se aprofundar no fenômeno do subconsideração, os autores realizaram a seguinte pesquisa:

1. definições e o fenômeno da subobservação e do subconsideração

- Definindo o pensamento: Os autores definem "pensar" como uma etapa cognitiva intermediária no processo de raciocínio de um modelo e usam termos como "alternativamente" como sinal de uma mudança no pensamento.

- Exemplo: Na Figura 2, os autores mostram um exemplo do resultado de um modelo com 25 etapas de pensamento e o comparam com o resultado do pensamento excessivo.

- Projeto experimental:

- Conjuntos de teste: Os autores escolheram três conjuntos de testes desafiadores:

- MATH500. Contém perguntas de competições de matemática do ensino médio, com dificuldade de 1 a 5.

- Diamante GPQA. Contém perguntas de múltipla escolha em nível de pós-graduação em física, química e biologia.

- AIME2024. Os tópicos do U.S. Invitational Mathematics Competition abrangem uma ampla gama de áreas, incluindo álgebra, contagem, geometria, teoria dos números e probabilidade.

- Seleção de modelos: Os autores escolheram dois modelos de código aberto da classe o1 com longas cadeias de pensamento visíveis: o QwQ-32B-Preview e o DeepSeek-R1-671B, e usaram o DeepSeek-R1-Preview como complemento para mostrar o desenvolvimento da família de modelos R1.

- Conjuntos de teste: Os autores escolheram três conjuntos de testes desafiadores:

2. análise das manifestações de reflexão inadequada

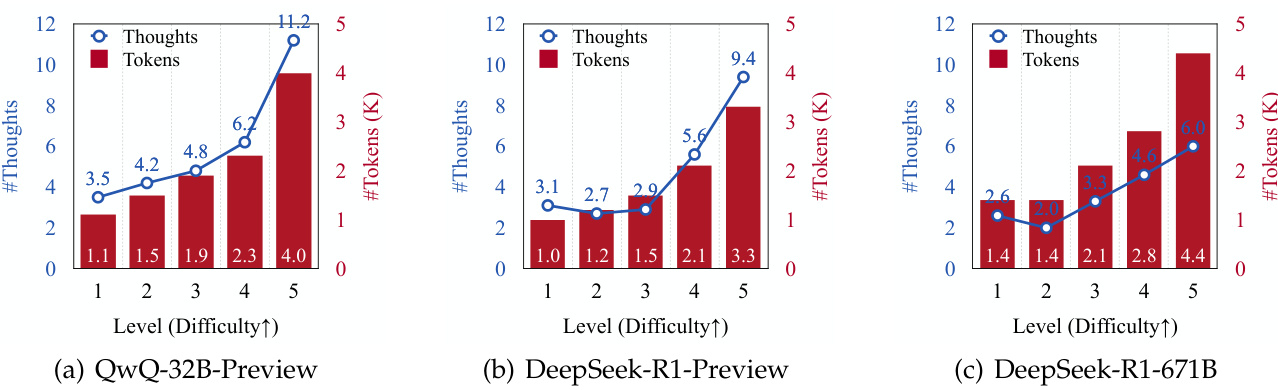

- Pensar na frequência de troca e na dificuldade do problema:

- Os autores descobriram que o número de reflexões de inferência geradas e o número de tokens gerados aumentaram para todos os modelos à medida que a dificuldade do problema aumentou (consulte a Figura 3).

- Isso sugere que os LLMs da classe o1 são capazes de adaptar dinamicamente o processo de raciocínio para lidar com problemas mais complexos.

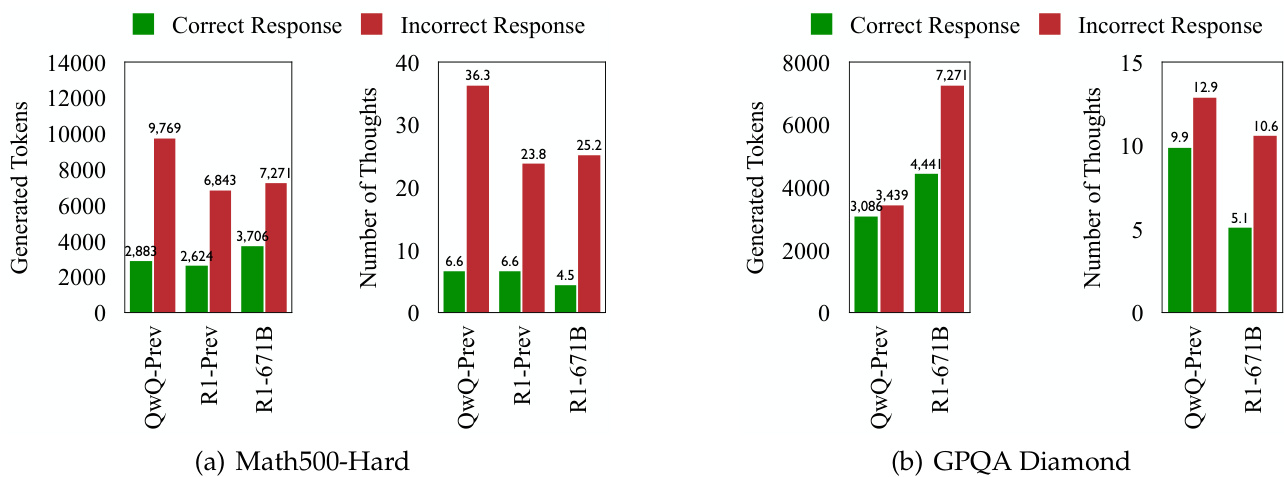

- Pensando em comutação e resposta a erros:

- Em todos os conjuntos de teste, os LLMs da classe o1 apresentaram mudanças de pensamento mais frequentes ao gerar respostas incorretas (veja as Figuras 1 e 4).

- Isso sugere que, embora o modelo tenha como objetivo adaptar dinamicamente os processos cognitivos para solucionar problemas, mudanças de pensamento mais frequentes não levam necessariamente a uma maior precisão.

3. investigação aprofundada sobre a natureza do déficit de raciocínio

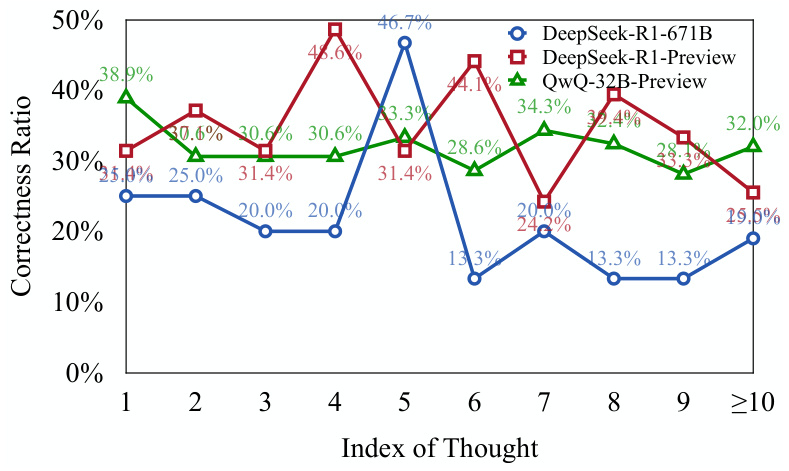

- Avaliar a correção do pensamento:

- Os autores usaram dois modelos baseados em Llama e Qwen (DeepSeek-R1-Distill-Llama-70B e DeepSeek-R1-Distill-Qwen-32B) para avaliar se cada etapa de pensamento estava correta.

- Os resultados mostram queUma parte significativa das etapas iniciais de raciocínio na resposta ao erro está correta, mas não foi totalmente explorada(veja a figura 5).

- Isso sugere que o modelo, quando confrontado com um problema complexoTendência a abandonar prematuramente caminhos promissores de raciocínio, levando a uma falta de profundidade de pensamento.

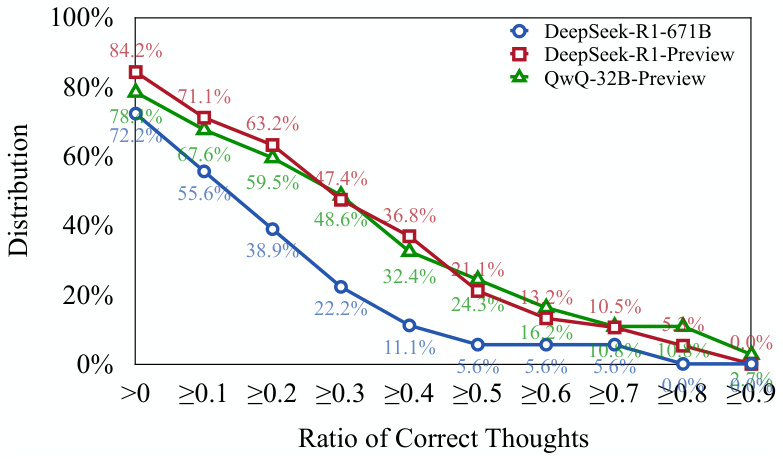

- Pense na distribuição da correção:

- Os autores descobriram que mais de 701 respostas de erro do TP3T continham pelo menos uma etapa de pensamento correta (veja a Figura 6).

- Isso apóia ainda mais a visão acima:o Os modelos da Classe 1 são capazes de iniciar os caminhos corretos de raciocínio, mas pode ser difícil continuar esses caminhos até a conclusão correta.

4. quantificando a falta de reflexão: propondo novos indicadores para avaliação

- Pensando em subindicadores (UT):

- Essa métrica quantifica o grau de subconsideração medindo a eficiência do token ao gerar uma resposta de erro.

- Especificamente, a métrica UT calcula a resposta de erro na qual oNúmero de tokens pensados corretamente desde o início até o primeiro como uma proporção do número total de tokens.

- Valores mais altos de UT indicam níveis mais altos de subconsciênciaou seja, uma proporção maior do token gerado pelo modelo em resposta a um erro não contribui efetivamente para gerar o pensamento correto.

5 Impacto do pensamento insuficiente no desempenho do modelo:

- Os autores descobriram queO fenômeno do pensamento subestimado tem desempenho diferente entre conjuntos de dados e tarefas::

- Nos conjuntos de dados MATH500-Hard e GPQA Diamond, o modelo DeepSeek-R1-671B, embora mais preciso, também teve um valor de UT mais alto, sugerindo mais subestimação em sua resposta a erros.

- No conjunto de testes AIME2024, o modelo DeepSeek-R1-671B não só tem uma precisão maior, mas também um valor UT menor, indicando um processo de inferência mais focado e eficiente.

III. Conclusões importantes:

- O pensamento insuficiente é um fator importante no desempenho ruim dos LLMs da categoria o1 em problemas complexos. As frequentes mudanças de pensamento resultam em modelos que não conseguem explorar profundamente os caminhos de inferência promissores, o que acaba afetando sua precisão.

- O fenômeno do pensamento insuficiente está relacionado à dificuldade do problema e à capacidade de modelagem. Problemas mais difíceis exacerbam a falta de pensamento, e modelos mais poderosos nem sempre reduzem a falta de pensamento.

- Pensar mal é diferente de pensar demais. Pensar demais é quando um modelo desperdiça recursos computacionais em problemas simples, enquanto pensar de menos é quando um modelo abandona prematuramente caminhos de inferência promissores em problemas complexos.

- O Underthinking Indicator (UT) pode quantificar efetivamente o grau de subconsideração. Essa métrica oferece uma nova perspectiva para avaliar a eficiência do raciocínio dos LLMs da classe o1.

IV. Estratégias de resposta:

Para aliviar o problema do pensamento inadequado, os autores propõem umEstratégia de decodificação com penalidade de mudança de pensamento (TIP)::

- Ideias centrais: Durante o processo de decodificação, as penalidades são aplicadas ao token associado ao think switch, oIncentivar os modelos a explorar mais profundamente o pensamento atual antes de mudar para um novo pensamento.

- Resultados: A estratégia TIP melhora a precisão do modelo QwQ-32B-Preview em todos os conjuntos de testes, demonstrando sua eficácia na atenuação do problema de subestimação.

V. Perspectivas futuras:

Os autores sugerem que as futuras direções de pesquisa incluem:

- Desenvolvimento de mecanismos adaptativos para permitir que os modelos autorregulem os interruptores de pensamento.

- Melhorar ainda mais a eficiência da inferência de LLMs da classe o1.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Publicações relacionadas

Nenhum comentário...