Jan: Assistente de IA off-line de código aberto, substituto do ChatGPT, executa modelos de IA locais ou se conecta à IA na nuvem

Introdução geral

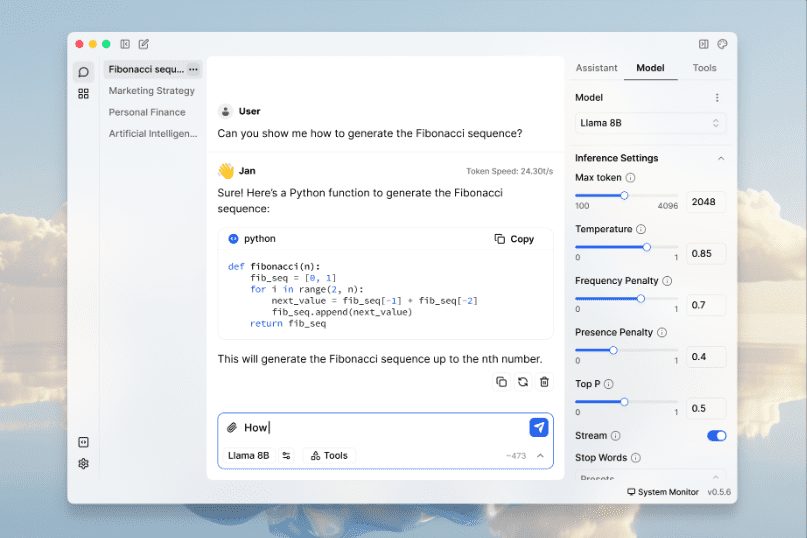

Jan é um software de código aberto ChatGPT O Jan oferece uma rica biblioteca de modelos que podem ser baixados e executados off-line no dispositivo 100% do usuário. Ele é acionado por um mecanismo Cortex e oferece suporte a uma ampla gama de plataformas de hardware, incluindo GPUs NVIDIA e chips da série M da Apple. O Jan oferece uma biblioteca rica de modelos que os usuários podem baixar e executar, como Llama, Gemma e Mistral O Jan é alimentado pelo Cortex, um mecanismo de IA nativo incorporável que pode ser executado em qualquer hardware, desde PCs até clusters com várias GPUs.

Lista de funções

- Execução de modelos de IA localmenteSuporte para Llama, Gemma, Mistral e muitos outros modelos populares.

- Suporte a vários motoresCompatível com llama.cpp, TensorRT-LLM e muitos outros mecanismos.

- operação off-lineNão é necessária conexão com a Internet e todo o processamento de dados é feito localmente.

- biblioteca de modelosOferece recursos avançados de download e gerenciamento de modelos.

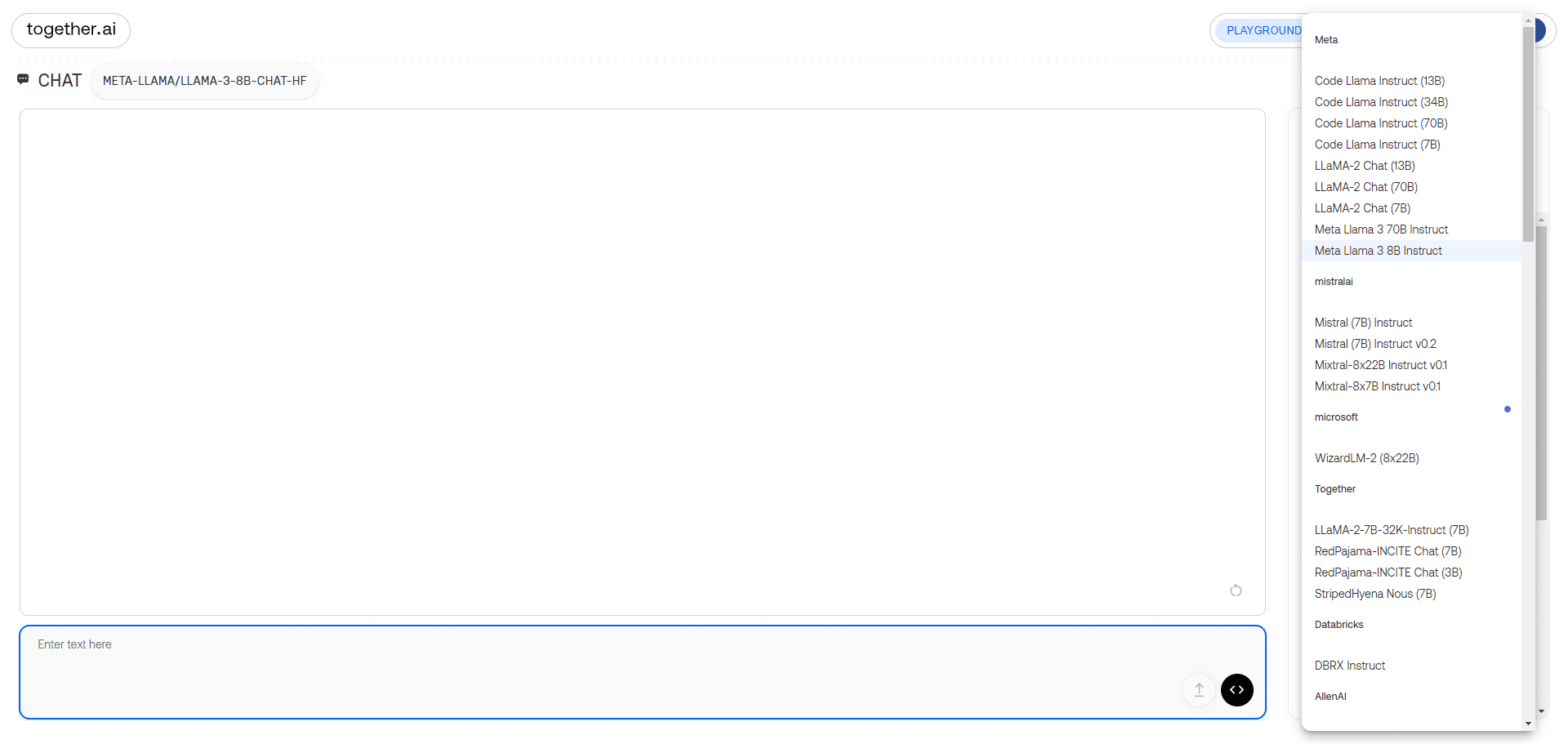

- Conexão AI remotaConecte-se a serviços remotos de IA, como OpenAI, Groq, Cohere e outros.

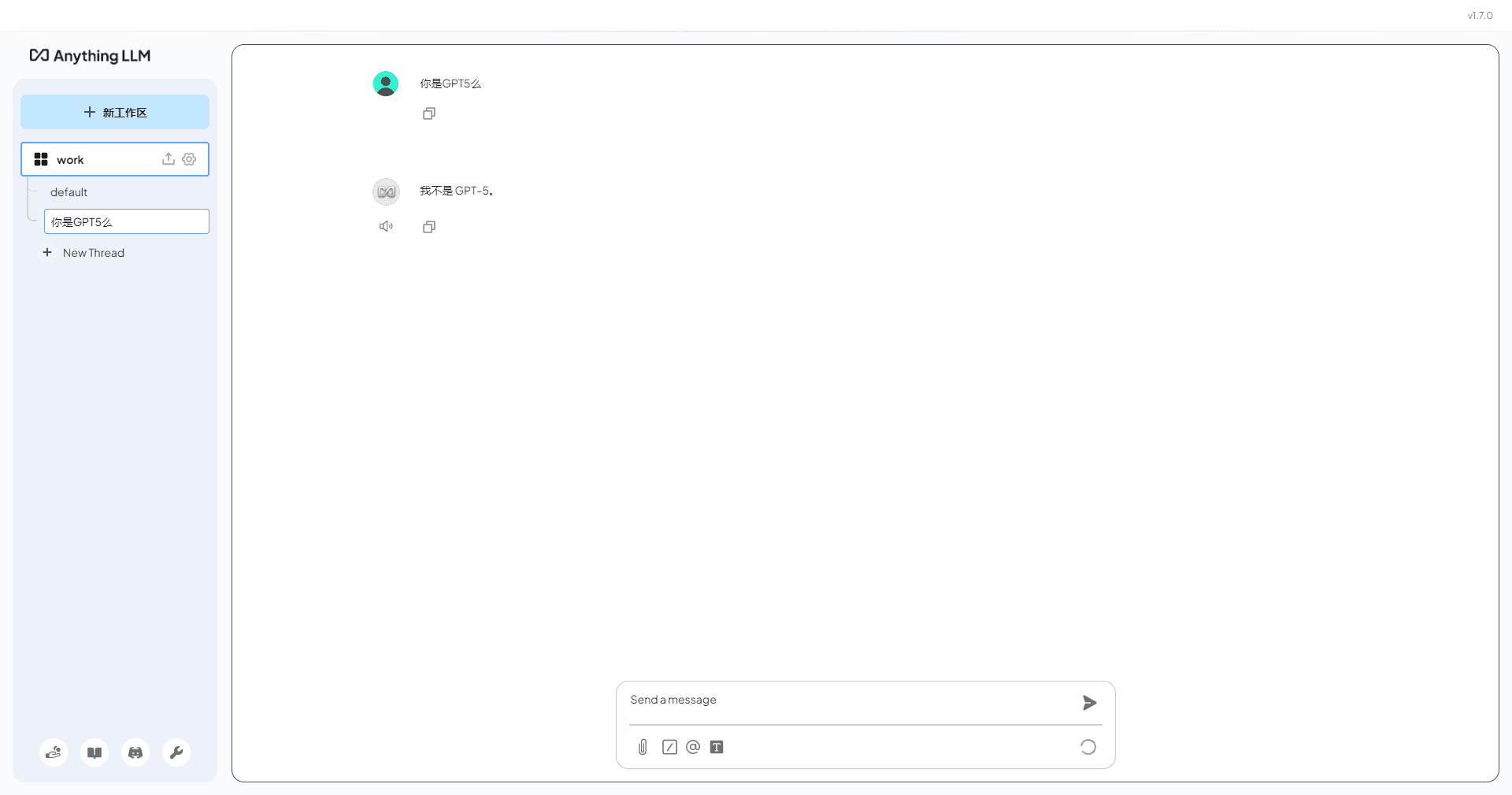

- Servidor de API localConfigure e execute um servidor de API local compatível com OpenAI.

- A altura pode ser personalizadaSuporte à personalização de recursos por meio de plug-ins de extensão.

- PrivacidadeTodos os dados são armazenados localmente e o usuário tem controle total sobre os dados.

Usando a Ajuda

Processo de instalação

- download: Acesso Site oficial da Jan talvez Página do GitHub Faça o download do pacote de instalação para Windows, MacOS ou Linux.

- montagem::

- Windows (computador)Execute o download

jan.exesiga as instruções para concluir a instalação. - MacOS: Download

jan.dmgclique duas vezes para abri-lo e arraste Jan para a pasta Aplicativos. - Linux: Download

.debtalvez.AppImageinstale-o usando a linha de comando ou execute-o diretamente.

- Windows (computador)Execute o download

Diretrizes para uso

- iniciar um aplicativoQuando a instalação estiver concluída, abra o aplicativo Jan.

- Selecione o modeloSelecione e faça o download do modelo de IA desejado na biblioteca de modelos, como Llama, Gemma ou Mistral.

- operação localSelecione o modelo baixado, clique no botão "Run" (Executar) e o modelo será iniciado no dispositivo local.

- Conexão de IA remotaSe precisar de mais capacidade de computação, você pode configurar e se conectar a serviços remotos de IA, como OpenAI, Groq, etc., nas configurações.

- Usando o servidor de APIAtivar o servidor de API local em Settings, seguir as instruções para configurar a chave de API e você poderá desenvolver e testar com APIs compatíveis com OpenAI.

- Extensões personalizadasVisite o Extension Centre para fazer download e instalar os plug-ins de extensão necessários e personalizar a funcionalidade do Jan para atender a necessidades específicas.

Procedimento de operação detalhado

- Download e gerenciamento de modelos::

- Abra o aplicativo Jan e vá para a Biblioteca de modelos.

- Procure os modelos disponíveis e clique no botão "Download" para fazer o download.

- Quando o download for concluído, o modelo aparecerá na lista "Downloaded" (Baixado).

- Selecione o modelo e clique no botão "Run" (Executar) para iniciar o modelo.

- Configuração do servidor de API local::

- Vá para a página "Settings" (Configurações) e localize a opção "API server" (Servidor de API).

- Ative o servidor de API e defina a chave de API.

- Use a documentação da API fornecida para começar a desenvolver chamando a API nativa.

- Instalação do plug-in de extensão::

- Visite o Extension Centre para pesquisar as extensões disponíveis.

- Clique no botão "Install" (Instalar) e siga as instruções para concluir a instalação.

- Após a instalação, a extensão será exibida na lista "Installed" (Instalada).

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...