Inception Labs lança o primeiro modelo de difusão de Big Language de nível comercial

A Inception Labs apresenta a família Mercury de dLLMs (Diffused Large Language Models), que são até 10 vezes mais rápidos e mais baratos do que os LLMs existentes, levando a modelagem de linguagem a novas fronteiras de inteligência e velocidade.

centro

- A Inception Labs lançou oficialmente a família Mercury de dLLMs (Diffused Large Language Models), marcando o nascimento de uma nova geração de LLMs e anunciando um novo nível de tecnologia de geração de texto rápida e de alta qualidade.

- O Mercury é 10 vezes mais rápido do que os LLMs atuais com velocidade otimizada. Nas GPUs NVIDIA H100, os modelos Mercury são executados a mais de 1.000 tokens/segundo, uma velocidade que antes só era possível com chips personalizados.

- modelo de geração de código Codificador Mercury Agora em playground A Inception Labs fornece acesso a modelos de código e modelos genéricos para clientes corporativos por meio de APIs e implementações nativas.

Visão da Inception Labs - Difusão Capacitando a próxima geração de LLMs

Os modelos de idiomas grandes (LLMs) atuais geralmente usam um modelo autorregressivo, o que significa que eles são escritos como a escrita humana, da esquerda para a direita, um por um token Geração de texto. Essa geração é inerentemente serial - os tokens anteriores devem ser gerados antes que os tokens subsequentes possam ser gerados, e cada token gerado requer a avaliação de uma rede neural com bilhões de parâmetros. As empresas de LLM líderes do setor estão apostando no aumento da computação no tempo de inferência para melhorar os recursos de inferência e correção de erros de seus modelos, mas a geração de longos processos de inferência também está fazendo com que os custos de inferência disparem e a latência aumente, o que acaba tornando os produtos difíceis de usar. É imprescindível uma mudança de paradigma para tornar as soluções de IA de alta qualidade realmente onipresentes.

Os modelos de difusão oferecem a possibilidade dessa mudança de paradigma. Esses modelos usam um processo de geração "grosseiro a fino". Conforme mostrado no vídeo, a saída do modelo começa com ruído puro e é progressivamente otimizada em várias etapas de "redução de ruído".

Diferentemente dos modelos autorregressivos, os modelos de difusão não são limitados a considerar apenas o que foi produzido anteriormente. Isso os torna melhores em termos de inferência e estruturação de respostas. Além disso, como os modelos de difusão são capazes de otimizar continuamente seus resultados, eles podem corrigir erros e reduzir ilusões com eficácia. É com base nessas vantagens que os modelos de difusão são um dos principais impulsionadores de muitas das atuais soluções de IA de destaque na geração de vídeo, imagem e áudio, como Sora, Midjourney e Riffusion, para citar alguns. Entretanto, as tentativas de aplicar modelos de difusão a dados discretos, como texto e código, nunca foram bem-sucedidas até agora. Até o Mercury, essa situação estava completamente quebrada.

Mercury Coder - Mais de 1.000 tokens por segundo, inteligência de ponta na ponta de seus dedos!

A Inception Labs tem o prazer de anunciar o lançamento do Mercury Coder, o primeiro dLLM disponível publicamente.

O Mercury Coder ultrapassa os limites dos recursos de IA: ele é de 5 a 10 vezes mais rápido do que os LLMs da geração atual e fornece respostas de alta qualidade a um custo muito menor. O Mercury Coder é o resultado de uma pesquisa inovadora da equipe fundadora do Inception Labs, que não só foi pioneira na modelagem de difusão de imagens, mas também co-inventou muitas IAs geradoras essenciais, incluindo a otimização direta de preferências (DPO) e os transformadores de decisões. O Mercury Coder é o resultado de uma pesquisa inovadora da equipe fundadora do Inception Labs, que não apenas foi pioneira na modelagem de difusão de imagens, mas também co-inventou várias tecnologias centrais de IA generativa, incluindo Direct Preference Optimization (DPO), Flash Attention e Decision Transformers.

O dLLM pode ser usado como um substituto direto dos LLMs autorregressivos existentes e oferece suporte a todos os cenários de aplicativos, incluindo RAG (Retrieval Augmentation Generation), uso de ferramentas e fluxos de trabalho de agentes. Ao receber uma consulta do usuário, o dLLM não gera a resposta token a token, mas gera a resposta de forma grosseira a fina, conforme mostrado na animação acima. O modelo de transformador (usado no Mercury Coder) foi treinado em uma grande quantidade de dados e é capaz de otimizar a qualidade da resposta globalmente, modificando vários tokens em paralelo para melhorar continuamente os resultados. O modelo Transformer (usado no Mercury Coder) é treinado em uma grande quantidade de dados para otimizar a qualidade da resposta globalmente e modificar vários tokens em paralelo para melhorar continuamente os resultados.

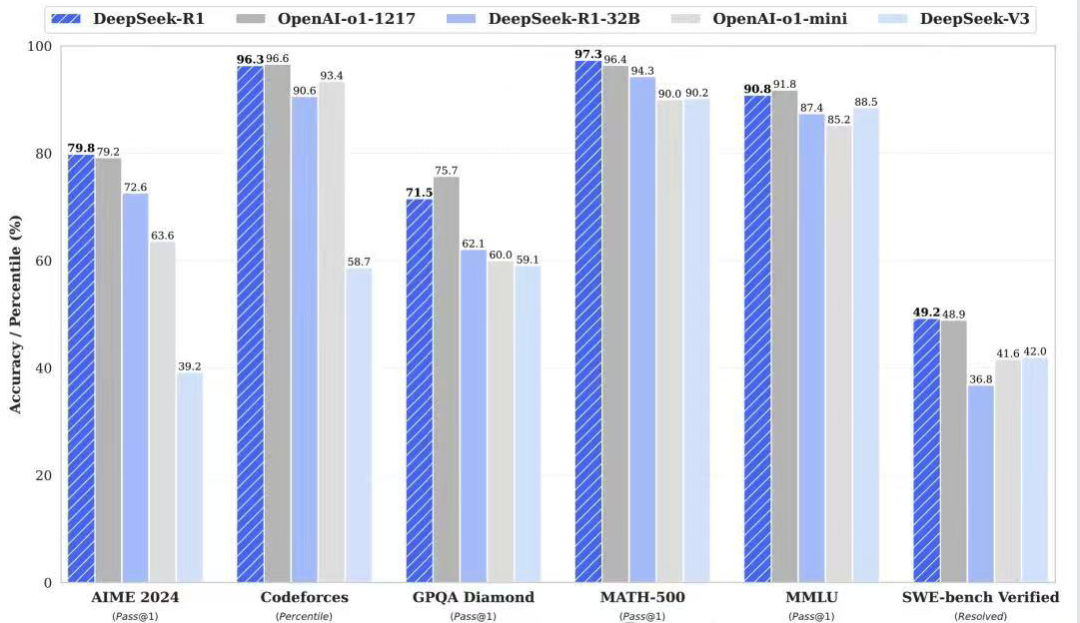

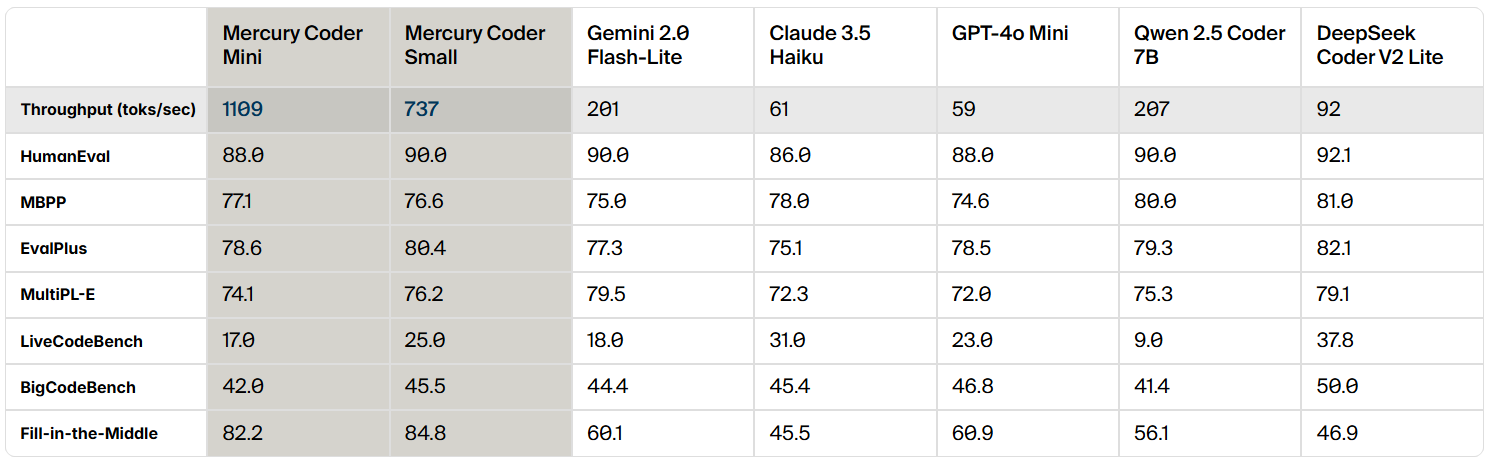

O Mercury Coder é um dLLM otimizado para a geração de código e, em análises de benchmark de código padrão, o Mercury Coder se destaca em uma ampla gama de benchmarks, muitas vezes superando o GPT-4o Mini e o Claude 3.5 Os modelos autorregressivos com velocidade otimizada, como o Haiku, também são até 10 vezes mais rápidos.

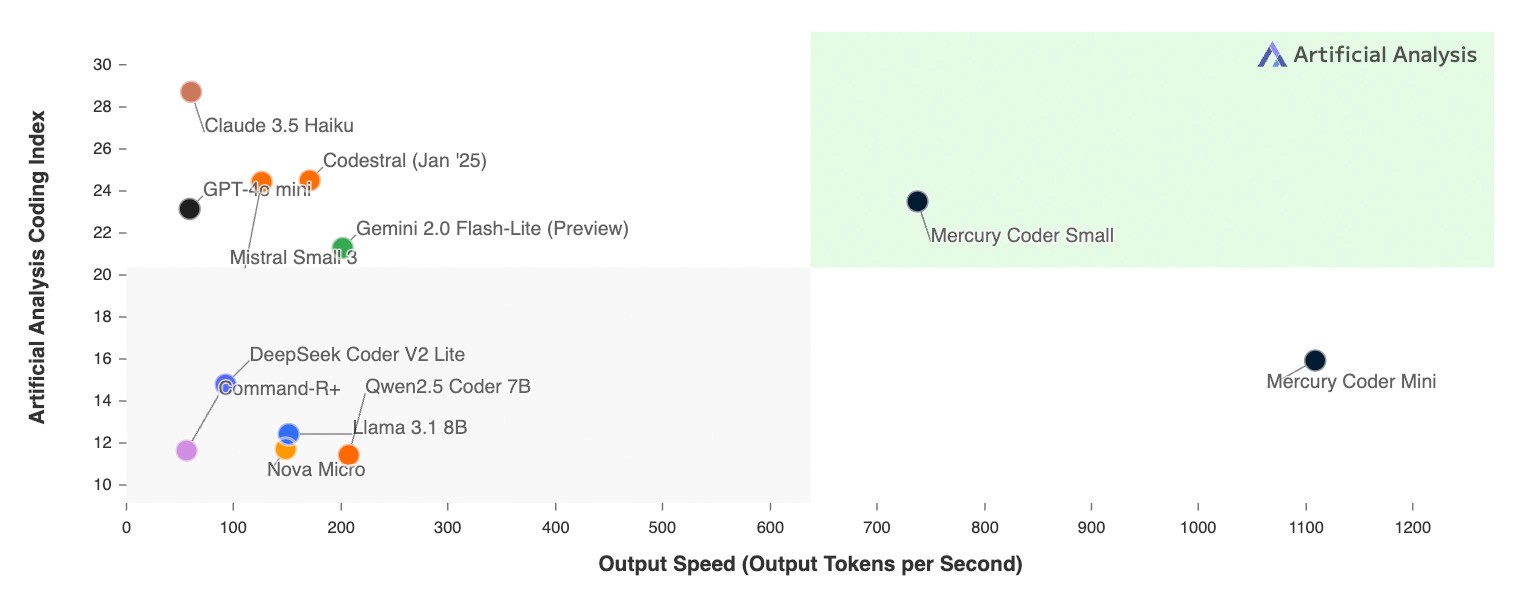

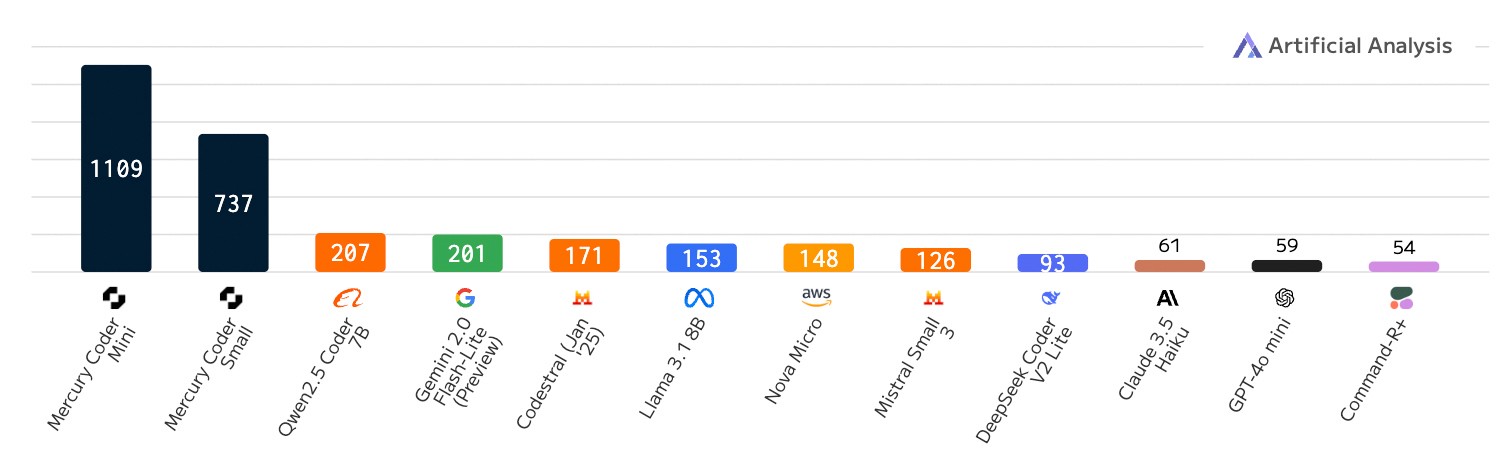

O recurso exclusivo do dLLM é sua incrível velocidade. Enquanto até mesmo os modelos autorregressivos com velocidade otimizada são executados a um máximo de 200 tokens/seg., o Mercury Coder é executado a mais de 1.000 tokens/seg. em uma GPU NVIDIA H100 de uso geral, uma velocidade 5x maior. O Mercury Coder é até 20 vezes mais rápido do que alguns modelos de fronteira, que podem ser executados a menos de 50 tokens/seg.

Anteriormente, somente hardware dedicado, como Groq, Cerebras e SambaNova, conseguia atingir taxas de transferência como a dLLM. Os aprimoramentos algorítmicos do Mercury Coder e a aceleração de hardware andam de mãos dadas e, em chips mais rápidos, os aumentos de velocidade aumentam ainda mais.

Comparação de velocidade: número de tokens emitidos por segundo; cargas de trabalho de gravação de código

Ainda mais interessante é o fato de os desenvolvedores preferirem o recurso de preenchimento de código do Mercury Coder. Na seção Copiloto Nos benchmarks da Arena, o Mercury Coder Mini empatou em segundo lugar, superando os modelos com velocidade otimizada, como o GPT-4o Mini e o Gemini-1.5-Flash, e até mesmo igualando o desempenho de modelos maiores, como o GPT-4o. Ao mesmo tempo, o Mercury Coder também é o modelo mais rápido, cerca de quatro vezes mais rápido que o GPT-4o Mini.

A Inception Labs convida você a experimentar o poder do Mercury Coder por si mesmo. A Inception Labs fez uma parceria com a Lambda Labs na playground A plataforma fornece a você um acesso de teste ao Mercury Coder. Experimente como o Mercury Coder gera código de alta qualidade em uma fração do tempo, conforme mostrado no vídeo abaixo.

O que isso significa para os aplicativos de IA?

Os primeiros a adotar o Mercury dLLM, incluindo os líderes de mercado em suporte ao cliente, geração de código e automação empresarial, estão mudando com sucesso do modelo básico autorregressivo padrão para o Mercury dLLM como um substituto direto. Essa mudança se traduz diretamente em uma melhor experiência do usuário e em custos mais baixos. Em cenários de aplicativos sensíveis à latência, os parceiros muitas vezes tiveram que escolher modelos menores e menos capazes no passado para atender a requisitos rigorosos de latência. Agora, graças ao desempenho superior da dLLM, esses parceiros podem usar modelos maiores e mais potentes e, ao mesmo tempo, atender aos requisitos originais de custo e velocidade.

A Inception Labs fornece acesso à família de modelos Mercury por meio de uma API e de uma implantação local. Os modelos Mercury são totalmente compatíveis com o hardware, os conjuntos de dados e os processos de ajuste fino supervisionado (SFT) e de alinhamento (RLHF) existentes.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...