HeyGem: Produto de almofada de alfinetes humana digital Heygen de código aberto da Silicon Intelligence

Introdução geral

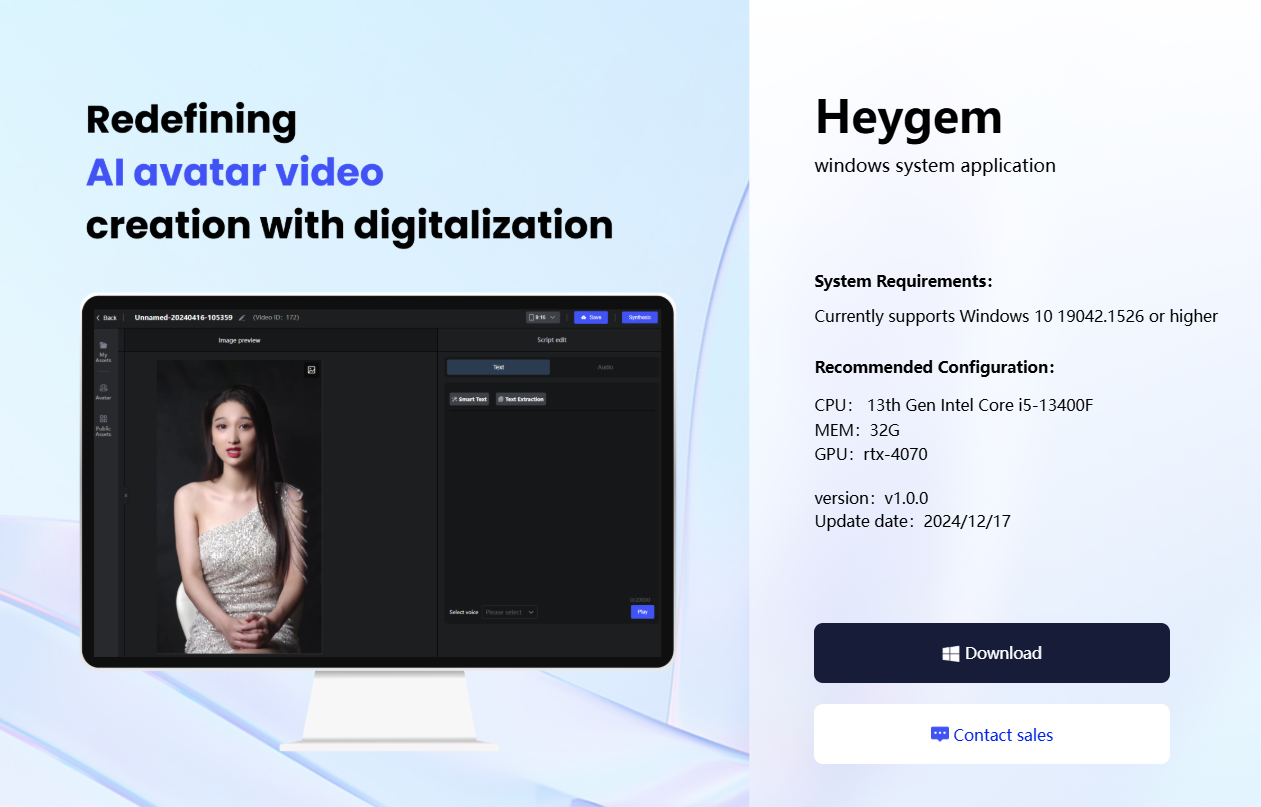

O HeyGem é uma ferramenta de composição de vídeo totalmente off-line para Windows, desenvolvida pela equipe do GuijiAI e de código aberto no GitHub. Ela usa algoritmos avançados de IA para clonar com precisão a aparência e a voz de um usuário para criar avatares realistas e oferecer suporte a vídeos personalizados acionados por texto ou voz. A ferramenta não precisa estar conectada à Internet, todas as operações são feitas localmente para garantir a privacidade e a segurança do usuário. O HeyGem oferece suporte a scripts em vários idiomas (incluindo inglês, japonês, coreano, chinês e outros oito idiomas), interface simples e intuitiva, adequada para usuários sem formação técnica para começar rapidamente, e fornece uma API aberta, que é conveniente para os desenvolvedores ampliarem a funcionalidade. Há alguns meses, a Silicon Intelligence abriu a versão móvel de código aberto da pessoa digital DUIX: pessoas digitais inteligentes para interação em tempo real, com suporte à implantação multiplataforma com um clique.

Endereço oficial de download do HeyGem: https://heygem.ai/

Lista de funções

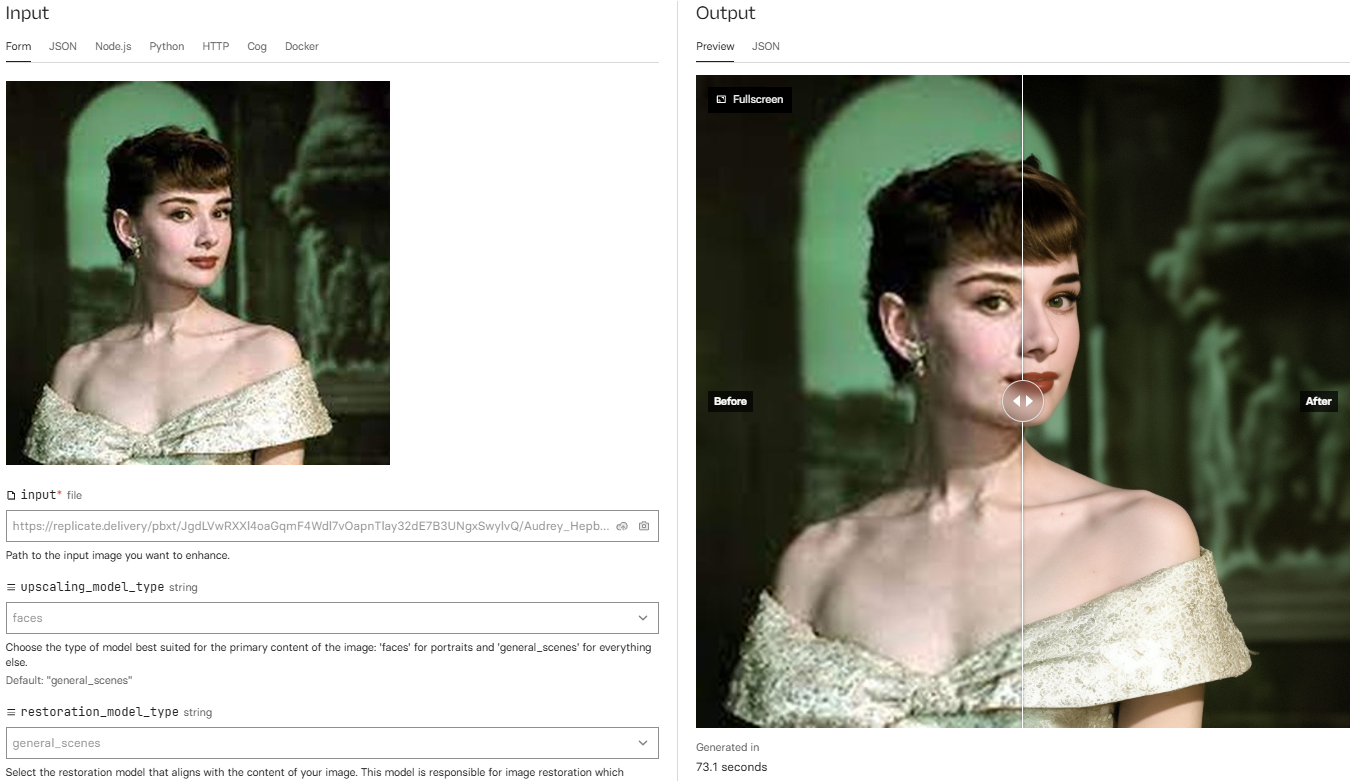

- Clonagem precisa de aparência e vozA tecnologia de IA captura características faciais e detalhes vocais para gerar avatares e vozes de alta fidelidade com suporte para ajuste de parâmetros.

- Imagem virtual baseada em textoO avatar é um personagem de uma família: depois que o texto é inserido, a ferramenta gera automaticamente uma fala natural e aciona o avatar por meio de sincronização labial e movimentos de expressão.

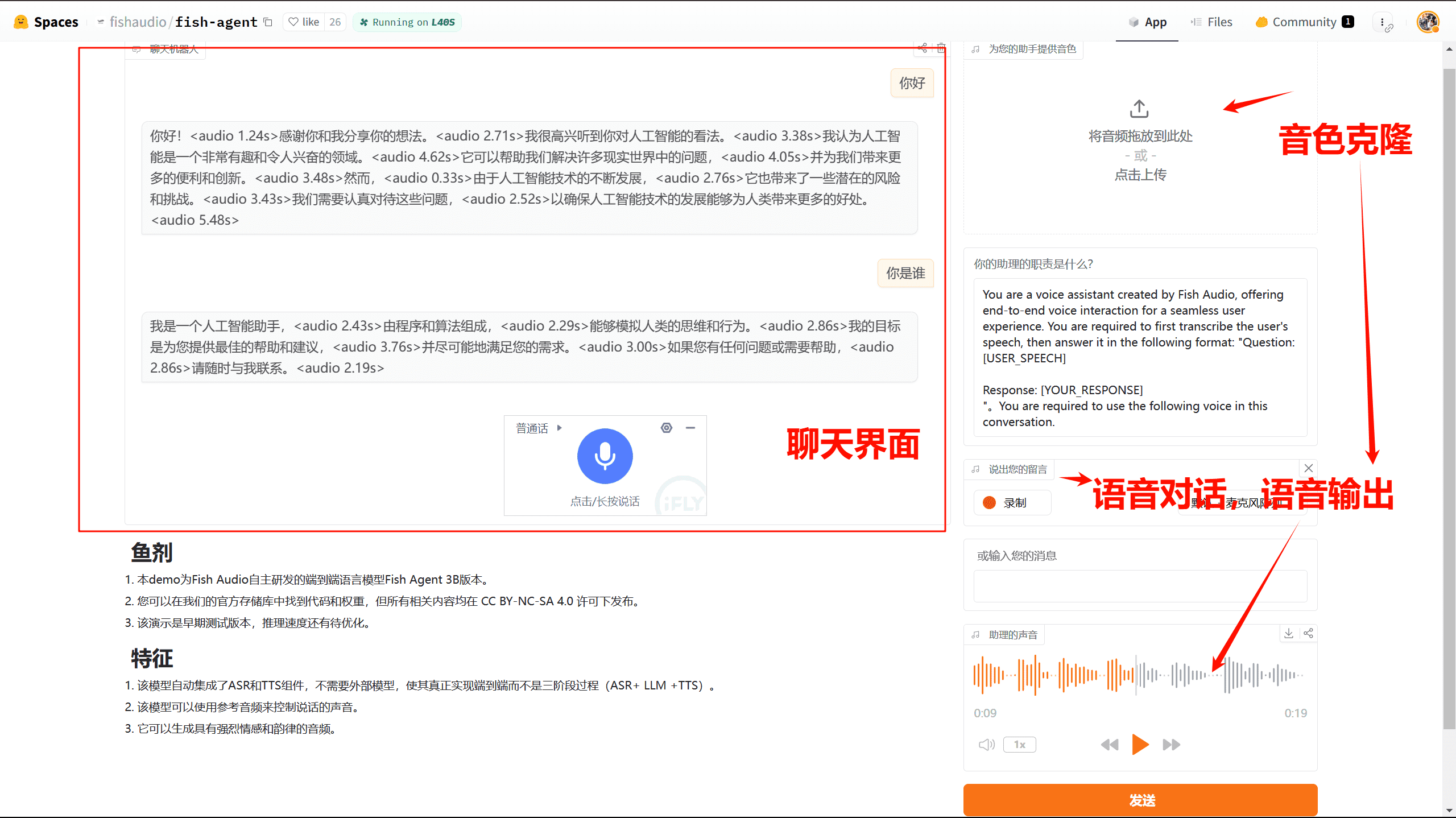

- Produção de vídeo orientada por vozGerar vídeos dinâmicos controlando o tom e o ritmo do avatar por meio da entrada de voz do usuário.

- Operação totalmente off-lineNão é necessária nenhuma conexão de rede e todos os dados são processados localmente para garantir a privacidade e a segurança.

- Suporte a vários idiomasScripts de oito idiomas são suportados: inglês, japonês, coreano, chinês, francês, alemão, árabe e espanhol.

- Composição eficiente de vídeoOtimização inteligente da sincronização de áudio e vídeo para garantir uma combinação natural entre o formato dos lábios e a voz.

- Interface de API de código abertoAPIs para treinamento de modelos e composição de vídeo, com recursos personalizáveis para desenvolvedores.

Usando a Ajuda

Processo de instalação

O processo de instalação a seguir segue rigorosamente as instruções oficiais, mantendo o texto original e os endereços das imagens:

Pré-requisitos

- Deve ter o disco DArmazenamento de imagens digitais e dados de projetos: Principalmente para armazenar imagens digitais e dados de projetos

- Requisito de espaço livre: mais de 30 GB

- Disco CUsado para armazenar arquivos de imagem de serviço

- Requisito de espaço livre: mais de 100 GB

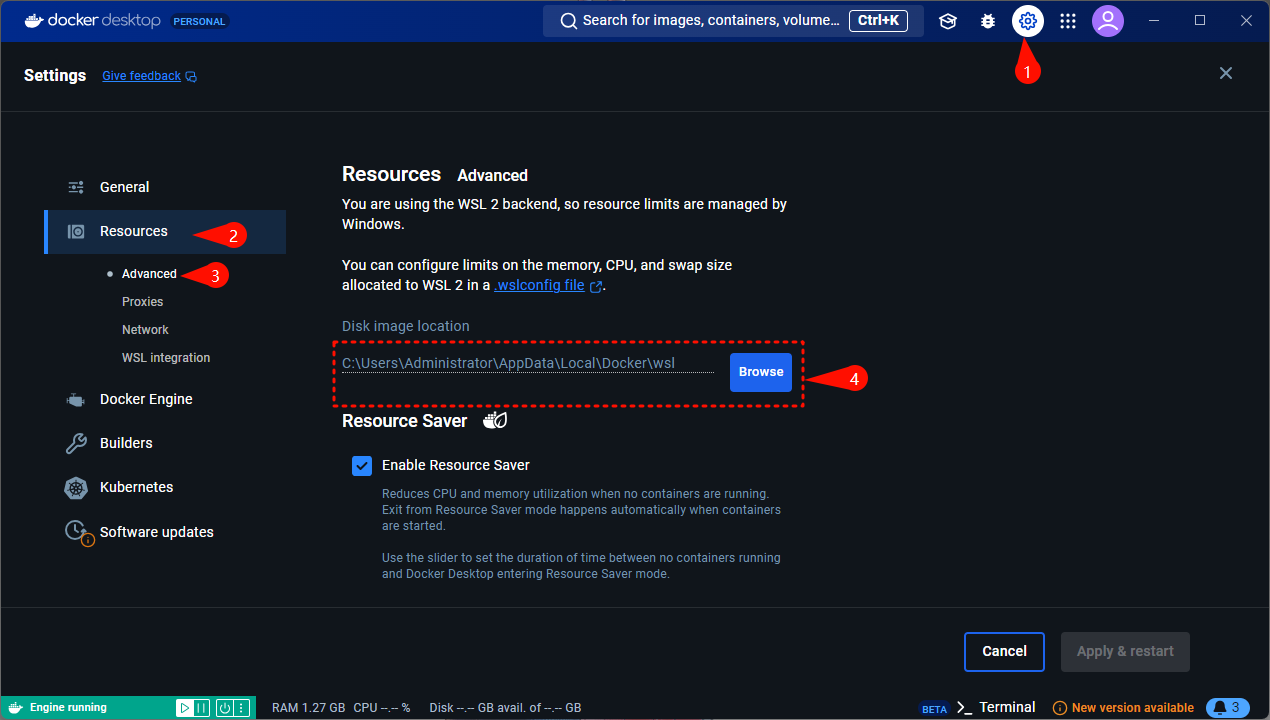

- Se você tiver menos de 100 GB de espaço livre, depois de instalar o Docker, poderá selecionar uma pasta em um disco com mais de 100 GB de espaço livre no local mostrado abaixo:

- Requisitos do sistema::

- Atualmente, é compatível com o Windows 10 19042.1526 ou posterior

- Configurações recomendadas::

- CPU: Intel Core i5-13400F de 13ª geração

- Memória: 32 GB

- Placa de vídeo: RTX-4070

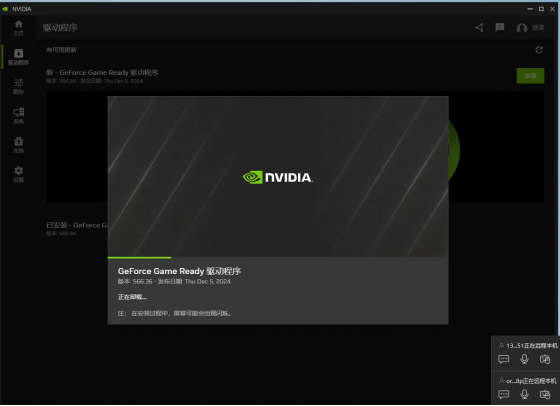

- Certifique-se de que você tenha uma placa de vídeo NVIDIA e que os drivers estejam instalados corretamente.

- Link para download do driver NVIDIA: https://www.nvidia.cn/drivers/lookup/

- Link para download do driver NVIDIA: https://www.nvidia.cn/drivers/lookup/

Instalação do Windows Docker

- Usando comandos

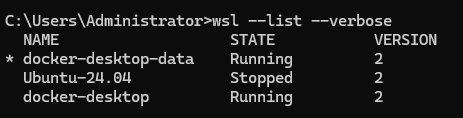

wsl --list --verboseVerifique se a WSL está instalada. A figura a seguir mostra que ela está instalada e não precisa ser reinstalada:

- Comandos de instalação da WSL:

wsl --install - Pode falhar devido a problemas de rede, tente várias vezes

- É necessário configurar e lembrar um novo nome de usuário e senha durante o processo de instalação

- Comandos de instalação da WSL:

- fazer uso de

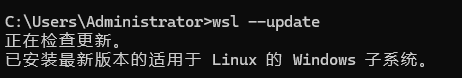

wsl --updateAtualização da WSL:

- Faça o download do Docker para Windows e escolha um instalador adequado à arquitetura de sua CPU.

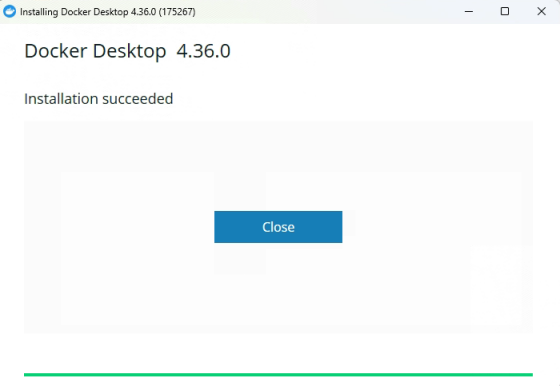

- Essa tela indica que a instalação foi bem-sucedida:

- Executar o Docker:

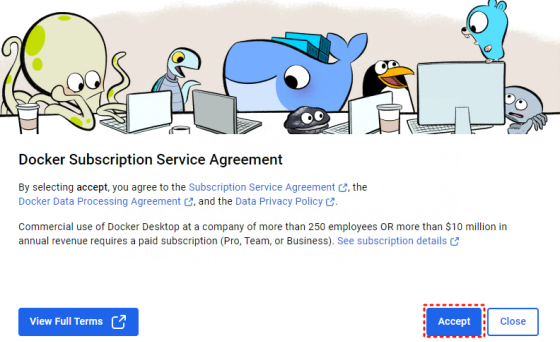

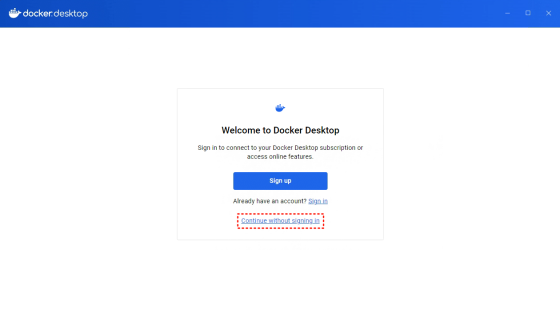

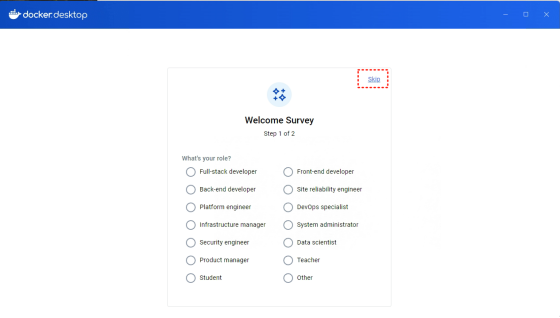

- Aceita o protocolo e ignora o login na primeira execução:

Instalação do servidor

Instale o seguinte usando o Docker e o docker-compose:

docker-compose.ymlO arquivo está localizado no diretório/deployCatálogo.- existir

/deploypara executar odocker-compose up -d. - Aguarde pacientemente (cerca de meia hora, dependendo da velocidade da Internet); o download consumirá cerca de 70 GB de tráfego; certifique-se de usar o WiFi.

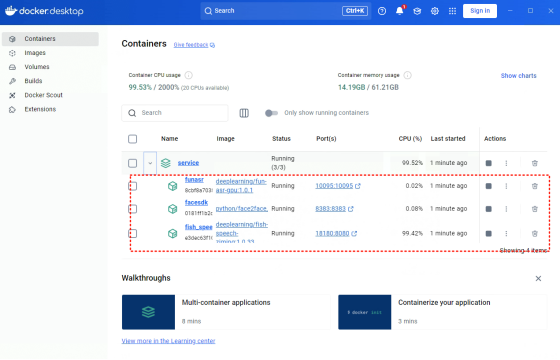

- O sucesso é indicado quando três serviços são vistos no Docker:

Cliente

- Script de construção

npm run build:winApós a execução, ele estará no diretóriodistGeração de catálogosHeyGem-1.0.0-setup.exe. - clique duas vezes

HeyGem-1.0.0-setup.exeRealize a instalação.

Dependências

- Nodejs 18

- Imagem do Docker:

docker pull guiji2025/fun-asr:1.0.1docker pull guiji2025/fish-speech-ziming:1.0.39docker pull guiji2025/heygem.ai:0.0.7_sdk_slim

Funções principais

1. clonagem de aparência e voz

- Preparar o material

- Grave uma voz clara (10 a 30 segundos no formato WAV) e coloque-a no

D:\heygem_data\voice\data. - Tire uma foto de alta resolução da frente e coloque-a no arquivo

D:\heygem_data\face2face(Os caminhos podem ser encontrados na seçãodocker-compose.yml(Ajustado em).

- Grave uma voz clara (10 a 30 segundos no formato WAV) e coloque-a no

- Execução da função clone

- Inicie o cliente, abra a interface e selecione "Model Training".

- Chamando a API

http://127.0.0.1:18180/v1/preprocess_and_tranparâmetros de entrada, como:{ "format": ".wav", "reference_audio": "D:/heygem_data/voice/data/sample.wav", "lang": "zh" } - Obtenha os resultados retornados (por exemplo, caminho de áudio e texto) e salve-os para uso posterior.

2. imagens virtuais orientadas por texto

- texto de entrada

- Selecione "Audio Synthesis" (Síntese de áudio) na interface do cliente e chame a API.

http://127.0.0.1:18180/v1/invokeparâmetros de entrada, como:{ "speaker": "unique-uuid", "text": "欢迎体验 HeyGem.ai", "format": "wav", "topP": 0.7, "max_new_tokens": 1024, "chunk_length": 100, "repetition_penalty": 1.2, "temperature": 0.7, "need_asr": false, "streaming": false, "is_fixed_seed": 0, "is_norm": 0, "reference_audio": "返回的音频路径", "reference_text": "返回的文本" }

- Selecione "Audio Synthesis" (Síntese de áudio) na interface do cliente e chame a API.

- Gerar vídeo

- Uso da interface de síntese

http://127.0.0.1:8383/easy/submitparâmetros de entrada, como:{ "audio_url": "生成的音频路径", "video_url": "D:/heygem_data/face2face/sample.mp4", "code": "unique-uuid", "chaofen": 0, "watermark_switch": 0, "pn": 1 } - Informe-se sobre o progresso:

http://127.0.0.1:8383/easy/query?code=unique-uuid.

- Uso da interface de síntese

- Salvar resultados

- Quando terminar, o arquivo de vídeo será salvo localmente no caminho especificado.

3. produção de vídeo orientada por voz

- gravar voz

- Grave sua voz no cliente ou carregue arquivos WAV diretamente no

D:\heygem_data\voice\data.

- Grave sua voz no cliente ou carregue arquivos WAV diretamente no

- Gerar vídeo

- Chame as APIs de composição de áudio e vídeo acima para gerar um vídeo de avatar com ações.

- Visualização e ajuste

- O efeito é visualizado por meio do cliente e pode ser gerado novamente após o ajuste dos parâmetros.

Dicas e truques

- Requisito de materialFoto: As fotografias precisam ser iluminadas de maneira uniforme e a fala precisa estar livre de ruídos.

- Suporte a vários idiomas: definido nos parâmetros da API

langé o código do idioma correspondente (por exemplo, "zh" para chinês). - Suporte ao desenvolvedor: Referência

src/main/serviceSob o código, personalize a funcionalidade.

advertência

- O sistema precisa atender aos requisitos de espaço de 100 GB para a unidade C e 30 GB para a unidade D.

- Certifique-se de que a WSL esteja ativada antes de instalar o Docker.

- São necessários 70 GB de tráfego para fazer o download da imagem. Recomenda-se o uso de uma rede WiFi estável.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...