HealthGPT: um grande modelo médico para apoiar a análise de imagens médicas e as perguntas e respostas de diagnóstico

Introdução geral

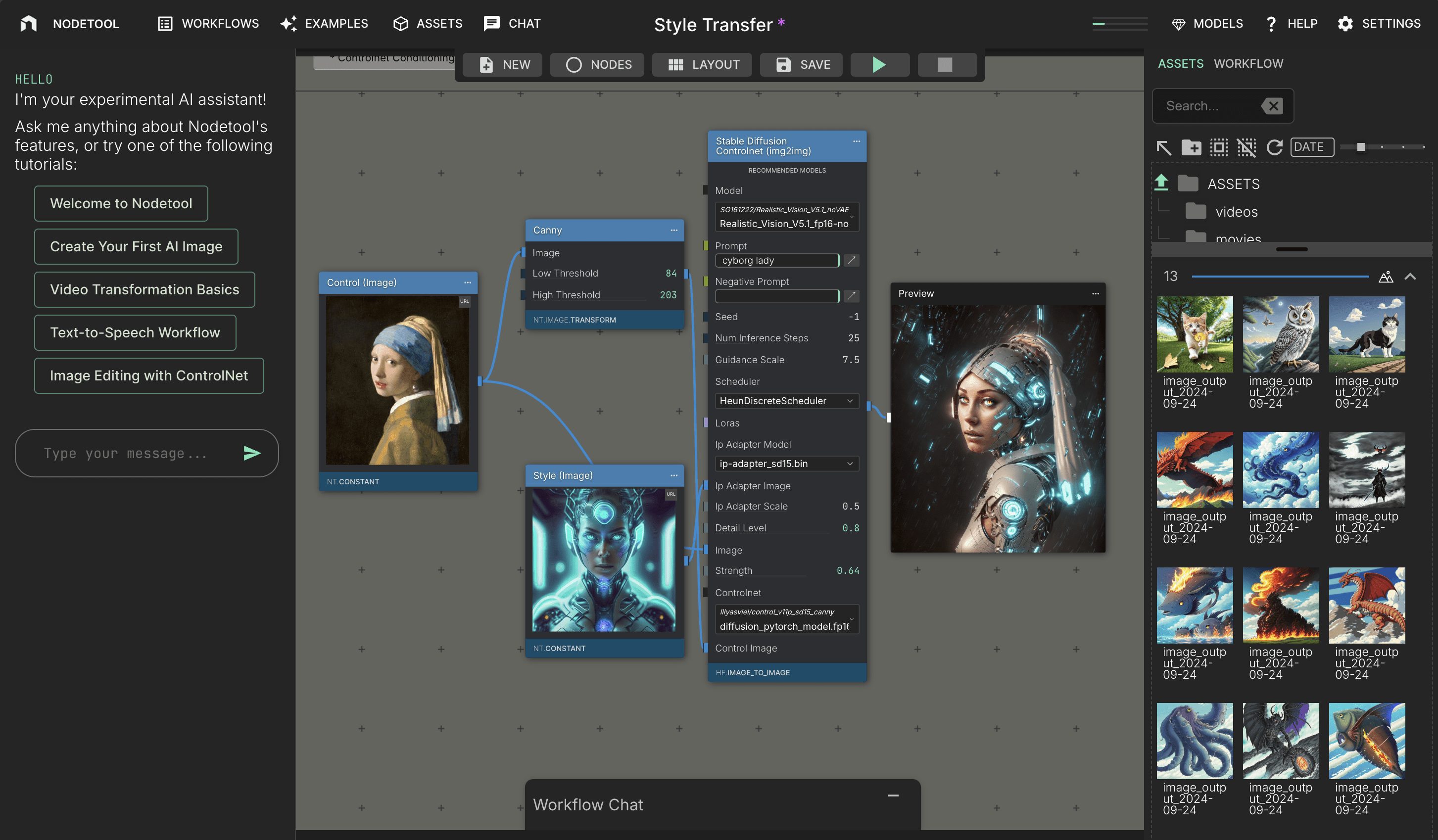

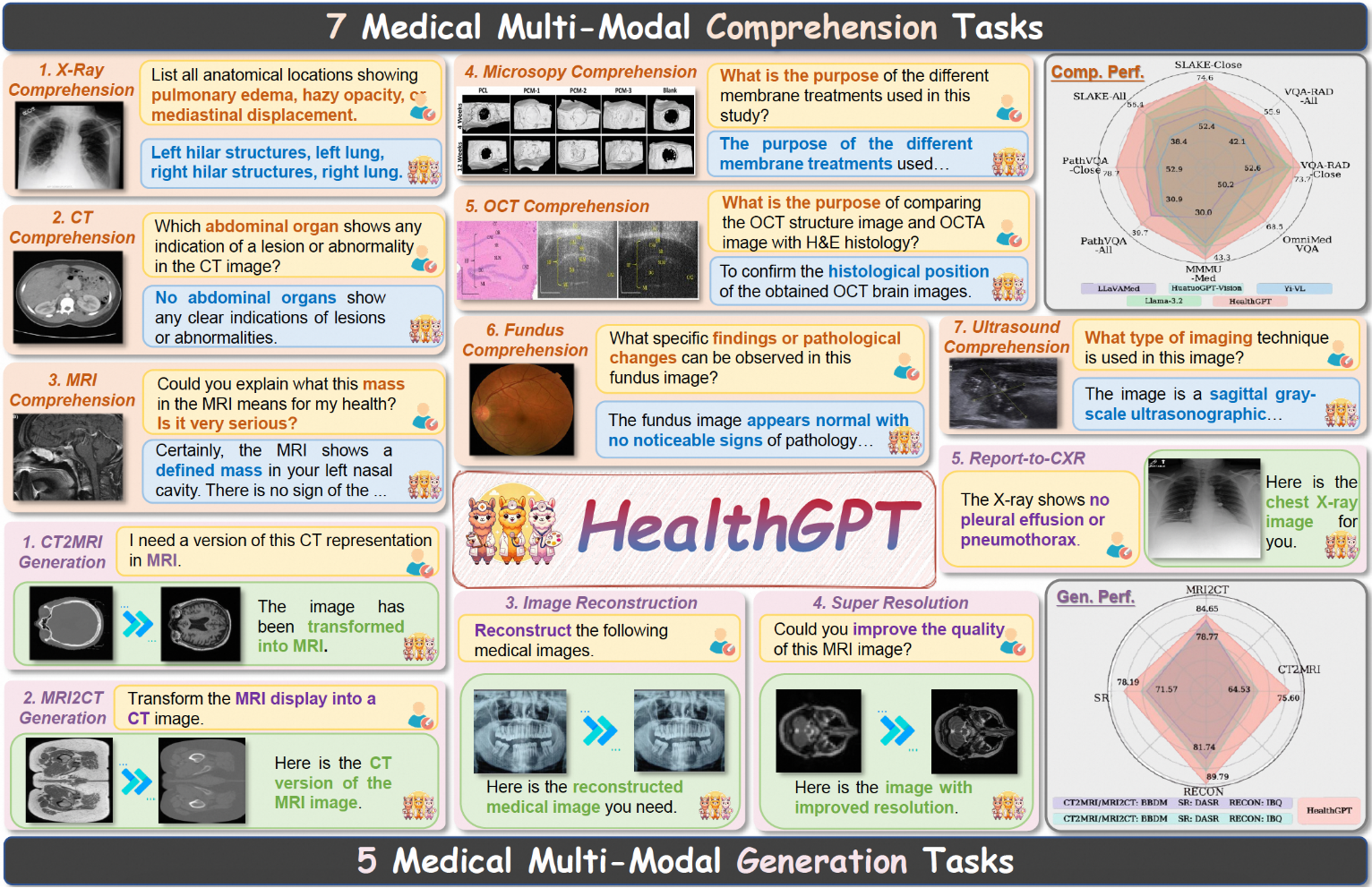

O HealthGPT é um modelo de linguagem visual médica de última geração que visa obter recursos unificados de geração e compreensão visual médica por meio da adaptação de conhecimento heterogêneo. O objetivo do projeto é integrar os recursos de compreensão e geração de imagens médicas em uma estrutura autorregressiva unificada, o que melhora significativamente a eficiência e a precisão do processamento de imagens médicas. O HealthGPT oferece suporte a uma ampla gama de tarefas de compreensão e geração de imagens médicas e é capaz de apresentar bom desempenho em vários cenários de processamento de imagens médicas. O projeto foi desenvolvido em conjunto pela Universidade de Zhejiang, pela Universidade de Ciência e Tecnologia Eletrônica, pelo Alibaba, pela Universidade de Ciência e Tecnologia de Hong Kong, pela Universidade Nacional de Cingapura e por muitas outras organizações, e tem grande valor prático e de pesquisa.

Lista de funções

- Perguntas e respostas visuais médicas: oferece suporte a uma ampla variedade de imagens médicas para tarefas de perguntas e respostas, respondendo com precisão às perguntas médicas feitas pelos usuários.

- Geração de imagens médicas: capaz de gerar imagens médicas de alta qualidade para auxiliar no diagnóstico e na pesquisa médica.

- Suporte à classificação de tarefas: suporta 7 tipos de tarefas de compreensão médica e 5 tipos de tarefas de geração médica, abrangendo uma ampla gama de cenários de aplicativos médicos.

- Arquitetura do modelo: o conteúdo textual e visual é gerado usando percepção visual hierárquica e plug-ins H-LoRA, selecionando recursos visuais e plug-ins H-LoRA.

- Modelo de várias versões: as configurações HealthGPT-M3 e HealthGPT-L14 são fornecidas para se adaptarem a diferentes necessidades e recursos, respectivamente.

Usando a Ajuda

Processo de instalação

- Preparação do ambiente

Primeiro, clone o projeto e crie um ambiente de tempo de execução do Python:git clone https://github.com/DCDmllm/HealthGPT.git cd HealthGPT conda create -n HealthGPT python=3.10 conda activate HealthGPT pip install -r requirements.txt

- Preparar os pesos pré-treinamento

SaúdeUso de GPTclip-vit-large-patch14-336Como codificadores visuais, o HealthGPT-M3 e o HealthGPT-L14 se baseiam, respectivamente, emPhi-3-mini-4k-instructresponder cantandophi-4Pré-treinamento.

Faça o download dos pesos de modelo necessários e coloque-os no diretório apropriado:- Modelagem ViT:link para download

- Modelo básico do HealthGPT-M3:link para download

- Modelo básico HealthGPT-L14:link para download

- Modelo VQGAN:link para download

- Preparação de H-LoRA e pesos adaptadores

Faça o download e coloque os pesos do H-LoRA para aprimorar os recursos de geração e compreensão visual médica do modelo. Os pesos completos serão lançados em breve, portanto, fique atento.

inferência

Perguntas e respostas sobre visão médica

- Faça o download dos documentos necessários

- Atualizar o caminho do script

show (um ingresso)llava/demo/com_infer.shaltere a seguinte variável para o caminho do arquivo baixado:- MODEL_NAME_OR_PATH: Caminho ou identificador do modelo básico

- VIT_PATH: Caminho de peso do modelo do transformador visual

- HLORA_PATH: compreensão visual dos caminhos de peso H-LoRA

- FUSION_LAYER_PATH: Caminho de peso da camada de fusão

- Executando scripts

cd llava/demo bash com_infer.shTambém é possível executar comandos Python diretamente:

python3 com_infer.py \ --model_name_or_path "microsoft/Phi-3-mini-4k-instruct" \ --dtype "FP16" \ --hlora_r "64" \ --hlora_alpha "128" \ --hlora_nums "4" \ --vq_idx_nums "8192" \ --instruct_template "phi3_instruct" \ --vit_path "openai/clip-vit-large-patch14-336/" \ --hlora_path "path/to/your/local/com_hlora_weights.bin" \ --fusion_layer_path "path/to/your/local/fusion_layer_weights.bin" \ --question "Your question" \ --img_path "path/to/image.jpg"

Reconstrução de imagens

comandante-em-chefe (militar)HLORA_PATHdefinido comogen_hlora_weights.bine configurar outros caminhos de modelo:

cd llava/demo

bash gen_infer.sh

Você também pode executar o seguinte comando Python diretamente:

python3 gen_infer.py \

--model_name_or_path "microsoft/Phi-3-mini-4k-instruct" \

--dtype "FP16" \

--hlora_r "256" \

--hlora_alpha "512" \

--hlora_nums "4" \

--vq_idx_nums "8192" \

--instruct_template "phi3_instruct" \

--vit_path "openai/clip-vit-large-patch14-336/" \

--hlora_path "path/to/your/local/gen_hlora_weights.bin" \

--fusion_layer_path "path/to/your/local/fusion_layer_weights.bin" \

--question "Reconstruct the image." \

--img_path "path/to/image.jpg" \

--save_path "path/to/save.jpg"© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...