Harbor: um conjunto de ferramentas em contêineres para implantar ambientes locais de desenvolvimento do LLM com um clique e gerenciar e executar facilmente os serviços de IA

Introdução geral

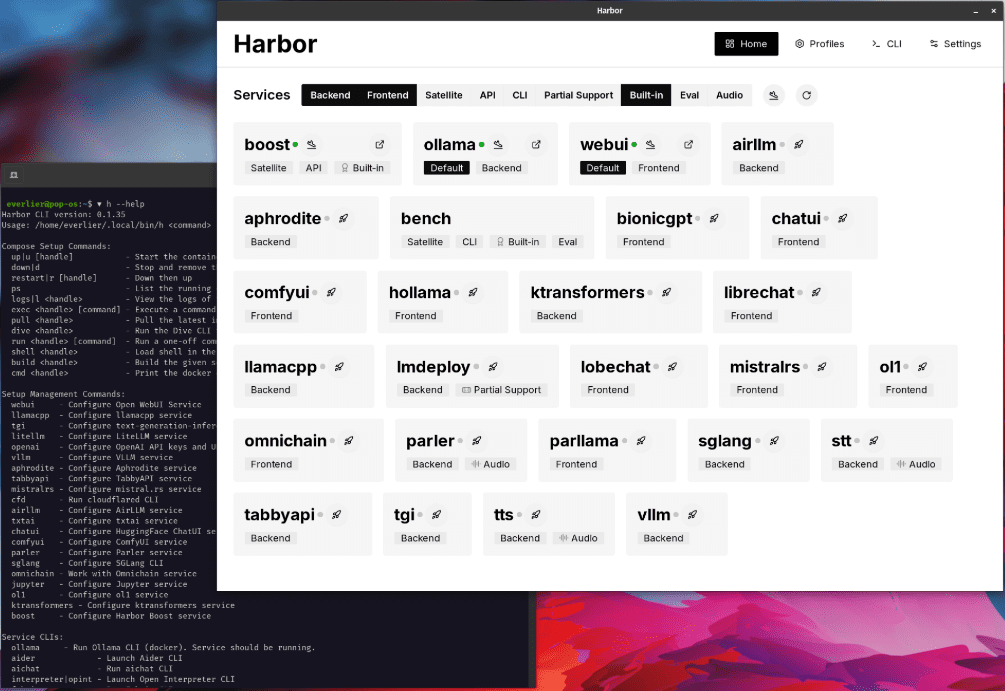

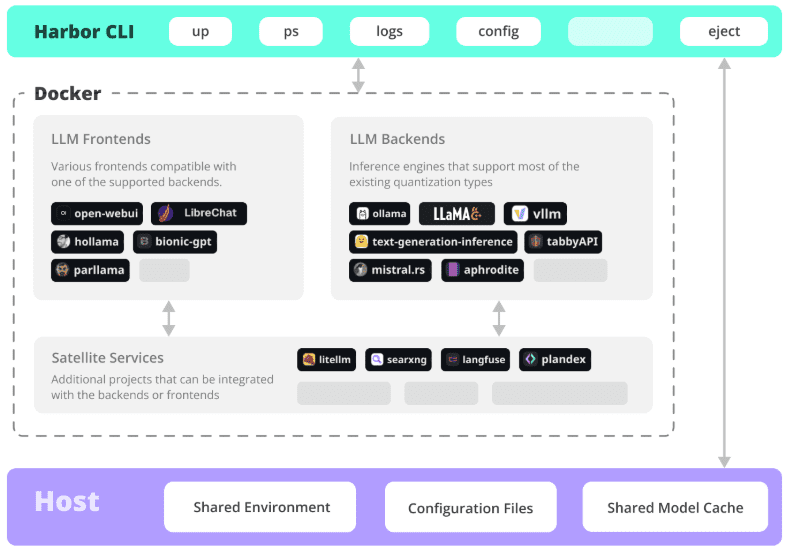

O Harbor é um revolucionário conjunto de ferramentas LLM em contêineres voltado para a simplificação da implantação e do gerenciamento de ambientes locais de desenvolvimento de IA. Ele permite que os desenvolvedores iniciem e gerenciem todos os componentes do serviço de IA, incluindo back-end do LLM, interface de API, interface de front-end etc., com um único clique por meio de uma interface de linha de comando (CLI) concisa e aplicativos de suporte. Como um projeto de código aberto, o Harbor é particularmente adequado para desenvolvedores que precisam criar e experimentar rapidamente aplicativos LLM. Ele não só é compatível com os principais modelos e serviços de IA, mas também oferece opções de configuração flexíveis e uma cadeia de ferramentas completa, permitindo que os desenvolvedores se concentrem no desenvolvimento de aplicativos em vez de na configuração do ambiente. O Harbor adota o protocolo de código aberto Apache 2.0, tem suporte ativo da comunidade e recebeu mais de 770 rótulos com estrelas no GitHub, além de ter sido reconhecido e usado por muitos desenvolvedores.

Lista de funções

- Implementação com um clique: inicie um ambiente de serviço LLM completo com um único comando

- Gerenciamento de contêineres: integração do Docker e do Docker Compose para orquestração de serviços

- Suporte a vários back-end: compatível com vários mecanismos LLM e formatos de modelo (GGUF, SafeTensors, etc.).

- Integração de serviços: serviços de API pré-configurados e interfaces de front-end trabalhando juntos

- Ferramentas de desenvolvimento: fornece uma cadeia completa de ferramentas de desenvolvimento local

- Flexibilidade de configuração: suporte para componentes de serviço personalizados e opções de configuração

- Certificados SSL: suporte integrado ao Certbot para facilitar a configuração do acesso HTTPS

- Migração de ambiente: suporte à exportação de configuração, fácil de migrar para o ambiente de produção

- Gerenciamento de monitoramento: fornece monitoramento do status do serviço e função de visualização de registros.

- Controle de versão: suporte ao gerenciamento de diferentes versões dos componentes do serviço de IA

Usando a Ajuda

1. preparação ambiental

1.1 Requisitos do sistema

- Sistema operacional: compatível com Linux, MacOS ou Windows WSL2

- Mecanismo Docker 20.10+

- Docker Compose 1.18.0+

- Node.js 16+ (opcional, para o método de instalação npm)

1.2 Instalação do Harbor

# 方式1:使用npm安装

npm install -g @avlab/harbor

# 方式2:使用curl安装

curl -sfL https://get.harbor.ai | sh

2. uso básico

2.1 Início dos serviços

# 初始化Harbor环境

harbor init

# 启动所有服务

harbor up

# 查看服务状态

harbor ps

2.2 Configuração do serviço

# 配置模型路径

harbor config set models.path /path/to/models

# 启用特定服务

harbor enable chatui

harbor enable api

# 禁用服务

harbor disable service-name

3. funções avançadas

3.1 Configuração do certificado SSL

# 设置环境变量

export NGINX_SSL_CERT_FILENAME=fullchain.pem

export NGINX_SSL_CERT_KEY_FILENAME=privkey.pem

export CERTBOT_DOMAIN=your_domain.com

export CERTBOT_EMAIL=your@email.com

# 获取证书

harbor ssl setup

3.2 Configuração personalizada

# 导出配置

harbor eject

# 修改配置文件

vim harbor.yaml

# 使用自定义配置启动

harbor up -c custom-config.yaml

4. procedimentos operacionais comuns

4.1 Implantação de novos serviços

- Verifique a lista de serviços:

harbor list - Habilite os serviços necessários:

harbor enable <service-name> - Configure os parâmetros do serviço:

harbor config set <param> <value> - Inicie o serviço:

harbor up - Verifique o status do serviço:

harbor ps

4.2 Identificação do problema

# 查看服务日志

harbor logs <service-name>

# 检查服务状态

harbor status

# 重启服务

harbor restart <service-name>

5. melhores práticas

- Backup regular dos arquivos de configuração

- Gerenciamento de configurações personalizadas com controle de versão

- Monitorar o uso de recursos do serviço

- Mantenha o Harbor e os componentes relacionados atualizados

- Acelere o processo de implementação com predefinições de projeto

Serviços de IA instaláveis

usuário

Abrir a WebUI ⦁︎ ComfyUI ⦁︎ LibreChat ⦁︎ ChatUI do HuggingFace ⦁︎ Bate-papo do lobo ⦁︎ Hollama ⦁︎ parllama ⦁︎ BionicGPT ⦁︎ Qualquer coisaLLM ⦁︎ Chat Nio

serviço de back-end

Ollama ⦁︎ llama.cpp ⦁︎ vLLM ⦁︎ TabbyAPI ⦁︎ Motor Aphrodite ⦁︎ mistral.rs ⦁︎ discurso aberto ⦁︎ servidor de sussurro mais rápido ⦁︎ Parler ⦁︎ inferência de geração de texto ⦁︎ LMDeploy ⦁︎ AirLLM ⦁︎ SGLang ⦁︎ KTransformadores ⦁︎ Nexa SDK

Ferramentas de extensão

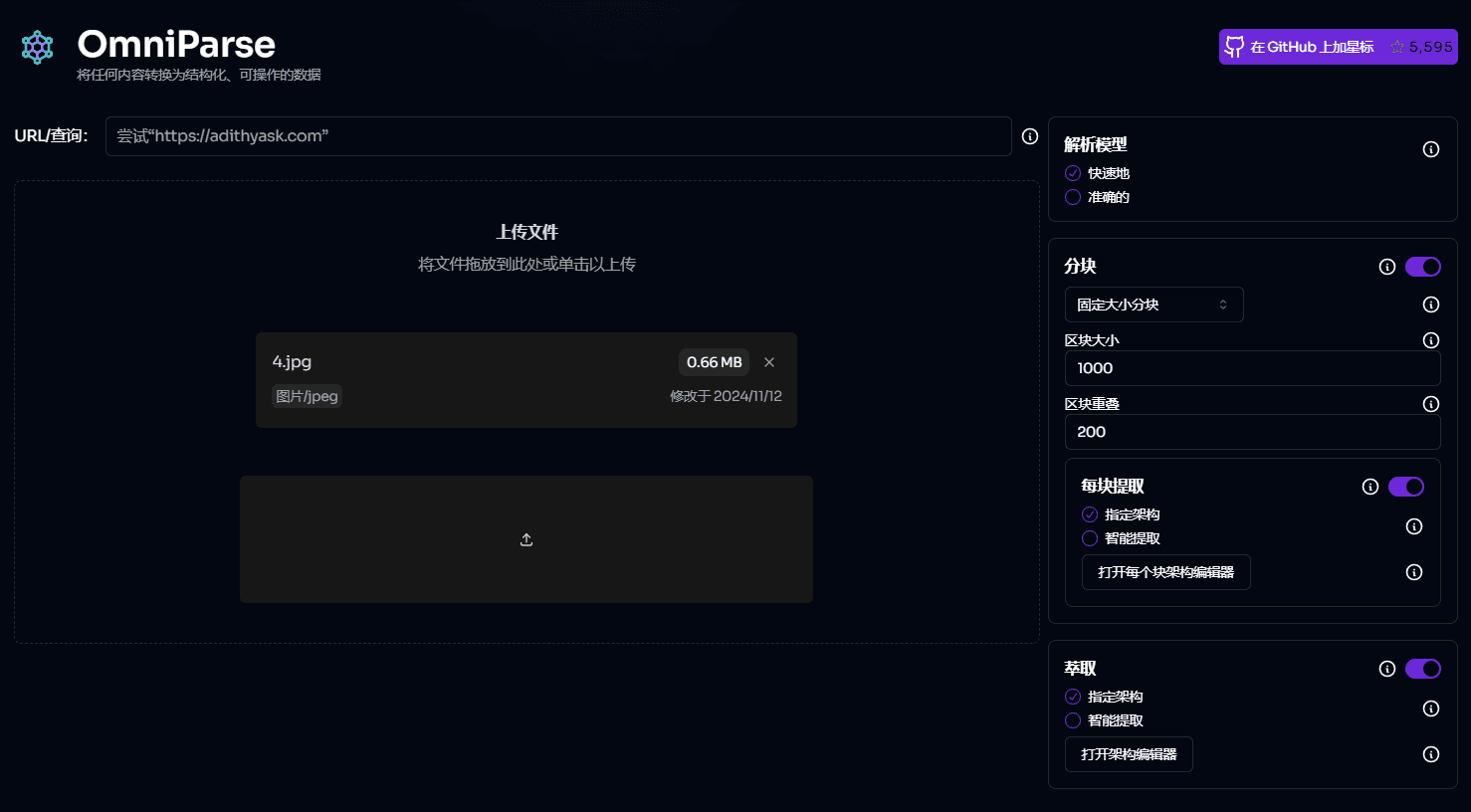

Banco do porto ⦁︎ Impulso do porto ⦁︎ SearXNG ⦁︎ Perplexica ⦁︎ Dify ⦁︎ Plandex ⦁︎ LiteLLM ⦁︎ LangFuse ⦁︎ Intérprete aberto ⦁ ︎com nuvem ⦁︎ cmdh ⦁︎ tecido ⦁︎ txtai RAG ⦁︎ TextGrad ⦁︎ Ajudante ⦁︎ aichat ⦁︎ omnichain ⦁︎ lm-evaluation-harness ⦁︎ JupyterLab ⦁︎ ol1 ⦁︎ OpenHands ⦁︎ LitLytics ⦁︎ Repopack ⦁︎ n8n ⦁︎ Parafuso.novo ⦁︎ Abrir pipelines da WebUI ⦁︎ Qdrant ⦁︎ K6 ⦁︎ Promptfoo ⦁︎ Webtop ⦁︎ OmniParser ⦁︎ Fluxo ⦁︎ Langflow ⦁︎ OptiLLM

Veja também Documentação do serviço Obtenha uma breve visão geral de cada serviço.

Etapas detalhadas para instalar o Open WebUI com o Harbor

1. pré-preparação

- Certifique-se de que o Docker e o Docker Compose estejam instalados

- Certifique-se de que a CLI do Harbor esteja instalada corretamente

- Certifique-se de que o sistema atenda aos requisitos básicos (recomenda-se 8 GB ou mais de RAM)

2. inicialização do ambiente Harbor

# 初始化Harbor环境

harbor init

# 验证Harbor环境

harbor doctor

3. instalação e configuração da Open WebUI

3.1 Ativação dos serviços da WebUI

# 启用Open WebUI服务

harbor enable webui

3.2 Configuração dos parâmetros básicos (opcional)

# 配置WebUI版本(如果需要指定特定版本)

harbor webui version <version>

# 配置WebUI端口(默认为8080)

harbor config set webui.port <port_number>

4. ativação de serviços

# 启动所有已启用的服务,包括WebUI

harbor up

# 或者仅启动WebUI服务

harbor up webui

5. verificação da instalação

- Acesse http://localhost:8080 (ou qualquer outra porta que você tenha configurado)

- Verifique o status do serviço:

harbor ps

6. comandos de gerenciamento comuns

Verificar o status do serviço

# 查看所有运行中的服务

harbor ps

# 查看WebUI日志

harbor logs webui

gerenciamento de serviços

# 停止WebUI服务

harbor stop webui

# 重启WebUI服务

harbor restart webui

# 更新WebUI版本

harbor webui version latest

harbor restart webui

7. integração de Ollama (opcional)

Se você quiser se conectar ao Ollama usando a WebUI:

# 启用Ollama服务

harbor enable ollama

# 重启服务

harbor restart

8. solução de problemas comuns

Verificação do status de integridade do serviço

harbor doctor

Exibir mensagens de erro específicas

harbor logs webui

Resolução de conflitos portuários

Se a porta 8080 estiver ocupada:

# 修改WebUI端口

harbor config set webui.port 8081

harbor restart webui

9. local do arquivo de configuração

- Arquivo de configuração principal:

~/.harbor/.env - Configuração da WebUI:

~/.harbor/open-webui/

10. recomendações de backup

# 导出当前配置

harbor eject > harbor-backup.yaml

Advertências:

- Certifique-se de que o sistema tenha recursos suficientes para executar o serviço

- A primeira inicialização pode levar algum tempo para fazer o download da imagem

- Se você encontrar problemas de permissão, verifique as configurações de permissão do Docker

- Recomenda-se o backup regular dos arquivos de configuração

- Manter o Harbor e os serviços relacionados atualizados para a versão mais recente

开始使用:

1. 完成安装后,打开浏览器访问 http://localhost:8080

2. 首次访问时会要求进行基本设置

3. 可以开始使用Open WebUI进行AI对话了

需要帮助时可以使用:

```bash

harbor help webui© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...