Hallo2: geração orientada por áudio de vídeos de retratos sincronizados com os lábios e com a expressão (instalação com um clique para Windows)

Introdução geral

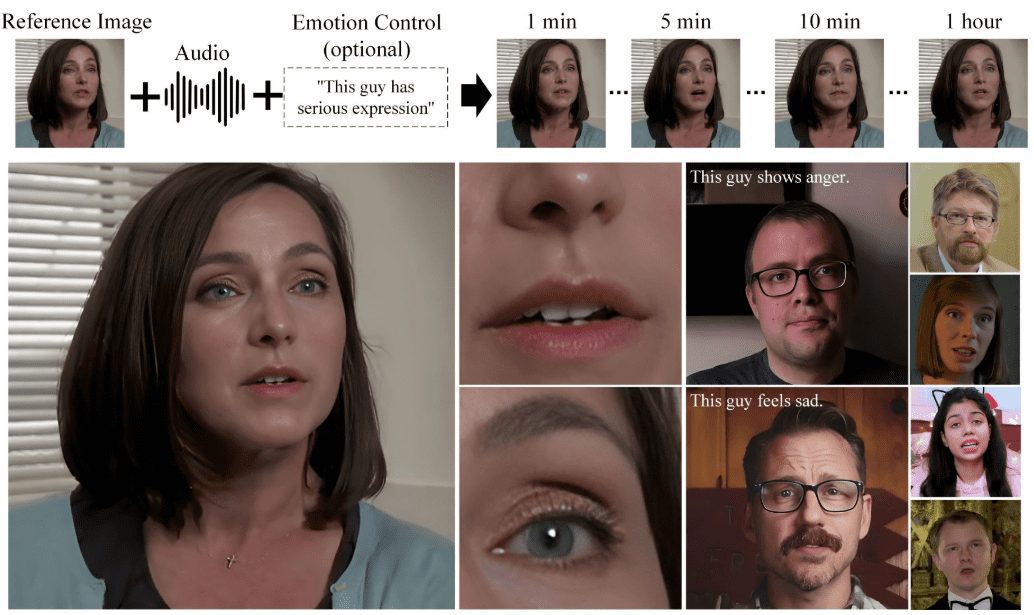

O Hallo2 é um projeto de código aberto desenvolvido em conjunto pela Universidade de Fudan e pelo Baidu para gerar animações de retratos de alta resolução por meio de geração orientada por áudio. O projeto utiliza técnicas avançadas de alinhamento temporal e Generative Adversarial Networks (GAN) para obter uma resolução de 4K e até 1 hora de geração de vídeo. O Hallo2 também oferece suporte a avisos de texto para aumentar a diversidade e a capacidade de controle do conteúdo gerado.

O Hallo3 foi lançado, permitindo o condicionamento de áudio por meio da introdução de um mecanismo de atenção cruzada que capta com eficácia a complexa relação entre os sinais de áudio e as expressões faciais, alcançando uma sincronização labial notável.

Observe que o Hallo3 tem os seguintes requisitos simples para os dados de entrada para inferência:

Imagem de referência: a imagem de referência deve ter uma relação de aspecto de 1:1 ou 3:2. Áudio do driver: o áudio do driver deve estar no formato WAV. Idioma do áudio: o áudio deve estar em inglês, pois o conjunto de dados de treinamento do modelo contém apenas esse idioma. Clareza do áudio: certifique-se de que os vocais estejam claros no áudio; música de fundo é aceitável.

Lista de funções

- Geração de animação orientada por áudioGerar a animação de retrato correspondente com a entrada de um arquivo de áudio.

- Suporte a alta resoluçãoSuporte para geração de vídeos com resolução 4K para garantir uma qualidade de imagem nítida.

- Geração de vídeos longosPode gerar conteúdo de vídeo de até 1 hora de duração.

- Aprimoramento do alerta de textoControle de expressões e ações de retratos gerados por meio de rótulos de texto semânticos.

- código abertoCódigo-fonte completo e modelos pré-treinados são fornecidos para facilitar o desenvolvimento secundário.

- Suporte a várias plataformasSuporte à execução em várias plataformas, como Windows, Linux, etc.

Usando a Ajuda

Processo de instalação

- Requisitos do sistema::

- Sistema operacional: Ubuntu 20.04/22.04

- GPU: placa de vídeo compatível com CUDA 11.8 (por exemplo, A100)

- Criação de um ambiente virtual::

conda create -n hallo python=3.10 conda activate hallo - Instalação de dependências::

pip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt sudo apt-get install ffmpeg - Download do modelo pré-treinado::

git lfs install git clone https://huggingface.co/fudan-generative-ai/hallo2 pretrained_models

Processo de uso

- Preparação para inserir dados::

- Faça o download e prepare o modelo pré-treinado necessário.

- Prepare a imagem de origem e os arquivos de áudio do driver.

- Execução de scripts de inferência::

python scripts/inference.py --source_image path/to/image --driving_audio path/to/audio - Exibir resultados gerados::

- O arquivo de vídeo gerado será salvo no diretório de saída especificado e poderá ser visualizado em qualquer reprodutor de vídeo.

Etapas detalhadas

- Código de download::

git clone https://github.com/fudan-generative-vision/hallo2 cd hallo2 - Criar e ativar um ambiente virtual::

conda create -n hallo python=3.10 conda activate hallo - Instale os pacotes Python necessários::

pip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url https://download.pytorch.org/whl/cu118 pip install -r requirements.txt - Instalar o ffmpeg::

sudo apt-get install ffmpeg - Download do modelo pré-treinado::

git lfs install git clone https://huggingface.co/fudan-generative-ai/hallo2 pretrained_models - Execução de scripts de inferência::

python scripts/inference.py --source_image path/to/image --driving_audio path/to/audio - Exibir resultados gerados::

- O arquivo de vídeo gerado será salvo no diretório de saída especificado e poderá ser visualizado em qualquer reprodutor de vídeo.

Hallo2: instalador do Windows com um clique

https://pan.quark.cn/s/aa9fc15a786f

Código do extrato: 51XY

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...