Como o GRPO supera o desempenho do o1, o3-mini e R1 no jogo "Clue of Time".

Nos últimos anos, o campo da Inteligência Artificial fez um progresso significativo em seus recursos de raciocínio. Depois que a OpenAI demonstrou o poderoso potencial de inferência de grandes modelos de linguagem (LLMs) no ano passado, a Google DeepMind, a Alibaba, a DeepSeek e a Antrópica Organizações como a Universidade da Califórnia em Berkeley foram rápidas em seguir o exemplo, usando técnicas de aprendizagem por reforço (RL) para treinar modelos avançados com recursos de "cadeia de pensamento" (CoT). Esses modelos alcançaram pontuações próximas à saturação em muitos testes de referência em áreas como matemática e programação.

No entanto, é um fato que não pode ser ignorado: mesmo os melhores modelos disponíveis atualmente ainda enfrentam alguns obstáculos intransponíveis ao lidar com problemas de raciocínio lógico. Os modelos de linguagem de grande porte geralmente têm dificuldade para manter uma cadeia coerente de raciocínio lógico com atenção constante a todos os detalhes relevantes ou para conectar de forma confiável várias etapas de raciocínio. Mesmo os modelos de última geração que geram conteúdo 10 a 100 vezes maior que os modelos comuns costumam cometer erros de baixo nível que são facilmente detectados por solucionadores de problemas humanos.

Para explorar essa questão, Brad Hilton e Kyle Corbitt, autores deste artigo, começaram a pensar: as técnicas mais recentes de aprendizado por reforço podem ser aproveitadas para levar modelos menores e de código aberto à vanguarda do desempenho de inferência? Para responder a essa pergunta, eles escolheram uma técnica chamada Otimização de política relativa de grupo (GRPO) de algoritmos de aprendizado por reforço.

O que é GRPO?

Em poucas palavras, o GRPO é um método para otimizar gradientes de estratégia. Os métodos de gradiente de política melhoram o desempenho do modelo ajustando a política do modelo (ou seja, a distribuição de probabilidade das ações do modelo em uma determinada situação). A GRPO atualiza a política com mais eficiência comparando os méritos relativos de um conjunto de respostas do modelo. Em comparação com os métodos tradicionais, como a otimização da política proximal (PPO), a GRPO simplifica o processo de treinamento e, ao mesmo tempo, garante um excelente desempenho.

Para verificar a validade do GRPO, eles escolheram um programa chamado "Pista Temporal"Reasoning Games as Experimental Platforms" (Jogos de raciocínio como plataformas experimentais).

O que é o Time Clue?

"Time Clue" é um jogo de quebra-cabeça inspirado no clássico jogo de tabuleiro "Clue (Cluedo)". Nesse jogo, o jogador precisa descobrir o assassino, a arma do crime, o local, a hora e o motivo por meio de uma série de pistas. Diferentemente do jogo original, o Clue (Cluedo) expande o problema para cinco dimensões, aumentando a complexidade e o desafio do jogo.

Os autores começaram com modelos relativamente fracos e os treinaram iterativamente no jogo "Time Clue" usando o algoritmo GRPO. Com o passar do tempo, eles observaram uma melhora significativa na capacidade de raciocínio desses modelos, que acabaram se equiparando ou até mesmo superando alguns dos modelos proprietários mais avançados.

Agora, eles compartilharão as informações que incluemtesteeProgramas de treinamentoeconjunto de dados responder cantandopeso do modelo todos disponíveis gratuitamente sob a licença MIT.

avaliação comparativa

Para realizar um experimento, primeiro é necessário identificar uma tarefa de raciocínio desafiadora que tenha uma solução claramente verificável e uma complexidade escalonável. Coincidentemente, um dos autores, Brad Hilton, havia criado anteriormente um projeto chamado Pista Temporal do conjunto de quebra-cabeças que atende perfeitamente a essas necessidades. Além de atender aos critérios de clareza factual básica, novos quebra-cabeças podem ser criados conforme necessário.

O Temporal Clue é inspirado no popular jogo de tabuleiro Clue (Cluedo)Pista Temporal Neste jogo, os jogadores correm para descobrir quem matou o Sr. Boddy na Mansão Tudor. O Temporal Clue transforma esse jogo em um quebra-cabeça lógico independente que vai além do padrãoqueeCom o quê?eondee acrescentamos duas dimensões adicionais:Quando?(tempo) ePor qual motivo?(Motivação). Os quebra-cabeças são gerados aleatoriamente, e pistas mínimas, mas suficientes, são usadas para Ferramentas OR (usado em uma expressão nominal) Solucionador CP-SAT Eleito.

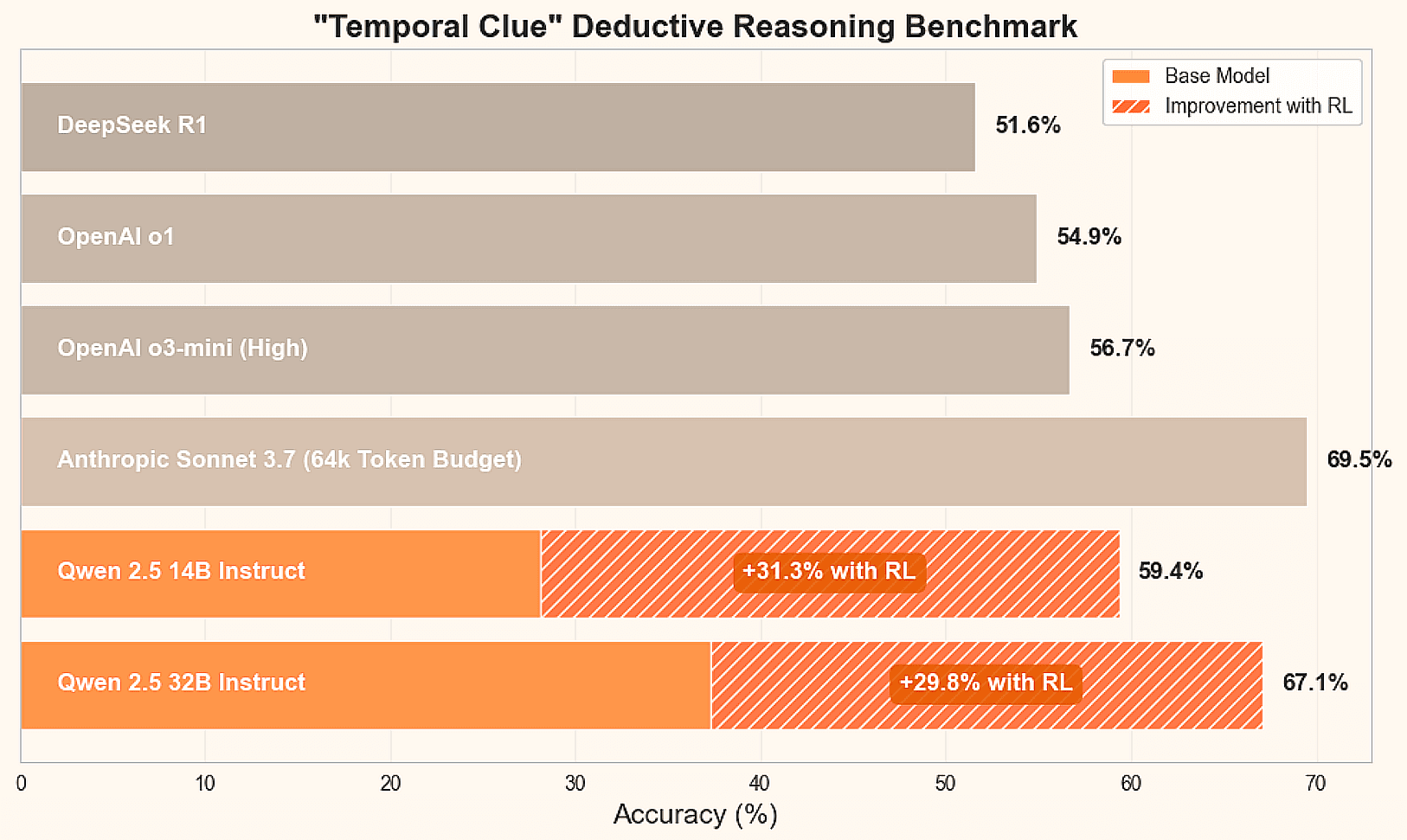

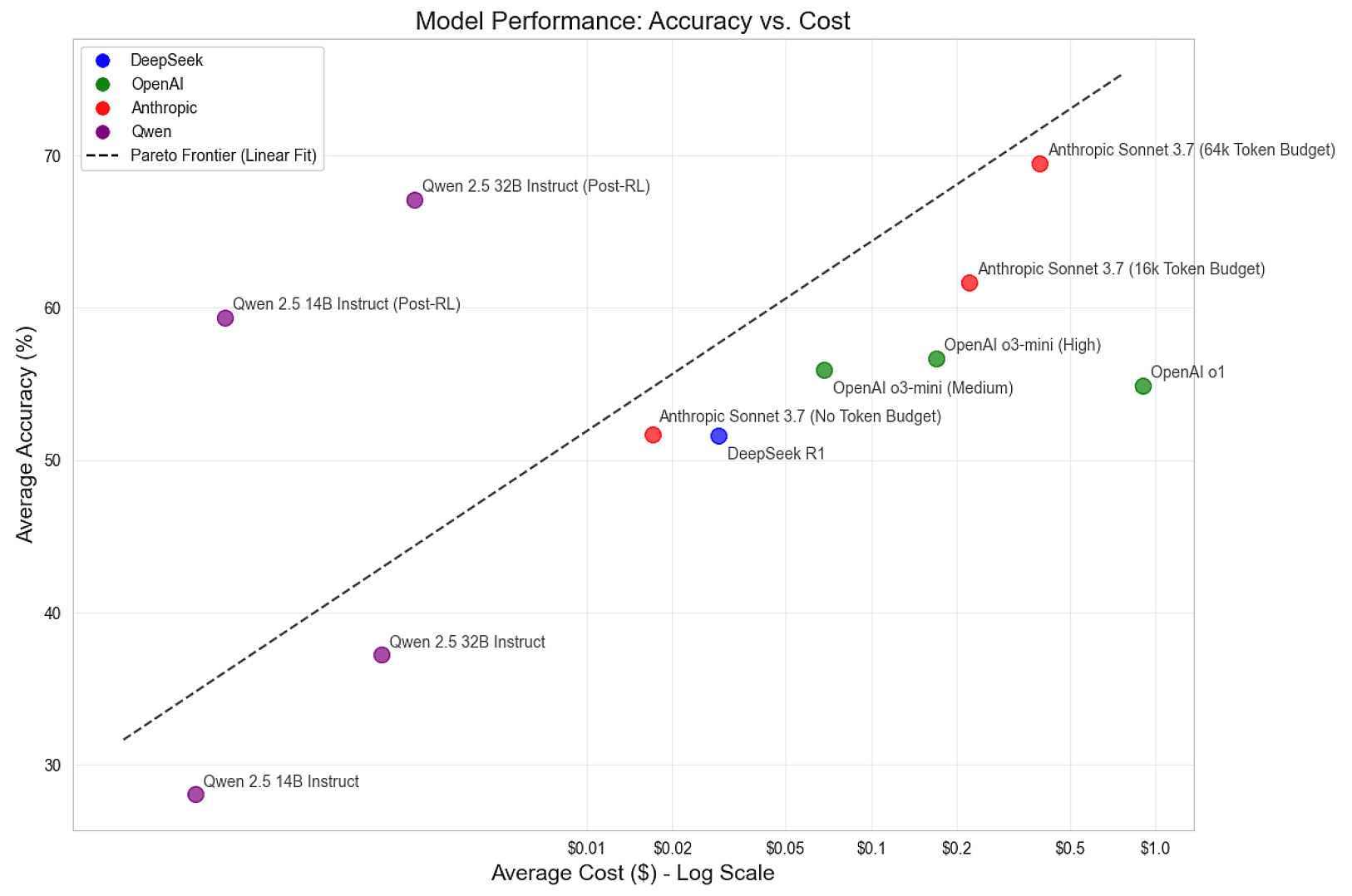

Para determinar o estado atual da arte dessa tarefa de inferência, eles compararam os principais modelos de inferência, incluindo DeepSeek R1, Antrópico Claude Sonnet 3.7, e os modelos Qwen 2.5 14B e 32B Instruct da Alibaba. Além disso, eles fornecem uma prévia dos resultados finais:

| mecanismo | modelagem | capacidade de raciocínio | Precisão média | custo médio |

|---|---|---|---|---|

| DeepSeek | R1 | padrão (configuração) | 51.6% | $0.029 |

| Antrópica | Soneto 3.7 | não ter | 51.7% | $0.017 |

| Antrópica | Soneto 3.7 | 16k | 61.7% | $0.222 |

| Antrópica | Soneto 3.7 | 64k | 69.5% | $0.392 |

| Ali Baba, personagem de As Noites da Arábia | Qwen 2.5 14B Instruct | não ter | 28.1% | $0.001 |

| Ali Baba, personagem de As Noites da Arábia | Qwen 2.5 32B Instrução | não ter | 37.3% | $0.002 |

Com base nesses benchmarks, é possível observar que ter 64k token O Claude Sonnet 3.7 da Anthropic foi o que teve o melhor desempenho nessa tarefa, mas todos os principais modelos podem ser melhorados. O DeepSeek R1, um modelo popular de código aberto, teve um desempenho próximo à precisão média do Claude Sonnet 3.7 da Anthropic, 51,7%. No entanto, o desempenho do modelo Qwen 2.5 Instruct não ajustado é relativamente ruim. A grande questão é: esses modelos menores e de código aberto podem ser treinados em níveis de ponta?

trem

Para treinar um modelo de inferência de ponta, eles usaram o aprendizado por reforço - um método que permite que as inteligências aprendam com sua própria experiência em um ambiente controlado. Aqui, os LLMs são as inteligências e os quebra-cabeças são o ambiente. Eles orientaram o aprendizado dos LLMs fazendo com que eles gerassem várias respostas para cada quebra-cabeça a fim de explorar o cenário do problema. Eles reforçam o raciocínio que leva à solução correta e penalizam o raciocínio que leva o modelo a se desviar.

Entre os vários métodos de RL, eles escolheram o popular algoritmo Group Relative Policy Optimization (GRPO) desenvolvido pela DeepSeek. Em comparação com os métodos mais tradicionais, como o PPO (Proximal Policy Optimization, otimização de política proximal), o GRPO simplifica o processo de treinamento e, ao mesmo tempo, oferece um desempenho sólido. Para acelerar seus experimentos, eles omitiram o Dispersão de Kullback-Leibler (KL) punição, apesar de seu programa de treinamento apoiar isso.

Em resumo, o ciclo de treinamento segue estas etapas básicas:

- Geração de respostas de modelo para tarefas de quebra-cabeça.

- Pontue as respostas e estime a vantagem de concluir o bate-papo para cada grupo (essa é a parte "Group Relative" do GRPO).

- O modelo é ajustado usando um gradiente de estratégias de adaptação orientadas por essas estimativas de dominância.

- Repita essas etapas com novos quebra-cabeças e a versão mais recente do modelo até obter o desempenho ideal.

Para gerar a resposta, eles usam o popular vLLM Mecanismo de inferência. Eles ajustaram a seleção de parâmetros para maximizar a taxa de transferência e minimizar o tempo de inicialização. O armazenamento em cache de prefixos é particularmente importante porque eles coletam amostras de muitas respostas para cada tarefa, e as dicas de armazenamento em cache ajudam a evitar cálculos redundantes.

Eles observaram que o excesso de solicitações pode fazer com que o vLLM sobrecarregados, o que leva à preempção ou à troca de solicitações em andamento. Para resolver esse problema, eles limitam as solicitações usando um semáforo que é ajustado para manter a alta utilização do cache de valor-chave (KV) e, ao mesmo tempo, minimizar a troca. Mecanismos de agendamento mais avançados podem produzir maior utilização e, ao mesmo tempo, suportar comprimentos de geração flexíveis.

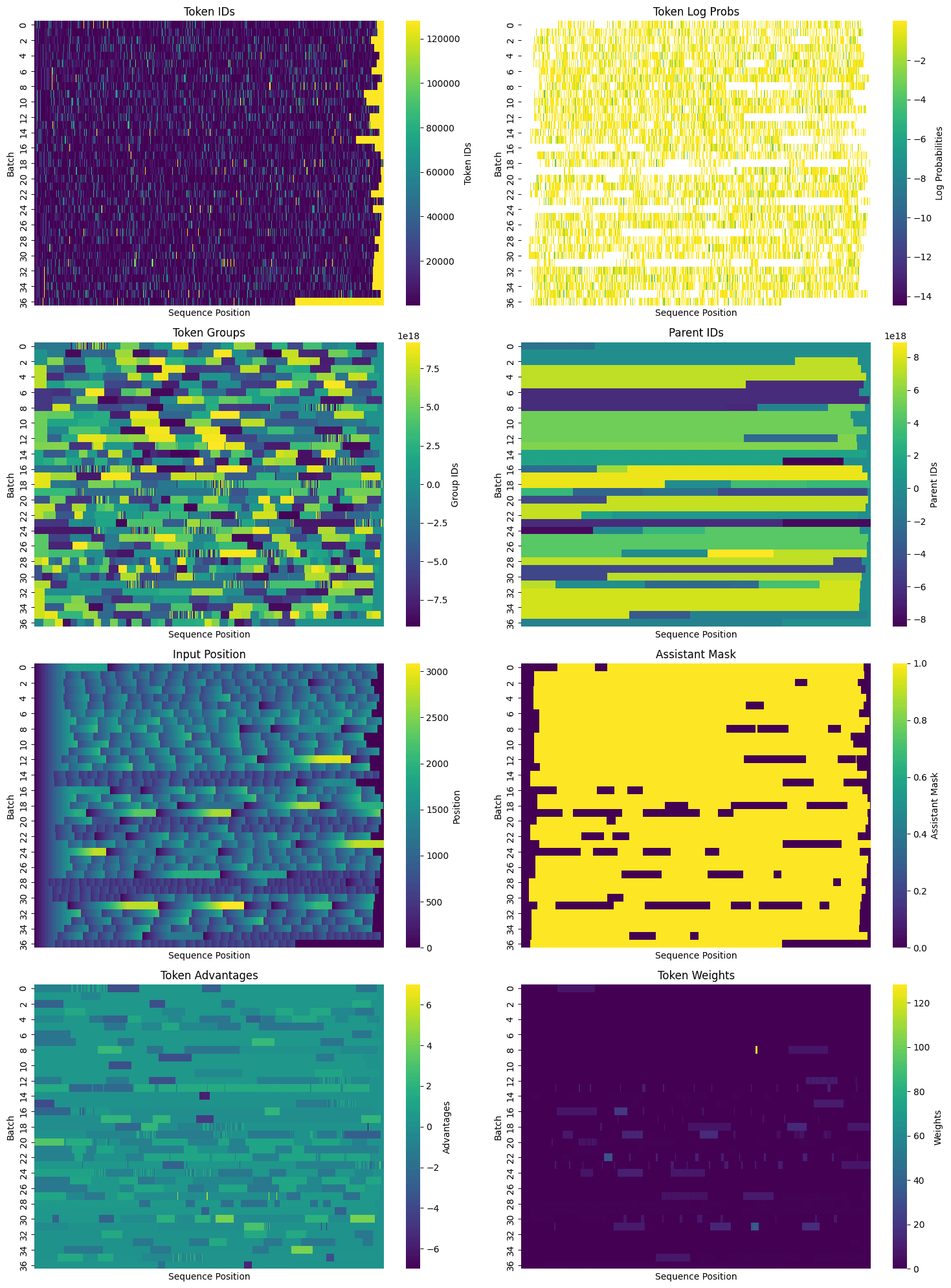

Após a amostragem, um Transformadores HuggingFace AutoTokenizer O processamento está concluído. Seu recurso de modelo de bate-papo apresenta o objeto de mensagem como uma string de prompt que inclui uma máscara auxiliar para determinar quais tokens foram gerados pelo LLM. %generation% Portanto, elas são modificadas na etapa de rotulagem. As máscaras auxiliares geradas são incluídas no dicionário de tensores usado para ajuste e são usadas para identificar quais posições são necessárias para calcular as perdas.

Depois de classificar as respostas e obter máscaras de auxiliares, eles empacotaram os dados para ajuste. Além de incluir vários pares de dica/resposta em cada sequência empacotada, eles identificaram tokens de dica compartilhados e atribuíram um ID pai e um ID de grupo padrão a cada token. Especialmente em tarefas como o Temporal Clue (com média de mais de 1.000 tokens por quebra-cabeça), a geração de um grande número de respostas para cada tarefa e o empacotamento eficiente do tensor pode reduzir significativamente a redundância. Uma vez que todas as informações necessárias tenham sido empacotadas, o conjunto de dados de treinamento pode ser visualizado em duas dimensões, com cada linha sendo uma sequência de tokens que pode conter várias dicas e conclusões:

Com dados bem compactados, é hora de fazer o ajuste. Os modelos foram pré-treinados, ajustados por instruções, são bastante inteligentes e são bons em seguir instruções. No entanto, eles ainda não conseguem resolver de forma confiável o quebra-cabeça Temporal Clue. No entanto, ocasionalmente, eles conseguem, e isso é suficiente. Gradualmente, o modelo é guiado para um estado de "detetive", aumentando a probabilidade de bom raciocínio e diminuindo a probabilidade de raciocínio ruim. Isso é feito por meio de técnicas padrão de aprendizado de máquina, usando uma abordagem de gradiente de política para calcular as perdas e mudar os pesos de forma favorável.

Para o treinamento, a equipe do PyTorch forneceu o torchtune A Torchtune tem um decodificador altamente eficiente transformador implementações para modelos populares, incluindo Llama, Gemma, Phi e outros. Embora tenham usado principalmente o modelo Qwen nesse projeto, eles também fizeram experimentos com os modelos Llama 8B e 70B da Meta.O Torchtune também oferece utilitários de economia de memória e melhoria de desempenho, incluindo:

- Ativar pontos de controle

- Ativação Desinstalação

- quantificável

- Parameter Efficient Fine Tuning (PEFT) (ajuste fino eficiente de parâmetros)Por exemplo Adaptativo de baixo nível (LoRA)

Para obter uma lista completa das otimizações compatíveis, consulte a seçãoDocumento autoexplicativo aqui.

Além disso, o Torchtune oferece suporte a vários dispositivos (e agoramultinódo), o que o torna ideal para modelos grandes. Ele é compatível com o treinamento FSDP (Fully Sliced Data Parallel) e TP (Tensor Parallel), que podem ser usados em conjunto. Eles também oferecemUma dúzia de programasincentivando os usuários a replicá-lo e personalizá-lo para seus próprios casos de uso. Eles criaram uma versão modificada do programa completo de ajuste fino que oferece suporte:

- Treinamento com vários equipamentos e com um único equipamento

- Carregamento do modelo de referência e troca de peso para calcular a dispersão KL

- Cálculo avançado de máscara causal usando IDs de grupo e IDs pai

- Integração de perdas e registro de componentes do GRPO

O programa está disponível emAqui estãoVeja. No futuro, eles esperam adicionar suporte ao paralelismo de tensor e explorar o PEFT e a quantificação.

O processo de treinamento de RL envolve a seleção de um grande número de hiperparâmetros. Durante o treinamento do modelo, eles testaram várias configurações e identificaram principalmente as seguintes configurações:

- Modelos: Qwen 2.5 Instruct 14B e 32B

- Número de tarefas por iteração: 32

- Número de amostras por tarefa e por iteração: 50

- Número total de amostras por iteração: 32 * 50 = 1600

- Taxa de aprendizado: 6e-6

- Tamanho do microbatch: 4 sequências para o modelo de 14B, 8 sequências para o modelo de 32B

- Tamanho do lote: variável, dependendo do número de sequências

Os tamanhos dos lotes são variáveis porque os comprimentos das respostas podem mudar durante o treinamento, a eficiência do empacotamento da sequência flutua em cada iteração e as respostas de dominância zero (ou seja, respostas para as quais o modelo não fornece feedback positivo ou negativo) são descartadas. Em uma execução, foi feita uma tentativa de ajustar dinamicamente a taxa de aprendizado com base no tamanho do lote, mas isso resultou em uma taxa de aprendizado muito alta para lotes pequenos e que precisou ser limitada. A versão com o limite definido não foi significativamente diferente do uso de uma taxa de aprendizagem constante, mas o ajuste do tamanho do lote e da taxa de aprendizagem continua sendo uma área interessante para experimentos futuros.

Eles também realizaram breves experimentos aumentando o número de tarefas por iteração e diminuindo o número de amostras por tarefa e vice-versa, mantendo o número total de amostras por iteração aproximadamente igual. Essas alterações não mostraram diferenças significativas em um curto período de treinamento, sugerindo que o esquema é robusto para diferentes compensações entre o número de tarefas e o número de amostras por tarefa.

no final

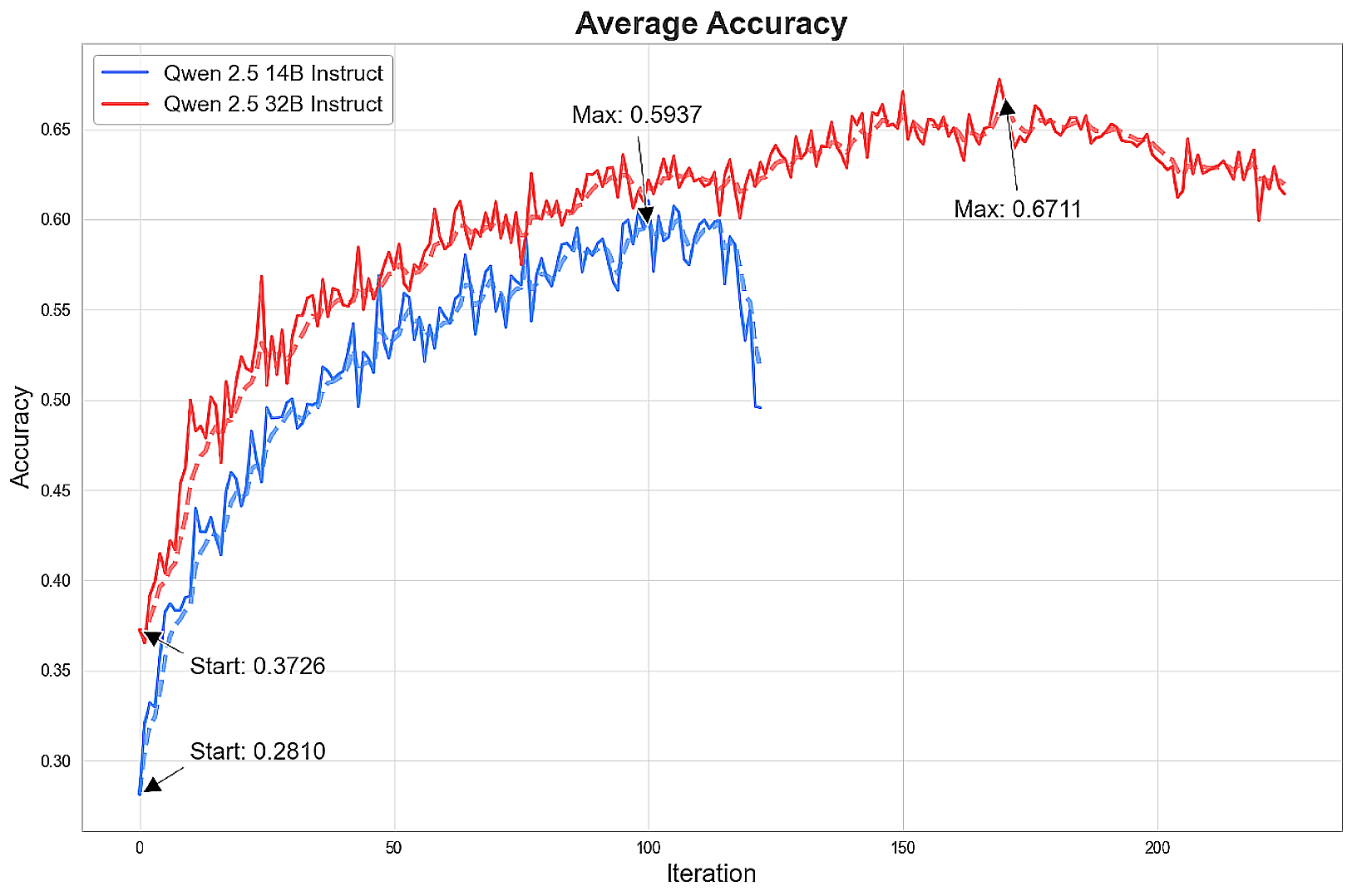

Depois de treinar o modelo por mais de 100 iterações, foi alcançado um nível de inferência de ponta.

O modelo melhora rapidamente e, em seguida, o aprimoramento da precisão começa a diminuir e, por fim, declina, às vezes drasticamente. Em sua melhor forma, o modelo 14B se aproxima do desempenho do Claude Sonnet 3.7 com 16 mil tokens, e o modelo 32B quase iguala os resultados do Sonnet com 64 mil tokens.

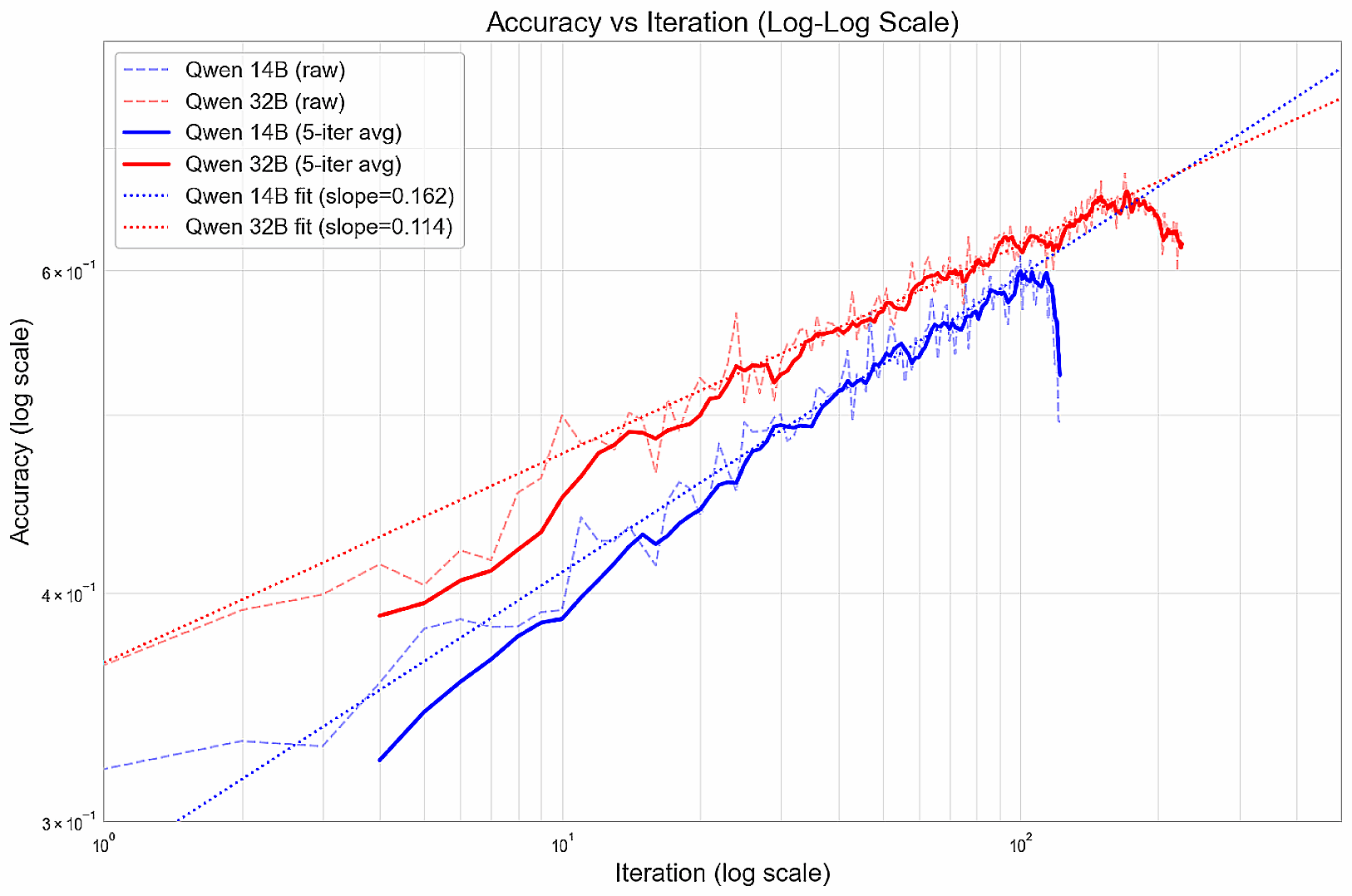

Durante o treinamento, a melhoria do desempenho segue uma lei de potência, formando uma relação linear no gráfico log-log (antes da deterioração).

Eles suspeitam que esses modelos podem convergir prematuramente para estratégias gananciosas que funcionam no início, mas que podem limitar suas perspectivas de longo prazo. A próxima etapa poderia ser explorar maneiras de incentivar uma diversidade de respostas, ou maneiras de desenvolver a competência de forma incremental (por exemplo, aprendizado em cursos), ou atribuir recompensas maiores a soluções particularmente boas para incentivar a exploração completa.

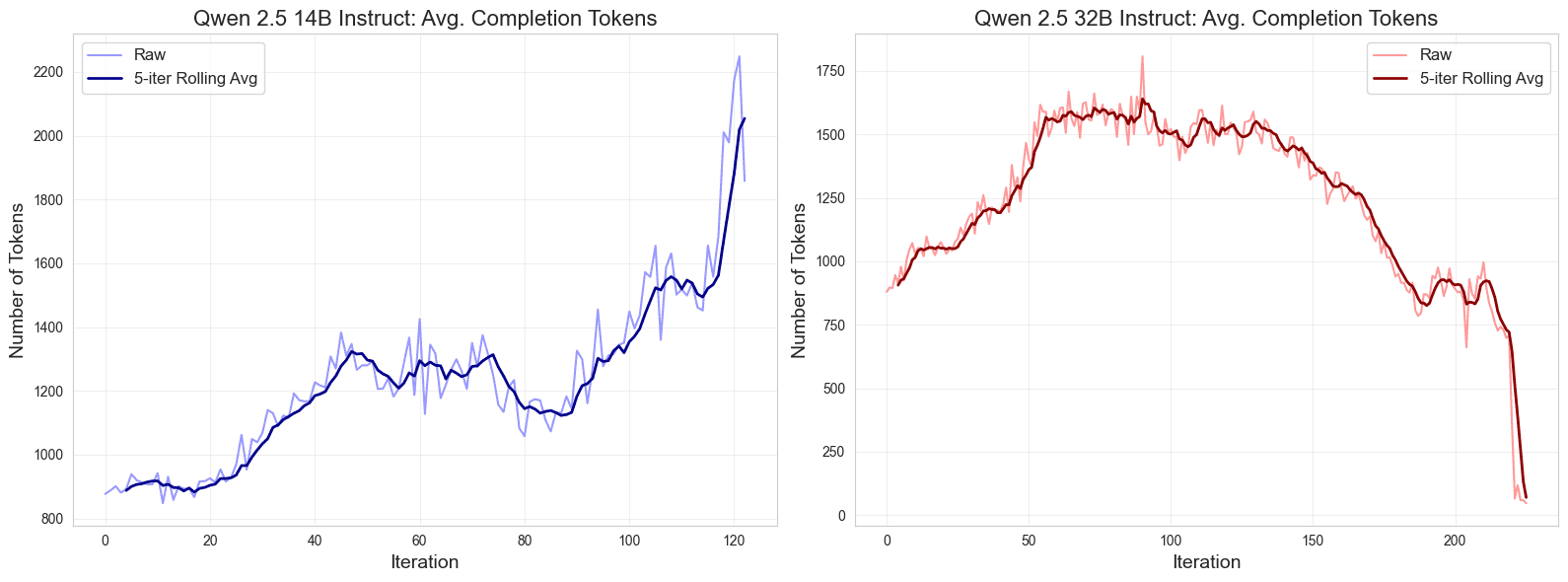

Além disso, eles notaram um padrão interessante no comprimento da saída durante o treinamento. Inicialmente, a resposta se torna mais longa, depois se estabiliza e, em seguida, diverge no final do treinamento, com a resposta do modelo 14B se tornando mais longa e o comprimento da resposta do modelo 32B diminuindo, especialmente depois que o desempenho máximo é atingido.

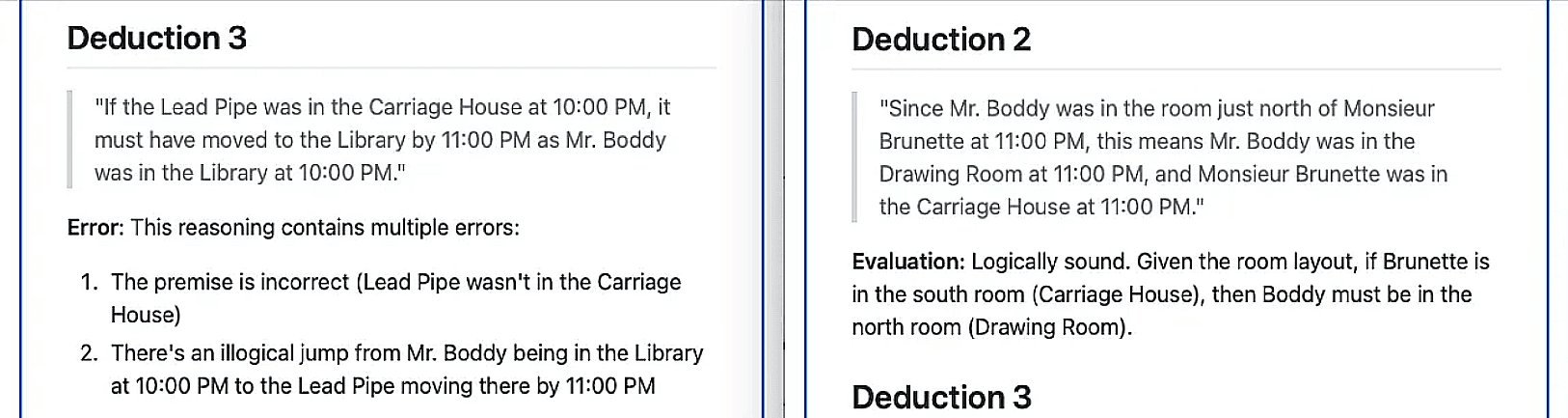

Para avaliar qualitativamente as melhorias no raciocínio lógico, eles fizeram com que seu modelo de ponta mais forte, o Claude Sonnet 3.7, identificasse e avaliasse a plausibilidade do raciocínio realizado pelo modelo Qwen 32B em quebra-cabeças semelhantes - antes e depois de mais de 100 iterações de treinamento.O Sonnet identificou 6 inferências do modelo básico, das quais todas, exceto uma, foram consideradas falsas;Em vez disso, ele identificou sete inferências do modelo treinado, sendo que todas, exceto uma, foram consideradas logicamente sólidas.

Por fim, a suposição de queimplantação sob demandaterProdutividade suficienteEles são baseados em IA de fogos de artifício (usado em uma expressão nominal)Níveis de preços sem servidorestimaram o custo do modelo Qwen. Eles compararam a precisão com o logaritmo natural do custo médio de inferência por resposta e observaram uma clara fronteira linear de Pareto no modelo não ajustado. A compensação entre custo e precisão foi significativamente aprimorada pelo treinamento bem-sucedido do modelo de código aberto até o nível de precisão da fronteira.

resumos

Nessa investigação, eles procuraram explorar se modelos de linguagem menores e de código aberto poderiam alcançar recursos de raciocínio de ponta por meio do aprendizado por reforço. Depois de treinar os modelos Qwen 14B e 32B em quebra-cabeças desafiadores do Temporal Clue usando hiperparâmetros cuidadosamente escolhidos e o método GRPO, eles obtiveram ganhos de desempenho impressionantes. Essas melhorias colocam os modelos de código aberto na vanguarda do desempenho de inferência e, ao mesmo tempo, reduzem significativamente o custo. Os resultados destacam o potencial do aprendizado por reforço para treinar com eficiência modelos abertos em tarefas de raciocínio complexas.

Conforme mencionado anteriormente.conjunto de dadosetesteeProgramas de treinamento e pesos do modelo (14B, 32B) estão disponíveis gratuitamente sob a licença MIT.

Além disso, eles descobriram que apenas 16 exemplos de treinamento É possível obter ganhos significativos de desempenho de até 10-15%.

© declaração de direitos autorais

Direitos autorais do artigo Círculo de compartilhamento de IA A todos, favor não reproduzir sem permissão.

Artigos relacionados

Nenhum comentário...